NVIDIA DGX Spark vs Mac Studio vs RTX-4080: Perbandingan Kinerja Ollama

Benchmark GPT-OSS 120b pada tiga platform AI

Saya menemukan beberapa uji kinerja menarik dari GPT-OSS 120b yang berjalan di Ollama di tiga platform berbeda: NVIDIA DGX Spark, Mac Studio, dan RTX 4080. Model GPT-OSS 120b dari perpustakaan Ollama memiliki ukuran 65GB, yang berarti tidak masuk ke dalam 16GB VRAM dari RTX 4080 (atau yang lebih baru RTX 5080).

Ya, model ini dapat berjalan dengan offloading sebagian ke CPU, dan jika Anda memiliki 64GB RAM sistem (seperti yang saya miliki), Anda dapat mencoba. Namun, konfigurasi ini tidak akan dianggap dekat dengan kinerja yang siap diproduksi. Untuk beban kerja yang sangat menuntut, Anda mungkin membutuhkan sesuatu seperti NVIDIA DGX Spark, yang dirancang khusus untuk beban kerja AI berkapasitas tinggi.

Saya mengharapkan LLM ini akan mendapatkan manfaat signifikan dari berjalan di perangkat “high-RAM AI” seperti DGX Spark. Meskipun hasilnya baik, mereka tidak sebaik yang Anda harapkan mengingat perbedaan harga antara DGX Spark dan opsi yang lebih terjangkau.

TL;DR

Ollama berjalan GPT-OSS 120b perbandingan kinerja di tiga platform:

| Perangkat | Kinerja Evaluasi Prompt (token/detik) | Kinerja Generasi (token/detik) | Catatan |

|---|---|---|---|

| NVIDIA DGX Spark | 1159 | 41 | Kinerja terbaik secara keseluruhan, sepenuhnya dipercepat GPU |

| Mac Studio | Tidak diketahui | 34 → 6 | Satu uji menunjukkan penurunan kinerja dengan peningkatan ukuran konteks |

| RTX 4080 | 969 | 12,45 | 78% CPU / 22% GPU karena batasan VRAM |

Spesifikasi model:

- Model: GPT-OSS 120b

- Parameter: 117B (Arsitektur Mixture-of-Experts)

- Parameter aktif per pass: 5,1B

- Kuantisasi: MXFP4

- Ukuran model: 65GB

Ini mirip dengan arsitektur model MoE lain seperti Qwen3:30b, tetapi pada skala yang jauh lebih besar.

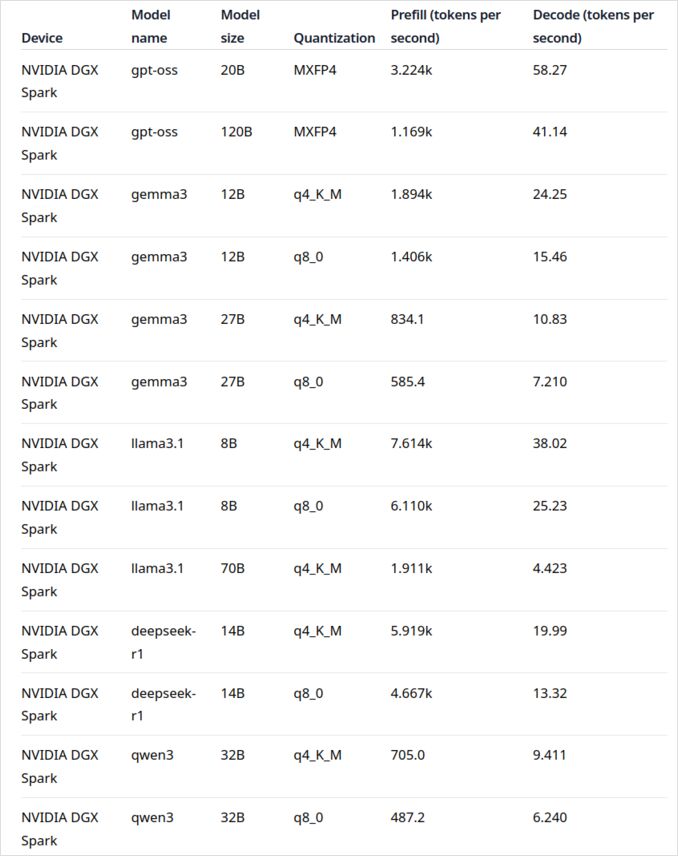

GPT-OSS 120b di NVIDIA DGX Spark

Data kinerja LLM untuk NVIDIA DGX Spark berasal dari posting blog resmi Ollama (dilink di bagian Tautan Berguna di bawah). DGX Spark mewakili masuknya NVIDIA ke pasar superkomputer AI pribadi, dengan 128GB memori terpadu yang dirancang khusus untuk menjalankan model bahasa besar.

Kinerja GPT-OSS 120b terlihat mengesankan dengan 41 token/detik untuk generasi. Ini membuatnya menjadi pemenang jelas untuk model ini, menunjukkan bahwa kapasitas memori tambahan benar-benar bisa membuat perbedaan untuk model yang sangat besar.

Namun, kinerja LLM sedang hingga besar tidak terlihat sebaik yang diharapkan. Ini terutama terlihat dengan Qwen3:32b dan Llama3.1:70b—model tepat di mana Anda mengharapkan kapasitas RAM tinggi untuk bersinar. Kinerja model-model ini di DGX Spark tidak menarik ketika dibandingkan dengan premi harga. Jika Anda secara utama bekerja dengan model dalam rentang parameter 30-70B, Anda mungkin ingin mempertimbangkan alternatif seperti workstation yang dikonfigurasi dengan baik atau bahkan Quadro RTX 5880 Ada dengan 48GB VRAM-nya.

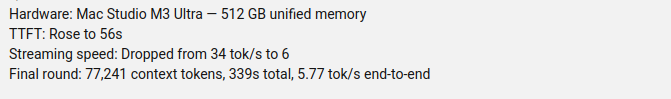

GPT-OSS 120b di Mac Studio Max

Saluran YouTube Slinging Bits melakukan uji menyeluruh menjalankan GPT-OSS 120b di Ollama dengan ukuran konteks yang berbeda. Hasilnya mengungkapkan kekhawatiran kinerja yang signifikan: kecepatan generasi model turun drastis dari 34 token/detik menjadi hanya 6 token/detik seiring meningkatnya ukuran konteks.

Degradasi kinerja ini kemungkinan besar disebabkan oleh tekanan memori dan cara macOS mengelola arsitektur memori terpadu. Meskipun Mac Studio Max memiliki memori terpadu yang mengesankan (hingga 192GB dalam konfigurasi M2 Ultra), cara mengelolanya saat beban konteks meningkat sangat berbeda dengan VRAM GPU khusus.

Untuk aplikasi yang memerlukan kinerja konsisten di berbagai panjang konteks, ini membuat Mac Studio kurang ideal untuk GPT-OSS 120b, meskipun kemampuan AI-nya secara umum luar biasa. Anda mungkin akan lebih beruntung dengan model yang lebih kecil atau mempertimbangkan fitur pengelolaan permintaan paralel Ollama untuk memaksimalkan throughput dalam skenario produksi.

GPT-OSS 120b di RTX 4080

Awalnya saya pikir menjalankan Ollama dengan GPT-OSS 120b di PC konsumen saya tidak akan terlalu menarik, tetapi hasilnya justru mengejutkan saya. Berikut yang terjadi saat saya menguji dengan query ini:

$ ollama run gpt-oss:120b --verbose Bandingkan cuaca di ibukota negara bagian Australia

Berpikir...

Kita perlu membandingkan cuaca di ibukota negara bagian Australia. Sediakan perbandingan, mungkin termasuk

...

*Semua data diakses September 2024; setiap pembaruan dari BOM setelah tanggal tersebut mungkin sedikit mengubah angka, tetapi pola umum tetap tidak berubah.*

total duration: 4m39.942105769s

load duration: 75.843974ms

prompt eval count: 75 token(s)

prompt eval duration: 77.341981ms

prompt eval rate: 969.72 tokens/s

eval count: 3483 token(s)

eval duration: 4m39.788119563s

eval rate: 12.45 tokens/s

Sekarang ini bagian menarik—Ollama dengan LLM ini berjalan hampir sepenuhnya di CPU! Model sederhana tidak masuk ke dalam 16GB VRAM, jadi Ollama secara cerdas mengalihkan sebagian besar ke RAM sistem. Anda dapat melihat perilaku ini menggunakan perintah ollama ps:

$ ollama ps

NAME ID SIZE PROCESSOR CONTEXT

gpt-oss:120b a951a23b46a1 65 GB 78%/22% CPU/GPU 4096

Meskipun berjalan dengan pembagian 78% CPU / 22% GPU, RTX 4080 tetap memberikan kinerja yang layak untuk model sebesar ini. Evaluasi prompt sangat cepat dengan 969 token/detik, dan bahkan kecepatan generasi 12,45 token/detik sudah bisa digunakan untuk banyak aplikasi.

Ini terutama mengesankan ketika Anda mempertimbangkan bahwa:

- Model hampir 4x lebih besar dari VRAM yang tersedia

- Sebagian besar komputasi terjadi di CPU (yang memanfaatkan RAM sistem 64GB saya)

- Memahami bagaimana Ollama menggunakan inti CPU dapat membantu mengoptimalkan konfigurasi ini lebih lanjut

Siapa yang akan berpikir GPU konsumen bisa menangani model parameter 117B sama sekali, apalagi dengan kinerja yang bisa digunakan? Ini menunjukkan kekuatan manajemen memori cerdas Ollama dan pentingnya memiliki RAM sistem yang cukup. Jika Anda tertarik mengintegrasikan Ollama ke dalam aplikasi Anda, lihat panduan ini tentang menggunakan Ollama dengan Python.

Catatan: Meskipun ini bekerja untuk eksperimen dan pengujian, Anda akan melihat GPT-OSS bisa memiliki beberapa keanehan, terutama dengan format output terstruktur.

Sumber Utama

- Ollama di NVIDIA DGX Spark: Benchmark Kinerja - Posting blog resmi Ollama dengan data kinerja DGX Spark yang menyeluruh

- GPT-OSS 120B di Mac Studio - Saluran YouTube Slinging Bits - Uji video menyeluruh GPT-OSS 120b dengan ukuran konteks yang berbeda

Bacaan Terkait

Perbandingan Perangkat & Harga

- DGX Spark vs. Mac Studio: Pandangan Praktis, Dengan Pemeriksaan Harga untuk Superkomputer AI Pribadi NVIDIA - Penjelasan terperinci tentang konfigurasi DGX Spark, harga global, dan perbandingan langsung dengan Mac Studio untuk pekerjaan AI lokal

- NVIDIA DGX Spark - Antisipasi - Liputan awal DGX Spark: ketersediaan, harga, dan spesifikasi teknis

- Harga NVidia RTX 5080 dan RTX 5090 di Australia - Oktober 2025 - Harga pasar saat ini untuk GPU konsumen generasi berikutnya

- Apakah Quadro RTX 5880 Ada 48GB Baik? - Ulasan GPU workstation alternatif untuk beban kerja AI dengan 48GB VRAM

Panduan Ollama & Kinerja

- Ollama cheatsheet - Referensi perintah menyeluruh dan tips untuk Ollama

- Bagaimana Ollama Mengelola Permintaan Paralel - Memahami pemrosesan permintaan paralel dalam produksi

- Bagaimana Ollama Menggunakan Inti CPU Intel Performa dan Efisien - Analisis mendalam tentang pola penggunaan inti CPU

- Mengintegrasikan Ollama dengan Python: Contoh REST API dan Klien Python - Integrasi praktis Ollama dengan REST API dan klien resmi

Perbandingan Model

- Perbandingan LLM: Qwen3:30b vs GPT-OSS:20b - Perbandingan teknis dua model MoE populer

- Masalah Output Terstruktur Ollama GPT-OSS - Keterbatasan yang diketahui saat menggunakan GPT-OSS untuk generasi data terstruktur