एनवीडिया डीजीएक्स स्पार्क बनाम मैक स्टूडियो बनाम आरटीएक्स-4080: ओल्लामा प्रदर्शन तुलना

GPT-OSS 120b तीन AI प्लेटफॉर्म पर बेंचमार्क

मैंने कुछ दिलचस्प प्रदर्शन परीक्षणों का पता लगाया है GPT-OSS 120b का जो Ollama पर चल रहा है, तीन अलग-अलग प्लेटफॉर्मों पर: NVIDIA DGX Spark, Mac Studio, और RTX 4080। Ollama लाइब्रेरी का GPT-OSS 120b मॉडल 65GB का है, जिसका मतलब है कि यह RTX 4080 के 16GB VRAM में नहीं फिट होता है (या नए RTX 5080).

हाँ, मॉडल CPU पर आंशिक ऑफलोडिंग के साथ चल सकता है, और अगर आपके पास 64GB सिस्टम RAM है (जैसे कि मेरे पास है), तो आप इसे ट्राई कर सकते हैं। हालांकि, यह सेटअप किसी भी उत्पादन-तैयार प्रदर्शन के करीब नहीं माना जाएगा। वास्तव में मांग वाले वर्कलोड्स के लिए, आपको शायद NVIDIA DGX Spark की तरह कुछ चाहिए, जो उच्च-क्षमता AI वर्कलोड्स के लिए विशेष रूप से डिज़ाइन किया गया है।

मैंने उम्मीद की थी कि यह LLM “हाई-RAM AI डिवाइस” जैसे DGX Spark पर चलने से काफी फायदा उठाएगा। जबकि परिणाम अच्छे हैं, वे DGX Spark और अधिक किफायती विकल्पों के बीच की कीमत अंतर के अनुसार उतने ड्रामैटिक रूप से बेहतर नहीं हैं।

TL;DR

Ollama GPT-OSS 120b के प्रदर्शन की तुलना तीन प्लेटफॉर्मों पर:

| डिवाइस | प्रॉम्प्ट मूल्यांकन प्रदर्शन (टोकन्स/सेकंड) | जनरेशन प्रदर्शन (टोकन्स/सेकंड) | नोट्स |

|---|---|---|---|

| NVIDIA DGX Spark | 1159 | 41 | सर्वोत्तम समग्र प्रदर्शन, पूर्ण GPU-त्वरित |

| Mac Studio | अज्ञात | 34 → 6 | एक परीक्षण ने बढ़ते कॉन्टेक्स्ट साइज के साथ गिरावट दिखाई |

| RTX 4080 | 969 | 12.45 | VRAM सीमाओं के कारण 78% CPU / 22% GPU विभाजन |

मॉडल विन्यास:

- मॉडल: GPT-OSS 120b

- पैरामीटर्स: 117B (Mixture-of-Experts आर्किटेक्चर)

- प्रति पास सक्रिय पैरामीटर्स: 5.1B

- क्वांटाइजेशन: MXFP4

- मॉडल साइज: 65GB

यह Qwen3:30b जैसे अन्य MoE मॉडल्स के आर्किटेक्चर के समान है, लेकिन बहुत बड़े पैमाने पर।

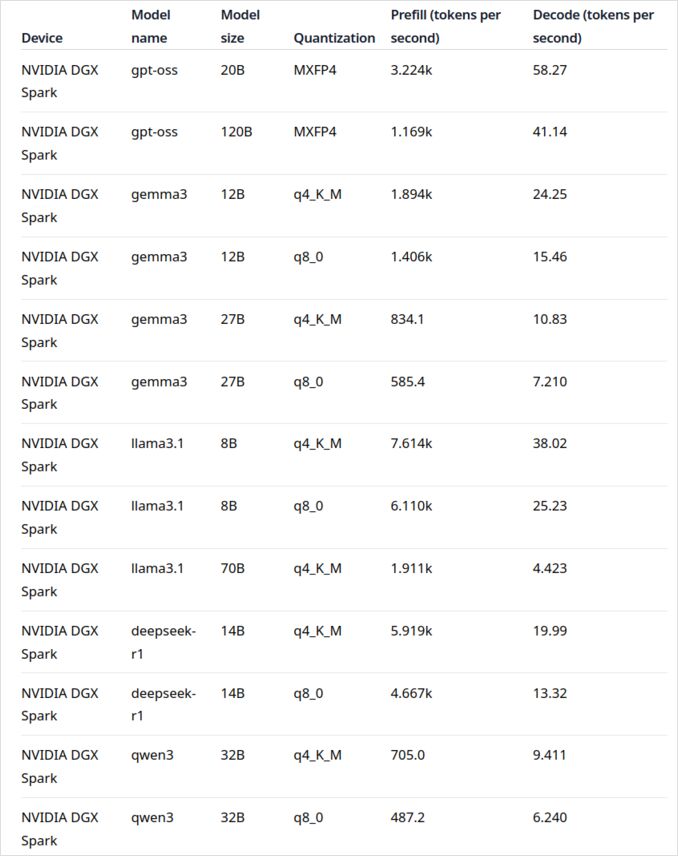

GPT-OSS 120b पर NVIDIA DGX Spark

NVIDIA DGX Spark के लिए LLM प्रदर्शन डेटा आधिकारिक Ollama ब्लॉग पोस्ट से आता है (नीचे उपयोगी लिंक्स अनुभाग में लिंक किया गया है)। DGX Spark NVIDIA का व्यक्तिगत AI सुपरकंप्यूटर बाजार में प्रवेश का प्रतिनिधित्व करता है, जिसमें 128GB एकीकृत मेमोरी है जो बड़े भाषा मॉडल्स को चलाने के लिए विशेष रूप से डिज़ाइन किया गया है।

GPT-OSS 120b का प्रदर्शन जनरेशन के लिए 41 टोकन्स/सेकंड पर प्रभावशाली लग रहा है। यह इस विशेष मॉडल के लिए स्पष्ट विजेता है, जो दिखाता है कि अतिरिक्त मेमोरी क्षमता वास्तव में बहुत बड़े मॉडल्स के लिए अंतर कर सकती है।

हालांकि, मध्यम से बड़े LLM प्रदर्शन उतने आकर्षक नहीं लगते। यह विशेष रूप से Qwen3:32b और Llama3.1:70b के साथ स्पष्ट है—वही मॉडल्स जहां आप उच्च RAM क्षमता को चमकने की उम्मीद करते हैं। DGX Spark पर इन मॉडल्स का प्रदर्शन कीमत प्रीमियम के मुकाबले प्रेरित नहीं करता है। अगर आप मुख्य रूप से 30-70B पैरामीटर्स के रेंज में मॉडल्स के साथ काम कर रहे हैं, तो आप अल्टरनेटिव्स जैसे एक अच्छी तरह से कॉन्फ़िगर किया गया वर्कस्टेशन) या यहां तक कि Quadro RTX 5880 Ada के साथ 48GB VRAM का विचार कर सकते हैं।

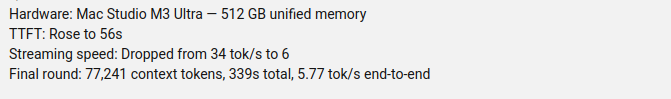

GPT-OSS 120b पर Mac Studio Max

Slinging Bits यूट्यूब चैनल ने Ollama के साथ GPT-OSS 120b को चलाने के लिए व्यापक परीक्षण किए, विभिन्न कॉन्टेक्स्ट साइज के साथ। परिणाम एक महत्वपूर्ण प्रदर्शन चिंता का खुलासा करते हैं: मॉडल का जनरेशन स्पीड कॉन्टेक्स्ट साइज बढ़ने के साथ 34 टोकन्स/सेकंड से केवल 6 टोकन्स/सेकंड तक महत्वपूर्ण रूप से गिर गया।

यह प्रदर्शन गिरावट संभवतः मेमोरी दबाव और macOS द्वारा एकीकृत मेमोरी आर्किटेक्चर का प्रबंधन करने के तरीके के कारण है। जबकि Mac Studio Max में एकीकृत मेमोरी (M2 Ultra कॉन्फ़िगरेशन में 192GB तक) प्रभावशाली है, यह बहुत बड़े मॉडल्स को बढ़ते कॉन्टेक्स्ट लोड के तहत संभालने का तरीका समर्पित GPU VRAM से काफी अलग है।

बढ़ते कॉन्टेक्स्ट लंबाइयों के माध्यम से स्थिर प्रदर्शन की आवश्यकता वाले एप्लिकेशन्स के लिए, यह Mac Studio को GPT-OSS 120b के लिए कम आदर्श बनाता है, इसके बावजूद कि यह AI वर्कलोड्स के लिए अन्यथा उत्कृष्ट क्षमताओं का प्रदर्शन करता है। आपको छोटे मॉडल्स का उपयोग करने में बेहतर भाग्य मिल सकता है या उत्पादन सीनारियों में थ्रूपुट को अधिकतम करने के लिए Ollama के पैरालल रिक्वेस्ट हैंडलिंग फीचर्स का उपयोग करने का विचार कर सकते हैं।

GPT-OSS 120b पर RTX 4080

मैंने पहले से ही सोचा था कि Ollama के साथ GPT-OSS 120b को अपने कंज्यूमर PC पर चलाना विशेष रूप से रोमांचक नहीं होगा, लेकिन परिणाम मुझे अच्छी तरह से आश्चर्यचकित कर गए। जब मैंने इस क्वेरी के साथ इसे परीक्षण किया:

$ ollama run gpt-oss:120b --verbose Compare the weather in state capitals of Australia

Thinking...

We need to compare weather in state capitals of Australia. Provide a comparison, perhaps include

...

*All data accessed September 2024; any updates from the BOM after that date may slightly adjust the

numbers, but the broad patterns remain unchanged.*

total duration: 4m39.942105769s

load duration: 75.843974ms

prompt eval count: 75 token(s)

prompt eval duration: 77.341981ms

prompt eval rate: 969.72 tokens/s

eval count: 3483 token(s)

eval duration: 4m39.788119563s

eval rate: 12.45 tokens/s

अब रोचक बात यह है—Ollama इस LLM को प्रमुख रूप से CPU पर चल रहा था! मॉडल 16GB VRAM में नहीं फिट होता है, इसलिए Ollama ने बुद्धिमानी से अधिकांश को सिस्टम RAM में ऑफलोड किया। आप ollama ps कमांड का उपयोग करके इस व्यवहार को देख सकते हैं:

$ ollama ps

NAME ID SIZE PROCESSOR CONTEXT

gpt-oss:120b a951a23b46a1 65 GB 78%/22% CPU/GPU 4096

78% CPU / 22% GPU विभाजन के बावजूद, RTX 4080 इस आकार के मॉडल के लिए सम्मानजनक प्रदर्शन प्रदान करता है। प्रॉम्प्ट मूल्यांकन 969 टोकन्स/सेकंड पर चमकता है, और जनरेशन स्पीड 12.45 टोकन्स/सेकंड भी कई एप्लिकेशन्स के लिए उपयोग में लाया जा सकता है।

यह विशेष रूप से प्रभावशाली है जब आप विचार करते हैं कि:

- मॉडल उपलब्ध VRAM से लगभग 4 गुना बड़ा है

- अधिकांश गणना CPU पर होती है (जो मेरे 64GB सिस्टम RAM से फायदा उठाता है)

- Ollama CPU कोर का उपयोग कैसे करता है इस सेटअप को और अधिक अनुकूलित करने में मदद कर सकता है

कौन सोच सकता था कि एक कंज्यूमर GPU 117B पैरामीटर्स के मॉडल को संभाल सकता है, और उसमें उपयोग में लाया जा सकता है प्रदर्शन? यह Ollama की बुद्धिमानी भरी मेमोरी प्रबंधन क्षमता और पर्याप्त सिस्टम RAM होने की महत्वपूर्णता को प्रदर्शित करता है। अगर आप Ollama को अपने एप्लिकेशन्स में एकीकृत करने में रुचि रखते हैं, तो Ollama को Python के साथ उपयोग करने के लिए इस गाइड को देखें।

नोट: जबकि यह प्रयोग और परीक्षण के लिए काम करता है, आप GPT-OSS में कुछ क्वर्क्स हो सकते हैं देखेंगे, विशेष रूप से संरचित आउटपुट फॉर्मेट्स के साथ।

प्राथमिक स्रोत

- Ollama on NVIDIA DGX Spark: Performance Benchmarks - DGX Spark प्रदर्शन डेटा के साथ व्यापक आधिकारिक Ollama ब्लॉग पोस्ट

- GPT-OSS 120B on Mac Studio - Slinging Bits YouTube - बढ़ते कॉन्टेक्स्ट साइज के साथ GPT-OSS 120b का विस्तृत वीडियो परीक्षण

संबंधित पठन

हार्डवेयर तुलना और कीमतें

- DGX Spark vs. Mac Studio: NVIDIA के व्यक्तिगत AI सुपरकंप्यूटर का एक व्यावहारिक, कीमत-परखा दृष्टिकोण - DGX Spark कॉन्फ़िगरेशन्स, वैश्विक कीमतें, और स्थानीय AI कार्य के लिए Mac Studio के साथ सीधा तुलना का विस्तृत स्पष्टीकरण

- NVIDIA DGX Spark - अपेक्षा - DGX Spark की प्रारंभिक कवरेज: उपलब्धता, कीमतें, और तकनीकी विन्यास

- NVidia RTX 5080 और RTX 5090 की ऑस्ट्रेलिया में कीमतें - अक्टूबर 2025 - अगली पीढ़ी के कंज्यूमर GPUs की वर्तमान बाजार कीमतें

- क्या Quadro RTX 5880 Ada 48GB अच्छा है? - AI वर्कलोड्स के लिए 48GB वर्कस्टेशन GPU विकल्प की समीक्षा

Ollama गाइड्स और प्रदर्शन

- Ollama cheatsheet - Ollama के लिए व्यापक कमांड रेफरेंस और टिप्स

- Ollama कैसे पैरालल रिक्वेस्ट हैंडल करता है - उत्पादन में समकालिक रिक्वेस्ट प्रोसेसिंग को समझना

- Ollama Intel CPU Performance और Efficient Cores का उपयोग कैसे करता है - CPU कोर उपयोग पैटर्न्स में गहन डाइव

- Ollama को Python के साथ एकीकृत करना: REST API और Python क्लाइंट उदाहरण - REST API और आधिकारिक क्लाइंट के साथ व्यावहारिक Python एकीकरण

मॉडल तुलना

- LLMs तुलना: Qwen3:30b vs GPT-OSS:20b - दो लोकप्रिय MoE मॉडल्स की तकनीकी तुलना

- Ollama GPT-OSS Structured Output Issues - GPT-OSS को संरचित डेटा जनरेशन के लिए उपयोग करने के दौरान जाने-माने सीमाएं