NVIDIA DGX Spark vs Mac Studio vs RTX-4080: Ollama 성능 비교

GPT-OSS 120b의 세 개 AI 플랫폼에서의 벤치마크

GPT-OSS 120b의 세 개 AI 플랫폼에서의 벤치마크

AI 어시스턴트를 위한 MCP 서버를 Python 예제와 함께 구축하세요.

모델 컨텍스트 프로토콜(MCP)은 AI 어시스턴트가 외부 데이터 소스 및 도구와 상호 작용하는 방식을 혁신하고 있습니다. 이 가이드에서는 웹 검색 및 스크래핑 기능에 초점을 맞춘 MCP 서버를 Python으로 구축 방법을 살펴보겠습니다.

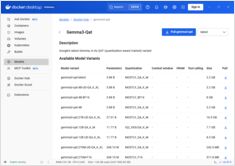

Docker Model Runner 명령어의 빠른 참조

Docker 모델 러너 (DMR)는 2025년 4월에 도입된 Docker의 공식 솔루션으로, 로컬에서 AI 모델을 실행하는 데 사용됩니다. 이 체크리스트는 모든 필수 명령어, 구성 및 최선의 실천 방법에 대한 빠른 참조를 제공합니다.

도커 모델 러너와 올라마를 사용한 로컬 LLM 비교

로컬에서 대규모 언어 모델(LLM) 실행 는 프라이버시, 비용 관리, 오프라인 기능을 위해 점점 더 인기를 끌고 있습니다. 2025년 4월에 Docker가 Docker Model Runner (DMR), AI 모델 배포를 위한 공식 솔루션을 발표하면서 상황은 크게 변화했습니다.

전문적인 칩이 AI 추론을 더 빠르고 저렴하게 만들고 있습니다.

가용성, 6개 국가의 실제 소매 가격, Mac Studio와의 비교.

**NVIDIA DGX Spark**는 실제 제품이며, 2025년 10월 15일에 판매가 시작되며, CUDA 개발자들이 로컬 LLM 작업을 수행하기 위해 통합된 NVIDIA AI 스택이 포함된 제품을 대상으로 합니다. 미국 MSRP는 $3,999이며, 영국/독일/일본의 경우 VAT 및 채널 비용으로 인해 가격이 더 높습니다. AUD/KRW 공식 가격표는 아직 널리 공개되지 않았습니다.

Ollama를 Go와 통합하기: SDK 가이드, 예제 및 프로덕션 최고 실천 방법.

이 가이드는 사용 가능한 Go SDKs for Ollama에 대한 종합적인 개요를 제공하고, 그 기능 세트를 비교합니다.

이 두 모델의 속도, 파라미터 및 성능 비교

다음은 Qwen3:30b와 GPT-OSS:20b 사이의 비교입니다.

지시사항 준수 및 성능 파라미터, 사양 및 속도에 초점을 맞추고 있습니다:

매우 좋지 않다.

Ollama의 GPT-OSS 모델은 특히 LangChain, OpenAI SDK, vllm 및 기타 프레임워크와 함께 사용될 때 구조화된 출력을 처리하는 데 반복적인 문제가 있습니다.

Ollama에서 구조화된 출력을 얻는 몇 가지 방법

대규모 언어 모델(LLMs) 은 강력하지만, 실제 운영 환경에서는 일반적인 문장이 아닌 예측 가능한 데이터를 원합니다. 즉, 앱에 입력할 수 있는 속성, 사실 또는 구조화된 객체를 원합니다. 이에 대해 LLM 구조화된 출력을 살펴보겠습니다.

내가 직접 수행한 ollama 모델 스케줄링 테스트 ````

여기서 저는 새로운 버전의 Ollama가 모델에 할당하는 VRAM의 양을 이전 버전과 비교하고 있습니다.

새로운 버전은 더 나쁘다고 보입니다.

현재 Ollama 개발의 상태에 대한 제 관점

Ollama은 LLM을 로컬에서 실행하는 데 사용되는 가장 인기 있는 도구 중 하나로 빠르게 자리 잡았습니다.

간단한 CLI와 간소화된 모델 관리 기능 덕분에, 클라우드 외부에서 AI 모델을 사용하고자 하는 개발자들에게 필수적인 선택지가 되었습니다.

하지만 많은 유망한 플랫폼과 마찬가지로, 이미 **Enshittification**의 징후가 나타나고 있습니다.

2025년 올라마의 가장 두드러진 UI에 대한 간략한 개요

로컬에서 호스팅된 Ollama는 대형 언어 모델을 자신의 컴퓨터에서 실행할 수 있게 해줍니다. 하지만 명령줄을 통해 사용하는 것은 사용자 친화적이지 않습니다. 다음은 로컬 Ollama에 연결되는 **ChatGPT 스타일의 인터페이스**를 제공하는 여러 오픈 소스 프로젝트입니다.

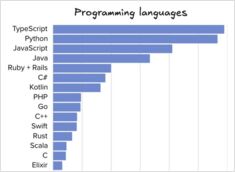

소프트웨어 엔지니어링 도구 및 언어 비교

The Pragmatic Engineer 뉴스레터가 며칠 전에 발표한 설문 조사 통계에 따르면, 2025년 중반의 프로그래밍 언어, IDE, AI 도구의 인기 및 기타 데이터가 포함되어 있습니다.

2025년 7월에 곧 제공될 예정입니다.

NVIDIA는 곧 NVIDIA DGX Spark를 출시할 예정입니다. 이는 Blackwell 아키텍처를 기반으로 한 소형 AI 슈퍼컴퓨터로, 128GB 이상의 통합 RAM과 1 PFLOPS의 AI 성능을 제공합니다. LLM을 실행하는 데 매우 적합한 장비입니다.

RAG을 구현 중이시다면? 여기 Go 코드 예제가 있습니다 - 2...

표준 Ollama에는 직접적인 재정렬 API가 없기 때문에, 쿼리-문서 쌍의 임베딩을 생성하고 이를 점수화하여 Qwen3 재정렬기 사용으로 재정렬하기(GO)를 구현해야 합니다.