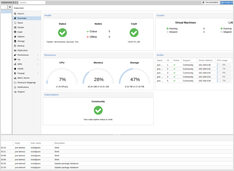

Шпаргалка по управлению виртуальными машинами Multipass: руководство для Ubuntu, Windows и macOS

Установка, настройка и основные команды Multipass

Multipass — это легковесный менеджер виртуальных машин, который упрощает создание и управление облачными экземплярами Ubuntu на Linux, Windows и macOS.