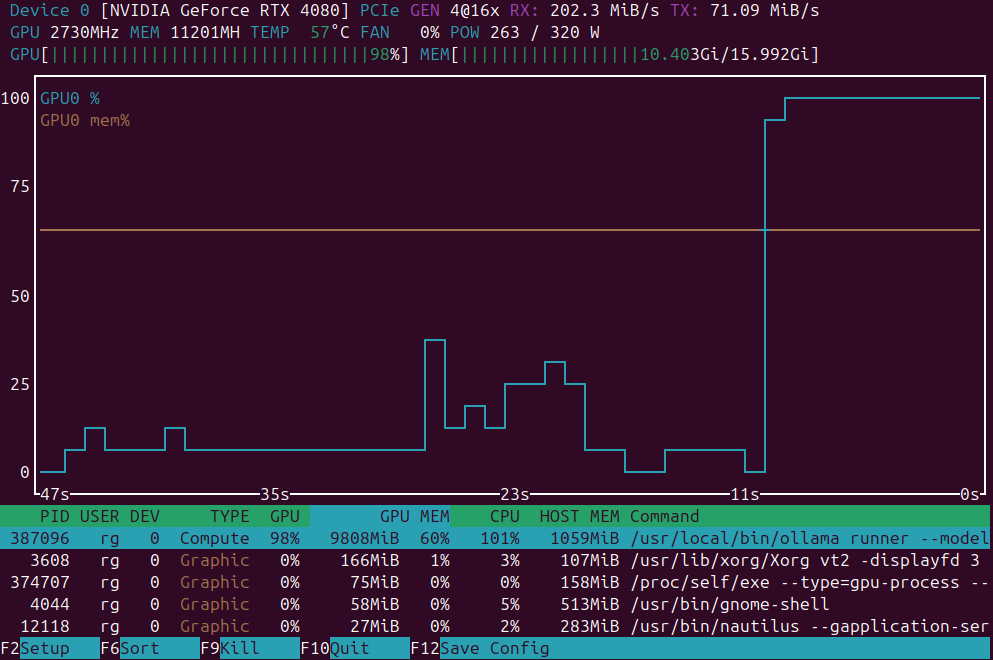

Лучшие языковые модели для Ollama на GPU с 16 ГБ видеопамяти

Тест скорости LLM на RTX 4080 с 16 ГБ видеопамяти

Запуск крупных языковых моделей локально обеспечивает вам конфиденциальность, возможность работы оффлайн и отсутствие затрат на API. Этот бенчмарк раскрывает, чего именно можно ожидать от 9 популярных LLMs на Ollama на RTX 4080.