NVIDIA DGX Spark vs Mac Studio vs RTX-4080: Porównanie wydajności Ollama

Wyniki testów GPT-OSS 120b na trzech platformach AI

Znalazłem kilka ciekawych testów wydajności GPT-OSS 120b działającego na Ollama na trzech różnych platformach: NVIDIA DGX Spark, Mac Studio i RTX 4080. Model GPT-OSS 120b z biblioteki Ollama waży 65 GB, co oznacza, że nie mieści się w 16 GB VRAM na RTX 4080 (ani w nowszej RTX 5080).

Tak, model może działać z częściowym przekazaniem do procesora, a jeśli masz 64 GB pamięci systemowej (jak ja), możesz to spróbować. Jednak taka konfiguracja nie będzie w żaden sposób gotowa do produkcji. Dla naprawdę wymagających zadań może być potrzebny coś takiego jak NVIDIA DGX Spark, który został zaprojektowany specjalnie do intensywnych obciążeń AI.

Spodziewałem się, że ten LLM będzie znacząco korzystał z działania na urządzeniu o “wysokiej pojemności pamięci RAM” takim jak DGX Spark. Choć wyniki są dobre, to nie są tak znacząco lepsze, jak można się spodziewać, biorąc pod uwagę różnicę cen między DGX Spark a bardziej opłacalnymi opcjami.

TL;DR

Ollama z GPT-OSS 120b porównanie wydajności na trzech platformach:

| Urządzenie | Wydajność oceny promptu (tokeny/s) | Wydajność generowania (tokeny/s) | Uwagi |

|---|---|---|---|

| NVIDIA DGX Spark | 1159 | 41 | Najlepsza ogólna wydajność, w pełni przyspieszona przez GPU |

| Mac Studio | Nieznana | 34 → 6 | Jeden test wykazał pogorszenie się przy zwiększaniu się rozmiaru kontekstu |

| RTX 4080 | 969 | 12,45 | 78% CPU / 22% GPU ze względu na ograniczenia VRAM |

Specyfikacja modelu:

- Model: GPT-OSS 120b

- Parametry: 117B (architektura Mixture-of-Experts)

- Aktywne parametry na przejściu: 5,1B

- Kwantyzacja: MXFP4

- Rozmiar modelu: 65 GB

To podobne do innych modeli MoE, takich jak Qwen3:30b, ale na znacznie większą skalę.

GPT-OSS 120b na NVIDIA DGX Spark

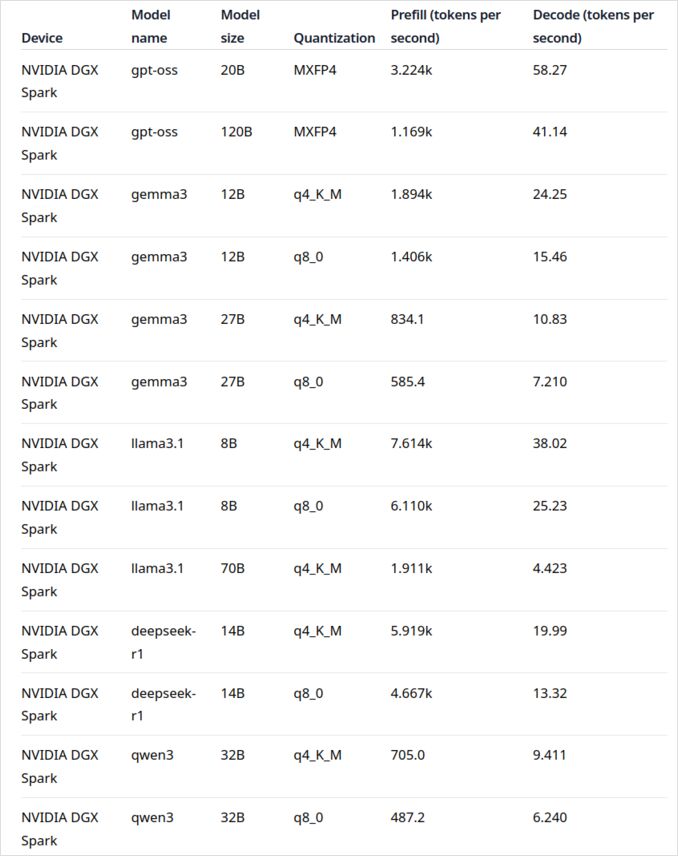

Dane wydajności LLM dla NVIDIA DGX Spark pochodzą z oficjalnego wpisu bloga Ollama (podanego poniżej w sekcji “Użyteczne linki”). DGX Spark reprezentuje wejście NVIDIA do rynku osobistych superkomputerów do AI, oferując 128 GB jednolitej pamięci specjalnie zaprojektowanej do działania dużych modeli językowych.

Wydajność GPT-OSS 120b wydaje się imponująca, osiągając 41 tokenów/s przy generowaniu. To czyni z niego wyraźnego zwycięzcę dla tego konkretnego modelu, pokazując, że dodatkowa pojemność pamięci może naprawdę wpłynąć na bardzo duże modele.

Jednak wydajność średnich i dużych LLM nie wygląda tak zachęcająco. To szczególnie widoczne w przypadku Qwen3:32b i Llama3.1:70b – dokładnie tych modeli, gdzie można się spodziewać, że wysoka pojemność pamięci będzie miała znaczenie. Wydajność tych modeli na DGX Spark nie jest zachęcająca w porównaniu do premii cenowej. Jeśli głównie pracujesz z modelami w zakresie 30–70B parametrów, możesz rozważyć alternatywy, takie jak dobrze skonfigurowany stanowisko robocze lub nawet Quadro RTX 5880 Ada z jego 48 GB VRAM.

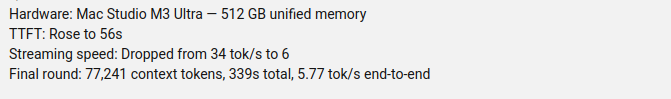

GPT-OSS 120b na Mac Studio Max

Kanał YouTube Slinging Bits przeprowadził kompleksowe testy działania GPT-OSS 120b na Ollama z różnymi rozmiarami kontekstu. Wyniki wykazują poważny problem wydajności: prędkość generowania spadła znacząco z 34 tokenów/s do zaledwie 6 tokenów/s przy zwiększaniu się rozmiaru kontekstu.

To pogorszenie wydajności prawdopodobnie wynika z presji pamięci i sposobu, w jaki macOS zarządza architekturą jednolitej pamięci. Choć Mac Studio Max ma imponującą jednolitą pamięć (do 192 GB w konfiguracji M2 Ultra), sposób, w jaki radzi sobie z bardzo dużymi modelami przy rosnących obciążeniach kontekstowymi, różni się znacząco od dedykowanej VRAM GPU.

Dla aplikacji wymagających spójnej wydajności przy różnych długościach kontekstu, to czyni Mac Studio mniej idealnym wyborem dla GPT-OSS 120b, mimo jego wspaniałych możliwości dla obciążeń AI. Możesz mieć lepsze wyniki z mniejszymi modelami lub rozważyć użycie funkcji obsługi równoległych żądań Ollama w celu maksymalizacji przepływności w scenariuszach produkcyjnych.

GPT-OSS 120b na RTX 4080

Początkowo myślałem, że uruchamianie Ollama z GPT-OSS 120b na moim komputerze użytkownika nie będzie szczególnie interesujące, ale wyniki zaskoczyły mnie w sposób przyjemny. Oto, co się wydarzyło, gdy przeprowadziłem test z tym zapytaniem:

$ ollama run gpt-oss:120b --verbose Porównaj pogodę w stolicach stanów Australii

Myślę...

Musimy porównać pogodę w stolicach stanów Australii. Udostępnij porównanie, może zawierać

...

*Wszystkie dane dostępne w wrześniu 2024; wszelkie aktualizacje od BOM po tej dacie mogą lekko zmienić liczby, ale ogólne wzorce pozostają niezmienione.*

całkowity czas: 4m39.942105769s

czas ładowania: 75.843974ms

liczba tokenów oceny promptu: 75 token(s)

czas oceny promptu: 77.341981ms

prędkość oceny promptu: 969.72 tokenów/s

liczba tokenów oceny: 3483 token(s)

czas oceny: 4m39.788119563s

prędkość oceny: 12.45 tokenów/s

Teraz tu jest ciekawe – Ollama z tym LLM działał przede wszystkim na procesorze! Model po prostu nie mieści się w 16 GB VRAM, więc Ollama inteligentnie przekazał większość do pamięci systemowej. Możesz zobaczyć to zachowanie za pomocą polecenia ollama ps:

$ ollama ps

NAME ID SIZE PROCESSOR CONTEXT

gpt-oss:120b a951a23b46a1 65 GB 78%/22% CPU/GPU 4096

Mimo działania z podziałem 78% CPU / 22% GPU, RTX 4080 nadal dostarcza szacunkowo dobrej wydajności dla modelu tego rozmiaru. Ocena promptu jest błyskawicznie szybka – 969 tokenów/s, a nawet prędkość generowania 12,45 tokenów/s jest użyteczna dla wielu aplikacji.

To jest szczególnie imponujące, biorąc pod uwagę, że:

- Model jest prawie 4 razy większy niż dostępna VRAM

- Większość obliczeń odbywa się na procesorze (co korzysta z moich 64 GB pamięci systemowej)

- Zrozumienie jak Ollama wykorzystuje jądra procesora może pomóc w dalszej optymalizacji tej konfiguracji

Kto by się spodziewał, że konsumentowski GPU mógłby w ogóle obsługiwać model z 117B parametrów, nie mówiąc już o użytecznej wydajności? To pokazuje siłę inteligentnego zarządzania pamięcią Ollama i znaczenie posiadania wystarczającej ilości pamięci systemowej. Jeśli chcesz zintegrować Ollama z aplikacjami, sprawdź ten przewodnik dotyczący użycia Ollama z Pythonem.

Uwaga: Choć to działa do eksperymentowania i testowania, zauważysz GPT-OSS może mieć pewne dziwne zachowania, szczególnie w przypadku formatów wyjścia strukturalnego.

Źródła

- Ollama na NVIDIA DGX Spark: Testy wydajności - Oficjalny wpis bloga Ollama z kompleksowymi danymi wydajności DGX Spark

- GPT-OSS 120B na Mac Studio - Slinging Bits YouTube - Szczegółowe testy GPT-OSS 120b z różnymi rozmiarami kontekstu

Czytaj dalej

Porównania sprzętu i cen

- DGX Spark vs. Mac Studio: Praktyczne, sprawdzone cenowo spojrzenie na osobisty superkomputer NVIDIA do AI - Szczegółowe wyjaśnienie konfiguracji DGX Spark, cen globalnych i bezpośredniego porównania z Mac Studio dla lokalnych zadań AI

- NVIDIA DGX Spark - Oczekiwania - Wczesne pokrycie DGX Spark: dostępność, ceny i specyfikacje techniczne

- Ceny NVidia RTX 5080 i RTX 5090 w Australii - październik 2025 - Obecne ceny rynkowe nowej generacji konsumentowskich GPU

- Czy Quadro RTX 5880 Ada 48GB ma sens? - Recenzja alternatywy 48GB dla obciążeń AI

Przewodniki Ollama i wydajność

- Ollama cheatsheet - Kompleksowa referencja poleceń i wskazówki dla Ollama

- Jak Ollama obsługuje żądania równoległe - Zrozumienie przetwarzania żądań równoległych w środowisku produkcyjnym

- Jak Ollama wykorzystuje jądra procesora Intel Performance i Efficient - Głębszy wgląd w wzorce wykorzystania jąder procesora

- Integracja Ollama z Pythonem: Przykłady REST API i klienta Pythona - Praktyczna integracja Ollama z REST API i oficjalnym klientem Pythona

Porównania modeli

- Porównanie LLM: Qwen3:30b vs GPT-OSS:20b - Techniczne porównanie dwóch popularnych modeli MoE

- Problemy z wyjściem strukturalnym Ollama GPT-OSS - Znane ograniczenia przy użyciu GPT-OSS do generowania danych strukturalnych