Ubuntu에 Mumble 서버를 설치하고 Android 및 iOS에서 Mumble을 사용하는 방법

대체 VoIP 통신 플랫폼

Mumble은 주로 실시간 음성 통신을 위해 설계된 무료이고 오픈소스의 음성 통화(VoIP) 애플리케이션입니다. 사용자들이 공유된 서버에 연결하여 서로와 대화할 수 있도록 클라이언트-서버 아키텍처를 사용합니다.

대체 VoIP 통신 플랫폼

Mumble은 주로 실시간 음성 통신을 위해 설계된 무료이고 오픈소스의 음성 통화(VoIP) 애플리케이션입니다. 사용자들이 공유된 서버에 연결하여 서로와 대화할 수 있도록 클라이언트-서버 아키텍처를 사용합니다.

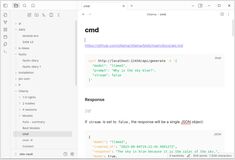

2025년 올라마의 가장 두드러진 UI에 대한 간략한 개요

로컬에서 호스팅된 Ollama는 대형 언어 모델을 자신의 컴퓨터에서 실행할 수 있게 해줍니다. 하지만 명령줄을 통해 사용하는 것은 사용자 친화적이지 않습니다. 다음은 로컬 Ollama에 연결되는 **ChatGPT 스타일의 인터페이스**를 제공하는 여러 오픈 소스 프로젝트입니다.

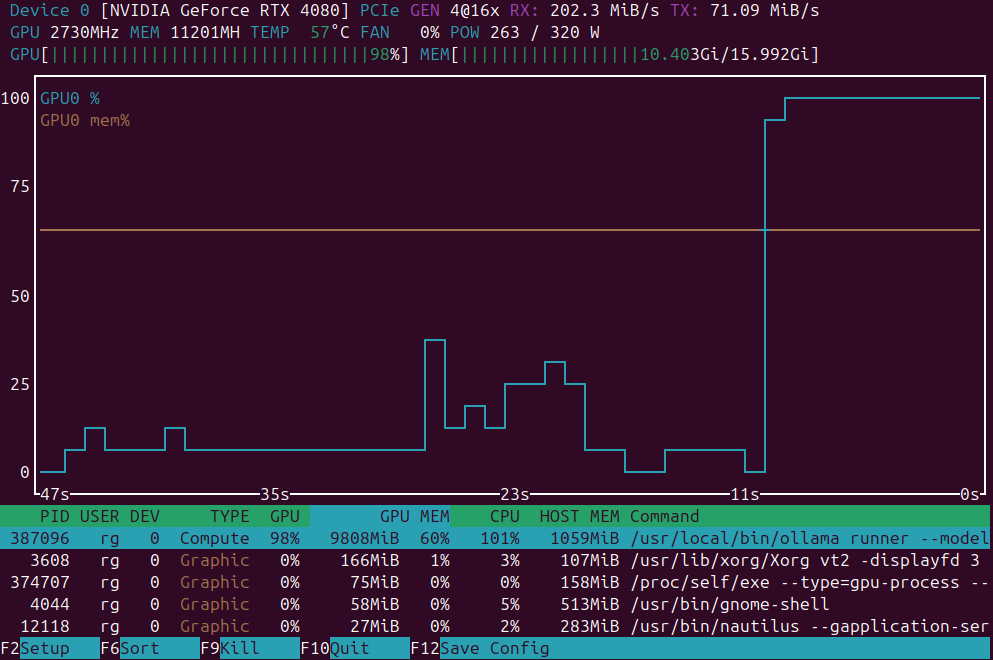

GPU 부하 모니터링을 위한 애플리케이션 목록

GPU 로드 모니터링 애플리케이션: nvidia-smi vs nvtop vs nvitop vs KDE plasma systemmonitor.

홈랩 클러스터에 little k3s 쿠버네티스 설치

3노드 K3s 클러스터의 설치 단계별 가이드를 아래에 제공합니다.

이 가이드는 물리 서버(1 마스터 + 2 워커)에서 실행되는

**3노드 K3s 클러스터 설치**에 대한 것입니다.

쿠버네티스 변종에 대한 매우 짧은 개요

자체 호스팅 Kubernetes(self-hosting Kubernetes) 분포를 비교하여, 베어메탈 또는 홈 서버에 호스팅할 때 설치 용이성, 성능, 시스템 요구사항, 기능 세트에 초점을 맞추고 있습니다.

자신의 홈 랩에 가장 적합한 Kubernetes 플레버 선택

저는 Ubuntu 기반 홈랩에 적합한 3개 노드(각각 16GB RAM, 4코어)를 갖춘 자체 호스팅 Kubernetes 변형을 비교하고 있으며, 설치 및 유지보수가 용이하고, Persistent Volumes(PV) 및 LoadBalancer(LB) 서비스를 지원하는 것을 중심으로 살펴보고 있습니다.

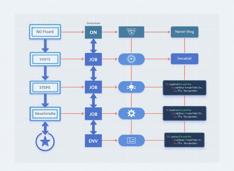

일반적인 GitHub Actions에 대해 간략히 소개하고 그 구조를 설명합니다.

GitHub Actions

은 GitHub 내에서 사용되는 자동화 및 CI/CD 플랫폼으로, 푸시, 풀리퀘스트, 또는 일정에 따라 코드를 빌드, 테스트, 배포할 수 있습니다.

한 가지 참고로, docker-compose는 docker compose와는 다릅니다.

다음은 제공된 Hugo 페이지 내용을 영어에서 한국어로 번역한 것입니다. 모든 Hugo 단축 코드, 기술적 요소, 구조, 포맷은 그대로 유지되었으며, 한국어의 문법, 표현, 타이포그래피에 맞게 자연스럽게 번역되었습니다.

다음은

Docker Compose 간편 가이드

으로, Compose 파일과 명령어를 빠르게 정리하고 익히는 데 도움이 되는 주석이 달린 예제입니다.

Obsidian에 대해...

다음은 제공된 Hugo 페이지 콘텐츠의 영어에서 한글로의 정확한 번역입니다. 모든 Hugo 쇼트코드, 마크다운 구조, 기술적 요소는 그대로 유지되었으며, 한글의 문법, 표현, 타이포그래피 규칙에 따라 자연스럽고 정확하게 번역되었습니다.

다음은 **개인 지식 관리(PKM)**에 강력한 도구로 알려진 Obsidian에 대한 상세한 분석입니다. 이는 Obsidian의 아키텍처, 기능, 강점, 그리고 현대 지식 워크플로우를 지원하는 방식에 대해 설명합니다.

2025년 7월에 곧 제공될 예정입니다.

NVIDIA는 곧 NVIDIA DGX Spark를 출시할 예정입니다. 이는 Blackwell 아키텍처를 기반으로 한 소형 AI 슈퍼컴퓨터로, 128GB 이상의 통합 RAM과 1 PFLOPS의 AI 성능을 제공합니다. LLM을 실행하는 데 매우 적합한 장비입니다.

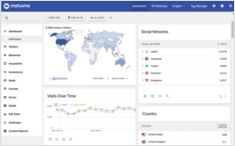

웹사이트에 사용할 웹 분석 시스템은 무엇인가요?

간단히 살펴보자면,

Matomo, Plausible, Google 및 기타 웹 분석 제공업체 및 시스템

자체 호스팅이 가능한 시스템들을 비교해 보자.

Ubuntu 24.04 표준 설치 순서에 대한 참고 사항

여기 제가 좋아하는 Ubuntu 24.04의 신규 설치에 대한 단계입니다.

여기서 제가 좋아하는 점은 NVidia 드라이버를 설치할 필요가 없으며, 자동으로 설치됩니다.

저는 개인용 지식 저장소로 Dokuwiki를 사용하고 있었습니다.

도쿠위키는 데이터베이스가 필요 없는 자체 호스팅 위키로, 쉽게 온프레미스에서 호스팅할 수 있습니다.

저는 도커화된 상태로, 제 개인의 페트/kubernetes 클러스터에서 실행하고 있었습니다.

AI에 적합한 GPU 가격 업데이트 - RTX 5080 및 RTX 5090

최상위 소비자용 GPU의 가격을 비교해 보겠습니다. 특히 LLM(대규모 언어 모델)에 적합하지만, 일반적으로 AI에도 적합한 GPU에 초점을 맞추겠습니다.

구체적으로는 다음을 확인해 보세요:

RTX 5080 및 RTX 5090 가격. 가격이 약간 하락했습니다.

파이썬을 사용한 ETS/MLOPS에 적합한 프레임워크

Apache Airflow은 프로그래밍적으로 워크플로우를 작성, 예약 및 모니터링할 수 있는 오픈소스 플랫폼으로, 완전히 파이썬 코드로 작성되어 전통적인, 수동적, 또는 UI 기반 워크플로우 도구보다 유연하고 강력한 대안을 제공합니다.

RAG을 구현 중이시다면? 여기 Go 코드 예제가 있습니다 - 2...

표준 Ollama에는 직접적인 재정렬 API가 없기 때문에, 쿼리-문서 쌍의 임베딩을 생성하고 이를 점수화하여 Qwen3 재정렬기 사용으로 재정렬하기(GO)를 구현해야 합니다.