오픈 웹유아: 자체 호스팅 LLM 인터페이스

로컬 LLM을 위한 자체 호스팅형 ChatGPT 대안

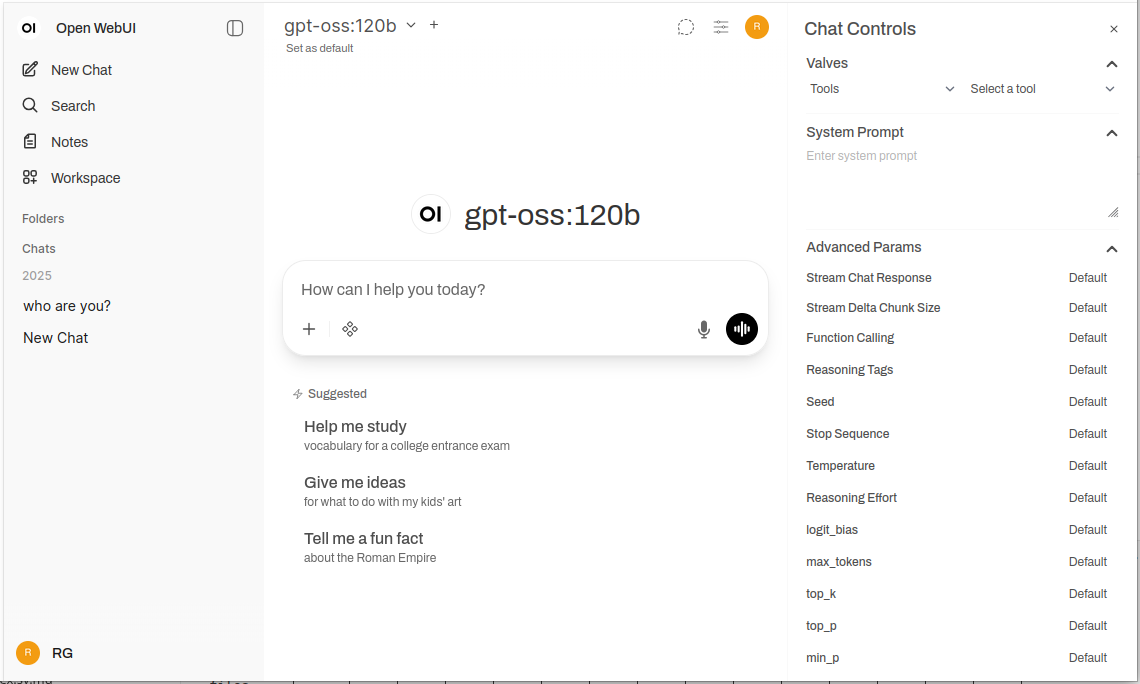

Open WebUI는 대규모 언어 모델과 상호 작용할 수 있는 강력하고 확장성이 뛰어난 자체 호스팅 웹 인터페이스입니다.

Ollama(Ollama와 OpenAI 호환 API를 지원하며, 완전한 프라이버시, 오프라인 기능, 기업용 기능을 갖춘 익숙한 ChatGPT 경험을 인프라에 제공합니다. 지역 및 클라우드 LLM 백엔드에 대한 비교를 원하시면 LLM 호스팅: 로컬, 자체 호스팅 및 클라우드 인프라 비교를 참조하세요.

Open WebUI란 무엇인가요?

Open WebUI는 대규모 언어 모델과 상호 작용할 수 있는 현대적인 채팅 인터페이스를 제공하는 오픈소스, 자체 호스팅 웹 애플리케이션입니다. 클라우드 기반 AI 서비스와 달리 Open WebUI는 완전히 귀하의 인프라에서 실행되며, 데이터, 대화 및 모델 선택에 대한 완전한 제어권을 제공합니다.

Open WebUI는 일반적으로 Ollama와 함께 사용되며, 때로는 비공식적으로 “Ollama WebUI"라고 불리기도 하지만, 사실상 백엔드와 무관한 플랫폼입니다. Ollama의 API를 통해 로컬 모델 실행에 연결할 수 있지만, vLLM, LocalAI, LM Studio, Text Generation WebUI, 심지어 클라우드 제공업체의 OpenAI 호환 엔드포인트도 지원합니다. 이러한 유연성은 Open WebUI가 여러 백엔드, 문서 채팅을 위한 RAG(검색 증강 생성), 다중 사용자 인증, 음성 기능, 광범위한 커스터마이징 옵션을 지원하는 포괄적인 솔루션으로 만들었습니다. 노트북, 홈 서버 또는 쿠버네티스 클러스터에서 모델을 실행하든간에 Open WebUI는 귀하의 요구사항에 맞게 확장됩니다.

Open WebUI를 선택해야 할 이유

프라이버시 우선: 모든 데이터는 귀하의 인프라에 남아 있습니다. 외부 API를 명시적으로 구성하지 않는 한 대화, 문서 또는 프롬프트는 귀하의 네트워크를 떠나지 않습니다.

오프라인 기능: 공기 격리 환경, 제한된 네트워크 또는 인터넷 접속이 불안정하거나 금지된 상황에 완벽합니다. Ollama 또는 vLLM을 통해 로컬에서 실행되는 모델과 결합하면 클라우드 서비스에 대한 완전한 독립성을 달성할 수 있습니다.

기능 풍부: 자체 호스팅 되었음에도 불구하고 문서 업로드 및 RAG, 의미 검색을 통한 대화 기록, 프롬프트 템플릿 및 공유, 모델 관리, 음성 입력/출력, 모바일 반응형 디자인, 어두운/밝은 테마 등 상업적 제공물과 견줄 수 있는 기능을 제공합니다.

다중 사용자 지원: 역할 기반 접근 제어(관리자, 사용자, 대기)를 갖춘 내장 인증 시스템, 사용자 관리 대시보드, 대화 분리, 팀 간 공유 프롬프트 및 모델.

빠른 설치 가이드

Open WebUI를 시작하는 가장 빠른 방법은 Docker를 사용하는 것입니다. 이 섹션에서는 일반적인 배포 시나리오를 다룹니다.

기본 설치 (기존 Ollama에 연결)

시스템에 이미 Ollama가 실행 중이라면 다음 명령을 사용하세요:

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

이 명령은 포트 3000에서 Open WebUI를 실행하며, Docker 볼륨에서 데이터를 지속적으로 유지합니다. http://localhost:3000에서 액세스할 수 있습니다.

패키지 설치 (Open WebUI + Ollama)

Ollama를 포함한 완전한 단일 설정을 원하시면 다음 명령을 사용하세요:

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

--gpus all 플래그는 더 빠른 추론을 위해 GPU 접근을 활성화합니다. CPU만 사용하려면 이 플래그를 생략하세요.

Docker Compose 설정

프로덕션 배포를 위해 Docker Compose는 더 나은 유지보수를 제공합니다:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

docker-compose up -d로 배포합니다.

쿠버네티스 배포

기업용 배포를 위해 Open WebUI는 Helm 차트를 제공합니다:

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

이 명령은 지속 가능한 저장소, 건강 상태 확인 및 선택적 인그레스 구성이 포함된 프로덕션 준비 배포를 생성합니다.

핵심 기능 심층 분석

RAG 및 문서 채팅

Open WebUI의 RAG 구현은 문서를 업로드하고 모델이 대화에서 이를 참조하도록 허용합니다. 시스템은 자동으로 문서를 조각내고, 임베딩을 생성하고, 벡터 데이터베이스에 저장하고, 질문을 할 때 관련된 맥락을 검색합니다.

지원되는 형식: PDF, DOCX, TXT, Markdown, CSV 및 내장 파서를 통해 더 많은 형식.

사용법: 채팅에서 ‘+’ 버튼을 클릭하고 ‘파일 업로드’를 선택한 후 문서를 선택하고 질문을 시작합니다. 모델은 응답에서 관련된 단락과 페이지 번호를 인용합니다.

설정: 관리자 설정에서 조각 크기, 중첩, 임베딩 모델 및 검색 파라미터를 조정하여 문서 유형과 최적의 성능을 얻을 수 있습니다.

다중 사용자 인증 및 관리

Open WebUI는 팀 및 조직 사용에 적합한 완전한 인증 시스템을 포함합니다:

- 로컬 인증: 보안 암호 해싱을 사용한 사용자 이름/암호

- OAuth/OIDC 통합: 기존의 ID 제공자(Google, GitHub, Keycloak 등)에 연결

- LDAP/Active Directory: 기업 디렉토리 통합

- 역할 기반 접근: 관리자(전체 제어), 사용자(표준 접근), 대기(승인 필요)

관리자는 사용자를 관리하고 사용량을 모니터링하고 사용자/그룹별 모델 접근을 구성하고 대화 보존 정책을 설정할 수 있습니다.

음성 입력 및 출력

내장된 음성 상호작용 지원은 Open WebUI를 접근성 있고 편리하게 만듭니다:

- 음성 인식: Web Speech API 또는 구성된 외부 STT 서비스 사용

- 문자 인식: 여러 TTS 엔진 지원(브라우저 기반, Coqui TTS, ElevenLabs 등)

- 언어 지원: TTS/STT 구성에 따라 여러 언어 지원

프롬프트 공학 도구

Open WebUI는 프롬프트 관리에 대한 강력한 도구를 제공합니다:

- 프롬프트 라이브러리: 자주 사용하는 프롬프트를 템플릿으로 저장

- 변수 및 플레이스홀더: 동적 콘텐츠를 포함한 재사용 가능한 프롬프트 생성

- 프롬프트 공유: 팀과 효과적인 프롬프트를 공유

- 프롬프트 버전 관리: 시간에 따른 변경 및 개선 추적

모델 관리

UI를 통해 간편한 모델 전환 및 관리:

- 모델 카탈로그: Ollama 라이브러리에서 직접 모델을 탐색 및 다운로드

- 커스텀 모델: 커스텀 GGUF 모델을 업로드 및 구성

- 모델 파라미터: 대화별로 온도, top-p, 컨텍스트 길이 및 기타 샘플링 파라미터 조정

- 모델 메타데이터: 모델 세부 정보, 크기, 양자화, 기능 보기

설정 및 커스터마이징

환경 변수

환경 변수를 통한 주요 설정 옵션:

# 백엔드 URL (Ollama 또는 기타 OpenAI 호환 API)

OLLAMA_BASE_URL=http://localhost:11434

# 인증 활성화

WEBUI_AUTH=true

# 기본 사용자 역할 (user, admin, pending)

DEFAULT_USER_ROLE=pending

# 사용자 가입 활성화

ENABLE_SIGNUP=true

# 관리자 이메일 (관리자 계정 자동 생성)

WEBUI_ADMIN_EMAIL=admin@example.com

# 데이터베이스 (기본 SQLite, 또는 프로덕션용 PostgreSQL)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# RAG 활성화

ENABLE_RAG=true

# RAG용 임베딩 모델

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

대체 백엔드 연결

Open WebUI는 모든 OpenAI 호환 API와 작동합니다. 설정 → 연결에서 기본 URL을 구성합니다:

- vLLM:

http://localhost:8000/v1 - LocalAI:

http://localhost:8080 - LM Studio:

http://localhost:1234/v1 - Text Generation WebUI:

http://localhost:5000/v1 - OpenAI:

https://api.openai.com/v1(API 키 필요) - Azure OpenAI: 커스텀 엔드포인트 URL

역방향 프록시 설정

프로덕션 배포를 위해 Open WebUI를 역방향 프록시 뒤에 실행하세요:

Nginx 예시:

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# 웹소켓 지원

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Traefik 예시 (Docker 라벨):

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

성능 최적화

데이터베이스 튜닝

다중 사용자 배포를 위해 SQLite에서 PostgreSQL로 전환하세요:

# 의존성 설치

pip install psycopg2-binary

# 데이터베이스 URL 구성

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

PostgreSQL은 동시 사용자를 더 잘 처리하고 대화 검색 및 RAG 작업에 대한 개선된 쿼리 성능을 제공합니다.

임베딩 모델 선택

RAG 성능은 임베딩 모델 선택에 크게 의존합니다:

- 빠르고 자원 제약:

all-MiniLM-L6-v2(384 차원, ~80MB) - 균형:

all-mpnet-base-v2(768 차원, ~420MB) - 최고 품질:

bge-large-en-v1.5(1024 차원, ~1.3GB)

설정 → RAG → 임베딩 모델에서 구성합니다.

캐싱 전략

반복된 API 호출을 줄이기 위해 대화 캐싱을 활성화하세요:

- 모델 캐싱: Ollama는 로드된 모델을 메모리에 자동으로 캐싱

- 응답 캐싱: Open WebUI는 동일한 프롬프트를 캐싱(설정 가능)

- 임베딩 캐싱: 이전에 처리된 문서에 대한 임베딩 재사용

보안 최선 실천

프로덕션에서 Open WebUI를 배포할 때 다음 보안 지침을 따르세요:

- 인증 활성화: 공공 네트워크에서 Open WebUI를 인증 없이 실행하지 마세요

- HTTPS 사용: 항상 TLS/SSL을 사용하는 역방향 프록시 뒤에 배포하세요

- 정기 업데이트: 보안 패치를 위해 Open WebUI 및 Ollama를 최신 상태로 유지하세요

- 접근 제한: 신뢰할 수 있는 네트워크에만 액세스하도록 방화벽 규칙을 설정하세요

- API 키 보안: 외부 API에 연결하는 경우 환경 변수를 사용하고, API 키를 하드코딩하지 마세요

- 감사 로그: 의심스러운 활동을 감지하기 위해 액세스 로그를 활성화하고 모니터링하세요

- 데이터 백업:

/app/backend/data볼륨을 정기적으로 백업하세요 - 데이터베이스 암호화: 프로덕션에서 PostgreSQL에 암호화를 활성화하세요

- 레이트 제한: 남용을 방지하기 위해 레이트 제한을 구성하세요

- 콘텐츠 필터링: 조직에 적합한 콘텐츠 정책을 구현하세요

사용 사례 및 실제 응용

개인 지식 어시스턴트

로컬 모델과 RAG를 결합하여 개인 지식 베이스를 생성하세요. 노트, 연구 논문, 프로젝트 문서 및 개인 문서를 업로드하세요. 클라우드 서비스에 데이터를 전송하지 않고 대화형으로 쿼리할 수 있습니다. 이는 데이터 프라이버시를 중시하는 연구자, 학생, 지식 작업자에게 완벽합니다.

개발 팀 협업

공유된 기술 문서, API 명세, 코드베이스 지식에 대한 액세스를 제공하기 위해 개발 팀에 Open WebUI를 배포하세요. RAG 기능은 수천 페이지의 문서에서 관련 정보를 빠르게 찾을 수 있도록 합니다. 대화 기록은 아키텍처 결정 및 기술 토론을 추적하는 데 도움이 됩니다.

기업 내부 챗봇

기업은 SSO 통합을 통해 내부 인트라넷에 Open WebUI를 배포하여 직원들에게 내부 위키, 정책, 절차에 액세스할 수 있는 AI 어시스턴트를 제공할 수 있습니다. 역할 기반 접근은 민감한 정보가 적절히 분리되도록 보장하며, 관리자 제어는 거버넌스 및 준수를 유지합니다.

교육 및 훈련

교육 기관은 프라이버시 걱정 없이 학생 및 교수에게 AI 지원을 제공하기 위해 Open WebUI를 사용합니다. 강의 자료, 교과서, 강의 노트를 업로드하여 맥락에 맞는 Q&A를 제공합니다. 다중 사용자 시스템은 사용량을 추적하면서도 학생 데이터를 개인적으로 보호합니다.

의료 및 법률 응용

데이터 프라이버시가 중요한 규제 산업에서 Open WebUI는 HIPAA 또는 GDPR 준수를 유지하면서 AI 지원 워크플로우를 가능하게 합니다. 의료 전문가는 약물 데이터베이스 및 치료 프로토콜을 쿼리하고, 법률 팀은 사례법 및 계약을 검색할 수 있습니다—all without data leaving controlled infrastructure.

공기 격리 및 오프라인 환경

정부 기관, 연구소, 보안 운영 센터는 공기 격리 네트워크에서 Open WebUI를 사용합니다. 완전한 오프라인 기능은 인터넷 연결 없이도 AI 지원이 가능하도록 보장하며, 분류된 환경이나 원격 위치에 필수적입니다.

일반적인 문제 해결

연결 문제

문제: Open WebUI가 Ollama에 연결할 수 없습니다

해결: Ollama가 실행 중인지 확인하세요 (curl http://localhost:11434), OLLAMA_BASE_URL 환경 변수를 확인하고 연결을 허용하는 방화벽 규칙을 확인하세요. Docker 배포의 경우 서비스 이름(http://ollama:11434) 대신 localhost를 사용하세요.

문제: UI에 모델이 나타나지 않습니다

해결: 모델이 설치되었는지 확인하세요 (ollama list), Open WebUI 설정에서 모델 목록을 새로고침하고 브라우저 콘솔에서 API 오류를 확인하세요.

RAG 및 문서 업로드 문제

문제: 문서 업로드 실패

해결: 설정에서 파일 크기 제한을 확인하고 지원되는 파일 형식을 확인하고 데이터 볼륨에 충분한 디스크 공간이 있는지 확인하고 컨테이너 로그에서 파싱 오류를 확인하세요.

문제: RAG 응답이 업로드된 문서를 참조하지 않습니다

해결: 임베딩 모델이 다운로드되고 실행 중인지 확인하고 조각 크기 설정을 확인하세요 (더 나은 세분화를 위해 작은 조각을 시도), RAG 설정에서 검색된 조각 수를 증가시키고, 쿼리가 문서 내용과 관련되어 있는지 확인하세요.

성능 문제

문제: 느린 응답 시간

해결: GPU 가속이 가능하다면 활성화하고, 모델 크기를 줄이거나 양자화된 버전을 사용하고, OLLAMA_NUM_PARALLEL을 증가시켜 동시 요청을 처리하고, Docker 컨테이너에 더 많은 RAM을 할당하세요.

문제: 메모리 부족 오류

해결: 더 작은 모델(7B 대신 13B 파라미터)을 사용하고, 모델 파라미터에서 컨텍스트 길이를 줄이고, 동시 사용자를 제한하거나 시스템에 더 많은 RAM/스왑 공간을 추가하세요.

인증 및 접근

문제: 로그인 또는 관리자 계정 생성 불가

해결: WEBUI_AUTH=true로 설정하고, WEBUI_ADMIN_EMAIL을 자동 생성 관리자로 구성하고, 브라우저 쿠키와 캐시를 지우고, 컨테이너 로그에서 데이터베이스 오류를 확인하세요.

문제: 사용자가 가입할 수 없습니다

해결: ENABLE_SIGNUP=true를 확인하고, DEFAULT_USER_ROLE 설정을 확인하세요(자동 승인을 위해 user 또는 수동 승인을 위해 pending 사용), 데이터베이스가 쓰기 가능한지 확인하세요.

Open WebUI 대안

Open WebUI는 강력한 Ollama 통합을 제공하는 자체 호스팅 인터페이스에서 뛰어난 성능을 보이지만, 여러 제공업체 유연성, 특화된 문서 처리, 극단적인 간단함, 또는 기업 기능을 제공하는 대안도 있습니다. 선택은 다중 제공업체 유연성, 특화된 문서 처리, 극단적인 간단함, 또는 기업 기능이 필요한지에 따라 달라집니다.

LibreChat은 제공업체와 무관한 솔루션으로, OpenAI, Anthropic, Azure OpenAI, Google Vertex AI, AWS Bedrock, Ollama를 단일 인터페이스에서 네이티브 지원합니다. 플러그인 아키텍처와 기업 기능(다중 사용자, 상세한 접근 제어, 사용량 할당)은 여러 AI 제공업체를 지원하거나 복잡한 감사 추적이 필요한 조직에 이상적입니다. 단점은 복잡성—LibreChat은 Open WebUI보다 더 많은 설정 노력과 더 무거운 리소스를 요구하며, Ollama 지원은 클라우드 제공업체보다 부차적입니다. 팀이 Claude로 글쓰기, GPT-4로 코딩, 로컬 모델로 프라이버시 민감한 작업을 수행하는 경우 LibreChat의 통합 인터페이스가 빛납니다.

문서 중심 작업을 위해 AnythingLLM은 기본 RAG를 넘어선 지식베이스 중심 접근법을 제공합니다. 작업 공간 모델은 문서 및 대화를 고립된 환경으로 구성하고, 고급 검색 기능에는 하이브리드 검색, 재정렬, 인용 추적이 포함됩니다. 데이터 커넥터는 GitHub, Confluence, Google Drive에서 콘텐츠를 가져오고, 에이전트 기능은 다단계 추론 및 워크플로우 자동화를 가능하게 합니다. 이는 여러 클라이언트 지식베이스를 관리하는 컨설팅 회사나 대량의 문서를 다루는 지원 팀에 이상적입니다. 채팅 인터페이스는 Open WebUI보다 덜 매끄럽지만, 대량의 문서 컬렉션을 쿼리하는 것이 주요 요구사항이라면 복잡한 검색 기능이 학습 곡선을 정당화합니다.

LobeChat은 기능 깊이보다 사용자 경험을 우선시하며, 모바일 친화적인 인터페이스와 프로그레시브 웹 앱 기능을 제공합니다. 현대적인 디자인, 부드러운 애니메이션, 강력한 음성/멀티모달 지원으로 디자이너 및 비기술 사용자에게 인기가 있습니다. PWA 구현은 Open WebUI가 제공하지 않는 앱처럼 모바일 경험을 제공합니다. 그러나 기업 기능은 제한적이며, 플러그인 생태계는 작고, RAG 기능은 Open WebUI 및 AnythingLLM보다 뒤처집니다.

데스크탑 애플리케이션을 선호하는 사용자에게 Jan.ai는 Windows, macOS, Linux의 크로스 플랫폼 설치 프로그램을 제공하며, Ollama를 별도로 설치하거나 Docker를 다루지 않아도 되는 제로 설정 로컬 모델 관리가 가능합니다. 이는 “그냥 작동” 철학으로, 가족 구성원이나 명령줄 도구에 익숙하지 않은 동료에게 로컬 LLM을 제공하기에 이상적입니다. 단점은 다중 사용자 지원이 없고, 고급 기능이 적으며, 원격 액세스 기능이 없습니다.

Chatbox는 경량 니치를 차지하며, OpenAI, Claude, Gemini, 로컬 API를 지원하는 최소한의 크로스 플랫폼 클라이언트로 매우 낮은 자원 오버헤드를 제공합니다. 이는 다른 API 제공업체를 빠르게 테스트하거나 자원 제약이 있는 하드웨어를 사용하는 개발자에게 완벽합니다. 설정 마찰은 최소화되지만, 일부 기능은 구독이 필요하고, 완전히 오픈소스가 아니며, RAG 지원은 제한적입니다.

Ollama에 특화된 최소한의 UI가 존재하며, “충분한 인터페이스"를 원하는 사용자에게 Hollama는 여러 머신의 Ollama 서버를 관리하고, Ollama UI는 기본 채팅 및 PDF 업로드와 매우 간단한 배포를 제공하며, Oterm은 SSH 세션 및 tmux 워크플로우를 위한 놀라운 능력의 터미널 기반 인터페이스를 제공합니다. 이들은 기능을 희생하면서도 간단함과 속도를 제공합니다.

업체 지원이 필요한 조직의 경우, TypingMind Team, BionicGPT, Dust.tt와 같은 상용 옵션은 자체 호스팅과 전문적인 지원, 준수 인증, SLA를 제공합니다. 이들은 오픈소스 자유를 희생하면서도 보장된 가동 시간, 보안 감사 및 책임을 제공하며, 조직이 기업 등급 지원 계약이 필요한 경우 적합합니다.

적절하게 선택하기: Open WebUI는 대부분의 자체 호스팅 Ollama 배포에 이상적인 중간 지점을 제공하며, 포괄적인 기능과 관리 가능한 복잡성 사이의 균형을 제공합니다. 제공업체 유연성이 가장 중요한 경우 LibreChat을 선택하고, 복잡한 문서 워크플로우를 위한 경우 AnythingLLM, 모바일 중심 또는 디자인 중심 사용자에게 LobeChat, 비기술 데스크탑 사용자에게 Jan, 또는 업체 지원이 필요한 경우 상용 옵션을 선택하세요. 대부분의 기술 사용자가 로컬 모델을 실행하는 경우, Open WebUI의 활발한 개발, 강력한 커뮤니티 및 우수한 RAG 구현으로 인해 추천되는 시작점입니다.

미래 개발 및 로드맵

Open WebUI는 빠른 개발을 계속하며, 다음과 같은 흥미로운 기능이 로드맵에 있습니다:

개선된 멀티모달 지원: LLaVA 및 Bakllava와 같은 모델의 이미지, 시각 모델 및 멀티모달 대화에 대한 더 나은 처리.

강화된 에이전트 기능: AutoGPT 패턴과 유사한 함수 호출, 도구 사용, 다단계 추론 워크플로우.

더 나은 모바일 앱: 현재 PWA 구현을 넘어 iOS 및 Android의 네이티브 앱을 제공하여 모바일 경험을 개선합니다.

고급 RAG 기능: 그래프 기반 RAG, 의미 조각, 다중 쿼리 검색, 부모 문서 검색을 통한 더 나은 맥락.

협업 기능: 공유 대화, 팀 워크스페이스, 프롬프트 및 문서에 대한 실시간 협업.

기업 통합: 더 깊은 SSO 지원, SCIM 프로비저닝, 고급 감사 로그, 규제 산업을 위한 준수 보고.

프로젝트는 뒷받침 호환성과 의미 버전 관리를 유지하며, 업그레이드가 간단합니다. 활발한 GitHub 저장소는 매일 커밋과 반응적인 이슈 관리를 제공합니다.

결론

Open WebUI는 단순한 Ollama 프론트엔드에서 자체 호스팅 AI 상호작용을 위한 포괄적인 플랫폼으로 진화했습니다. 프라이버시, 기능, 배포 용이성의 조합으로, 개인, 팀, 조직이 로컬 LLM을 활용하면서 기능을 희생하지 않고 선택할 수 있는 최고의 선택입니다.

개발자가 모델을 테스트하거나, 조직이 내부 AI 도구를 구축하거나, 개인이 프라이버시를 중시하는 경우, Open WebUI는 강력하고 자체 호스팅 AI 워크플로우의 기초를 제공합니다. 활발한 커뮤니티, 정기적인 업데이트, 확장 가능한 아키텍처로 인해 자체 호스팅 AI 공간에서의 리더로 남을 것입니다.

기본 Docker 설치로 시작하고, 몇 개의 문서를 업로드하여 RAG를 시도하고, Ollama 라이브러리에서 다양한 모델을 시도하고, 필요에 따라 고급 기능을 탐색하세요. 학습 곡선은 부드럽지만, 천장은 높습니다—Open WebUI는 개인 노트북에서 기업 쿠버네티스 클러스터까지 확장됩니다.

대안을 비교하는 경우, Open WebUI의 Ollama 중심 설계, 균형 잡힌 기능 세트 및 활발한 개발은 대부분의 자체 호스팅 LLM 배포에 대한 권장 시작점입니다. 특정 요구사항이 생기면 더 전문적인 솔루션으로 이전할 수 있지만, 많은 사용자는 Open WebUI의 기능이 실험에서 프로덕션까지의 전체 여정에 충분하다고 느낍니다.

Open WebUI의 일반적인 백엔드(Ollama, vLLM 등)가 Docker Model Runner, LocalAI 및 클라우드 제공업체와 어떻게 어울리는지 보려면 LLM 호스팅: 로컬, 자체 호스팅 및 클라우드 인프라 비교 가이드를 참조하세요.

유용한 링크

Open WebUI 환경을 설정할 때, 로컬 LLM 호스팅 및 배포 옵션의 더 넓은 생태계를 이해하는 것이 도움이 됩니다. 포괄적인 가이드 로컬 LLM 호스팅: 2025년 완전 가이드 - Ollama, vLLM, LocalAI, Jan, LM Studio 및 기타는 Ollama, vLLM, LocalAI 및 기타 12개 이상의 로컬 LLM 도구를 비교하여 Open WebUI 배포에 적합한 백엔드를 선택하는 데 도움을 줍니다. API 성숙도, 도구 호출 기능, 성능 벤치마크에 따라 선택할 수 있습니다.

고성능 프로덕션 배포에서 처리량 및 지연이 중요한 경우, vLLM 빠른 시작: 고성능 LLM 서빙 가이드를 참조하세요. 이는 vLLM 설정, OpenAI API 호환성, PagedAttention 최적화를 다룹니다. Open WebUI가 여러 동시 사용자를 서비스하고 Ollama의 성능이 병목이 되는 경우 특히 유용합니다.

백엔드가 동시 요청을 처리하는 방식을 이해하는 것은 용량 계획에 중요합니다. Ollama가 병렬 요청을 처리하는 방식 문서는 Ollama의 요청 대기열, GPU 메모리 관리, 동시 실행 모델을 설명하며, Open WebUI 배포의 다중 사용자 시나리오에 적절한 제한 및 예상치를 설정하는 데 도움을 줍니다.

외부 자원

공식 문서 및 커뮤니티 지원을 위해 다음 외부 자원을 참조하세요: