Hardware

Самостоятельное развертывание LLM и суверенитет ИИ

Управляйте данными и моделями с помощью самодостаточных ЛЛМ

Размещение ЛЛМ на собственных серверах позволяет контролировать данные, модели и вычисления — практический путь к суверенитету ИИ для команд, предприятий и стран. Здесь мы расскажем, что такое суверенный ИИ, какие аспекты и методы используются для его создания, как размещение ЛЛМ на собственных серверах вписывается в эту концепцию и как страны решают эту задачу.

Лучшие языковые модели для Ollama на GPU с 16 ГБ видеопамяти

Тест скорости LLM на RTX 4080 с 16 ГБ видеопамяти

Запуск крупных языковых моделей локально обеспечивает вам конфиденциальность, возможность работы оффлайн и отсутствие затрат на API. Этот бенчмарк раскрывает, чего именно можно ожидать от 9 популярных LLMs на Ollama на RTX 4080.

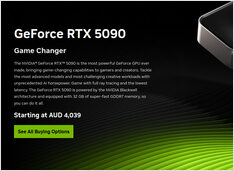

Рост цен на GPU и ОЗУ в Австралии: RTX 5090 подорожал на 15%, ОЗУ — на 38% — январь 2026 года

Проверка цен на GPU и RAM в январе 2025 года

Сегодня мы рассматриваем топовые потребительские графические процессоры и модули оперативной памяти. Конкретно я смотрю на цены на RTX-5080 и RTX-5090, а также на 32ГБ (2x16ГБ) DDR5 6000.

Лучшие эмуляторы терминалов Linux: сравнение 2026

Выберите подходящий терминал для вашего рабочего процесса в Linux

Цены на DGX Spark AU: $6,249-$7,999 у крупных ритейлеров

Актуальные цены на AUD у австралийских ритейлеров

NVIDIA DGX Spark (GB10 Grace Blackwell) теперь доступен в Австралии в местных магазинах у крупных розничных продавцов ПК с наличием на складе. Если вы следили за глобальными ценами и доступностью DGX Spark, вам будет интересно узнать, что цены в Австралии составляют от 6 249 до 7 999 AUD в зависимости от конфигурации хранилища и продавца.

Самостоятельное размещение Cognee: тесты производительности LLM

Тестирование Cognee с локальными ЛСМ — реальные результаты

Cognee — это фреймворк на Python для создания знаний из документов с использованием LLMs. Но работает ли он с локальными моделями?

Ubuntu потеряла сеть после обновления ядра

Как я исправил проблемы с сетью в Ubuntu

После автоматической установки нового ядра, Ubuntu 24.04 потеряла сетевое подключение по Ethernet. Эта раздражающая проблема произошла со мной во второй раз, поэтому я документирую решение здесь, чтобы помочь другим, столкнувшимся с той же проблемой.

Цена на ОЗУ в Австралии - декабрь 2025 года

Короткий пост, просто отмечаю цену

С этой безумной волатильностью цен на оперативную память, чтобы сформировать и иметь лучшее представление, давайте сначала отследим цену на оперативную память в Австралии.

Рост цен на ОЗУ: до 619% к 2025 году

Цены на ОЗУ выросли на 163-619% из-за роста спроса на ИИ

Рынок памяти переживает беспрецедентную ценовую волатильность в конце 2025 года, с резким ростом цен на ОЗУ во всех сегментах.

Цены на видеокарты NVIDIA RTX 5080 и RTX 5090 в Австралии - ноябрь 2025 года

Цены на потребительские GPU, подходящие для ИИ - RTX 5080 и RTX 5090

Давайте сравним цены на топовые потребительские видеокарты, которые подходят для ЛЛМ и ИИ в целом. Конкретно я рассматриваю цены на RTX-5080 и RTX-5090.

Инфраструктура ИИ на потребительском оборудовании

Развертывание корпоративного ИИ на бюджетном оборудовании с открытыми моделями

Демократизация ИИ уже здесь. С открытыми моделями ИИ с открытым исходным кодом, такими как Llama 3, Mixtral и Qwen, которые теперь соперничают с проприетарными моделями, команды могут создавать мощную инфраструктуру ИИ с использованием потребительского оборудования - снижая затраты, сохраняя при этом полный контроль над конфиденциальностью данных и развертыванием.

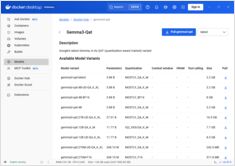

Добавление поддержки GPU NVIDIA в Docker Model Runner

Включите ускорение с помощью GPU для Docker Model Runner с поддержкой NVIDIA CUDA

Docker Model Runner — это официальный инструмент Docker для запуска моделей ИИ локально, но включение ускорения NVidia GPU в Docker Model Runner требует специальной настройки.

Сравнение производительности Ollama: NVIDIA DGX Spark против Mac Studio против RTX-4080

Бенчмарки GPT-OSS 120b на трёх платформах ИИ

Я выкопал некоторые интересные тесты производительности GPT-OSS 120b, работающей на Ollama на трех разных платформах: NVIDIA DGX Spark, Mac Studio и RTX 4080. Модель GPT-OSS 120b из библиотеки Ollama весит 65ГБ, что означает, что она не помещается в 16ГБ видеопамяти RTX 4080 (или более новой RTX 5080).

Шпаргалка Docker Model Runner: команды и примеры

Справочник команд Docker Model Runner

Docker Model Runner (DMR) — это официальное решение Docker для запуска моделей ИИ локально, представленное в апреле 2025 года. Этот справочник предоставляет быстрый доступ ко всем основным командам, настройкам и лучшим практикам.

GNOME Boxes: Полное руководство по функциям, преимуществам, проблемам и альтернативам

Простое управление виртуальными машинами в Linux с помощью GNOME Boxes

В современном вычислительном ландшафте виртуализация стала неотъемлемой частью разработки, тестирования и запуска нескольких операционных систем. Для пользователей Linux, ищущих простой и интуитивно понятный способ управления виртуальными машинами, GNOME Boxes выделяется как легковесный и удобный вариант, который делает акцент на простоте использования без ущерба для функциональности.