Сравнение производительности Ollama: NVIDIA DGX Spark против Mac Studio против RTX-4080

Бенчмарки GPT-OSS 120b на трёх платформах ИИ

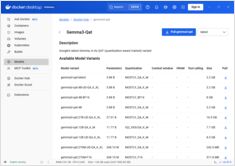

Я выкопал некоторые интересные тесты производительности GPT-OSS 120b, работающей на Ollama на трех разных платформах: NVIDIA DGX Spark, Mac Studio и RTX 4080. Модель GPT-OSS 120b из библиотеки Ollama весит 65ГБ, что означает, что она не помещается в 16ГБ видеопамяти RTX 4080 (или более новой RTX 5080).