NVIDIA DGX Spark vs Mac Studio vs RTX-4080: Porównanie wydajności Ollama

Wyniki testów GPT-OSS 120b na trzech platformach AI

Wyniki testów GPT-OSS 120b na trzech platformach AI

Tworzenie serwerów MCP dla asystentów AI z przykładami w Pythonie

Protokół Kontekstu Modelu (MCP) rewolucjonizuje sposób, w jaki asystenci AI interagują z zewnętrznymi źródłami danych i narzędziami. W tym przewodniku omówimy, jak zbudować serwery MCP w Pythonie, z przykładami skupionymi na możliwościach wyszukiwania w sieci i skrapowania.

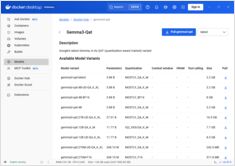

Szybki przewodnik po poleceniach Docker Model Runner

Docker Model Runner (DMR) to oficjalne rozwiązanie firmy Docker do uruchamiania modeli AI lokalnie, wprowadzone w kwietniu 2025 roku. Ten cheatsheet zawiera szybki przewodnik po wszystkich istotnych komendach, konfiguracjach i najlepszych praktykach.

Porównaj Docker Model Runner i Ollama dla lokalnego LLM

Uruchamianie dużych modeli językowych (LLM) lokalnie staje się coraz bardziej popularne ze względu na prywatność, kontrolę kosztów i możliwości offline. Landscape zmienił się znacząco w kwietniu 2025 roku, gdy Docker wprowadził Docker Model Runner (DMR), oficjalne rozwiązanie do wdrażania modeli AI.

Specjalistyczne procesory sprawiają, że wnioskowanie w AI jest szybsze i tańsze.

Przyszłość AI nie jest tylko o bardziej inteligentne modele – jest o bardziej inteligentny krzem.

Specjalistyczne sprzęty do wyznaczania wyników LLM napędzają rewolucję podobną do przejścia od wydobywania bitcoina do ASICów.

Dostępność, rzeczywiste ceny detaliczne na terenie sześciu krajów oraz porównanie z Mac Studio.

NVIDIA DGX Spark jest rzeczywisty, dostępny do zakupu 15 października 2025 roku, i skierowany do programistów CUDA, którzy potrzebują lokalnej pracy z LLM zintegrowanej z NVIDIA AI stack. Cena MSRP w Stanach Zjednoczonych to $3 999; UK/DE/JP ma wyższą cenę detaliczną z powodu VAT i kanałów. AUD/KRW publiczne ceny są jeszcze nie powszechnie opublikowane.

Integruj Ollama z Go: przewodnik po SDK, przykłady i najlepsze praktyki w środowisku produkcyjnym.

Ten przewodnik oferuje kompleksowy przegląd dostępnych Go SDKs dla Ollama i porównuje ich zestawy funkcji.

Porównanie prędkości, parametrów i wydajności tych dwóch modeli

Oto porównanie między Qwen3:30b a GPT-OSS:20b skupiające się na przestrzeganiu instrukcji i parametrach wydajności, specyfikacjach oraz prędkości:

Nie bardzo przyjemne.

Modele GPT-OSS z Ollama mają powtarzające się problemy z obsługą strukturalnego wyjścia, zwłaszcza gdy są używane wraz z frameworkami takimi jak LangChain, OpenAI SDK, vllm i innymi.

Kilka sposobów na uzyskanie strukturalnego wyjścia z Ollama

Duże modele językowe (LLMs)

są potężne, ale w środowisku produkcyjnym rzadko chcemy wolnych paragrafów.

Zamiast tego chcemy przewidywalne dane: atrybuty, fakty lub strukturalne obiekty, które można przekazać do aplikacji.

To Strukturalne wyjście LLM.

Moje własne przetestowanie harmonogramowania modelu ollama ```

Oto porównanie jak dużo VRAM nowa wersja Ollama przydziela modelowi

z poprzednią wersją Ollama. Nowa wersja jest gorsza.

Moje zdanie na temat obecnego stanu rozwoju Ollama

Ollama szybko stało się jednym z najpopularniejszych narzędzi do lokalnego uruchamiania modeli językowych. Jego prosty interfejs CLI oraz zoptymalizowany zarządzanie modelami sprawiły, że stał się pierwszym wyborem dla programistów, którzy chcą pracować z modelami AI poza chmurą. Ale tak jak w przypadku wielu obiecujących platform, już teraz pojawiają się pierwsze oznaki Enshittification:

Szybki przegląd najbardziej znanych interfejsów użytkownika dla Ollama w 2025 roku

Lokalnie hostowany Ollama umożliwia uruchamianie dużych modeli językowych na własnym komputerze, ale korzystanie z niego przez wiersz poleceń nie jest przyjazne dla użytkownika. Oto kilka projektów open source, które oferują interfejsy stylu ChatGPT, łączące się z lokalnym Ollama.

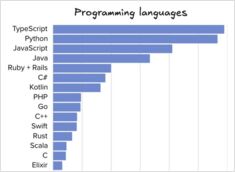

Porównanie narzędzi i języków inżynierii oprogramowania

Liczba przesłanych danych z ankiety o popularność języków programowania, IDE i narzędzi AI z kilku dni temu została opublikowana w liście The Pragmatic Engineer popularność języków programowania, IDE i narzędzi AI oraz inne dane na temat połowy 2025 roku.

W lipcu 2025 r. niedługo powinno zostać dostępne

NVIDIA wkrótce wyda NVIDIA DGX Spark – mały superkomputer AI oparty na architekturze Blackwell z 128+GB jednolitej pamięci RAM i wydajnością 1 PFLOPS w zakresie AI. Świetny sprzęt do uruchamiania LLM.

Wdrażanie RAG? Oto kilka fragmentów kodu w Go - 2...

Ponieważ standardowy Ollama nie ma bezpośredniego interfejsu API do ponownego rangowania, musisz zaimplementować ponowne rangowanie przy użyciu Qwen3 Reranker w GO generując embeddingi dla par zapytań i dokumentów oraz oceniając je.