Ubuntu에서 Grafana 설치 및 사용: 완전 가이드

모니터링 및 시각화를 위한 Grafana 설정 방법 정리

Grafana은 메트릭, 로그, 트레이스를 시각화하여 실행 가능한 통찰을 제공하는 모니터링 및 관찰 플랫폼으로, 시각적으로 인상적인 시각화를 통해 리딩 오픈소스 플랫폼입니다.

모니터링 및 시각화를 위한 Grafana 설정 방법 정리

Grafana은 메트릭, 로그, 트레이스를 시각화하여 실행 가능한 통찰을 제공하는 모니터링 및 관찰 플랫폼으로, 시각적으로 인상적인 시각화를 통해 리딩 오픈소스 플랫폼입니다.

순차적 확장 및 지속 가능한 데이터와 함께 상태 있는 앱 배포

Kubernetes StatefulSets은 안정적인 정체성, 지속 가능한 저장소, 순서 있는 배포 패턴이 필요한 상태가 있는 애플리케이션을 관리하는 데 이상적인 솔루션입니다. 데이터베이스, 분산 시스템, 캐싱 레이어와 같은 필수적인 작업에 사용됩니다.

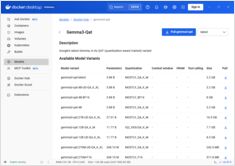

GGUF 양자화로 FLUX.1-dev 가속화

FLUX.1-dev 은 텍스트에서 이미지를 생성하는 강력한 모델로, 놀라운 결과를 제공하지만 24GB 이상의 메모리 요구 사항으로 인해 많은 시스템에서 실행하기 어렵습니다. GGUF quantization of FLUX.1-dev 은 메모리 사용량을 약 50% 줄이며 우수한 이미지 품질을 유지하는 해결책을 제공합니다.

Docker 모델 러너에서 컨텍스트 크기 구성 및 대안 방법

도커 모델 러너에서 컨텍스트 크기 구성은 예상보다 더 복잡합니다.

텍스트 지시문으로 이미지를 강화하는 AI 모델

블랙 포레스트 랩스는 텍스트 지시문을 사용하여 기존 이미지를 향상시키는 고급 이미지에서 이미지로 생성하는 AI 모델인 FLUX.1-Kontext-dev를 출시했습니다.

NVIDIA CUDA를 지원하는 Docker 모델 러너에 GPU 가속 기능을 활성화하세요.

Docker Model Runner은 로컬에서 AI 모델을 실행하기 위한 Docker의 공식 도구이지만, NVIDIA GPU 가속을 Docker Model Runner에서 활성화하기 위해서는 특정한 설정이 필요합니다.

헤드리스 CMS 비교 - 기능, 성능 및 사용 사례

올바른 헤드리스 CMS를 선택하는 것은 콘텐츠 관리 전략을 성공적으로 만들거나 망하게 만들 수 있습니다.

개발자가 콘텐츠 중심 애플리케이션을 구축하는 방식에 영향을 미치는 세 가지 오픈소스 솔루션을 비교해 보겠습니다.

자체 호스팅된 Nextcloud 클라우드 저장소로 데이터를 제어하세요.

Nextcloud은 데이터에 대한 완전한 통제를 제공하는 최고의 오픈소스, 자체 호스팅 클라우드 저장소 및 협업 플랫폼입니다.

자체 호스팅된 AI 기반 백업에 저장된 사진

Immich는 사진 및 영상 관리에 대한 완전한 제어권을 제공하는 혁신적인 오픈소스, 자체 호스팅 솔루션입니다. 구글 포토와 경쟁할 수 있는 기능을 갖추고 있으며, AI 기반 얼굴 인식, 스마트 검색, 자동 모바일 백업을 포함하여 데이터를 개인 서버에서 안전하게 보호합니다.

검색, 인덱싱 및 분석을 위한 Elasticsearch 명령어

Elasticsearch은 Apache Lucene 기반의 강력한 분산 검색 및 분석 엔진입니다.

이 포괄적인 체크리스트는 Elasticsearch 클러스터와 함께 작업할 때 필수 명령어, 최선의 실천 방법, 그리고 빠른 참조를 다룹니다.

GPT-OSS 120b의 세 개 AI 플랫폼에서의 벤치마크

Docker Model Runner 명령어의 빠른 참조

Docker 모델 러너 (DMR)는 2025년 4월에 도입된 Docker의 공식 솔루션으로, 로컬에서 AI 모델을 실행하는 데 사용됩니다. 이 체크리스트는 모든 필수 명령어, 구성 및 최선의 실천 방법에 대한 빠른 참조를 제공합니다.

도커 모델 러너와 올라마를 사용한 로컬 LLM 비교

로컬에서 대규모 언어 모델(LLM) 실행 는 프라이버시, 비용 관리, 오프라인 기능을 위해 점점 더 인기를 끌고 있습니다. 2025년 4월에 Docker가 Docker Model Runner (DMR), AI 모델 배포를 위한 공식 솔루션을 발표하면서 상황은 크게 변화했습니다.

GNOME Boxes를 사용한 Linux용 간단한 가상 머신 관리

현대 컴퓨팅 환경에서 가상화는 개발, 테스트, 여러 운영 체제의 실행에 필수적인 요소가 되었습니다. Linux 사용자들이 가상 머신을 관리하는 데 간단하고 직관적인 방법을 원한다면, GNOME Boxes는 기능성을 희생하지 않고 사용 편의성을 중시하는 가벼운 사용자 친화적인 옵션으로 두드러집니다.

다중 패스 설치, 설정 및 필수 명령어

Multipass은 Linux, Windows, macOS에서 Ubuntu 클라우드 인스턴스를 쉽게 생성하고 관리할 수 있는 가벼운 가상 머신 관리자입니다.

구글과 빙을 넘어 다른 검색 엔진을 탐색해 보세요.

구글이 전 세계 시장 점유율의 90% 이상을 차지하며 검색 엔진 시장을 지배하고 있지만, 다양한 접근 방식을 제공하는 대체 검색 엔진들이 성장하고 있는 생태계가 존재합니다.