Открытый WebUI: Интерфейс самонастроенного LLM

Самостоятельно развёртываемая альтернатива ChatGPT для локальных моделей большого языка

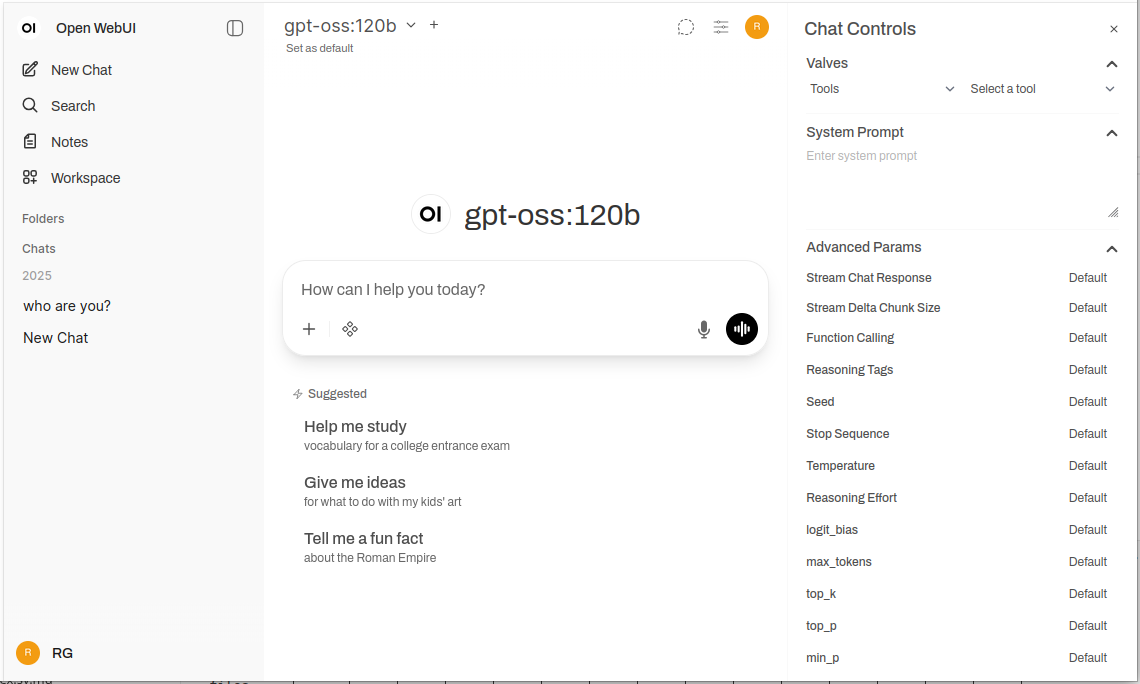

Открыть WebUI — это мощное, расширяемое и функциональное веб-приложение для взаимодействия с большими языковыми моделями.

Оно поддерживает Ollama и любые API, совместимые с OpenAI, предоставляя знакомый опыт ChatGPT в вашей инфраструктуре с полной конфиденциальностью, возможностью работы оффлайн и корпоративными функциями. Для более широкого сравнения локальных и облачных бэкендов LLM — Ollama, vLLM, Docker Model Runner, LocalAI и облачных провайдеров — см. Хостинг LLM: Локальные, Самостоятельно Развертываемые и Облачные Инфраструктуры Сравнены.

Что такое Open WebUI?

Open WebUI — это открытое, самостоятельно развертываемое веб-приложение, предоставляющее современный чат-интерфейс для взаимодействия с большими языковыми моделями. В отличие от облачных AI-сервисов, Open WebUI работает полностью на вашей инфраструктуре, давая вам полный контроль над данными, беседами и выбором моделей.

Хотя Open WebUI часто используется с Ollama (и иногда неформально называется “Ollama WebUI”), на самом деле это платформа, независимая от бэкенда. Она может подключаться к API Ollama для локального выполнения моделей, но также поддерживает любые конечные точки, совместимые с OpenAI — включая vLLM, LocalAI, LM Studio, Text Generation WebUI и даже облачные провайдеры. Эта гибкость делает Open WebUI всеобъемлющим решением, поддерживающим несколько бэкендов, RAG (Retrieval-Augmented Generation) для чата с документами, многопользовательскую аутентификацию, голосовые возможности и широкие возможности настройки. Будь то запуск моделей на ноутбуке, домашнем сервере или кластере Kubernetes, Open WebUI масштабируется для удовлетворения ваших потребностей.

Почему выбрать Open WebUI?

Конфиденциальность на первом месте: Все данные остаются на вашей инфраструктуре — никакие беседы, документы или запросы не покидают вашу сеть, если вы явно не настроили внешние API.

Возможность работы оффлайн: Идеально для изолированных сред, ограниченных сетей или ситуаций, где доступ в интернет ненадежен или запрещен. В сочетании с локально работающими моделями через Ollama или vLLM вы достигаете полной независимости от облачных сервисов.

Богатый функционал: Несмотря на то, что это самостоятельно развертываемое решение, Open WebUI соперничает с коммерческими предложениями, предоставляя загрузку документов и RAG, историю бесед с семантическим поиском, шаблоны и обмен запросами, управление моделями, голосовой ввод/вывод, адаптивный дизайн для мобильных устройств и темные/светлые темы.

Поддержка нескольких пользователей: Встроенная система аутентификации с ролевым доступом (администратор, пользователь, ожидающий), панель управления пользователями, изоляция бесед и общие запросы и модели для команд.

Быстрое руководство по установке

Самый быстрый способ начать работу с Open WebUI — использовать Docker. Этот раздел охватывает наиболее распространенные сценарии развертывания.

Базовая установка (подключение к существующему Ollama)

Если у вас уже установлен Ollama, используйте эту команду:

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Это запускает Open WebUI на порту 3000, сохраняя данные в Docker-томе. Доступ к нему осуществляется по адресу http://localhost:3000.

Комплектная установка (Open WebUI + Ollama)

Для полного решения “все-в-одном” с включенным Ollama:

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

Флаг --gpus all включает доступ к GPU для более быстрого вывода. Удалите его, если вы работаете только на CPU.

Настройка Docker Compose

Для производственных развертываний Docker Compose обеспечивает лучшую поддерживаемость:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

Разверните с помощью docker-compose up -d.

Развертывание в Kubernetes

Для корпоративных развертываний Open WebUI предоставляет Helm-чарты:

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

Это создает производственное развертывание с постоянным хранилищем, проверками здоровья и опциональной конфигурацией ингресса.

Глубокое погружение в ключевые функции

RAG и чат с документами

Реализация RAG в Open WebUI позволяет загружать документы и использовать их в беседах. Система автоматически разбивает документы на части, генерирует эмбеддинги, сохраняет их в векторной базе данных и извлекает релевантный контекст при запросе вопросов.

Поддерживаемые форматы: PDF, DOCX, TXT, Markdown, CSV и другие через встроенные парсеры.

Использование: Нажмите кнопку ‘+’ в чате, выберите ‘Загрузить файлы’, выберите свои документы и начните задавать вопросы. Модель будет ссылаться на релевантные отрывки и номера страниц в своих ответах.

Настройка: Вы можете регулировать размер частей, перекрытие, модель эмбеддингов и параметры извлечения в административных настройках для оптимальной производительности с вашими типами документов.

Многопользовательская аутентификация и управление

Open WebUI включает полную систему аутентификации, подходящую для использования командами и организациями:

- Локальная аутентификация: Имя пользователя/пароль с безопасным хешированием паролей

- Интеграция OAuth/OIDC: Подключение к существующим провайдерам идентификации (Google, GitHub, Keycloak и т.д.)

- LDAP/Active Directory: Интеграция с корпоративными каталогами

- Ролевая модель доступа: Администратор (полный контроль), Пользователь (стандартный доступ), Ожидающий (требует подтверждения)

Администраторы могут управлять пользователями, отслеживать использование, настраивать доступ к моделям для пользователей/групп и устанавливать политики хранения бесед.

Голосовой ввод и вывод

Встроенная поддержка голосового взаимодействия делает Open WebUI доступным и удобным:

- Речь в текст: Использует Web Speech API или настроенные внешние STT-сервисы

- Текст в речь: Поддерживается несколько TTS-движков (на основе браузера, Coqui TTS, ElevenLabs и т.д.)

- Поддержка языков: Работает с несколькими языками в зависимости от вашей конфигурации TTS/STT

Инструменты для инженерии запросов

Open WebUI предоставляет мощные инструменты для управления запросами:

- Библиотека запросов: Сохраняйте часто используемые запросы как шаблоны

- Переменные и заполнители: Создавайте повторно используемые запросы с динамическим содержимым

- Обмен запросами: Делитесь эффективными запросами с вашей командой

- Версионирование запросов: Отслеживайте изменения и улучшения со временем

Управление моделями

Простое переключение и управление моделями через интерфейс:

- Каталог моделей: Просматривайте и загружайте модели напрямую из библиотеки Ollama

- Пользовательские модели: Загружайте и настраивайте пользовательские модели GGUF

- Параметры моделей: Настраивайте температуру, top-p, длину контекста и другие параметры выборки для каждой беседы

- Метаданные моделей: Просматривайте детали модели, размер, квантование и возможности

Настройка и кастомизация

Переменные окружения

Ключевые опции конфигурации через переменные окружения:

# URL бэкенда (Ollama или другой API, совместимый с OpenAI)

OLLAMA_BASE_URL=http://localhost:11434

# Включить аутентификацию

WEBUI_AUTH=true

# Роль пользователя по умолчанию (user, admin, pending)

DEFAULT_USER_ROLE=pending

# Разрешить регистрацию пользователей

ENABLE_SIGNUP=true

# Email администратора (автоматически создается учетная запись администратора)

WEBUI_ADMIN_EMAIL=admin@example.com

# База данных (по умолчанию SQLite, или PostgreSQL для производства)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# Включить RAG

ENABLE_RAG=true

# Модель эмбеддингов для RAG

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

Подключение к альтернативным бэкендам

Open WebUI работает с любым API, совместимым с OpenAI. Настройте базовый URL в Настройках → Подключения:

- vLLM:

http://localhost:8000/v1 - LocalAI:

http://localhost:8080 - LM Studio:

http://localhost:1234/v1 - Text Generation WebUI:

http://localhost:5000/v1 - OpenAI:

https://api.openai.com/v1(требуется API ключ) - Azure OpenAI: Пользовательский URL конечной точки

Настройка обратного прокси

Для производственных развертываний запускайте Open WebUI за обратным прокси:

Пример Nginx:

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# Поддержка WebSocket

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Пример Traefik (метки Docker):

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

Оптимизация производительности

Настройка базы данных

Для развертываний с несколькими пользователями переключитесь с SQLite на PostgreSQL:

# Установка зависимостей

pip install psycopg2-binary

# Настройка URL базы данных

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

PostgreSQL лучше справляется с одновременными пользователями и обеспечивает улучшенную производительность запросов для поиска бесед и операций RAG.

Выбор модели эмбеддингов

Производительность RAG сильно зависит от выбора модели эмбеддингов:

- Быстрая/Ресурсосберегающая:

all-MiniLM-L6-v2(384 измерения, ~80MB) - Сбалансированная:

all-mpnet-base-v2(768 измерений, ~420MB) - Лучшее качество:

bge-large-en-v1.5(1024 измерения, ~1.3GB)

Настройте в Настройках → RAG → Модель эмбеддингов.

Стратегии кэширования

Включите кэширование бесед для уменьшения повторных вызовов API:

- Кэширование моделей: Ollama автоматически кэширует загруженные модели в памяти

- Кэширование ответов: Open WebUI может кэшировать идентичные запросы (настраиваемо)

- Кэш эмбеддингов: Повторное использование эмбеддингов для ранее обработанных документов

Лучшие практики безопасности

При развертывании Open WebUI в производственной среде следуйте этим рекомендациям по безопасности:

- Включите аутентификацию: Никогда не запускайте Open WebUI без аутентификации в публичных сетях

- Используйте HTTPS: Всегда развертывайте за обратным прокси с TLS/SSL

- Регулярные обновления: Держите Open WebUI и Ollama обновленными для получения исправлений безопасности

- Ограничьте доступ: Используйте правила брандмауэра для ограничения доступа к доверенным сетям

- Безопасность API-ключей: Если подключаетесь к внешним API, используйте переменные окружения, никогда не жестко закодированные ключи

- Журналы аудита: Включите и мониторьте журналы доступа для выявления подозрительной активности

- Резервное копирование данных: Регулярно создавайте резервные копии тома

/app/backend/data - Шифрование базы данных: Включите шифрование “на месте” для PostgreSQL в производственной среде

- Ограничение скорости: Настройте ограничения скорости для предотвращения злоупотреблений

- Фильтрация контента: Реализуйте политики контента, соответствующие вашей организации

Примеры использования и реальные приложения

Персональный помощник знаний

Комбинируйте Open WebUI с локальными моделями и RAG для создания закрытой базы знаний. Загружайте свои заметки, исследовательские статьи, проектную документацию и личные документы. Запрашивайте их в разговорной форме без отправки данных в облачные сервисы — идеально для исследователей, студентов и работников знаний, которые ценят конфиденциальность.

Коллаборация команды разработчиков

Развертывайте Open WebUI для вашей команды разработчиков с общим доступом к технической документации, спецификациям API и знаниям кода. Функция RAG позволяет разработчикам быстро находить релевантную информацию среди тысяч страниц документации, а история разговоров помогает отслеживать архитектурные решения и технические обсуждения.

Корпоративный внутренний чат-бот

Организации могут развертывать Open WebUI за своим брандмауэром с интеграцией SSO, предоставляя сотрудникам AI-ассистента, который имеет доступ к внутренним вики, политикам и процедурам. Ролевая модель доступа обеспечивает правильное сегментирование конфиденциальной информации, а административные настройки поддерживают управление и соответствие требованиям.

Образование и обучение

Образовательные учреждения используют Open WebUI для предоставления студентам и преподавателям AI-помощи без проблем с конфиденциальностью. Загружайте учебные материалы, учебники и лекционные заметки для контекстного Q&A. Многопользовательская система позволяет отслеживать использование, сохраняя данные студентов конфиденциальными.

Медицинские и юридические приложения

В регулируемых отраслях, где критична конфиденциальность данных, Open WebUI позволяет AI-поддерживаемым рабочим процессам, сохраняя соответствие HIPAA или GDPR. Медицинские работники могут запрашивать базы данных лекарств и протоколы лечения, а юридические команды могут искать судебные прецеденты и контракты — все без выхода данных за пределы контролируемой инфраструктуры.

Изолированные и оффлайн-среды

Государственные агентства, исследовательские учреждения и центры управления безопасностью используют Open WebUI в изолированных сетях. Полная оффлайн-возможность обеспечивает доступность AI-помощи даже без интернет-соединения, что критично для классифицированных сред или удаленных мест.

Устранение распространенных проблем

Проблемы с подключением

Проблема: Open WebUI не может подключиться к Ollama

Решение: Убедитесь, что Ollama запущен (curl http://localhost:11434), проверьте переменную окружения OLLAMA_BASE_URL и убедитесь, что правила брандмауэра разрешают подключение. Для развертываний Docker используйте имена сервисов (http://ollama:11434) вместо localhost.

Проблема: Модели не отображаются в интерфейсе

Решение: Подтвердите установку моделей (ollama list), обновите список моделей в настройках Open WebUI и проверьте консоль браузера на наличие ошибок API.

Проблемы с RAG и загрузкой документов

Проблема: Загрузка документа не удалась Решение: Проверьте лимиты размера файлов в настройках, убедитесь в поддержке формата файла, проверьте наличие достаточного места на диске в томе данных и проверьте логи контейнера на наличие ошибок разбора.

Проблема: Ответы RAG не ссылаются на загруженные документы Решение: Убедитесь, что модель встраивания загружена и работает, проверьте настройки размера фрагментов (попробуйте меньшие фрагменты для лучшей детализации), увеличьте количество извлеченных фрагментов в настройках RAG и убедитесь, что запрос соответствует содержимому документа.

Проблемы с производительностью

Проблема: Медленные времена ответа

Решение: Включите ускорение GPU, если доступно, уменьшите размер модели или используйте квантованные версии, увеличьте OLLAMA_NUM_PARALLEL для одновременных запросов и выделите больше оперативной памяти для контейнеров Docker.

Проблема: Ошибки нехватки памяти Решение: Используйте меньшие модели (7B вместо 13B параметров), уменьшите длину контекста в параметрах модели, ограничьте количество одновременных пользователей или добавьте больше оперативной памяти/обмена на вашу систему.

Аутентификация и доступ

Проблема: Не могу войти или создать админский аккаунт

Решение: Установите WEBUI_AUTH=true, настройте WEBUI_ADMIN_EMAIL для автоматического создания админа, очистите куки и кеш браузера и проверьте логи контейнера на наличие ошибок базы данных.

Проблема: Пользователи не могут зарегистрироваться

Решение: Убедитесь, что ENABLE_SIGNUP=true, проверьте настройку DEFAULT_USER_ROLE (используйте user для автоматического одобрения или pending для ручного одобрения) и убедитесь, что база данных доступна для записи.

Альтернативы Open WebUI

Хотя Open WebUI преуспевает в предоставлении самодостаточного интерфейса с сильной интеграцией Ollama, несколько альтернатив предлагают разные подходы к той же проблеме. Ваш выбор зависит от того, нужна ли вам гибкость нескольких поставщиков, специализированная обработка документов, экстремальная простота или корпоративные функции.

LibreChat выделяется как наиболее поставщико-независимое решение, предлагая нативную поддержку OpenAI, Anthropic, Azure OpenAI, Google Vertex AI, AWS Bedrock и Ollama в одном интерфейсе. Его плагинная архитектура и корпоративные функции, такие как многопользовательская работа, детальные контроль доступа и квоты использования, делают его идеальным для организаций, которым нужно поддерживать несколько поставщиков AI или требовать сложные аудиторские журналы. Компромисс — сложность: LibreChat требует больших усилий по настройке и более тяжелых ресурсов, чем Open WebUI, а его поддержка Ollama кажется вторичной по сравнению с облачными поставщиками. Если ваша команда использует Claude для написания, GPT-4 для кодирования и локальные модели для работы с конфиденциальными данными, унифицированный интерфейс LibreChat выделяется.

Для рабочих процессов, связанных с документами, AnythingLLM предлагает подход, ориентированный на базу знаний, который выходит за рамки базового RAG. Его модель рабочей области организует документы и разговоры в изолированные среды, а продвинутые функции извлечения включают гибридный поиск, переранжирование и отслеживание цитирования. Коннекторы данных извлекают контент из GitHub, Confluence и Google Drive, а возможности агентов позволяют многократное рассуждение и автоматизацию рабочих процессов. Это делает AnythingLLM отличным для консалтинговых фирм, управляющих несколькими клиентскими базами знаний, или служб поддержки, работающих с обширной документацией. Интерфейс чата менее отполирован, чем у Open WebUI, но если запрос к большим коллекциям документов — ваша основная потребность, продвинутые возможности извлечения оправдывают более крутую кривую обучения.

LobeChat делает упор на пользовательский опыт, а не на глубину функций, предлагая элегантный, мобильно-ориентированный интерфейс с возможностями прогрессивного веб-приложения. Его современный дизайн, плавные анимации и сильная поддержка голоса/мультимодальности делают его популярным среди дизайнеров и нетехнических пользователей, которые хотят AI-ассистента, работающего плавно на разных устройствах. Реализация PWA обеспечивает мобильный опыт, подобный приложению, которого не хватает Open WebUI. Однако корпоративные функции ограничены, экосистема плагинов меньше, а возможности RAG отстают как от Open WebUI, так и от AnythingLLM.

Для пользователей, предпочитающих настольные приложения, Jan.ai предоставляет кроссплатформенные установщики (Windows, macOS, Linux) с нулевой конфигурацией локального управления моделями. Нет необходимости устанавливать Ollama отдельно или иметь дело с Docker — Jan объединяет все в нативное приложение с поддержкой системного трея и однокликовым загрузкой моделей. Эта философия “просто работает” делает Jan идеальным для предоставления локальных LLMs членам семьи или коллегам, которые не комфортно чувствуют себя с инструментами командной строки. Компромиссы — отсутствие поддержки нескольких пользователей, меньшее количество продвинутых функций и отсутствие возможности удаленного доступа.

Chatbox занимает нишу легковесных решений — минимальный кроссплатформенный клиент, поддерживающий OpenAI, Claude, Gemini и локальные API с очень низкими затратами ресурсов. Он идеален для разработчиков, которым нужно быстро протестировать разные поставщики API, или пользователей с ограниченными аппаратными ресурсами. Усилие по настройке минимально, но некоторые функции доступны по подписке, он не полностью открыт и поддержка RAG ограничена.

Несколько специфичных для Ollama минимальных интерфейсов существуют для пользователей, которые хотят “достаточно” интерфейса: Hollama управляет несколькими серверами Ollama на разных машинах, Ollama UI предоставляет базовый чат и загрузку PDF с чрезвычайно простой развертыванием, а Oterm предлагает удивительно мощный терминальный интерфейс для сессий SSH и рабочих процессов tmux. Эти решения жертвуют функциями ради простоты и скорости.

Для организаций, требующих поддержки поставщика, коммерческие варианты вроде TypingMind Team, BionicGPT и Dust.tt предлагают самодостаточное развертывание с профессиональной поддержкой, сертификатами соответствия и SLA. Они жертвуют свободой открытого исходного кода ради гарантированной доступности, аудитов безопасности и ответственности — подходящие, когда вашей организации нужны корпоративные контракты на поддержку.

Выбор мудро: Open WebUI попадает в золотую середину для большинства самодостаточных развертываний Ollama, балансируя всесторонними функциями с управляемой сложностью. Выбирайте LibreChat, когда гибкость поставщиков имеет первостепенное значение, AnythingLLM для сложных рабочих процессов с документами, LobeChat для мобильно-ориентированных или дизайн-ориентированных пользователей, Jan для нетехнических пользователей настольных ПК или коммерческие варианты, когда вам нужна поддержка поставщика. Для большинства технических пользователей, работающих с локальными моделями, активное развитие, сильное сообщество и отличная реализация RAG делают Open WebUI рекомендуемой отправной точкой.

Будущие разработки и дорожная карта

Open WebUI продолжает быстрое развитие с несколькими захватывающими функциями в дорожной карте:

Улучшенная мультимодальная поддержка: Лучшая обработка изображений, моделей зрения и мультимодальных разговоров с моделями вроде LLaVA и Bakllava.

Улучшенные возможности агентов: Вызов функций, использование инструментов и рабочие процессы многократного рассуждения, подобные паттернам AutoGPT.

Лучшие мобильные приложения: Нативные приложения для iOS и Android за пределами текущей реализации PWA для улучшенного мобильного опыта.

Продвинутые функции RAG: Графовая RAG, семантическое разбиение, многократное извлечение запросов и извлечение родительских документов для лучшего контекста.

Коллаборативные функции: Общие разговоры, командные рабочие пространства и совместная работа над запросами и документами в реальном времени.

Корпоративные интеграции: Глубокая поддержка SSO, предоставление SCIM, продвинутые аудиторские журналы и отчеты о соответствии требованиям для регулируемых отраслей.

Проект поддерживает обратную совместимость и семантическое версионирование, что делает обновления простыми. Активный репозиторий GitHub получает ежедневные коммиты и оперативное управление проблемами.

Заключение

Open WebUI эволюционировал из простого фронтенда для Ollama в комплексную платформу для взаимодействия с искусственным интеллектом на самоуправляемых серверах. Сочетание конфиденциальности, функциональности и простоты развертывания делает его отличным выбором для отдельных пользователей, команд и организаций, желающих использовать локальные языковые модели без потери возможностей.

Будь вы разработчиком, тестирующим модели, организацией, создающей внутренние инструменты ИИ, или отдельным пользователем, приоритизирующим конфиденциальность, Open WebUI предоставляет основу для мощных самоуправляемых рабочих процессов ИИ. Активное сообщество, регулярные обновления и расширяемая архитектура гарантируют, что он останется ведущим решением в сфере самоуправляемых ИИ.

Начните с базовой установки Docker, экспериментируйте с RAG, загружая несколько документов, попробуйте разные модели из библиотеки Ollama и постепенно исследуйте продвинутые функции по мере роста ваших потребностей. Кривая обучения мягкая, но потолок высокий — Open WebUI масштабируется от персонального ноутбука до корпоративного кластера Kubernetes.

Для тех, кто сравнивает альтернативы, дизайн Open WebUI с приоритетом для Ollama, сбалансированный набор функций и активное развитие делают его рекомендуемой отправной точкой для большинства самоуправляемых развертываний языковых моделей. Вы всегда можете мигрировать на более специализированные решения, если возникнут специфические потребности, но многие пользователи находят возможности Open WebUI достаточными для всего пути от экспериментов до продакшена.

Чтобы узнать, как типичные бэкенды Open WebUI (Ollama, vLLM и др.) сочетаются с Docker Model Runner, LocalAI и облачными провайдерами, ознакомьтесь с нашим руководством LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Полезные ссылки

При настройке вашей среды Open WebUI вы получите пользу от понимания более широкой экосистемы локального хостинга и развертывания языковых моделей. Всеобъемлющее руководство Local LLM Hosting: Complete 2025 Guide - Ollama, vLLM, LocalAI, Jan, LM Studio & More сравнивает 12+ локальных инструментов LLM, включая Ollama, vLLM, LocalAI и другие, помогая вам выбрать оптимальный бэкенд для вашего развертывания Open WebUI на основе зрелости API, возможностей вызова инструментов и бенчмарков производительности.

Для высокопроизводительных продакшен-развертываний, где пропускная способность и задержка критичны, исследуйте руководство vLLM Quickstart: High-Performance LLM Serving, которое охватывает настройку vLLM с Docker, совместимость с OpenAI API и оптимизацию PagedAttention. Это особенно ценно, если Open WebUI обслуживает нескольких одновременных пользователей и производительность Ollama становится узким местом.

Понимание того, как ваш бэкенд обрабатывает одновременные запросы, критически важно для планирования мощности. Статья How Ollama Handles Parallel Requests объясняет очередь запросов Ollama, управление памятью GPU и модель одновременного выполнения, помогая вам настроить соответствующие ограничения и ожидания для сценариев многопользовательского использования вашего развертывания Open WebUI.

Внешние ресурсы

Для официальной документации и поддержки сообщества обратитесь к этим внешним ресурсам: