Open WebUI: Selbstgehostete LLM-Schnittstelle

Selbstgehostete ChatGPT-Alternative für lokale LLMs

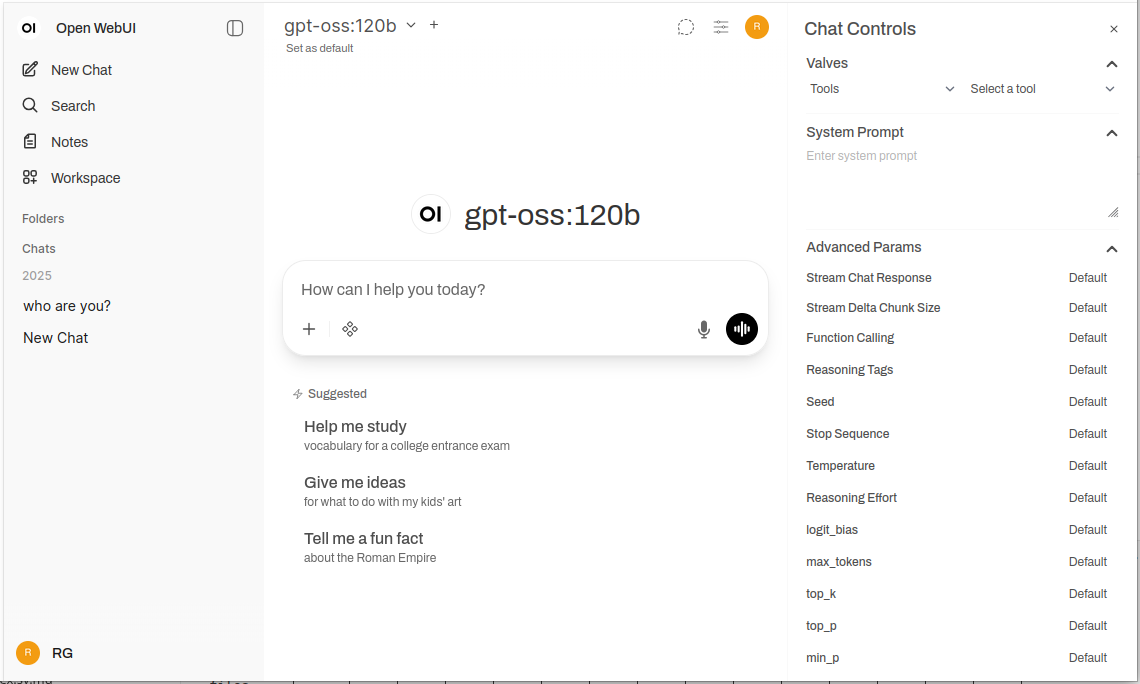

Open WebUI ist eine leistungsstarke, erweiterbare und umfangreiche selbstgehostete Web-Schnittstelle zur Interaktion mit großen Sprachmodellen.

Es unterstützt Ollama und jede OpenAI-kompatible API, wodurch die vertraute ChatGPT-Erfahrung in Ihre Infrastruktur gebracht wird, mit voller Privatsphäre, Offline-Fähigkeit und Enterprise-Features. Für eine umfassende Vergleichsanalyse lokaler und cloudbasierter LLM-Backends – Ollama, vLLM, Docker Model Runner, LocalAI und Cloud-Anbieter – siehe LLM Hosting: Lokal, Selbstgehostet & Cloud-Infrastruktur Vergleich.

Was ist Open WebUI?

Open WebUI ist eine Open-Source, selbstgehostete Webanwendung, die eine moderne Chat-Schnittstelle für die Interaktion mit großen Sprachmodellen bereitstellt. Im Gegensatz zu cloudbasierten KI-Diensten läuft Open WebUI vollständig auf Ihrer Infrastruktur und gibt Ihnen die volle Kontrolle über Ihre Daten, Gespräche und Modellauswahl.

Obwohl Open WebUI häufig mit Ollama verwendet wird (und manchmal informell als “Ollama WebUI” bezeichnet wird), ist es tatsächlich eine plattformunabhängige Plattform. Es kann über die Ollama-API für lokale Modellausführung verbunden werden, unterstützt aber auch jede OpenAI-kompatible Endpunkt – einschließlich vLLM, LocalAI, LM Studio, Text Generation WebUI und sogar Cloud-Anbieter. Diese Flexibilität macht Open WebUI zu einer umfassenden Lösung, die mehrere Backends unterstützt, RAG (Retrieval-Augmented Generation) für Dokumente, mehrere Benutzer-Authentifizierung, Sprachfunktionen und umfangreiche Anpassungsoptionen bietet. Ob Sie Modelle auf einem Laptop, einem Heimserver oder einem Kubernetes-Cluster ausführen, Open WebUI passt sich Ihren Anforderungen an.

Warum Open WebUI wählen?

Datenschutz first: Alle Daten bleiben auf Ihrer Infrastruktur – keine Gespräche, Dokumente oder Prompts verlassen Ihr Netzwerk, es sei denn, Sie konfigurieren explizit externe APIs.

Offline-fähig: Perfekt für abgeschlossene Umgebungen, eingeschränkte Netzwerke oder Situationen, in denen der Internetzugang unzuverlässig oder verboten ist. Wenn Sie lokal laufende Modelle über Ollama oder vLLM verwenden, erreichen Sie vollständige Unabhängigkeit von Cloud-Diensten.

Funktionenreich: Obwohl selbstgehostet, kann Open WebUI kommerzielle Angebote mit Dokumentupload und RAG, Gesprächsgeschichte mit semantischem Suchen, Promptvorlagen und -freigabe, Modellverwaltung, Spracheingabe/Ausgabe, mobile responsive Design und dunkle/helle Themen wettbewerbsfähig sein.

Multi-Benutzer-Unterstützung: Integriertes Authentifizierungssystem mit rollebasiertem Zugriffssteuerung (Admin, Benutzer, wartend), Benutzerverwaltungs-Dashboard, Gesprächs-Isolierung und geteilte Prompts und Modelle über Teams.

Schnelle Installation

Der schnellste Weg, mit Open WebUI zu beginnen, ist die Verwendung von Docker. Dieser Abschnitt behandelt die häufigsten Bereitstellungsszenarien.

Grundlegende Installation (Verbindung zu bestehendem Ollama)

Wenn Sie Ollama bereits auf Ihrem System laufen haben, verwenden Sie diesen Befehl:

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Dies führt Open WebUI auf Port 3000 aus, wobei Daten in einem Docker-Volume persistent gespeichert werden. Zugriff unter http://localhost:3000.

Paketinstallation (Open WebUI + Ollama)

Für eine vollständige all-in-one-Setup mit Ollama enthalten:

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

Der --gpus all-Flag aktiviert GPU-Zugriff für schnellere Inferenz. Omitieren Sie es, wenn Sie nur CPU ausführen.

Docker Compose Setup

Für Produktionsbereitstellungen bietet Docker Compose bessere Wartbarkeit:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

Bereitstellen mit docker-compose up -d.

Kubernetes-Bereitstellung

Für Enterprise-Bereitstellungen bietet Open WebUI Helm-Charts:

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

Dies erstellt eine produktionsreife Bereitstellung mit persistenter Speicherung, Gesundheitschecks und optionaler Ingress-Konfiguration.

Tiefergang in die Kernfunktionen

RAG und Dokumentchats

Die RAG-Implementierung von Open WebUI ermöglicht es Ihnen, Dokumente hochzuladen und den Modell auf sie in Gesprächen zu verweisen. Das System teilt automatisch Dokumente, generiert Embeddings, speichert sie in einer Vektordatenbank und ruft relevanten Kontext ab, wenn Sie Fragen stellen.

Unterstützte Formate: PDF, DOCX, TXT, Markdown, CSV und mehr durch eingebaute Parser.

Verwendung: Klicken Sie auf den ‘+’-Button in einem Chat, wählen Sie ‘Dateien hochladen’, wählen Sie Ihre Dokumente aus und beginnen Sie, Fragen zu stellen. Das Modell zitiert relevante Abschnitte und Seitennummern in seinen Antworten.

Konfiguration: Sie können den Chunk-Größe, Überlappung, Embedding-Modell und Retrieval-Parameter in den Admin-Einstellungen anpassen, um die Leistung mit Ihren Dokumenttypen zu optimieren.

Mehr-Benutzer-Authentifizierung und -Verwaltung

Open WebUI enthält ein vollständiges Authentifizierungssystem, das für Team- und Organisationsverwendung geeignet ist:

- Lokale Authentifizierung: Benutzername/Passwort mit sicheren Passwort-Hashing

- OAuth/OIDC-Integration: Verbinden Sie sich mit bestehenden Identitätsanbietern (Google, GitHub, Keycloak usw.)

- LDAP/Active Directory: Enterprise-Verzeichnisintegration

- Rollebasiert Zugriff: Admin (vollständige Kontrolle), Benutzer (Standardzugriff), Wartend (erfordert Genehmigung)

Admins können Benutzer verwalten, Nutzung überwachen, Modellezugriff pro Benutzer/Gruppe konfigurieren und Konversations-Retentionsrichtlinien festlegen.

Spracheingabe und -ausgabe

Ein integrierter Support für Sprachinteraktion macht Open WebUI zugänglich und bequem:

- Sprach-zu-Text: Nutzt Web Speech API oder konfigurierte externe STT-Dienste

- Text-zu-Sprache: Mehrere TTS-Engines unterstützt (Browser-basiert, Coqui TTS, ElevenLabs usw.)

- Sprachunterstützung: Funktioniert mit mehreren Sprachen abhängig von Ihrer TTS/STT-Konfiguration

Prompt-Engineering-Tools

Open WebUI bietet robuste Tools für Prompt-Verwaltung:

- Prompt-Bibliothek: Speichern Sie häufig verwendete Prompts als Vorlagen

- Variablen und Platzhalter: Erstellen Sie wiederverwendbare Prompts mit dynamischen Inhalten

- Prompt-Freigabe: Teilen Sie effektive Prompts mit Ihrem Team

- Prompt-Versionsverwaltung: Verfolgen Sie Änderungen und Verbesserungen im Laufe der Zeit

Modellverwaltung

Einfache Modellwechsel und -verwaltung über die UI:

- Modellkatalog: Durchsuchen und laden Sie Modelle direkt aus der Ollama-Bibliothek

- Benutzerdefinierte Modelle: Hochladen und konfigurieren Sie benutzerdefinierte GGUF-Modelle

- Modellparameter: Anpassen Sie Temperatur, top-p, Kontextlänge und andere Sampling-Parameter pro Gespräch

- Modellmetadaten: Anzeigen Sie Modelldetails, Größe, Quantisierung und Fähigkeiten

Konfiguration und Anpassung

Umgebungsvariablen

Wichtige Konfigurationsoptionen über Umgebungsvariablen:

# Backend-URL (Ollama oder andere OpenAI-kompatible API)

OLLAMA_BASE_URL=http://localhost:11434

# Authentifizierung aktivieren

WEBUI_AUTH=true

# Standard-Benutzerrolle (user, admin, pending)

DEFAULT_USER_ROLE=pending

# Benutzerregistrierung aktivieren

ENABLE_SIGNUP=true

# Admin-E-Mail (erstellt automatisch einen Admin-Account)

WEBUI_ADMIN_EMAIL=admin@example.com

# Datenbank (Standard SQLite, oder PostgreSQL für Produktion)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# RAG aktivieren

ENABLE_RAG=true

# Embedding-Modell für RAG

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

Verbindung zu alternativen Backends

Open WebUI funktioniert mit jeder OpenAI-kompatiblen API. Konfigurieren Sie die Basis-URL in Einstellungen → Verbindungen:

- vLLM:

http://localhost:8000/v1 - LocalAI:

http://localhost:8080 - LM Studio:

http://localhost:1234/v1 - Text Generation WebUI:

http://localhost:5000/v1 - OpenAI:

https://api.openai.com/v1(erfordert API-Schlüssel) - Azure OpenAI: Benutzerdefinierte Endpunkt-URL

Reverse Proxy-Konfiguration

Für Produktionsbereitstellungen, führen Sie Open WebUI hinter einem Reverse Proxy aus:

Nginx-Beispiel:

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# WebSocket-Unterstützung

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Traefik-Beispiel (Docker-Labels):

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

Leistungsoptimierung

Datenbank-Tuning

Für Multi-Benutzer-Bereitstellungen wechseln Sie von SQLite zu PostgreSQL:

# Abhängigkeiten installieren

pip install psycopg2-binary

# Datenbank-URL konfigurieren

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

PostgreSQL verarbeitet mehrere Benutzer besser und bietet verbesserte Abfragespeed für Suchvorgänge in Gesprächen und RAG-Operationen.

Embedding-Modell-Auswahl

Die RAG-Performance hängt stark von der Wahl Ihres Embedding-Modells ab:

- Schnell/Resource-gekapselt:

all-MiniLM-L6-v2(384 Dimensionen, ~80MB) - Ausgewogen:

all-mpnet-base-v2(768 Dimensionen, ~420MB) - Beste Qualität:

bge-large-en-v1.5(1024 Dimensionen, ~1,3GB)

Konfigurieren Sie dies in Einstellungen → RAG → Embedding-Modell.

Caching-Strategien

Aktivieren Sie Konversations-Caching, um wiederholte API-Aufrufe zu reduzieren:

- Modell-Caching: Ollama cacheiert geladene Modelle automatisch im Speicher

- Antwort-Caching: Open WebUI kann identische Prompts cacheieren (konfigurierbar)

- Embedding-Cache: Wiederverwenden Sie Embeddings für bereits verarbeitete Dokumente

Sicherheitsbest Practices

Wenn Sie Open WebUI in der Produktion bereitstellen, folgen Sie diesen Sicherheitsrichtlinien:

- Authentifizierung aktivieren: Führen Sie Open WebUI niemals ohne Authentifizierung auf öffentlichen Netzwerken aus

- HTTPS verwenden: Stellen Sie immer hinter einem Reverse Proxy mit TLS/SSL bereit

- Regelmäßige Updates: Halten Sie Open WebUI und Ollama aktuell für Sicherheitspatches

- Zugriff einschränken: Verwenden Sie Firewall-Regeln, um den Zugriff auf vertrauenswürdige Netzwerke zu beschränken

- API-Schlüssel sichern: Wenn Sie externe APIs verbinden, verwenden Sie Umgebungsvariablen, codieren Sie Schlüssel nie hart

- Audit-Logs aktivieren: Aktivieren und überwachen Sie Zugriffsprotokolle für verdächtige Aktivitäten

- Daten sichern: Backup des

/app/backend/data-Volumens regelmäßig - Datenbankverschlüsselung: Aktivieren Sie Verschlüsselung bei Ruhestand für PostgreSQL in der Produktion

- Rate Limiting: Konfigurieren Sie Rate Limits, um Missbrauch zu verhindern

- Inhaltsschutz: Implementieren Sie Inhaltsrichtlinien, die für Ihre Organisation geeignet sind

Use Cases und reale Anwendungen

Persönlicher Wissensassistent

Kombinieren Sie Open WebUI mit lokalen Modellen und RAG, um einen privaten Wissensspeicher zu erstellen. Laden Sie Ihre Notizen, Forschungspapiere, Projekt-Dokumentation und persönliche Dokumente hoch. Fragen Sie sie ohne Daten an Cloud-Dienste zu senden – perfekt für Forscher, Studenten und Wissensarbeiter, die Privatsphäre schätzen.

Entwicklungsteam-Kollaboration

Stellen Sie Open WebUI für Ihr Entwicklungsteam bereit mit gemeinsamem Zugriff auf technische Dokumentation, API-Spezifikationen und Codebasis-Wissen. Die RAG-Funktion ermöglicht es Entwicklern, relevante Informationen schnell in tausenden Seiten Dokumentation zu finden, während die Gesprächsgeschichte hilft, Architekturentscheidungen und technische Diskussionen zu verfolgen.

Unternehmensinterner Chatbot

Unternehmen können Open WebUI hinter ihre Firewall stellen mit SSO-Integration, um Mitarbeitern einen KI-Assistenten bereitzustellen, der Zugriff auf interne Wikis, Richtlinien und Verfahren hat. Rollebasierte Zugriffsschutz stellt sicher, dass sensible Informationen ordnungsgemäß segmentiert bleiben, während Admin-Kontrollen Governance und Compliance gewährleisten.

Bildung und Schulung

Bildungseinrichtungen verwenden Open WebUI, um Studenten und Dozenten mit KI-Hilfe ohne Privatsphärebedenken zu versorgen. Laden Sie Kursmaterialien, Lehrbücher und Vorlesungsnotizen hoch, um kontextuelle Fragen und Antworten zu erhalten. Das Multi-Benutzer-System ermöglicht die Verfolgung der Nutzung, während Studierendendaten privat bleiben.

Gesundheits- und Rechtsanwendungen

In regulierten Branchen, in denen Datensicherheit kritisch ist, ermöglicht Open WebUI KI-gestützte Workflows, während HIPAA oder GDPR-Konformität gewahrt bleibt. Mediziner können Arzneimittel-Datenbanken und Behandlungsprotokolle abfragen, während Rechtsabteilungen Fallrecht und Verträge durchsuchen – alles ohne Daten aus kontrollierten Infrastrukturen zu entfernen.

Air-Gapped und Offline-Umgebungen

Regierungsbehörden, Forschungseinrichtungen und sichere Betriebszentren verwenden Open WebUI in air-gapped Netzwerken. Die vollständige Offline-Fähigkeit stellt sicher, dass KI-Hilfe auch ohne Internetverbindung verfügbar bleibt, was für klassifizierte Umgebungen oder abgelegene Standorte kritisch ist.

Problemlösung bei häufigen Problemen

Verbindungsprobleme

Problem: Open WebUI kann sich nicht mit Ollama verbinden

Lösung: Überprüfen Sie, ob Ollama läuft (curl http://localhost:11434), prüfen Sie die Umgebungsvariable OLLAMA_BASE_URL und stellen Sie sicher, dass Firewall-Regeln die Verbindung ermöglichen. Bei Docker-Bereitstellungen verwenden Sie Dienstnamen (http://ollama:11434) anstelle von localhost.

Problem: Modelle erscheinen nicht in der UI

Lösung: Bestätigen Sie, dass Modelle installiert sind (ollama list), aktualisieren Sie die Modellliste in den Einstellungen von Open WebUI und prüfen Sie den Browser-Console auf API-Fehler.

RAG und Dokument hochladen Probleme

Problem: Dokument hochladen fehlschlägt

Lösung: Prüfen Sie die Dateigrößenbegrenzungen in den Einstellungen, überprüfen Sie das unterstützte Dateiformat, stellen Sie sicher, dass genügend Speicherplatz im Daten-Volumen vorhanden ist, und prüfen Sie die Container-Protokolle auf Parsing-Fehler.

Problem: RAG-Antworten verweisen nicht auf hochgeladene Dokumente

Lösung: Bestätigen Sie, dass das Embedding-Modell heruntergeladen und läuft, prüfen Sie die Chunk-Größe-Einstellungen (probieren Sie kleinere Chunks für bessere Granularität), erhöhen Sie die Anzahl der abgerufenen Chunks in den RAG-Einstellungen und stellen Sie sicher, dass die Abfrage relevant für den Dokumentinhalt ist.

Leistungsprobleme

Problem: Langsame Antwortzeiten

Lösung: Aktivieren Sie GPU-Unterstützung, wenn verfügbar, reduzieren Sie Modellgröße oder verwenden Sie quantisierte Versionen, erhöhen Sie OLLAMA_NUM_PARALLEL für parallele Anfragen und weisen Sie mehr RAM Docker-Containern zu.

Problem: Ausreichend RAM-Fehler

Lösung: Verwenden Sie kleinere Modelle (7B anstelle von 13B Parameter), reduzieren Sie die Kontextlänge in Modellparametern, begrenzen Sie parallele Benutzer oder fügen Sie mehr RAM/Swap-Raum zu Ihrem System hinzu.

Authentifizierung und Zugriff

Problem: Kein Login oder Admin-Konto erstellen

Lösung: Setzen Sie WEBUI_AUTH=true, konfigurieren Sie WEBUI_ADMIN_EMAIL, um ein Admin-Konto automatisch zu erstellen, leeren Sie Browser-Cookies und -Cache und prüfen Sie Container-Protokolle auf Datenbankfehler.

Problem: Benutzer können sich nicht registrieren

Lösung: Überprüfen Sie ENABLE_SIGNUP=true, prüfen Sie die DEFAULT_USER_ROLE-Einstellung (verwenden Sie user für automatische Genehmigung oder pending für manuelle Genehmigung) und stellen Sie sicher, dass die Datenbank schreibbar ist.

Alternativen zu Open WebUI

Obwohl Open WebUI hervorragend ist, um eine selbstgehostete Schnittstelle mit starker Ollama-Integration zu bieten, gibt es mehrere Alternativen, die unterschiedliche Ansätze für denselben Problembereich bieten. Ihre Wahl hängt davon ab, ob Sie Multi-Anbieter-Flexibilität, spezialisierte Dokumentverarbeitung, extreme Einfachheit oder Enterprise-Funktionen benötigen.

LibreChat ist die am meisten anbieterunabhängige Lösung, die native Unterstützung für OpenAI, Anthropic, Azure OpenAI, Google Vertex AI, AWS Bedrock und Ollama in einer einzigen Schnittstelle bietet. Sein Plugin-Architektur und Enterprise-Funktionen wie Multi-Tenancy, detaillierte Zugriffssteuerungen und Nutzungskontingente machen es ideal für Organisationen, die mehrere KI-Anbieter unterstützen oder umfassende Audit-Protokolle benötigen. Der Kompromiss ist Komplexität – LibreChat erfordert mehr Setup-Aufwand und schwerere Ressourcen als Open WebUI, und seine Ollama-Unterstützung fühlt sich sekundär zu Cloud-Anbietern an. Wenn Ihr Team Claude für Schreiben, GPT-4 für Codierung und lokale Modelle für datenschutzempfindliche Arbeit verwendet, strahlt LibreChats einheitliche Schnittstelle.

Für Dokumentintensive Workflows bietet AnythingLLM einen Wissensbasis-first-Ansatz, der über grundlegende RAG hinausgeht. Sein Workspace-Modell organisiert Dokumente und Gespräche in isolierten Umgebungen, während erweiterte Retrieval-Funktionen Hybrid-Suche, Re-Ranking und Zitierverfolgung umfassen. Datenverbindungen ziehen Inhalte von GitHub, Confluence und Google Drive, und Agentenfunktionen ermöglichen mehrschrittiges Denken und Workflow-Automatisierung. Dies macht AnythingLLM ideal für Beratungsgesellschaften, die mehrere Klientenwissensbasen verwalten, oder Support-Teams, die mit umfangreichen Dokumentationen arbeiten. Die Chat-Schnittstelle ist weniger poliert als Open WebUI, aber wenn die Abfrage von großen Dokumentkollektionen Ihre primäre Anforderung ist, rechtfertigen die fortgeschrittenen Retrieval-Funktionen den steileren Lernkurve.

LobeChat priorisiert Benutzererfahrung über Funktions Tiefe, bietet eine schlank, mobilefreundliche Schnittstelle mit Progressive Web App-Fähigkeiten. Sein modernes Design, glatte Animationen und starke Sprach-/Multimodale Unterstützung machen es beliebt bei Designern und Nicht-technischen Nutzern, die einen KI-Assistenten benötigen, der nahtlos über Geräte hinweg funktioniert. Die PWA-Implementierung bietet eine App-ähnliche mobile Erfahrung, die Open WebUI nicht übertreffen kann. Allerdings sind Enterprise-Funktionen begrenzt, das Plugin-Ökosystem ist kleiner und RAG-Fähigkeiten sind hinter Open WebUI und AnythingLLM zurück.

Für Nutzer, die Desktop-Anwendungen bevorzugen, bietet Jan.ai plattformübergreifende Installer (Windows, macOS, Linux) mit Null-Konfiguration für lokale Modell-Verwaltung. Es ist keine separate Installation von Ollama oder Umgang mit Docker erforderlich – Jan verpackt alles in eine native Anwendung mit System Tray-Unterstützung und One-Click-Modell-Downloads. Dieses “es funktioniert einfach” Philosophie macht Jan ideal für die Bereitstellung lokaler LLMs für Familienmitglieder oder Kollegen, die sich nicht mit Befehlszeilentools beschäftigen möchten. Die Kompromisse sind keine Multi-Benutzer-Unterstützung, weniger erweiterte Funktionen und keine Fernzugriffsfähigkeit.

Chatbox belegt den leichten Nischenbereich – eine minimale plattformübergreifende Client-App, die OpenAI, Claude, Gemini und lokale APIs mit sehr geringem Ressourcenverbrauch unterstützt. Sie ist perfekt für Entwickler, die verschiedene API-Anbieter schnell testen möchten, oder Nutzer mit ressourcenbeschränkter Hardware. Die Setup-Reibung ist minimal, aber einige Funktionen sind abonnement-geschützt, es ist nicht vollständig Open Source und RAG-Unterstützung ist begrenzt.

Viele Ollama-spezifische minimale UIs existieren für Nutzer, die “nur genug” Interface benötigen: Hollama verwaltet mehrere Ollama-Server über verschiedene Maschinen, Ollama UI bietet grundlegende Chat- und PDF-Upload-Funktionen mit extrem einfacher Bereitstellung, und Oterm bietet eine überraschend leistungsfähige Terminal-basierte Schnittstelle für SSH-Sessions und tmux-Workflows. Diese opfern Funktionen für Einfachheit und Geschwindigkeit.

Für Organisationen, die Vendor-Support benötigen, bieten kommerzielle Optionen wie TypingMind Team, BionicGPT und Dust.tt Selbsthosting mit professioneller Unterstützung, Compliance-Zertifizierungen und SLAs. Sie tauschen Open-Source-Freiheit gegen garantierte Uptime, Sicherheitsaudits und Verantwortung – angemessen, wenn Ihre Organisation Enterprise-grade Supportverträge benötigt.

Weise Auswahl: Open WebUI trifft den Sweet Spot für die meisten selbstgehosteten Ollama-Bereitstellungen, balanciert umfassende Funktionen mit verwaltbaren Komplexität. Wählen Sie LibreChat, wenn Anbieterflexibilität von entscheidender Bedeutung ist, AnythingLLM für fortgeschrittene Dokumentworkflows, LobeChat für mobile-first oder designbewusste Nutzer, Jan für nicht-technische Desktopnutzer oder kommerzielle Optionen, wenn Sie Vendor-Unterstützung benötigen. Für die Mehrheit der technischen Nutzer, die lokale Modelle ausführen, macht Open WebUIs aktive Entwicklung, starke Community und hervorragende RAG-Implementierung es zur empfohlenen Ausgangspunkt.

Zukunftsentwicklungen und Roadmap

Open WebUI entwickelt sich weiterhin schnell mit mehreren aufregenden Funktionen auf der Roadmap:

Verbesserte Multimodal-Unterstützung: Bessere Verarbeitung von Bildern, visuellen Modellen und multimodalen Gesprächen mit Modellen wie LLaVA und Bakllava.

Erweiterte Agentenfunktionen: Funktionsaufruf, Werkzeugnutzung und mehrschrittige Reasoning-Workflows, ähnlich wie bei AutoGPT.

Bessere Mobile Apps: Native iOS- und Android-Anwendungen jenseits der aktuellen PWA-Implementierung für verbesserte Mobile-Erfahrung.

Erweiterte RAG-Funktionen: Graph-basiertes RAG, semantisches Chunking, Multi-Query-Retrieval und Parent-Dokument-Retrieval für besseren Kontext.

Kollaborationsfunktionen: Geteilte Gespräche, Team-Arbeitsbereiche und Echtzeit-Kollaboration bei Prompts und Dokumenten.

Enterprise-Integrationen: Tieferer SSO-Unterstützung, SCIM-Provisionierung, erweiterte Audit-Protokolle und Compliance-Berichte für regulierte Branchen.

Das Projekt behält die rückwärtskompatibilität und semantische Versionierung bei, was Upgrades einfach macht. Das aktive GitHub-Repository sieht tägliche Commits und reaktive Issue-Management.

Schlussfolgerung

Open WebUI hat sich von einer einfachen Ollama-Frontend in eine umfassende Plattform für selbstgehostete KI-Interaktionen entwickelt. Seine Kombination aus Privatsphäre, Funktionen und Einfachheit der Bereitstellung macht es zu einer hervorragenden Wahl für Einzelpersonen, Teams und Organisationen, die lokale LLMs nutzen möchten, ohne Fähigkeiten einzubüßen.

Ob Sie ein Entwickler sind, der Modelle testet, eine Organisation, die interne KI-Tools baut, oder eine Person, die Privatsphäre priorisiert, bietet Open WebUI die Grundlage für leistungsstarke, selbstgehostete KI-Workflows. Die aktive Community, regelmäßige Updates und erweiterbare Architektur sorgen dafür, dass es in der selbstgehosteten KI-Szene weiterhin eine führende Option bleibt.

Beginnen Sie mit der grundlegenden Docker-Installation, experimentieren Sie mit RAG, indem Sie einige Dokumente hochladen, probieren Sie verschiedene Modelle aus der Ollama-Bibliothek aus und erkunden Sie schrittweise erweiterte Funktionen, während Ihre Anforderungen wachsen. Die Lernkurve ist sanft, aber das Deckel ist hoch – Open WebUI skaliert von einem persönlichen Laptop bis zu einem Enterprise-Kubernetes-Cluster.

Für diejenigen, die Alternativen vergleichen, macht Open WebUIs Ollama-first-Design, ausgewogene Funktionspalette und aktive Entwicklung es zur empfohlenen Ausgangspunkt für die meisten selbstgehosteten LLM-Bereitstellungen. Sie können sich immer auf spezialisierte Lösungen migrieren, wenn sich spezifische Anforderungen ergeben, aber viele Nutzer finden, dass Open WebUIs Fähigkeiten für ihre gesamte Reise von Experimentation bis zur Produktion ausreichen.

Um zu sehen, wie Open WebUIs typische Backends (Ollama, vLLM usw.) mit Docker Model Runner, LocalAI und Cloud-Anbietern zusammenpassen, prüfen Sie unseren [LLM Hosting: Lokal, Selbstgehostet & Cloud-Infrastruktur Vergleich](https://www.glukhov.org/de/llm-hosting/ “Komplettleitfaden zu LLM-Hosting im Jahr 2026. Vergleichen Sie Ollama, vLL段.

Nützliche Links

Wenn Sie Ihre Open WebUI-Umgebung einrichten, werden Sie von einem Verständnis der breiteren Ökosystem von lokalen LLM-Hosting- und -Bereitstellungsoptionen profitieren. Der umfassende Leitfaden Lokales LLM-Hosting: Vollständiger 2025-Leitfaden – Ollama, vLLM, LocalAI, Jan, LM Studio & mehr vergleicht 12+ lokale LLM-Tools, einschließlich Ollama, vLLM, LocalAI und andere, um Ihnen zu helfen, die optimale Backend-Option für Ihre Open WebUI-Bereitstellung basierend auf API-Reife, Tool-Calling-Fähigkeiten und Leistungsbenchmarks zu wählen.

Für Hochleistungsproduktionsbereitstellungen, bei denen Durchsatz und Latenz kritisch sind, erkunden Sie den vLLM Quickstart: Hochleistungs-LLM-Service-Leitfaden, der vLLM-Setup mit Docker, OpenAI-API-Kompatibilität und PagedAttention-Optimierung behandelt. Dies ist besonders wertvoll, wenn Open WebUI mehrere parallele Benutzer bedient und Ollamas Leistung zu einem Engpass wird.

Das Verständnis, wie Ihr Backend parallele Anfragen verarbeitet, ist für Kapazitätsplanung entscheidend. Der Artikel Wie Ollama parallele Anfragen verarbeitet erklärt Ollamas Anfrage-Queuing, GPU-Speicherverwaltung und paralleles Ausführungsmodell, um Sie bei der Konfiguration geeigneter Grenzen und Erwartungen für Ihre Open WebUI-Bereitstellung in Multi-Benutzer-Szenarien zu unterstützen.

Externe Ressourcen

Für offizielle Dokumentation und Community-Unterstützung, beziehen Sie sich auf diese externen Ressourcen: