Jak zmienić statyczny adres IP w serwerze Ubuntu

Uwagi dotyczące konfiguracji statycznego adresu IP w Linuxie

Ten przewodnik pokaże Ci, jak zmienić stały adres IP na serwerze Ubuntu.

Uwagi dotyczące konfiguracji statycznego adresu IP w Linuxie

Ten przewodnik pokaże Ci, jak zmienić stały adres IP na serwerze Ubuntu.

Moje zdanie na temat obecnego stanu rozwoju Ollama

Ollama szybko stało się jednym z najpopularniejszych narzędzi do lokalnego uruchamiania modeli językowych. Jego prosty interfejs CLI oraz zoptymalizowany zarządzanie modelami sprawiły, że stał się pierwszym wyborem dla programistów, którzy chcą pracować z modelami AI poza chmurą. Ale tak jak w przypadku wielu obiecujących platform, już teraz pojawiają się pierwsze oznaki Enshittification:

Alternatywna platforma komunikacji głosowej nad IP

Mumble to darmowy i open-source aplikacja do wideo i głosu (VoIP), zaprojektowana głównie do czasu rzeczywistego komunikowania się głosem. Wykorzystuje architekturę klient-serwer, gdzie użytkownicy łączą się z udostępnionym serwerem, aby rozmawiać ze sobą.

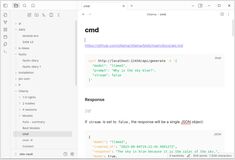

Szybki przegląd najbardziej znanych interfejsów użytkownika dla Ollama w 2025 roku

Lokalnie hostowany Ollama umożliwia uruchamianie dużych modeli językowych na własnym komputerze, ale korzystanie z niego przez wiersz poleceń nie jest przyjazne dla użytkownika. Oto kilka projektów open source, które oferują interfejsy stylu ChatGPT, łączące się z lokalnym Ollama.

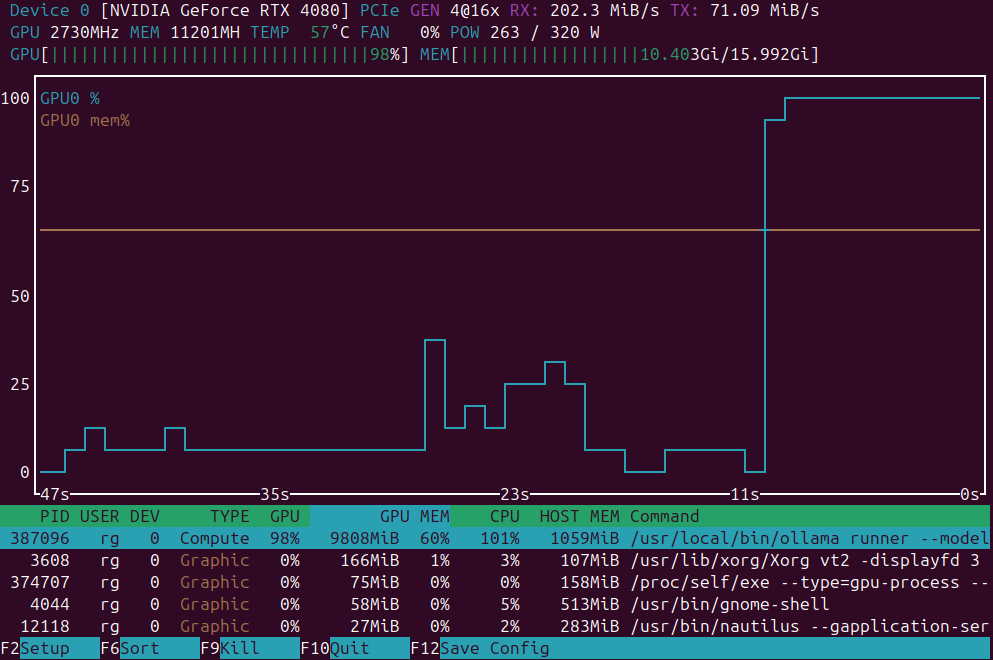

Krótki wykaz aplikacji do monitorowania obciążenia GPU

Monitorowanie obciążenia GPU: nvidia-smi vs nvtop vs nvitop vs KDE plasma systemmonitor.

Instalacja małego klastra Kubernetes z użyciem k3s na homelabie

Oto krok po kroku instrukcja instalacji

3-węzłowego klastra K3s

na serwerach nago metalowych (1 serwer główny + 2 serwery robocze).

Bardzo krótka charakterystyka wersji kubernetes

Porównanie dystrybucji self-hosting Kubernetes przeznaczonych do hostowania na serwerach nago-metalowych lub domowych, zwracając uwagę na łatwość instalacji, wydajność, wymagania systemowe oraz zestaw funkcji.

Wybór najlepszego wariantu Kubernetes dla naszej domowej laboratorium

Porównuję wersje samowystarczalnego Kubernetesa, które nadają się do homelaba opartego na Ubuntu z 3 węzłami (16 GB RAM, 4 rdzenie CPU każdy), skupiając się na łatwości instalacji i konserwacji, obsłudze persistent volumes i LoadBalancers.

Skrócona wersja tekstu: ``` Skrócona wersja tekstu: ``` Pełna wersja tekstu: ``` Skrócona wersja tekstu: ```

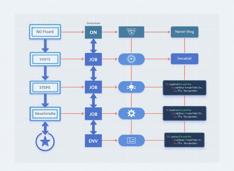

GitHub Actions to platform automatyzacji i CI/CD w GitHub, który służy do budowania, testowania i wdrażania kodu na podstawie zdarzeń takich jak pushy, żądania pull, czy harmonogramy.

W przypłyku, docker-compose różni się od docker compose...

Oto Docker Compose cheatshet z opisanymi przykładami, które pomogą Ci szybko opanować pliki i polecenia Compose.

O Obsidian ...

Oto szczegółowy opis

Obsidian jako potężne narzędzie do zarządzania wiedzą osobistą (PKM),

wyjaśniające jego architekturę, funkcje, zalety oraz to, jak wspiera współczesne przepływy wiedzy.

W lipcu 2025 r. niedługo powinno zostać dostępne

NVIDIA wkrótce wyda NVIDIA DGX Spark – mały superkomputer AI oparty na architekturze Blackwell z 128+GB jednolitej pamięci RAM i wydajnością 1 PFLOPS w zakresie AI. Świetny sprzęt do uruchamiania LLM.

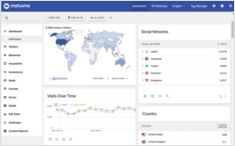

Których systemów analizy webowej warto użyć na swojej stronie internetowej?

Spójrzmy szybko na Matomo, Plausible, google i inne dostawcy i systemy analizy web dostępne do samowystawiania i porównajmy je.

Uwagi dotyczące standardowej sekwencji instalacji Ubuntu 24.04

Oto moje ulubione kroki podczas nowej instalacji Ubuntu 24.04. To, co lubię tutaj – nie muszę instalować sterowników NVidia! Są instalowane automatycznie.

Korzystałem z Dokuwiki jako osobowej bazą wiedzy

Dokuwiki to samowystarczalny wikipedia, który można łatwo hostować lokalnie, bez konieczności korzystania z baz danych.

Wcześniej uruchamiałem go w wersji dockerowej, na moim własnym klastrze Kubernetes.

Aktualizacja cen GPU odpowiednich do AI – RTX 5080 i RTX 5090

Porównajmy ceny najlepszych kart graficznych na poziomie konsumenckim, które są odpowiednie do LLM i ogólnie do AI.

Zobacz dokładnie na ceny RTX 5080 i RTX 5090. Slighty spadły.