Hardware

Samozhostowanie LLM i suwerenność AI

Kontroluj dane i modele za pomocą samodzielnie hostowanych LLMów

Samowystarczalność LLM (large language models) pozwala zachować kontrolę nad danymi, modelami i wnioskowaniem - praktyczna droga do samowystarczalności w zakresie AI dla zespołów, przedsiębiorstw i narodów.

Oto: co to jest samowystarczalność w zakresie AI, które aspekty i metody są wykorzystywane do jej budowania, jak samowystarczalne LLM wchodzą w grę, jak kraje radzą sobie z tym wyzwaniem.

Najlepsze modele LLM do Ollama na GPU z 16 GB VRAM

Test prędkości LLM na RTX 4080 z 16 GB VRAM

Uruchamianie dużych modeli językowych lokalnie zapewnia prywatność, możliwość pracy offline oraz zero kosztów API. Ten benchmark pokazuje dokładnie, co można oczekiwać od 9 popularnych LLM na Ollama na RTX 4080.

Wzrost cen GPU i RAM w Australii: RTX 5090 o 15%, RAM o 38% - styczeń 2026

Sprawdzenie cen GPU i RAM na styczniu 2025

Dziś zajmiemy się najwyższy poziom konsumentów GPU i modułami RAM. Konkretnie patrzę na ceny RTX-5080 i RTX-5090, oraz 32GB (2x16GB) DDR5 6000.

Najlepsze emulatorzy terminala w Linux: Porównanie 2026

Wybierz odpowiedni terminal dla swojego przepływu pracy w Linuxie

Jednym z najważniejszych narzędzi dla użytkowników systemu Linux to symulator terminala.

Ceny DGX Spark AU: 6 249–7 999 dolarów amerykańskich w głównych sklepach detalicznych

Rzeczywiste ceny w AUD od australijskich detaliów teraz

The NVIDIA DGX Spark (GB10 Grace Blackwell) jest teraz dostępny w Australii w głównych sklepach z komputerami z lokalnym zapasem. Jeśli śledziliście cenę i dostępność DGX Spark na całym świecie, to interesujące będzie dla Was, że w Australii ceny oscylują od 6 249 do 7 999 AUD w zależności od konfiguracji pamięci i sklepu.

Autonomiczne hostowanie Cognee: Testy wydajności modelu LLM

Testowanie Cognee z lokalnymi modelami LLM - rzeczywiste wyniki

Cognee to framework w języku Python do tworzenia grafów wiedzy z dokumentów za pomocą LLM. Ale działa on z modelami samowystawianymi?

Ubuntu stracił połączenie sieciowe po aktualizacji jądra

Jak naprawiłem problemy sieciowe w Ubuntu

Po automatycznym zainstalowaniu nowego jądra, Ubuntu 24.04 straciła połączenie sieciowe ethernet. To irytujące pytanie wystąpiło u mnie drugi raz, dlatego dokumentuję rozwiązanie, aby pomóc innym, którzy napotkali ten sam problem.

Cena RAM w Australii - grudzień 2025

Krótki wpis, tylko zaznaczam cenę

Z tą szalonym niestabilnością cen RAM, aby utworzyć lepszy obraz, najpierw sami śledź cenę RAM w Australii.

Wzrost cen RAM: aż 619% w 2025 roku

Ceny RAM wzrastają o 163–619%, ponieważ rosnąca popyt na AI naciska na podaż

Rynek pamięci doświadcza niezwykłej zmienności cen w późnym 2025 roku, z nadmierne wzrosty cen RAM obserwowane w całych segmentach.

Ceny kart NVidia RTX 5080 i RTX 5090 w Australii – listopad 2025

Ceny konsumentских GPU odpowiednich do AI - RTX 5080 i RTX 5090

Porównajmy ceny najnowszych kart graficznych dla użytkowników końcowych, które są szczególnie odpowiednie do LLM, a także ogólnie do AI. Konkretnie zajmuję się cenami RTX-5080 i RTX-5090.

Infrastruktura AI na sprzęcie konsumentowym

Wdrażaj sztuczną inteligencję na poziomie przedsiębiorstwa na sprzęcie o niskim koszcie za pomocą otwartych modeli

Demokratyzacja AI jest tu. Z powodu otwartych źródeł LLM takich jak Llama 3, Mixtral i Qwen, które teraz rywalizują z modelami prywatnymi, zespoły mogą tworzyć potężną infrastrukturę AI za pomocą sprzętu konsumenta - znacznie obniżając koszty, jednocześnie utrzymując pełną kontrolę nad prywatnością danych i wdrażaniem.

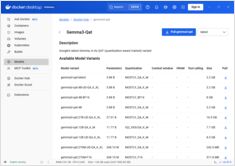

Dodanie obsługi GPU firmy NVIDIA do Docker Model Runner

Włącz przyspieszenie GPU dla Docker Model Runner z obsługą NVIDIA CUDA

Docker Model Runner to narzędzie oficjalne Dockera do uruchamiania modeli AI lokalnie, ale włączanie przyspieszenia GPU od firmy NVidia w Docker Model Runner wymaga konkretnej konfiguracji.

NVIDIA DGX Spark vs Mac Studio vs RTX-4080: Porównanie wydajności Ollama

Wyniki testów GPT-OSS 120b na trzech platformach AI

Docker Model Runner Cheatsheet: Polecenia i Przykłady

Szybki przewodnik po poleceniach Docker Model Runner

Docker Model Runner (DMR) to oficjalne rozwiązanie firmy Docker do uruchamiania modeli AI lokalnie, wprowadzone w kwietniu 2025 roku. Ten cheatsheet zawiera szybki przewodnik po wszystkich istotnych komendach, konfiguracjach i najlepszych praktykach.

GNOME Boxes: Kompletny przewodnik po funkcjach, zaletach, wyzwaniach i alternatywach

Prosta obsługa maszyn wirtualnych dla Linuxa z GNOME Boxes

W obecnej sytuacji informatycznej wirtualizacja stała się nieodzowna dla rozwoju, testowania i uruchamiania wielu systemów operacyjnych. Dla użytkowników systemu Linux poszukujących prostego i intuicyjnego sposobu zarządzania maszynami wirtualnymi, GNOME Boxes wyróżnia się jako lekki i przyjazny dla użytkownika wybór, który priorytetyzuje łatwość użycia bez poświęcania funkcjonalności.