Open WebUI: samowystarczalny interfejs LLM

Autonomiczna alternatywa do ChatGPT dla lokalnych modeli językowych

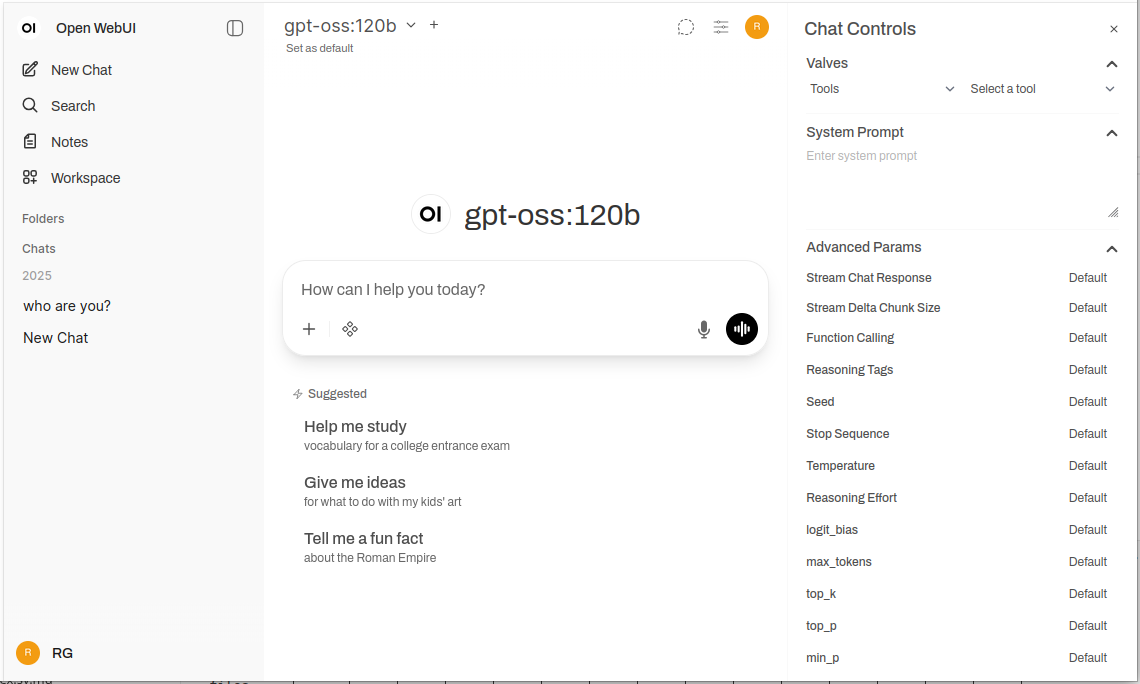

Open WebUI to potężny, rozszerzalny i bogaty w funkcje samozostawiana aplikacja webowa do interakcji z dużymi modelami językowymi.

Obsługuje Ollama oraz dowolny API kompatybilny z OpenAI, zapewniając doświadczenie podobne do ChatGPT w Twojej infrastrukturze z pełną prywatnością, możliwością pracy offline i funkcjami na poziomie przedsiębiorstwa. Aby uzyskać szeroką analizę lokalnych i chmurowych backendów modeli językowych — Ollama, vLLM, Docker Model Runner, LocalAI i dostawców chmurowych — zobacz Hostowanie modeli językowych: Porównanie lokalnych, samozostawianych i chmurowych infrastruktur.

Co to jest Open WebUI?

Open WebUI to open-source, samozostawiana aplikacja webowa, która zapewnia nowoczesny interfejs do interakcji z dużymi modelami językowymi. W przeciwieństwie do usług AI opartych na chmurze, Open WebUI działa całkowicie na Twojej infrastrukturze, dając Ci pełną kontrolę nad danymi, rozmowami i wyborem modeli.

Choć Open WebUI jest najczęściej używany z Ollama (i czasem nieoficjalnie nazywany “Ollama WebUI”), to w rzeczywistości jest platformą niezależną od backendu. Może łączyć się z API Ollama do lokalnego wykonywania modeli, ale także obsługuje dowolny endpoint kompatybilny z OpenAI — w tym vLLM, LocalAI, LM Studio, Text Generation WebUI i nawet dostawców chmurowych. Ta elastyczność sprawia, że Open WebUI jest kompleksowym rozwiązaniem obsługującym wiele backendów, RAG (Retrieval-Augmented Generation) do rozmów z dokumentami, autoryzację wielu użytkowników, możliwości wypowiedzi głosowych oraz szerokie możliwości dostosowywania. Niezależnie od tego, czy uruchamiasz modele na laptopie, serwerze domowym czy klastrze Kubernetes, Open WebUI skaluje się wraz z Twoimi potrzebami.

Dlaczego wybrać Open WebUI?

Prywatność w pierwszym miejscu: wszystkie dane pozostają na Twojej infrastrukturze — żadne rozmowy, dokumenty ani wskazówki nie opuszczają Twojej sieci, chyba że wyraźnie skonfigurujesz zewnętrzne API.

Wersja offline: idealna do środowisk izolowanych, ograniczonych sieci lub sytuacji, w których dostęp do internetu jest niepewny lub zabroniony. Połączone z lokalnie działającymi modelami przez Ollama lub vLLM osiągasz pełną niezależność od usług chmurowych.

Bogaty w funkcje: mimo że jest samozostawiana, Open WebUI rywalizuje z ofertami komercyjnymi dzięki możliwości przesyłania dokumentów i RAG, historii rozmów z wyszukiwaniem semantycznym, szablonom i udostępnianiu wskazówek, zarządzaniu modelami, wypowiedziom głosowym, responsywnemu projektowi mobilnemu i ciemnym/światłym motywom.

Wsparcie wielu użytkowników: wbudowany system autoryzacji z kontrolą dostępu opartą na rolach (administrator, użytkownik, oczekujący), panel zarządzania użytkownikami, izolację rozmów i udostępnianie wskazówek i modeli w ramach zespołów.

Szybki przewodnik instalacji

Najprostszym sposobem rozpoczęcia pracy z Open WebUI jest użycie Docker. Ten fragment obejmuje najczęściej spotykane scenariusze wdrażania.

Podstawowa instalacja (łączenie z istniejącym Ollama)

Jeśli masz już uruchomiony Ollama na swoim systemie, użyj poniższego polecenia:

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

To uruchomi Open WebUI na porcie 3000, przechowując dane w wolumenie Docker. Możesz go uzyskać pod adresem http://localhost:3000.

Zintegrowana instalacja (Open WebUI + Ollama)

Dla kompletnego jednostopniowego ustawienia z Ollama:

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

Flaga --gpus all umożliwia dostęp do GPU dla szybszego wnioskowania. Omituj ją, jeśli pracujesz tylko na CPU.

Wdrożenie z użyciem Docker Compose

Dla wdrożeń produkcyjnych, Docker Compose zapewnia lepszą utrzymanie:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

Wdróż za pomocą docker-compose up -d.

Wdrożenie w Kubernetes

Dla wdrożeń firmowych, Open WebUI oferuje charty Helm:

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

To tworzy wdrożenie gotowe do produkcji z trwałą pamięcią, testami zdrowia i opcjonalną konfiguracją ingressu.

Głębszy przegląd kluczowych funkcji

RAG i rozmowy z dokumentami

Implementacja RAG w Open WebUI umożliwia przesyłanie dokumentów i odnoszenie się do nich w rozmowach. System automatycznie dzieli dokumenty na fragmenty, generuje embeddingi, przechowuje je w bazie wektorowej i odzyskuje odpowiedni kontekst, gdy zadajesz pytania.

Obsługiwane formaty: PDF, DOCX, TXT, Markdown, CSV i wiele więcej dzięki wbudowanym parserom.

Użycie: Kliknij przycisk ‘+’, wybierz ‘Prześlij pliki’, wybierz swoje dokumenty i zacznij zadawać pytania. Model będzie cytował odpowiednie fragmenty i numery stron w swoich odpowiedziach.

Konfiguracja: Możesz dostosować rozmiar fragmentu, nakład, model embeddingu i parametry odzyskiwania w ustawieniach administratora dla optymalnej wydajności z typami dokumentów.

Wielo-użytkownikowa autoryzacja i zarządzanie

Open WebUI zawiera kompletny system autoryzacji odpowiedni do użycia w zespołach i organizacjach:

- Autoryzacja lokalna: nazwa użytkownika/hasło z bezpiecznym hashowaniem hasła

- Integracja OAuth/OIDC: połączenie z istniejącymi dostawcami tożsamości (Google, GitHub, Keycloak itp.)

- LDAP/Active Directory: integracja z katalogiem firmowym

- Autoryzacja oparta na rolach: administrator (pełna kontrola), użytkownik (standardowy dostęp), oczekujący (wymaga zatwierdzenia)

Administratorzy mogą zarządzać użytkownikami, monitorować użycie, konfigurować dostęp do modeli na poziomie użytkownika/grupy i ustalać polityki przechowywania rozmów.

Wypowiedź głosowa i wizualna

Wbudowana obsługa interakcji głosowej sprawia, że Open WebUI jest łatwy w użyciu i wygodny:

- Rozpoznawanie mowy: korzysta z API Web Speech lub skonfigurowanych zewnętrznych usług STT

- Wypowiadanie głosowe: obsługuje wiele silników TTS (bazowane na przeglądarce, Coqui TTS, ElevenLabs itp.)

- Obsługa języków: działa z wieloma językami w zależności od konfiguracji TTS/STT

Narzędzia do projektowania wskazówek

Open WebUI oferuje solidne narzędzia do zarządzania wskazówkami:

- Biblioteka wskazówek: zapisywanie często używanych wskazówek jako szablonów

- Zmienne i miejsca zastępcze: tworzenie ponownie użyciowych wskazówek z dynamicznym treścią

- Udostępnianie wskazówek: udostępnianie skutecznych wskazówek zespołowi

- Wersjonowanie wskazówek: śledzenie zmian i poprawek w czasie

Zarządzanie modelami

Łatwe przełączanie i zarządzanie modelami przez interfejs użytkownika:

- Katalog modeli: przeglądanie i pobieranie modeli bezpośrednio z biblioteki Ollama

- Modely niestandardowe: przesyłanie i konfigurowanie niestandardowych modeli GGUF

- Parametry modelu: dostosowywanie temperatury, top-p, długości kontekstu i innych parametrów próbkowania na rozmowę

- Metadane modelu: przeglądanie szczegółów modelu, rozmiaru, kwantyzacji i możliwości

Konfiguracja i dostosowanie

Zmienne środowiskowe

Kluczowe opcje konfiguracji za pomocą zmiennych środowiskowych:

# URL backendu (Ollama lub inny API kompatybilny z OpenAI)

OLLAMA_BASE_URL=http://localhost:11434

# Włącz autoryzację

WEBUI_AUTH=true

# Domyślna rola użytkownika (user, admin, pending)

DEFAULT_USER_ROLE=pending

# Włącz rejestrację użytkownika

ENABLE_SIGNUP=true

# E-mail administratora (automatyczne tworzenie konta administratora)

WEBUI_ADMIN_EMAIL=admin@example.com

# Baza danych (domyślnie SQLite, lub PostgreSQL w środowisku produkcyjnym)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# Włącz RAG

ENABLE_RAG=true

# Model embeddingu dla RAG

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

Łączenie z alternatywnymi backendami

Open WebUI działa z dowolnym API kompatybilnym z OpenAI. Skonfiguruj URL podstawowy w Ustawienia → Połączenia:

- vLLM:

http://localhost:8000/v1 - LocalAI:

http://localhost:8080 - LM Studio:

http://localhost:1234/v1 - Text Generation WebUI:

http://localhost:5000/v1 - OpenAI:

https://api.openai.com/v1(wymaga klucza API) - Azure OpenAI: niestandardowy URL punktu końcowego

Konfiguracja proxy odwrotnego

Dla wdrożeń produkcyjnych, uruchom Open WebUI za proxy odwrotnym:

Przykład Nginx:

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# Obsługa WebSocket

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Przykład Traefik (etykiety Docker):

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

Optymalizacja wydajności

Optymalizacja bazy danych

Dla wdrożeń wielu użytkowników, przejdź z SQLite na PostgreSQL:

# Zainstaluj zależności

pip install psycopg2-binary

# Skonfiguruj URL bazy danych

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

PostgreSQL lepiej radzi sobie z użytkownikami współbieżnymi i zapewnia poprawną wydajność zapytań dla wyszukiwania rozmów i operacji RAG.

Wybór modelu embeddingu

Wykonanie RAG zależy w dużej mierze od wyboru modelu embeddingu:

- Szybki/ograniczony zasobami:

all-MiniLM-L6-v2(384 wymiary, ~80MB) - Zrównoważony:

all-mpnet-base-v2(768 wymiarów, ~420MB) - Najlepsza jakość:

bge-large-en-v1.5(1024 wymiarów, ~1,3GB)

Skonfiguruj w Ustawienia → RAG → Model embeddingu.

Strategie cacheowania

Włącz cacheowanie rozmów, aby zmniejszyć powtarzające się wywołania API:

- Cache modelu: Ollama automatycznie cacheuje załadowane modele w pamięci

- Cache odpowiedzi: Open WebUI może cacheować identyczne wskazówki (konfigurowalne)

- Cache embeddingu: ponowne użycie embeddingów dla wcześniej przetworzonych dokumentów

Najlepsze praktyki bezpieczeństwa

Podczas wdrażania Open WebUI w środowisku produkcyjnym, postępuj zgodnie z poniższymi wytycznymi dotyczącymi bezpieczeństwa:

- Włącz autoryzację: nigdy nie uruchamiaj Open WebUI bez autoryzacji na publicznych sieciach

- Użyj HTTPS: zawsze wdrażaj za proxy odwrotnym z TLS/SSL

- Regularne aktualizacje: utrzymuj Open WebUI i Ollama zaktualizowane w celu poprawek bezpieczeństwa

- Ogranicz dostęp: używaj reguł zapory ogniowej, aby ograniczyć dostęp do zaufanych sieci

- Zabezpiecz klucze API: jeśli łączone są z zewnętrznymi API, używaj zmiennych środowiskowych, nigdy nie koduj kluczy

- Logowanie i audyt: włącz i monitoruj logi dostępu w celu wykrywania podejrzanych działań

- Zapasowe kopie danych: regularnie twórz kopie zapasowe wolumenu

/app/backend/data - Szyfrowanie bazy danych: włącz szyfrowanie danych w spoczynku dla PostgreSQL w środowisku produkcyjnym

- Ograniczanie przepływu: skonfiguruj ograniczenia przepływu, aby zapobiec nadużyciu

- Filtrowanie treści: zaimplementuj polityki treści odpowiednie dla Twojej organizacji

Przypadki użycia i rzeczywiste zastosowania

Osobisty asystent wiedzy

Połącz Open WebUI z lokalnymi modelami i RAG, aby stworzyć prywatną bazę wiedzy. Prześlij swoje notatki, artykuły naukowe, dokumentację projektu i osobiste dokumenty. Pytaj o nie bez wysyłania danych do usług chmurowych — idealne dla badaczy, studentów i pracowników, którzy cenią prywatność.

Współpraca zespołu programistów

Wdroż Open WebUI dla swojego zespołu programistów z dostępem do dokumentacji technicznej, specyfikacji API i wiedzy o kodzie. Funkcja RAG pozwala programistom szybko znajdować odpowiednie informacje w tysiącach stron dokumentacji, a historia rozmów pomaga śledzić decyzje architektoniczne i dyskusje techniczne.

Wewnętrzny chatbot w przedsiębiorstwie

Organizacje mogą wdrożyć Open WebUI za swoim zaporą z integracją SSO, zapewniając pracownikom asystenta AI z dostępem do wewnętrznych wiki, zasad i procedur. Autoryzacja oparta na rolach zapewnia odpowiednie segmentowanie poufnych informacji, a kontrole administratora utrzymują nadzór i zgodność.

Edukacja i szkolenia

Instytucje edukacyjne używają Open WebUI, aby zapewnić studentom i nauczycielom pomoc AI bez obaw o prywatność. Prześlij materiały kursowe, podręczniki i notatki z wykładów dla kontekstowej odpowiedzi na pytania. System wielu użytkowników umożliwia śledzenie użycia, jednocześnie utrzymując prywatność danych studentów.

Zastosowania w medycynie i prawie

W regulowanych branżach, gdzie prywatność danych jest krytyczna, Open WebUI umożliwia przepływ pracy wspomaganego przez AI, jednocześnie utrzymując zgodność z normami HIPAA lub GDPR. Specjaliści medyczni mogą badać bazy leków i protokoły leczenia, a zespoły prawnicze mogą przeszukiwać przypisy i kontrakty — wszystko bez opuszczenia kontrolowanej infrastruktury.

Środowiska odizolowane i offline

Agencje rządowe, instytucje badawcze i centra operacyjne z wysokim poziomem bezpieczeństwa używają Open WebUI w sieciach odizolowanych. Pełna możliwość pracy offline zapewnia dostęp do asystenta AI nawet bez połączenia internetowego, co jest krytyczne dla środowisk klasyfikowanych lub lokalizacji odległych.

Rozwiązywanie typowych problemów

Problemy z połączeniem

Problem: Open WebUI nie może się połączyć z Ollama

Rozwiązanie: Sprawdź, czy Ollama działa (curl http://localhost:11434), sprawdź zmienną środowiskową OLLAMA_BASE_URL i upewnij się, że reguły zapory pozwalają na połączenie. Dla wdrożeń Docker, użyj nazw usług (http://ollama:11434) zamiast localhost.

Problem: Modele nie pojawiają się w interfejsie

Rozwiązanie: Potwierdź, że modele są zainstalowane (ollama list), odśwież listę modeli w ustawieniach Open WebUI i sprawdź konsolę przeglądarki na błędy API.

Problemy z RAG i przesyłaniem dokumentów

Problem: Przesyłanie dokumentów nie powoduje sukcesu

Rozwiązanie: Sprawdź ograniczenia rozmiaru plików w ustawieniach, potwierdź obsługiwany format pliku, upewnij się, że jest wystarczająco miejsca na dysku w wolumenie danych, a następnie sprawdź logi kontenera na błędy parsowania.

Problem: Odpowiedzi RAG nie odnoszą się do przesłanych dokumentów

Rozwiązanie: Potwierdź, że model embeddingu jest pobrany i działa, sprawdź ustawienia rozmiaru fragmentu (spróbuj mniejszych fragmentów dla lepszej szczegółowości), zwiększ liczbę odzyskanych fragmentów w ustawieniach RAG i upewnij się, że pytanie jest odpowiednie do zawartości dokumentu.

Problemy z wydajnością

Problem: Wolne odpowiedzi

Rozwiązanie: Włącz przyspieszenie GPU, jeśli jest dostępne, zmniejsz rozmiar modelu lub użyj wersji skwantyzowanej, zwiększ OLLAMA_NUM_PARALLEL dla żądań współbieżnych i przydziel więcej RAM kontenerom Docker.

Problem: Błędy przekroczenia pamięci

Rozwiązanie: Użyj mniejszych modeli (7B zamiast 13B parametrów), zmniejsz długość kontekstu w parametrach modelu, ogranicz liczbę użytkowników współbieżnych lub dodaj więcej RAM/swap do systemu.

Autoryzacja i dostęp

Problem: Nie mogę się zalogować ani utworzyć konta administratora

Rozwiązanie: Ustaw WEBUI_AUTH=true, skonfiguruj WEBUI_ADMIN_EMAIL, aby automatycznie utworzyć administratora, wyczyść pliki cookie i cache przeglądarki i sprawdź logi kontenera na błędy bazy danych.

Problem: Użytkownicy nie mogą się zarejestrować

Rozwiązanie: Potwierdź ENABLE_SIGNUP=true, sprawdź ustawienie DEFAULT_USER_ROLE (użyj user dla automatycznego zatwierdzenia lub pending dla ręcznego zatwierdzenia), a także upewnij się, że baza danych jest zapisywalna.

Alternatywy dla Open WebUI

Choć Open WebUI doskonale radzi sobie z dostarczaniem samozostawianego interfejsu z silną integracją Ollama, kilka alternatyw oferuje różne podejścia do tego samego problemu. Twój wybór zależy od tego, czy potrzebujesz elastyczności wielu dostawców, specjalistycznej obsługi dokumentów, ekstremalnej prostoty lub funkcji firmowych.

LibreChat wyróżnia się jako najbardziej niezależna od dostawcy rozwiązanie, oferując natywną obsługę OpenAI, Anthropic, Azure OpenAI, Google Vertex AI, AWS Bedrock i Ollama w jednym interfejsie. Jego architektura wtyczkowa oraz funkcje firmowe, takie jak wielodostępność, szczegółowe kontrole dostępu i kwoty użycia, czynią ją idealną dla organizacji, które potrzebują wsparcia wielu dostawców AI lub zaawansowanych śladów audytu. Wymianą jest złożoność — LibreChat wymaga większego wysiłku konfiguracyjnego i większych zasobów niż Open WebUI, a jej obsługa Ollama wydaje się sekundarna wobec dostawców chmurowych. Jeśli Twój zespół korzysta z Claude do pisania, GPT-4 do kodowania i lokalnych modeli dla pracy z poufnymi danymi, interfejs LibreChat świetnie sprawdza się.

Dla przepływów pracy opartych na dokumentach, AnythingLLM podejmuje podejście pierwsze w zakresie bazy wiedzy, które przekracza podstawowe RAG. Jego model pracowni organizuje dokumenty i rozmowy w izolowanych środowiskach, a zaawansowane funkcje odzyskiwania obejmują wyszukiwanie hybrydowe, ponowne rangowanie i śledzenie cytowania. Połączenia danych pobierają treści z GitHub, Confluence i Google Drive, a możliwości agenta umożliwiają wielokrokowe rozumowanie i automatyzację przepływów pracy. To czyni AnythingLLM doskonałym rozwiązaniem dla firm doradczych zarządzających wieloma bazami wiedzy klientów lub zespołów wsparcia pracujących z rozległą dokumentacją. Interfejs rozmów jest mniej wygładzony niż w Open WebUI, ale jeśli Twoją główną potrzebą jest przeszukiwanie dużych zbiorów dokumentów, zaawansowane możliwości odzyskiwania uzasadniają steeper learning curve.

LobeChat priorytetyzuje doświadczenie użytkownika nad głębokością funkcji, oferując nowoczesny, przyjazny dla mobilnych interfejs użytkownika z możliwościami aplikacji PWA. Jego nowoczesny design, płynne animacje i silna obsługa wypowiedzi/multimodalna sprawiają, że jest popularny wśród projektantów i użytkowników nietechnicznych, którzy chcą asystenta AI, który działa płynnie na różnych urządzeniach. Implementacja PWA zapewnia aplikacyjne doświadczenie mobilne, które Open WebUI nie dorównuje. Jednak funkcje firmowe są ograniczone, ekosystem wtyczek jest mniejszy, a możliwości RAG są mniej rozwinięte niż zarówno w Open WebUI, jak i AnythingLLM.

Dla użytkowników preferujących aplikacje desktopowe, Jan.ai oferuje instalatory wieloplatformowe (Windows, macOS, Linux) z lokalnym zarządzaniem modelami bez konfiguracji. Nie trzeba instalować Ollama oddzielnie ani zajmować się Dockerem — Jan łączy wszystko w native app z obsługą pasku zadań i jednoklikowym pobieraniem modeli. To “it just works” filozofia czyni Jan idealnym do udostępniania lokalnych modeli językowych rodzinie lub kolegom, którzy nie są komfortowi z narzędziami wiersza poleceń. Wymianą jest brak wsparcia wielu użytkowników, mniej zaawansowanych funkcji i brak możliwości dostępu zdalnego.

Chatbox zajmuje niszę lekkich aplikacji — minimalna aplikacja wieloplatformowa wspierająca OpenAI, Claude, Gemini i lokalne API z bardzo niskim przeciążeniem zasobów. Idealna do szybkiego testowania różnych dostawców API lub użytkowników z ograniczonymi zasobami sprzętu. Wymiana ustawień jest minimalna, ale niektóre funkcje są ograniczone do subskrypcji, nie jest w pełni open-source i wsparcie RAG jest ograniczone.

Istnieje kilka minimalnych interfejsów dla Ollama: Hollama zarządza wieloma serwerami Ollama na różnych maszynach, Ollama UI oferuje podstawowe rozmowy i przesyłanie PDF z ekstremalnie łatwym wdrażaniem, a Oterm oferuje niezwykle zdolny interfejs terminalowy do sesji SSH i tmux. Te oferują funkcje w zamian za prostotę i szybkość.

Dla organizacji wymagających wsparcia od dostawcy, komercyjne opcje takie jak TypingMind Team, BionicGPT i Dust.tt oferują samozostawianie z profesjonalnym wsparciem, certyfikatami zgodności i SLA. Zamieniają wolność open-source na zapewnione dostępność, audyty bezpieczeństwa i odpowiedzialność — odpowiednie, gdy Twoja organizacja potrzebuje umów wsparcia firmowego.

Wybór mądry: Open WebUI trafia w środek dla większości samozostawianych wdrożeń Ollama, balansując między komprehensywnymi funkcjami a zarządzalną złożonością. Wybierz LibreChat, jeśli elastyczność dostawcy jest kluczowa, AnythingLLM dla zaawansowanych przepływów pracy dokumentów, LobeChat dla użytkowników mobilnych lub projektantów, Jan dla użytkowników desktopowych bez technicznej wiedzy, lub komercyjne opcje, jeśli potrzebujesz wsparcia od dostawcy. Dla większości użytkowników technicznych uruchamiających lokalne modele, aktywne rozwijanie Open WebUI, silna społeczność i doskonała implementacja RAG czynią ją zalecanym punktem wyjścia.

Przyszłe rozwinięcia i plany rozwoju

Open WebUI nadal szybko rozwija się, a na planie są kilka ekscytujących funkcji:

Poprawiona wsparcie multimodalne: lepsze obsługa obrazów, modeli wizyjnych i rozmów multimodalnych z modelami takimi jak LLaVA i Bakllava.

Zwiększone możliwości agentów: wywoływanie funkcji, korzystanie z narzędzi i wielokrokowe przepływy pracy podobne do AutoGPT.

Lepsze aplikacje mobilne: native aplikacje iOS i Android poza obecną implementacją PWA dla poprawniejszego doświadczenia mobilnego.

Zaawansowane funkcje RAG: RAG oparty na grafach, semantyczne fragmentowanie, wielokrotne wyszukiwanie i odzyskiwanie dokumentów nadrzędnych dla lepszego kontekstu.

Funkcje współpracy: udostępnione rozmowy, przestrzenie pracy zespołów i współpraca w czasie rzeczywistym nad wskazówkami i dokumentami.

Integracje firmowe: głębsza obsługa SSO, SCIM provisioning, zaawansowane logi audytu i raporty zgodności dla przemysłów regulowanych.

Projekt utrzymuje kompatybilność wsteczną i semantyczne wersjonowanie, co sprawia, że aktualizacje są proste. Aktywny repozytorium GitHub widzi codzienne commity i odpowiednie zarządzanie problemami.

Podsumowanie

Open WebUI ewoluował z prostego frontendu Ollama do komprehensywnej platformy do samozostawianych interakcji z AI. Kombinacja prywatności, funkcji i łatwości wdrażania czyni ją doskonałym wyborem dla osób, zespołów i organizacji, które chcą korzystać z lokalnych modeli językowych bez poświęcania możliwości.

Czy jesteś programistą testującym modele, organizacją tworzącą wewnętrzne narzędzia AI, czy osobą priorytetyzującą prywatność, Open WebUI oferuje fundament dla potężnych, samozostawianych przepływów pracy AI. Aktywna społeczność, regularne aktualizacje i rozszerzalna architektura zapewniają, że będzie to wiodące opcje w przestrzeni samozostawianych AI.

Zacznij od podstawowej instalacji Docker, eksperymentuj z RAG, przesyłając kilka dokumentów, spróbuj różnych modeli z biblioteki Ollama i stopniowo eksploruj zaawansowane funkcje, gdy Twoje potrzeby rosną. Krzywa uczenia się jest łagodna, ale sufit jest wysoki — Open WebUI skaluje się od osobistego laptopa do klastra Kubernetes w firmie.

Dla tych, którzy porównują alternatywy, projekt Ollama-first, zrównoważony zestaw funkcji i aktywne rozwijanie Open WebUI czynią go zalecanym punktem wyjścia dla większości wdrożeń samozostawianych modeli językowych. Zawsze możesz przenieść się do bardziej specjalizowanych rozwiązań, jeśli pojawią się konkretne potrzeby, ale wielu użytkowników znajduje możliwości Open WebUI wystarczające na całą swoją podróż od eksperymentów do produkcji. Aby zobaczyć, jak typowe backendi Open WebUI (Ollama, vLLM itp.) pasują do Docker Model Runner, LocalAI i dostawców chmurowych, sprawdź nasz przewodnik Hostowanie modeli językowych: Lokalne, samozostawiane i infrastruktura chmurowa.

Przydatne linki

Podczas konfigurowania środowiska Open WebUI warto zrozumieć szerszy ekosystem lokalnego hostowania i opcji wdrażania modeli językowych. Kompletny przewodnik Lokalne hostowanie modeli językowych: Pełny przewodnik 2025 - Ollama, vLLM, LocalAI, Jan, LM Studio i inne porównuje 12+ lokalnych narzędzi do modeli językowych, w tym Ollama, vLLM, LocalAI i inne, pomagając Ci wybrać odpowiedni backend dla wdrożenia Open WebUI na podstawie dojrzałości API, możliwości wywoływania narzędzi i testów wydajności.

Dla wysokiej wydajności wdrożeń produkcyjnych, gdzie przepustowość i opóźnienia są krytyczne, zapoznaj się z przewodnikiem vLLM Quickstart: Wysokiej wydajności serwowanie modeli językowych, który pokazuje instalację vLLM z Dockerem, kompatybilność z API OpenAI i optymalizację PagedAttention. To szczególnie wartościowe, jeśli Open WebUI służy wielu współbieżnym użytkownikom, a wydajność Ollama staje się punktem zwrotnym.

Zrozumienie tego, jak Twój backend obsługuje żądania współbieżne, jest kluczowe dla planowania pojemności. Artykuł Jak Ollama obsługuje żądania równoległe wyjaśnia model kolejki żądań, zarządzanie pamięcią GPU i model wykonywania współbieżnego w Ollama, pomagając Ci skonfigurować odpowiednie limity i oczekiwania dla scenariuszy wielu użytkowników wdrożenia Open WebUI.

Zasoby zewnętrzne

Aby uzyskać oficjalne dokumenty i wsparcie społeczności, odwiedź te zasoby zewnętrzne: