Docker Model Runner vs Ollama (2026): Który jest lepszy do lokalnych modeli LLM?

Porównaj Docker Model Runner i Ollama w kontekście lokalnych modeli LLM

Uruchamianie dużych modeli językowych (LLM) lokalnie staje się coraz bardziej popularne ze względu na prywatność, kontrolę kosztów i możliwości offline. Landscape zmienił się znacząco w kwietniu 2025 roku, gdy Docker wprowadził Docker Model Runner (DMR), oficjalne rozwiązanie do wdrażania modeli AI.

Teraz trzy podejścia rywalizują o uwagę programistów: natywny Model Runner od Dockera, rozwiązania trzecich stron w kontenerach (vLLM, TGI) oraz autonomiczna platforma Ollama.

Aby uzyskać szerszy obraz, który obejmuje dostawców chmurowych i analizę kosztów oraz infrastruktury, zobacz Hostowanie LLM: Porównanie lokalnego, samowystarczalnego i infrastruktury w chmurze.

TL;DR – Docker Model Runner vs Ollama

To porównanie koncentruje się na uruchamianiu dużych modeli językowych (LLM) lokalnie za pomocą Dockera lub autonomicznych środowisk uruchomieniowych, obejmując wydajność, obsługę GPU, kompatybilność API i scenariusze wdrażania w produkcji.

- Najlepszy dla workflowów natywnych Dockera: Docker Model Runner

- Najlepszy dla prostoty i szybkiego prototypowania: Ollama

- Najlepszy dla Kubernetes i orkestracji: konfiguracje oparte na Dockercie

- Najlepszy dla rozwoju na pojedynczym komputerze: Ollama

Jeśli intensywnie korzystasz z Dockera, DMR ma sens.

Jeśli chcesz najszybszy sposób na uruchamianie LLM lokalnie, Ollama jest prostszy.

Jeśli porównujesz więcej niż tylko Docker Model Runner i Ollama, zobacz nasze pełne omówienie Ollama vs vLLM vs LM Studio i inne narzędzia lokalnego hostowania LLM. Ten przewodnik porównuje dojrzałość API, obsługę sprzętu, wywoływanie narzędzi i gotowość do produkcji wśród 12+ lokalnych środowisk uruchomieniowych LLM.

Docker Model Runner vs Ollama: bezpośrednie porównanie

Z oficjalnym wejściem Dockera do przestrzeni runnerów LLM, porównanie staje się bardziej ciekawe. Oto jak DMR i Ollama porządkują się na wzajem:

| Funkcja | Docker Model Runner | Ollama |

|---|---|---|

| Instalacja | W zakładce AI w Docker Desktop lub docker-model-plugin |

Jednolinijkowy komend: curl | sh |

| Styl komend | docker model pull/run/package |

ollama pull/run/list |

| Format modelu | GGUF (OCI Artifacts) | GGUF (natywny) |

| Dystrybucja modelu | Docker Hub, rejestracje OCI | Rejestracja Ollama |

| Konfiguracja GPU | Automatyczna (prostsza niż tradycyjny Docker) | Automatyczna |

| API | Kompatybilne z OpenAI | Kompatybilne z OpenAI |

| Integracja z Dockerem | Natywna (jest to Docker) | Uruchamia się w Dockerze, jeśli jest to konieczne |

| Wsparcie Compose | Natywne | Przez obraz Docker |

| Krzywa uczenia | Niska (dla użytkowników Dockera) | Najniższa (dla wszystkich) |

| Partnerzy w ekosystemie | Google, Hugging Face, VMware | LangChain, CrewAI, Open WebUI |

| Najlepszy do | Workflowów natywnych Dockera | Prostej autonomicznej operacji |

Główne spostrzeżenie: DMR przynosi workflowy Dockera do wdrażania modeli AI, podczas gdy Ollama pozostaje niezależny od frameworków z prostszą autonomiczną operacją. Twoja istniejąca infrastruktura ma większy wpływ niż różnice techniczne.

Czy Docker Model Runner jest lepszy niż Ollama?

To zależy od Twojego workflowu.

- Wybierz Docker Model Runner (DMR), jeśli Twoja drużyna już intensywnie korzysta z Dockera, artefaktów OCI i orkestracji kontenerów.

- Wybierz Ollama, jeśli chcesz najprostszy sposób na uruchamianie LLM lokalnie z minimalną konfiguracją i szybkim prototypowaniem.

Dla większości konfiguracji pojedynczego komputera, Ollama jest łatwiejszy w użyciu.

Dla workflowów CI/CD natywnych Dockera i firmowych kontenerów, DMR łączy się bardziej naturalnie.

Jak uruchomić LLM w Dockercie: DMR vs Ollama

Jeśli Twoim celem jest po prostu uruchomienie LLM w Dockercie, zarówno Docker Model Runner, jak i Ollama w kontenerach Dockera mogą to osiągnąć.

Docker Model Runner korzysta z natywnych komend docker model pull i docker model run, pakując modele jako artefakty OCI.

Ollama może również działać w Dockercie, używając oficjalnego obrazu ollama/ollama, udostępniając API kompatybilne z OpenAI na porcie 11434.

Główne różnice leżą w integracji workflowu:

- DMR łączy się naturalnie z natywnymi pipelineami CI/CD Dockera.

- Ollama w Dockercie oferuje prostsze zarządzanie modelami z elastycznością orkestracji Dockera.

Zrozumienie runnerów modeli Dockera

Runnerzy modeli oparte na Dockercie korzystają z konteneryzacji, aby pakować silniki wnioskowania LLM wraz z ich zależnościami. Współczesna scena obejmuje zarówno oficjalne rozwiązanie Dockera, jak i frameworki trzecich stron.

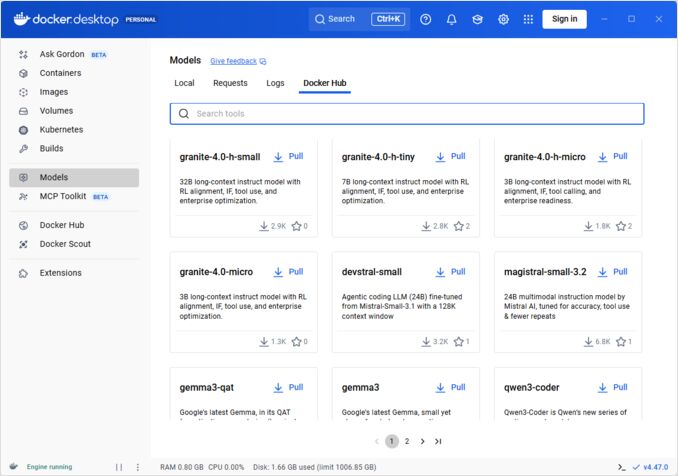

Docker Model Runner (DMR) – Oficjalne rozwiązanie

W kwietniu 2025 roku Docker wprowadził Docker Model Runner (DMR), oficjalny produkt zaprojektowany do uproszczenia uruchamiania modeli AI lokalnie przy użyciu infrastruktury Dockera. Oznacza to zaangażowanie Dockera w sprawne wdrażanie modeli AI tak samo jak konteneryzacja.

Główne funkcje DMR:

- Natywna integracja z Dockerem: Używa znanych komend Dockera (

docker model pull,docker model run,docker model package) - Pakowanie jako artefakty OCI: Modele są pakowane jako artefakty OCI, umożliwiając dystrybucję przez Docker Hub i inne rejestry

- API kompatybilne z OpenAI: Gotowy do użycia zamiast punktów końcowych OpenAI, upraszczając integrację

- Współpraca z GPU: Natywna obsługa GPU bez skomplikowanej konfiguracji nvidia-docker

- Obsługa formatu GGUF: Działa z popularnymi formatami modeli z kwantyzacją

- Integracja z Docker Compose: Łatwe konfigurowanie i wdrażanie modeli przy użyciu standardowych narzędzi Dockera

- Wsparcie Testcontainers: Gładka integracja z ramami testowania

Instalacja:

- Docker Desktop: Włącz przez zakładkę AI w ustawieniach

- Docker Engine: Zainstaluj pakiet

docker-model-plugin

Przykładowe użycie:

# Pobierz model z Docker Hub

docker model pull ai/smollm2

# Uruchom wnioskowanie

docker model run ai/smollm2 "Wyjaśnij Docker Model Runner"

# Pakuj niestandardowy model

docker model package --gguf /ścieżka/do/model.gguf --push myorg/mymodel:latest

Aby uzyskać pełny odniesienie do komend docker model, opcji pakowania, flag konfiguracyjnych i praktycznych przykładów, zobacz nasz szczegółowy Docker Model Runner Cheatsheet: Komendy i Przykłady. Pokrywa pobieranie modeli, pakowanie, konfigurację i najlepsze praktyki wdrażania LLM lokalnie z użyciem Dockera.

DMR współpracuje z Google, Hugging Face i VMware Tanzu, aby rozszerzyć ekosystem modeli AI dostępnych przez Docker Hub. Jeśli jesteś nowy w Dockercie lub potrzebujesz odświeżenia w zakresie komend Dockera, nasz Docker Cheatsheet oferuje kompleksowy przewodnik po istotnych operacjach Dockera.

Rozwiązania trzecich stron w Dockercie

Poza DMR, ekosystem obejmuje etabowane ramy:

- Kontenery vLLM: Wysokoprzepustowy serwer wnioskowania zoptymalizowany dla przetwarzania wsadowego

- Text Generation Inference (TGI): Gotowe rozwiązanie z Hugging Face

- Kontenery llama.cpp: Lekki implementacja w C++ z kwantyzacją

- Kontenery niestandardowe: Opakowanie PyTorch, Transformers lub firmowych ramów

Zalety podejścia Dockera

Flexibility i framework-agnostic: Kontenery Dockera mogą działać z dowolnymi ramami LLM, od PyTorch do ONNX Runtime, dając programistom pełną kontrolę nad stosem wnioskowania.

Izolacja zasobów: Każdy kontener działa w izolowanych środowiskach z zdefiniowanymi granicami zasobów (CPU, pamięć, GPU), zapobiegając konfliktom zasobów w wdrożeniach wielu modeli.

Wsparcie orkestracji: Docker łączy się naturalnie z Kubernetes, Docker Swarm i platformami chmurowymi, umożliwiając skalowanie, bilansowanie obciążenia i wysoką dostępność.

Kontrola wersji: Różne wersje modeli lub ramów mogą współistnieć na tej samej systemie bez konfliktów zależności.

Wady podejścia Dockera

Złożoność: Wymaga zrozumienia konteneryzacji, montażu woluminów, konfiguracji sieci i przechodzenia GPU (nvidia-docker).

Przeciążenie: Choć minimalne, Docker dodaje cienką warstwę abstrakcji, która lekko wpływa na czas uruchamiania i zużycie zasobów.

Obciążenie konfiguracyjne: Każde wdrożenie wymaga starannej konfiguracji Dockerfile, zmiennych środowiskowych i parametrów uruchomienia.

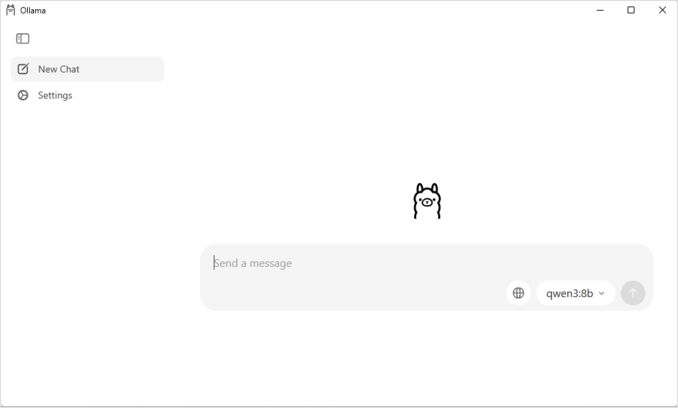

Zrozumienie Ollama

Ollama to aplikacja stworzona specjalnie do uruchamiania LLM lokalnie, zaprojektowana z prostotą jako głównym celem. Oferuje:

- Natywny binarny dla Linux, macOS i Windows

- Wbudowana biblioteka modeli z jednolinijkową instalacją

- Automatyczna detekcja i optymalizacja GPU

- RESTful API kompatybilne z formatem OpenAI

- Zarządzanie kontekstem i stanem modelu

Zalety Ollama

Prostota: Instalacja jest prosta (curl | sh na Linux), a uruchamianie modeli wymaga tylko ollama run llama2. Dla pełnego odniesienia do komend CLI Ollama takich jak ollama serve, ollama run, ollama ps i przepływów pracy zarządzania modelami, zobacz nasz Ollama CLI Cheatsheet.

Optymalizowana wydajność: Oparta na llama.cpp, Ollama jest bardzo dobrze zoptymalizowana pod kątem szybkości wnioskowania z obsługą kwantyzacji (Q4, Q5, Q8).

Zarządzanie modelami: Wbudowana rejestra modeli z komendami takimi jak ollama pull, ollama list, ollama rm upraszcza cykl życia modeli.

Doświadczenie programisty: Czyste API, szeroka dokumentacja i rosnące ekosystem integracji (LangChain, CrewAI itp.). Wersatylność Ollama rozciąga się na specjalistyczne przypadki użycia, takie jak ponowne rankowanie dokumentów tekstowych z modelami embeddingów.

Efektywność zasobów: Automatyczne zarządzanie pamięcią i wywalenie modeli przy bezczynności oszczędza zasoby systemowe.

Wady Ollama

Zakłócenie frameworku: Głównie obsługuje modele kompatybilne z llama.cpp, ograniczając elastyczność dla frameworków takich jak vLLM lub niestandardowych silników wnioskowania.

Ograniczona konfiguracja: Zaawansowane konfiguracje (niestandardowa kwantyzacja, konkretne strumienie CUDA) są mniej dostępne niż w środowiskach Dockera.

Wyzwania orkestracji: Choć Ollama może działać w kontenerach, brakuje natywnej obsługi zaawansowanych funkcji orkestracji, takich jak skalowanie poziome.

Porównanie wydajności

Prędkość wnioskowania

Docker Model Runner: Wydajność porównywalna z Ollama, ponieważ oba obsługują modele kwantyzowane GGUF. Dla Llama 2 7B (Q4), oczekiwana prędkość to 20-30 tokenów/sekunda na CPU i 50-80 tokenów/sekunda na średnich GPU. Minimalny nadmiar kontenera.

Ollama: Korzysta z bardzo zoptymalizowanego backendu llama.cpp z wydajną kwantyzacją. Dla Llama 2 7B (Q4), oczekiwana prędkość to 20-30 tokenów/sekunda na CPU i 50-80 tokenów/sekunda na średnich GPU. Brak nadmiaru kontenera. Aby uzyskać szczegółowe informacje na temat tego, jak Ollama zarządza równoległymi żądaniami, zobacz naszą analizę na temat jak Ollama obsługuje żądania równoległe.

Docker (vLLM): Zoptymalizowane do przetwarzania wsadowego z ciągłym przetwarzaniem wsadowym. Indywidualne żądania mogą być nieco wolniejsze, ale przepustowość wyróżnia się przy wysokiej obciążeniu współbieżnym (100+ tokenów/sekunda na model z przetwarzaniem wsadowym).

Docker (TGI): Podobne do vLLM z bardzo dobrą wydajnością przetwarzania wsadowego. Dodaje funkcje takie jak przesyłanie strumieniowe i generowanie token po tokenie.

Użycie pamięci

Docker Model Runner: Podobne do Ollama z automatycznym ładowaniem modeli. Modele GGUF Q4 zwykle zużywają 4-6 GB pamięci RAM. Nadmiar kontenera jest minimalny (kilka MB).

Konfiguracja rozmiaru kontekstu może znacząco wpływać na zużycie pamięci i zachowanie modelu. Domyślnie niektóre obrazy CUDA Docker Model Runner ustawią limit 4096 tokenów, nawet jeśli zostanie określony większy rozmiar w docker-compose. Aby uzyskać szczegółowe kroki nadpisania tego zachowania i pakowania modeli z niestandardowym rozmiarem kontekstu, zobacz nasz przewodnik na temat konfigurowania rozmiaru kontekstu w Docker Model Runner.

Ollama: Automatyczne zarządzanie pamięcią ładowa modeli na żądanie i wywalenie ich przy bezczynności. Model 7B Q4 zwykle zużywa 4-6 GB pamięci RAM. Najbardziej wydajny w przypadkach jednowarstwowych scenariuszy.

Tradycyjne rozwiązania Dockera: Zużycie pamięci zależy od frameworku. vLLM przydziela pamięć GPU wstępnie, aby uzyskać optymalną wydajność, podczas gdy kontenery oparte na PyTorch mogą używać więcej RAM na wagi modeli i cache KV (8-14 GB dla modeli 7B).

Czas uruchamiania

Docker Model Runner: Dodatkowy czas uruchamiania kontenera (~1 sekunda), plus czas ładowania modelu (2-5 sekund). Razem: 3-6 sekund dla średnich modeli.

Ollama: Praktycznie natychmiastowe uruchomienie, a czas ładowania modelu to 2-5 sekund dla średnich modeli. Najlepszy doświadczenie uruchamiania zimnego startu.

Tradycyjne Dockery: Dodatkowy czas uruchamiania kontenera (1-3 sekundy), plus czas ładowania modelu. Przewijanie kontenerów w środowiskach produkcyjnych ogranicza to.

Zalecenia do przypadków użycia

Wybierz Docker Model Runner, jeśli

- Workflow oparty na Dockercie: Twoja drużyna intensywnie korzysta z Dockera

- Jednolity narzędzia: Chcesz jedno narzędzie (Docker) dla kontenerów i modeli

- Dystrybucja artefaktów OCI: Potrzebujesz integracji z rejestrami firmowymi

- Wsparcie Testcontainers: Testujesz funkcje AI w CI/CD

- Preferencja Docker Hub: Chcesz dystrybucję modeli przez znane kanały

Wybierz Ollama, jeśli

- Szybkie prototypowanie: Szybkie eksperymentowanie z różnymi modelami

- Framework-agnostic: Nie jesteś powiązany z ekosystemem Dockera

- Absolutna prostota: Minimalne konfiguracje i obciążenie utrzymania

- Wdrożenia na pojedynczym serwerze: Uruchamianie na laptopach, stacjach roboczych lub pojedynczych maszynach wirtualnych

- Duża biblioteka modeli: Dostęp do szeroko zakrojonej biblioteki modeli wstępnie skonfigurowanych

Wybierz rozwiązania trzecich stron w Dockercie, jeśli

- Wdrożenia produkcyjne: Potrzeba zaawansowanej orkestracji i monitoringu

- Wdrażanie wielu modeli: Uruchamianie różnych frameworków (vLLM, TGI) równolegle

- Orkestracja Kubernetes: Skalowanie poza klastrami z bilansowaniem obciążenia

- Niestandardowe ramy: Użycie Ray Serve lub niestandardowych silników wnioskowania

- Ściśle kontrolowane zasoby: Wymuszanie granularnych limitów CPU/GPU na model

Hybrydowe podejścia: Najlepsze z obu światów

Nie jesteś ograniczony do jednego podejścia. Rozważ te strategie hybrydowe:

Opcja 1: Docker Model Runner + Tradycyjne kontenery

Użyj DMR dla standardowych modeli i kontenerów trzecich stron dla specjalistycznych frameworków:

# Pobierz standardowy model za pomocą DMR

docker model pull ai/llama2

# Uruchom vLLM dla scenariuszy wysokiej przepustowości

docker run --gpus all vllm/vllm-openai

Opcja 2: Ollama w Dockercie

Uruchom Ollama w kontenerach Dockera dla możliwości orkestracji:

docker run -d \

--name ollama \

--gpus all \

-v ollama:/root/.ollama \

-p 11434:11434 \

ollama/ollama

To zapewnia:

- Intuicyjne zarządzanie modelami Ollama

- Możliwości orkestracji i izolacji Dockera

- Wdrażanie w Kubernetes z standardowymi manifestami

Opcja 3: Mieszaj i dopasuj według przypadków użycia

- Rozwój: Ollama dla szybkiego iterowania

- Staging: Docker Model Runner dla testowania integracji

- Produkcja: vLLM/TGI w Kubernetes dla skalowalności

Kompatybilność API

Wszystkie nowoczesne rozwiązania zbiegają się na API kompatybilnym z OpenAI, upraszczając integrację:

API Docker Model Runner: Punkty końcowe kompatybilne z OpenAI są automatycznie udostępniane, gdy uruchamiasz modele. Nie wymaga dodatkowej konfiguracji.

# Model uruchamia się z automatycznie udostępnionym API

docker model run ai/llama2

# Użyj punktu końcowego kompatybilnego z OpenAI

curl http://localhost:8080/v1/chat/completions -d '{

"model": "llama2",

"messages": [{"role": "user", "content": "Dlaczego niebo jest niebieskie?"}]

}'

API Ollama: Punkty końcowe kompatybilne z OpenAI czynią z niego gotowy do użycia zamiennik dla aplikacji korzystających z SDK OpenAI. Obsługiwane jest przesyłanie strumieniowe.

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt": "Dlaczego niebo jest niebieskie?"

}'

API rozwiązania trzecich stron w Dockercie: vLLM i TGI oferują punkty końcowe kompatybilne z OpenAI, podczas gdy niestandardowe kontenery mogą implementować własne API.

Zbieżność na kompatybilność z OpenAI oznacza, że możesz przełączać się między rozwiązaniami z minimalnymi zmianami w kodzie.

Zarządzanie zasobami

Współpraca z GPU

Docker Model Runner: Natywna obsługa GPU bez skomplikowanej konfiguracji nvidia-docker. Automatycznie wykrywa i używa dostępnych GPU, znacznie upraszczając doświadczenie z GPU w Dockercie w porównaniu do tradycyjnych kontenerów.

Jeśli korzystasz z GPU NVIDIA i chcesz poprawnie skonfigurować wsparcie CUDA, zobacz nasz szczegółowy przewodnik na temat dodawania wsparcia GPU NVIDIA do Docker Model Runner. Pokrywa konfigurację demona Dockera, ustawienie Narzędzia NVIDIA Container Toolkit i jak potwierdzić, że Twój LLM rzeczywiście korzysta z pamięci GPU zamiast cofania się do wnioskowania na CPU.

# Współpraca z GPU działa automatycznie

docker model run ai/llama2

Ollama: Automatyczna detekcja GPU na CUDA-capable GPU NVIDIA. Nie wymaga konfiguracji poza instalacją sterowników.

Tradycyjne kontenery Dockera: Wymaga runtime nvidia-docker i jawnej alokacji GPU:

docker run --gpus all my-llm-container

Współpraca z CPU

Oba płynnie cofają się do wnioskowania na CPU, gdy GPU są niedostępne, choć wydajność znacznie spada (5-10 razy wolniej dla dużych modeli). Aby uzyskać wgląd w wydajność tylko CPU na nowoczesnych procesorach, przeczytaj nasz test na temat jak Ollama wykorzystuje wydajność i efektywne jądra CPU Intel.

Współpraca z wieloma GPU

Ollama: Obsługuje tensorową równoległością na wielu GPU dla dużych modeli.

Docker: Zależy od ramy. vLLM i TGI obsługują wnioskowanie na wielu GPU z odpowiednią konfiguracją.

Społeczność i ekosystem

Docker Model Runner: Uruchomiony w kwietniu 2025 roku z silnym wsparciem firmowym. Partnerstwa z Google, Hugging Face i VMware Tanzu AI Solutions zapewniają szeroki dostęp do modeli. Integracja z ogromną społecznością użytkowników Dockera (miliony użytkowników) zapewnia natychmiastowy dostęp do ekosystemu. Nadal buduje zasoby specyficzne dla społeczności jako nowy produkt.

Ollama: Szybko rosnąca społeczność z 50K+ gwiazdami na GitHubie. Silna integracja ekosystemu (LangChain, LiteLLM, Open WebUI, CrewAI) i aktywna społeczność Discord. Dostępne są rozszerzone narzędzia trzecich stron i tutoriale. Większa dojrzałość dokumentacji i zasobów społecznościowych. Aby uzyskać kompleksowy przegląd dostępnych interfejsów, zobacz nasz przewodnik dotyczący otwartych interfejsów użytkownika do lokalnych instancji Ollama. Jak w przypadku każdego szybko rosnącego projektu open-source, ważne jest, aby monitorować kierunek projektu - przeczytaj naszą analizę początkowe znaki enshittification Ollama w celu zrozumienia potencjalnych problemów.

Rozwiązania trzecich stron w Dockercie: vLLM i TGI mają dojrzałe ekosystemy z wsparciem firmowym. Szersze studia przypadków w produkcji, przewodniki optymalizacji i wzorce wdrażania od Hugging Face i społeczności użytkowników.

Rozważania kosztowe

Docker Model Runner: Darmowy z Dockera Desktop (osobisty/edukacyjny) lub Dockera Engine. Dockera Desktop wymaga subskrypcji dla większych organizacji (250+ pracowników lub 10M+ przychodu). Modele dystrybuowane przez Docker Hub podlegają cenom rejestru Dockera (darmowe publiczne repozytoria, płatne prywatne repozytoria).

Ollama: Kompletne darmowe i open-source bez kosztów licencyjnych niezależnie od rozmiaru organizacji. Koszty zasobów zależą tylko od sprzętu.

Rozwiązania trzecich stron w Dockercie: Darmowe dla open-source (vLLM, TGI). Potencjalne koszty dla platform orkestracji kontenerów (ECS, GKE) i prywatnego przechowywania repozytorium.

Rozważania bezpieczeństwa

Docker Model Runner: Korzysta z modelu bezpieczeństwa Dockera z izolacją kontenera. Modele pakowane jako artefakty OCI mogą być skanowane i podpisane. Dystrybucja przez Docker Hub umożliwia kontrolę dostępu i skanowanie wrażliwości dla użytkowników firmowych.

Ollama: Uruchamia się jako lokalna usługa z API udostępnionym domyślnie na localhost. Ekspozycja sieci wymaga jawnej konfiguracji. Rejestr modeli jest zaufany (Ollama-kuratoryzowany), zmniejszając ryzyko łańcucha dostaw.

Tradycyjne rozwiązania Dockera: Izolacja sieciowa jest wbudowana. Skanowanie bezpieczeństwa kontenera (Snyk, Trivy) i podpisywanie obrazów są standardową praktyką w środowiskach produkcyjnych.

Wszystkie rozwiązania wymagają uwagi do:

- Proweniencji modelu: Niezaufane modele mogą zawierać szkodliwy kod lub backdoory

- Autoryzacja API: Zaimplementuj autoryzację/autoryzację w wdrożeniach produkcyjnych

- Ograniczanie przepustowości: Zapobiegaj nadużyciu i wyczerpywaniu zasobów

- Ekspozycja sieci: Upewnij się, że API nie są przypadkowo ekspozycyjne na internet

- Przestrzeganie prywatności danych: Modele przetwarzają wrażliwe dane; zapewnij zgodność z regulacjami ochrony danych

Ścieżki migracji

Z Ollama do Docker Model Runner

Wsparcie GGUF w Docker Model Runner ułatwia migrację:

- Włącz Docker Model Runner w Docker Desktop lub zainstaluj

docker-model-plugin - Konwertuj odniesienia modeli:

ollama run llama2→docker model pull ai/llama2idocker model run ai/llama2 - Zaktualizuj punkty końcowe API z

localhost:11434do punktu końcowego DMR (zwyklelocalhost:8080) - Oba korzystają z API kompatybilnych z OpenAI, więc kod aplikacji wymaga minimalnych zmian

Z Docker Model Runner do Ollama

Przejście do Ollama dla prostszej autonomicznej operacji:

- Zainstaluj Ollama:

curl -fsSL https://ollama.ai/install.sh | sh. Dla pełnej listy komend CLI Ollama i opcji konfiguracji, odwołaj się do Ollama CLI cheatsheet. - Pobierz odpowiednie modele:

ollama pull llama2 - Zaktualizuj punkty końcowe API do

localhost:11434Ollama - Testuj za pomocą

ollama run llama2, aby potwierdzić funkcjonalność

Z tradycyjnych kontenerów Dockera do DMR

Uprość swoją konfigurację Dockera LLM:

- Włącz Docker Model Runner

- Zastąp niestandardowe Dockerfile komendami

docker model pull - Usuń konfigurację nvidia-docker (DMR obsługuje GPU automatycznie)

- Użyj

docker model runzamiast skomplikowanych komenddocker run

Z dowolnego rozwiązania do Ollama w Dockercie

Podejście najlepszych z obu światów:

docker pull ollama/ollama- Uruchom:

docker run -d --gpus all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama - Użyj komend Ollama jak zwykle:

docker exec -it ollama ollama pull llama2 - Zyskaj orkestrację Dockera z prostotą Ollama

Monitorowanie i obserwowalność

Ollama: Podstawowe metryki przez API (/api/tags, /api/ps). Narzędzia trzecich stron, takie jak Open WebUI, oferują panele.

Docker: Pełna integracja z Prometheus, Grafana, ELK stack i usługach monitoringu chmurowych. Metryki kontenera (CPU, pamięć, GPU) są łatwo dostępne.

Wnioski

Landscape lokalnego wdrażania LLM zmienił się znacząco z wprowadzeniem Docker Model Runner (DMR) przez Dockera w 2025 roku. Wybór zależy teraz od Twoich konkretnych wymagań:

- Dla programistów szukających integracji Dockera: DMR oferuje natywną integrację workflow Dockera za pomocą komend

docker model - Dla maksymalnej prostoty: Ollama nadal jest najprostszym rozwiązaniem z jednolinijkowym zarządzaniem modelami

- Dla produkcji i firm: Oba DMR i rozwiązania trzecich stron (vLLM, TGI) w Dockercie oferują orkestrację, monitorowanie i skalowalność

- Dla najlepszego z obu światów: Uruchom Ollama w kontenerach Dockera, aby połączyć prostotę z infrastrukturą produkcyjną

Wprowadzenie DMR zmniejsza różnicę w wygodzie użytkowania między Dockerem a Ollama. Ollama nadal wygrywa w prostocie dla szybkiego prototypowania, podczas gdy DMR wyróżnia się dla zespołów już zaangażowanych w workflow Dockera. Oba podejścia są aktywnie rozwijane, gotowe do produkcji, a ekosystem jest wystarczająco dojrzały, że przejście między nimi jest stosunkowo łatwe.

Podsumowanie: Jeśli intensywnie korzystasz z Dockera, DMR jest naturalnym wyborem. Jeśli chcesz bezwzględną prostotę niezależnie od infrastruktury, wybierz Ollama. Aby porównać te lokalne opcje z API w chmurze i innymi konfiguracjami samowystarczalnymi, sprawdź nasz Hostowanie LLM: Porównanie lokalnego, samowystarczalnego i infrastruktury w chmurze.

Przydatne linki

Docker Model Runner

- Oficjalna strona Docker Model Runner

- Dokumentacja Docker Model Runner

- Przewodnik startowy Docker Model Runner

- Oficjalny blog wprowadzający Docker Model Runner

Ollama

Inne rozwiązania Dockera

- Dokumentacja vLLM

- Text Generation Inference z Hugging Face

- Repozytorium GitHub llama.cpp

- NVIDIA Container Toolkit