다른 위치로 Ollama 모델 이동

Ollama LLM 모델 파일은 많은 저장 공간을 차지합니다.

ollama 설치 후에는 즉시 ollama를 재구성하여 새 위치에 저장하는 것이 좋습니다.

이렇게 하면 새 모델을 끌어다 놓을 때 이전 위치에 다운로드되지 않습니다.

Ollama 소개

Ollama는 LLM AI 모델에 대한 텍스트 기반 프론트엔드이자, 이러한 모델을 호스팅할 수 있는 API입니다.

Ollama 설치

https://ollama.com/download로 이동하세요.

Linux에서 Ollama를 설치하려면 다음 명령어를 사용하세요:

curl -fsSL https://ollama.com/install.sh | sh

Windows용 Ollama는 이 페이지에서 다운로드할 수 있습니다: https://ollama.com/download/windows

Mac용 Ollama는 여기에도 있습니다: https://ollama.com/download/macOllamaSetup.exe

Ollama 모델 다운로드, 목록 확인 및 삭제

일부 Ollama 모델을 다운로드하려면:

Ollama 라이브러리(https://ollama.com/library)로 이동하여 필요한 모델을 찾고,

여기서 모델 태그와 크기를 확인할 수도 있습니다.

그 후 다음 명령어를 실행하세요:

ollama pull gemma2:latest

# 또는 16GB VRAM에 잘 맞는 약간 더 똑똑한 모델도 사용할 수 있습니다:

ollama pull gemma2:27b-instruct-q3_K_S

# 또는:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

로컬 저장소에 있는 Ollama 모델을 확인하려면:

ollama list

필요 없는 모델을 삭제하려면:

ollama rm qwen2:7b-instruct-q8_0 # 예시

Ollama 모델 위치

기본적으로 모델 파일은 다음 위치에 저장됩니다:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

Windows에서 Ollama 모델 경로 설정

Windows에서 환경 변수를 생성하려면 다음 단계를 따르세요:

- Windows 설정을 열고,

- 시스템으로 이동한 후,

- ‘에 대한 정보’를 선택하고,

- ‘고급 시스템 설정’을 클릭합니다.

- ‘고급’ 탭으로 이동한 후,

- ‘환경 변수…‘를 선택합니다.

- ‘새로 만들기…‘를 클릭하고,

- 모델을 저장할 위치를 가리키는 OLLAMA_MODELS라는 변수를 생성합니다.

Linux에서 Ollama 모델 이동

ollama systemd 서비스 매개변수를 편집하세요:

sudo systemctl edit ollama.service

또는

sudo xed /etc/systemd/system/ollama.service

이렇게 하면 편집기가 열립니다.

각 환경 변수에 대해 [Service] 섹션 아래에 줄을 추가하세요:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

저장하고 나옵니다.

사용자 및 그룹 매개변수도 존재하며, 이 폴더에 접근할 수 있어야 합니다.

systemd를 다시 로드하고 Ollama를 재시작하세요:

sudo systemctl daemon-reload

sudo systemctl restart ollama

문제가 발생했다면:

systemctl status ollama.service

sudo journalctl -u ollama.service

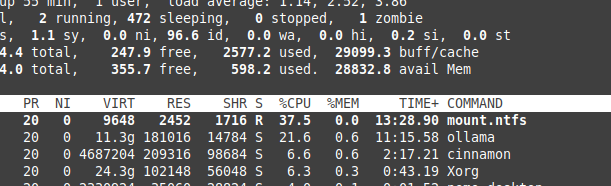

NTFS 오버헤드로 인한 파일 저장

Linux에서 실행 중이며 NTFS 포맷 파티션에 모델을 저장하는 경우,

모델 로딩 속도가 20% 이상 느려질 수 있다는 점을 주의하세요.

Windows에서 특정 폴더에 Ollama 설치

모델과 함께 설치할 경우:

.\OllamaSetup.exe /DIR=D:\OllamaDir

내부 네트워크에 Ollama API 노출

내부 네트워크는 로컬 네트워크를 의미합니다.

서비스 구성에 다음을 추가하세요:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"