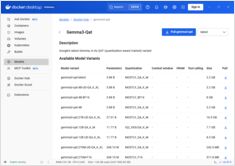

Docker Model Runner Guía Rápida: Comandos y Ejemplos

Referencia rápida para comandos de Docker Model Runner

Docker Model Runner (DMR) es la solución oficial de Docker para ejecutar modelos de IA localmente, introducida en abril de 2025. Esta guía rápida proporciona una referencia rápida para todos los comandos esenciales, configuraciones y mejores prácticas.