Farfalle vs Perplexica

Porównanie dwóch samodzielnie hostowanych silników wyszukiwania AI

Świetna jedzenie to przyjemność dla oczu również. Ale w tym poście porównamy dwa systemy wyszukiwania oparte na AI, Farfalle i Perplexica.

Porównanie dwóch samodzielnie hostowanych silników wyszukiwania AI

Świetna jedzenie to przyjemność dla oczu również. Ale w tym poście porównamy dwa systemy wyszukiwania oparte na AI, Farfalle i Perplexica.

Jaki język należy użyć dla AWS Lambda?

Możemy napisać funkcję lambda do wdrażania na AWS w kilku językach. Porównajmy wydajność (prawie pustych) funkcji napisanych w JavaScript, Pythonie i Golang…

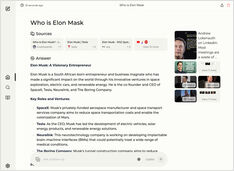

Uruchamianie lokalnego usługi w stylu Copilot? Łatwe!

To bardzo ekscytujące! Zamiast wołać copilot lub perplexity.ai i opowiadać światu, czego szukasz, teraz możesz uruchomić podobną usługę na własnym komputerze lub laptopie!

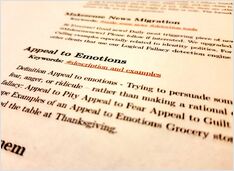

Testowanie wykrywania błędnego rozumowania

Niedawno widzieliśmy kilka nowych LLM, które zostały wydane. Wspaniałe czasy. Sprawdźmy i zobaczmy, jak działają, gdy wykrywają błędy logiczne.

Nieco mniej do wyboru, ale nadal...

Kiedy zacząłem eksperymentować z LLM, interfejsy do nich były w aktywnym rozwoju, a teraz niektóre z nich są naprawdę dobre.

Wymaga pewnego doświadczenia, ale

Nadal istnieją pewne powszechne podejścia do pisania dobrych promptów, dzięki czemu LLM nie będzie się pogubił, próbując zrozumieć, czego od niego oczekujesz.

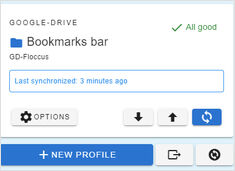

Synchronizacja zakładek między laptopami i przeglądarkami?

Wypróbowałem różne narzędzia i dołączyłem do wniosku, że najbardziej lubię floccus.

Często potrzebne fragmenty kodu w Pythonie

Czasami potrzebuję tego, ale nie mogę od razu znaleźć.

Więc trzymam je wszystkie tutaj.

Etykietowanie i trening wymaga pewnego stopnia łączenia

Kiedyś treningowałem detektor AI obiektów – LabelImg był bardzo pomocnym narzędziem, ale eksport z Label Studio do formatu COCO nie był akceptowany przez framework MMDetection..

8 wersji llama3 (Meta+) i 5 wersji phi3 (Microsoft) LLM

Testowanie działania modeli o różnej liczbie parametrów i stopniu kwantyzacji.

Pliki modeli LLM Ollama zajmują dużo miejsca.

Po zainstalowaniu ollama lepiej jest natychmiast skonfigurować Ollama, aby przechowywać je w nowym miejscu. Wtedy, gdy pobieramy nowy model, nie zostaje on pobrany do starego lokalizacji.

Jest tak frustrujące, że trzeba patrzeć na wszystkie te reklamy.

Możesz zainstalować wtyczkę lub dodatek do blokowania reklam w przeglądarce dla Google Chrome, Firefox lub Safari, ale musisz to zrobić na każdym urządzeniu.

Moje ulubione rozwiązanie to blokada reklam w sieci.

Bardzo częsty komunikat o błędzie...

Po sklonowaniu repozytorium git, skonfiguruj lokalne repozytorium, szczególnie ustaw nazwę użytkownika i adres e-mail.

Hugo to generator statycznych stron internetowych

Gdy strona zostanie wygenerowana za pomocą hugo, czas na wdrożenie jej na jakimś platformie hostingowej. Oto jak przesłać ją do AWS S3 i udostępnić za pomocą AWS CloudFront CDN.

Sprawdźmy prędkość LLM na GPU vs CPU

Porównanie prędkości przewidywania kilku wersji modeli językowych (LLM): llama3 (Meta/Facebook), phi3 (Microsoft), gemma (Google), mistral (open source) na procesorze (CPU) i karcie graficznej (GPU).

Sprawdźmy jakość wykrywania błędów logicznych przez różne LLM-y

Oto porównanie kilku wersji LLM: Llama3 (Meta), Phi3 (Microsoft), Gemma (Google), Mistral Nemo (Mistral AI) oraz Qwen (Alibaba).