Embedding multimodali: collegare le modalità dell'AI

Unificare testo, immagini e audio in spazi di embedding condivisi

Embeddingi cross-modal rappresentano un passo avanti significativo nell’intelligenza artificiale, consentendo di comprendere e ragionare su diversi tipi di dati all’interno di uno spazio di rappresentazione unificato.

Questa tecnologia alimenta le moderne applicazioni multimediali, dall’immagine di ricerca alla generazione di contenuti.

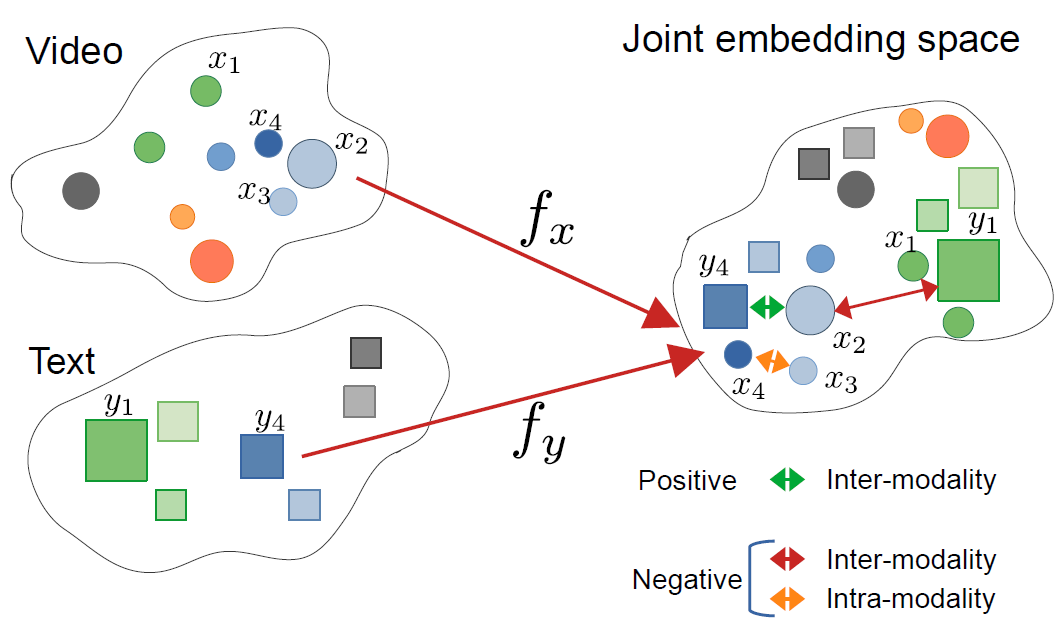

Quest’immagine proviene dall’articolo:

CrossCLR: cross-modal contrastive learning for multi-modal video representations, by Mohammadreza Zolfaghari and others

Quest’immagine proviene dall’articolo:

CrossCLR: cross-modal contrastive learning for multi-modal video representations, by Mohammadreza Zolfaghari and others

Comprendere gli Embeddingi Cross-Modal

Gli embeddingi cross-modal sono rappresentazioni vettoriali che codificano informazioni da diverse modalità—come testo, immagini, audio e video—nello stesso spazio di embedding. A differenza degli embedding tradizionali a singola modalità, gli approcci cross-modal imparano una rappresentazione unificata in cui i concetti semanticamente simili si raggruppano insieme, indipendentemente dal loro formato originale.

Cosa sono gli embeddingi cross-modal?

Al loro interno, gli embeddingi cross-modal risolvono una sfida critica nell’AI: come confrontare e relazionare informazioni tra diversi tipi di dati. Un classificatore tradizionale delle immagini può lavorare solo con immagini, mentre un modello del testo gestisce solo il testo. Gli embeddingi cross-modal colmano questo gap proiettando diverse modalità in uno spazio vettoriale comune in cui:

- Un’immagine di un gatto e la parola “gatto” hanno vettori di embedding simili

- Le relazioni semantiche vengono preservate tra le modalità

- Le metriche di distanza (similarità coseno, distanza euclidea) misurano la similarità cross-modal

Questa rappresentazione unificata abilita capacità potenti come la ricerca di immagini tramite query di testo, la generazione di didascalie da immagini o persino la classificazione senza addestramento specifico del compito.

L’architettura alle spalle dell’apprendimento cross-modal

I sistemi cross-modal moderni utilizzano tipicamente architetture a encoder doppio con obiettivi di apprendimento contrastivo:

Encoder Doppio: Reti neurali separate che codificano ciascuna modalità. Per esempio, CLIP utilizza:

- Un vision transformer (ViT) o ResNet per le immagini

- Un encoder basato su transformer per il linguaggio

Apprendimento Contrastivo: Il modello impara massimizzando la similarità tra coppie corrispondenti (es. immagine e sua didascalia) e minimizzando la similarità tra coppie non corrispondenti. La funzione di perdita contrastiva può essere espressa come:

$$ \mathcal{L} = -\log \frac{\exp(\text{sim}(v_i, t_i) / \tau)}{\sum_{j=1}^{N} \exp(\text{sim}(v_i, t_j) / \tau)} $$

dove $v_i$ è l’embedding dell’immagine, $t_i$ è l’embedding del testo, $\text{sim}$ è la similarità (tipicamente coseno) e $\tau$ è un parametro di temperatura.

Tecnologie e Modelli Chiave

CLIP: Pionierista nell’Comprensione Visione-Linguaggio

CLIP (Contrastive Language-Image Pre-training) di OpenAI ha rivoluzionato il campo addestrandosi su 400 milioni di coppie immagine-testo dal web. L’architettura del modello consiste di:

import torch

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

# Carica il modello CLIP pre-addestrato

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# Prepara gli input

image = Image.open("example.jpg")

texts = ["una foto di un gatto", "una foto di un cane", "una foto di un uccello"]

# Processa e ottieni gli embedding

inputs = processor(text=texts, images=image, return_tensors="pt", padding=True)

# Ottieni le valutazioni di similarità cross-modal

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = logits_per_image.softmax(dim=1)

print(f"Probabilità: {probs}")

L’innovazione chiave di CLIP è stata la scala e la semplicità. Addestrandosi su dati a grande scala del web senza annotazioni manuali, ha raggiunto capacità notevoli di trasferimento zero-shot. Come differisce CLIP da modelli visione tradizionali? A differenza di classificatori supervisionati addestrati su insiemi fissi di etichette, CLIP impara da supervisione linguistica naturale, rendendolo adattabile a qualsiasi concetto visivo descrivibile in testo.

ImageBind: Estensione a Sei Modalità

ImageBind di Meta estende gli embeddingi cross-modal oltre la visione e il linguaggio per includere:

- Audio (suoni ambientali, parlato)

- Informazioni di profondità

- Immagini termiche

- Dati IMU (sensore di movimento)

Questo crea uno spazio di embedding veramente multimodale in cui tutte e sei le modalità sono allineate. L’idea chiave è che le immagini servono come una “modalità di binding”—accoppiando immagini ad altre modalità e sfruttando l’esistente allineamento visione-linguaggio, ImageBind crea uno spazio unificato senza richiedere tutte le possibili coppie di modalità durante l’addestramento.

Alternative Open-Source

L’ecosistema si è espanso con diverse implementazioni open-source:

OpenCLIP: Un’implementazione della comunità che offre modelli più grandi e ricette di addestramento diverse:

import open_clip

model, _, preprocess = open_clip.create_model_and_transforms(

'ViT-L-14',

pretrained='laion2b_s32b_b82k'

)

tokenizer = open_clip.get_tokenizer('ViT-L-14')

Modelli LAION-5B: Addestrati sul vasto dataset open-source LAION-5B, offrono alternative ai modelli proprietari con prestazioni paragonabili o migliori.

Per gli sviluppatori interessati a soluzioni open-source di alto livello per gli embeddingi di testo, i modelli Qwen3 Embedding & Reranker su Ollama offrono eccellenti prestazioni multilingue con un deployment locale semplice.

Strategie di Implementazione

Costruire un Motore di Ricerca Cross-Modal

Un’implementazione pratica degli embeddingi cross-modal per la ricerca semantica coinvolge diversi componenti. Quali sono le principali applicazioni degli embeddingi cross-modal? Sono alla base di casi d’uso che vanno dalla ricerca di prodotti e-commerce alla moderazione del contenuto e agli strumenti creativi.

import numpy as np

from typing import List, Tuple

import faiss

from transformers import CLIPModel, CLIPProcessor

class CrossModalSearchEngine:

def __init__(self, model_name: str = "openai/clip-vit-base-patch32"):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.image_index = None

self.image_metadata = []

def encode_images(self, images: List) -> np.ndarray:

"""Codifica le immagini in embedding"""

inputs = self.processor(images=images, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_image_features(**inputs)

return embeddings.cpu().numpy()

def encode_text(self, texts: List[str]) -> np.ndarray:

"""Codifica le query di testo in embedding"""

inputs = self.processor(text=texts, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_text_features(**inputs)

return embeddings.cpu().numpy()

def build_index(self, image_embeddings: np.ndarray):

"""Costruisci un indice FAISS per una ricerca efficiente di similarità"""

dimension = image_embeddings.shape[1]

# Normalizza gli embedding per la similarità coseno

faiss.normalize_L2(image_embeddings)

# Crea l'indice (usando HNSW per grandi deployment)

self.image_index = faiss.IndexHNSWFlat(dimension, 32)

self.image_index.hnsw.efConstruction = 40

self.image_index.add(image_embeddings)

def search(self, query: str, k: int = 10) -> List[Tuple[int, float]]:

"""Cerca immagini utilizzando una query di testo"""

query_embedding = self.encode_text([query])

faiss.normalize_L2(query_embedding)

distances, indices = self.image_index.search(query_embedding, k)

return list(zip(indices[0], distances[0]))

# Esempio di utilizzo

engine = CrossModalSearchEngine()

# Costruisci l'indice da una raccolta di immagini

image_embeddings = engine.encode_images(image_collection)

engine.build_index(image_embeddings)

# Cerca con testo

results = engine.search("tramonto sulle montagne", k=5)

Fine-Tuning per Compiti Specifici del Dominio

Sebbene i modelli pre-addestrati funzionino bene per scopi generali, le applicazioni specifiche del dominio traggono vantaggio dal fine-tuning:

from transformers import CLIPModel, CLIPProcessor, AdamW

import torch.nn as nn

class FineTuneCLIP:

def __init__(self, model_name: str, num_epochs: int = 10):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.num_epochs = num_epochs

def contrastive_loss(self, image_embeddings, text_embeddings, temperature=0.07):

"""Calcola la perdita contrastiva InfoNCE"""

# Normalizza gli embedding

image_embeddings = nn.functional.normalize(image_embeddings, dim=1)

text_embeddings = nn.functional.normalize(text_embeddings, dim=1)

# Calcola la matrice di similarità

logits = torch.matmul(image_embeddings, text_embeddings.T) / temperature

# Le etichette sono diagonali (coppie corrispondenti)

labels = torch.arange(len(logits), device=logits.device)

# Perdita simmetrica

loss_i = nn.functional.cross_entropy(logits, labels)

loss_t = nn.functional.cross_entropy(logits.T, labels)

return (loss_i + loss_t) / 2

def train(self, dataloader, learning_rate=5e-6):

"""Fine-tuning su dati specifici del dominio"""

optimizer = AdamW(self.model.parameters(), lr=learning_rate)

self.model.train()

for epoch in range(self.num_epochs):

total_loss = 0

for batch in dataloader:

images, texts = batch['images'], batch['texts']

# Processa gli input

inputs = self.processor(

text=texts,

images=images,

return_tensors="pt",

padding=True

)

# Passo in avanti

outputs = self.model(**inputs, return_loss=True)

loss = outputs.loss

# Passo indietro

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"Epoca {epoch+1}/{self.num_epochs}, Perdita: {avg_loss:.4f}")

Considerazioni per il Deployment in Produzione

Ottimizzazione delle Prestazioni di Inference

Come posso ottimizzare gli embeddingi cross-modal per la produzione? L’ottimizzazione delle prestazioni è critica per il deployment reale:

Quantizzazione del Modello: Ridurre la dimensione del modello e aumentare la velocità di inference:

import torch

from torch.quantization import quantize_dynamic

# Quantizzazione dinamica per l'inference su CPU

quantized_model = quantize_dynamic(

model,

{torch.nn.Linear},

dtype=torch.qint8

)

Conversione in ONNX: Esporta in ONNX per un’ottimizzazione dell’inference:

import torch.onnx

dummy_input = processor(text=["esempio"], return_tensors="pt")

torch.onnx.export(

model,

tuple(dummy_input.values()),

"clip_model.onnx",

input_names=['input_ids', 'attention_mask'],

output_names=['output'],

dynamic_axes={

'input_ids': {0: 'batch_size'},

'attention_mask': {0: 'batch_size'}

}

)

Elaborazione in Batch: Massimizza l’utilizzo della GPU tramite l’elaborazione in batch:

def batch_encode(items: List, batch_size: int = 32):

"""Processa gli elementi in batch per efficienza"""

embeddings = []

for i in range(0, len(items), batch_size):

batch = items[i:i+batch_size]

batch_embeddings = encode_batch(batch)

embeddings.append(batch_embeddings)

return np.concatenate(embeddings, axis=0)

Archiviazione Vettoriale Scalabile

Per le applicazioni su larga scala, i database vettoriali sono essenziali. Quali framework supportano le implementazioni degli embeddingi cross-modal? Oltre ai modelli stessi, l’infrastruttura è importante:

FAISS (Facebook AI Similarity Search): Libreria efficiente per la ricerca di similarità

- Supporta miliardi di vettori

- Diversi tipi di indici (flat, IVF, HNSW)

- Accelerazione GPU disponibile

Milvus: Database vettoriale open-source

from pymilvus import connections, Collection, FieldSchema, CollectionSchema, DataType

# Definisci lo schema

fields = [

FieldSchema(name="id", dtype=DataType.INT64, is_primary=True, auto_id=True),

FieldSchema(name="embedding", dtype=DataType.FLOAT_VECTOR, dim=512),

FieldSchema(name="metadata", dtype=DataType.JSON)

]

schema = CollectionSchema(fields, description="Embeddingi delle immagini")

# Crea la raccolta

collection = Collection("immagini", schema)

# Crea l'indice

index_params = {

"metric_type": "IP", # Prodotto interno (similarità coseno)

"index_type": "IVF_FLAT",

"params": {"nlist": 1024}

}

collection.create_index("embedding", index_params)

Pinecone/Weaviate: Servizi di database vettoriale gestiti che offrono scalabilità e manutenzione semplice.

Utilizzi Avanzati e Applicazioni

Classificazione Zero-Shot

Gli embeddingi cross-modal abilitano la classificazione senza addestramento specifico del compito. Questa capacità si estende oltre gli approcci tradizionali di visione computerizzata—per esempio, se sei interessato a una soluzione più specializzata rilevamento oggetti con TensorFlow, rappresenta un approccio di apprendimento supervisionato complementare per compiti specifici di rilevamento.

def zero_shot_classify(image, candidate_labels: List[str], model, processor):

"""Classifica un'immagine in categorie arbitrarie"""

# Crea prompt di testo

text_inputs = [f"una foto di un {label}" for label in candidate_labels]

# Ottieni gli embedding

inputs = processor(

text=text_inputs,

images=image,

return_tensors="pt",

padding=True

)

outputs = model(**inputs)

# Calcola le probabilità

logits = outputs.logits_per_image

probs = logits.softmax(dim=1)

# Restituisce le previsioni ordinate

sorted_indices = probs.argsort(descending=True)[0]

return [(candidate_labels[idx], probs[0][idx].item()) for idx in sorted_indices]

# Esempio di utilizzo

labels = ["gatto", "cane", "uccello", "pesce", "cavallo"]

predictions = zero_shot_classify(image, labels, model, processor)

print(f"Prima previsione: {predictions[0]}")

RAG Multimodale (Retrieval-Augmented Generation)

Combinando gli embeddingi cross-modal con i modelli linguistici si creano potenti sistemi RAG multimodali. Una volta che hai recuperato documenti rilevanti, riconordinamento con modelli di embedding può migliorare notevolmente la qualità dei risultati riordinando i candidati recuperati in base alla rilevanza:

class MultimodalRAG:

def __init__(self, clip_model, llm_model):

self.clip = clip_model

self.llm = llm_model

self.knowledge_base = []

def add_documents(self, images, texts, metadata):

"""Aggiungi documenti multimodali alla knowledge base"""

image_embeds = self.clip.encode_images(images)

text_embeds = self.clip.encode_text(texts)

# Memorizza l'informazione combinata

for i, (img_emb, txt_emb, meta) in enumerate(

zip(image_embeds, text_embeds, metadata)

):

self.knowledge_base.append({

'image_embedding': img_emb,

'text_embedding': txt_emb,

'metadata': meta,

'index': i

})

def retrieve(self, query: str, k: int = 5):

"""Recupera contenuti multimodali rilevanti"""

query_embedding = self.clip.encode_text([query])[0]

# Calcola le similarità

similarities = []

for doc in self.knowledge_base:

# Media delle similarità tra le modalità

img_sim = np.dot(query_embedding, doc['image_embedding'])

txt_sim = np.dot(query_embedding, doc['text_embedding'])

combined_sim = (img_sim + txt_sim) / 2

similarities.append((combined_sim, doc))

# Restituisce i primi k

similarities.sort(reverse=True)

return [doc for _, doc in similarities[:k]]

def answer_query(self, query: str):

"""Rispondi a una query utilizzando il contesto recuperato"""

retrieved_docs = self.retrieve(query)

# Costruisci il contesto dai documenti recuperati

context = "\n".join([doc['metadata']['text'] for doc in retrieved_docs])

# Genera la risposta con LLM

prompt = f"Contesto:\n{context}\n\nDomanda: {query}\n\nRisposta:"

answer = self.llm.generate(prompt)

return answer, retrieved_docs

Se stai implementando sistemi RAG in produzione in Go, potresti trovare utile questa guida su riconordinamento di documenti testuali con Ollama e modello Qwen3 Embedding in Go per ottimizzare la qualità del recupero.

Moderazione del Contenuto e Sicurezza

Gli embeddingi cross-modal eccellono nel rilevare contenuti inappropriati tra le modalità:

class ContentModerator:

def __init__(self, model, processor):

self.model = model

self.processor = processor

# Definisci le categorie di sicurezza

self.unsafe_categories = [

"contenuto violento",

"contenuto adulto",

"immagini offensive",

"violenza grafica",

"materiale esplicito"

]

self.safe_categories = [

"sicuro per il lavoro",

"adatto per tutta la famiglia",

"contenuto educativo"

]

def moderate_image(self, image, threshold: float = 0.3):

"""Verifica se un'immagine contiene contenuti non sicuri"""

# Combina tutte le categorie

all_categories = self.unsafe_categories + self.safe_categories

text_inputs = [f"immagine contenente {cat}" for cat in all_categories]

# Ottieni le previsioni

inputs = self.processor(

text=text_inputs,

images=image,

return_tensors="pt"

)

outputs = self.model(**inputs)

probs = outputs.logits_per_image.softmax(dim=1)[0]

# Verifica le categorie non sicure

unsafe_scores = probs[:len(self.unsafe_categories)]

max_unsafe_score = unsafe_scores.max().item()

return {

'is_safe': max_unsafe_score < threshold,

'confidence': 1 - max_unsafe_score,

'flagged_categories': [

self.unsafe_categories[i]

for i, score in enumerate(unsafe_scores)

if score > threshold

]

}

Linee Guida e Errori Comuni

Preprocessing dei Dati

Un corretto preprocessing è cruciale per le prestazioni ottimali:

from torchvision import transforms

# Preprocessing standard di CLIP

clip_transform = transforms.Compose([

transforms.Resize(224, interpolation=transforms.InterpolationMode.BICUBIC),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(

mean=[0.48145466, 0.4578275, 0.40821073],

std=[0.26862954, 0.26130258, 0.27577711]

)

])

Gestione del Bias e della Giustizia

I modelli cross-modal possono ereditare bias dai dati di addestramento:

Strategie di mitigazione:

- Valuta su gruppi demografici diversi

- Usa tecniche di debiasing durante il fine-tuning

- Implementa un recupero sensibile alla giustizia

- Audit e monitoraggio regolari in produzione

Valutazione della Qualità degli Embedding

Monitora la qualità degli embedding in produzione:

def assess_embedding_quality(embeddings: np.ndarray):

"""Calcola metriche per la qualità degli embedding"""

# Calcola la distanza media tra coppie

distances = np.linalg.norm(

embeddings[:, None] - embeddings[None, :],

axis=2

)

avg_distance = distances.mean()

# Controlla il clustering (bassa distanza intra-clusters)

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=10)

labels = kmeans.fit_predict(embeddings)

# Calcola il punteggio silhouette

from sklearn.metrics import silhouette_score

score = silhouette_score(embeddings, labels)

return {

'avg_pairwise_distance': avg_distance,

'silhouette_score': score

}

Esempio di Deployment con Docker

Pacchetta la tua applicazione cross-modal per un deployment facile:

FROM nvidia/cuda:11.8.0-cudnn8-runtime-ubuntu22.04

# Installa Python e dipendenze

RUN apt-get update && apt-get install -y python3-pip

WORKDIR /app

# Installa le richieste

COPY requirements.txt .

RUN pip3 install --no-cache-dir -r requirements.txt

# Copia il codice dell'applicazione

COPY . .

# Espone la porta API

EXPOSE 8000

# Esegui il server API

CMD ["uvicorn", "api:app", "--host", "0.0.0.0", "--port", "8000"]

# api.py - Server FastAPI per gli embeddingi cross-modal

from fastapi import FastAPI, File, UploadFile

from pydantic import BaseModel

import torch

from PIL import Image

import io

app = FastAPI()

# Carica il modello all'avvio

@app.on_event("startup")

async def load_model():

global model, processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

if torch.cuda.is_available():

model = model.cuda()

class TextQuery(BaseModel):

text: str

@app.post("/embed/text")

async def embed_text(query: TextQuery):

inputs = processor(text=[query.text], return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_text_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/embed/image")

async def embed_image(file: UploadFile = File(...)):

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(images=image, return_tensors="pt")

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_image_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/similarity")

async def compute_similarity(

text: TextQuery,

file: UploadFile = File(...)

):

# Ottieni entrambi gli embedding

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(text=[text.text], images=image, return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

outputs = model(**inputs)

similarity = outputs.logits_per_image[0][0].item()

return {"similarità": similarity}

Direzioni Future

Il campo degli embeddingi cross-modal continua a evolversi rapidamente:

Copertura Modale Più Ampia: I modelli futuri incorporeranno probabilmente altre modalità come il tatto (feedback tattile), l’odore e il sapore per una comprensione multimodale veramente completa.

Miglior Efficienza: La ricerca su distillazione e architetture efficienti renderà i potenti modelli cross-modal accessibili su dispositivi edge.

Migliore Allineamento: Tecniche avanzate per allineare le modalità in modo più preciso, inclusi i loss di coerenza ciclica e l’addestramento avversariale.

Comprensione Compositiva: Passare oltre la semplice riconoscimento oggetti per comprendere relazioni complesse e composizioni tra le modalità.

Modellazione Temporale: Un migliore trattamento di video e dati a serie temporale con ragionamento temporale esplicito negli spazi di embedding.

Link Utili

- Repository CLIP di OpenAI

- OpenCLIP: Implementazione Open Source

- Documentazione Transformers di Hugging Face

- ImageBind di Meta

- Dataset LAION-5B

- Documentazione FAISS

- Database Vettoriale Milvus

- Database Vettoriale Pinecone

- Paper: Learning Transferable Visual Models From Natural Language Supervision

- Paper: ImageBind: One Embedding Space To Bind Them All

- Rilevamento oggetti con TensorFlow

- Riconordinamento con modelli di embedding

- Riconordinamento di documenti testuali con Ollama e modello Qwen3 Embedding - in Go

- Modelli Qwen3 Embedding & Reranker su Ollama: Prestazioni di Alto Livello

Gli embeddingi cross-modal rappresentano un cambiamento di paradigma su come i sistemi AI elaborano e comprendono le informazioni. Distruggendo le barriere tra diversi tipi di dati, queste tecniche abilitano applicazioni AI più naturali e capaci. Che tu stia costruendo sistemi di ricerca, strumenti di moderazione del contenuto o applicazioni creative, padroneggiare gli embeddingi cross-modal apre un mondo di possibilità per l’innovazione nell’AI multimodale.