Interfacce utente chat per istanze locali di Ollama

Panoramica rapida delle interfacce utente più rilevanti per Ollama nel 2025

Ollama ospitato localmente permette di eseguire modelli linguistici di grandi dimensioni sulla propria macchina, ma utilizzarlo tramite riga di comando non è molto user-friendly. Ecco alcuni progetti open-source che offrono interfacce stile ChatGPT che si collegano a un Ollama locale.

Queste interfacce supportano chat conversazionale, spesso con funzionalità come caricamento di documenti per la generazione aumentata da recupero (RAG), e funzionano come applicazioni web o desktop. Di seguito è riportato un confronto delle principali opzioni, seguito da sezioni dettagliate su ciascuna.

Confronto tra Interfacce Compatibili con Ollama

| Strumento UI | Piattaforma | Supporto Documenti | Integrazione con Ollama | Punti di forza | Limitazioni |

|---|---|---|---|---|---|

| Page Assist | Estensione del browser (Chrome, Firefox) | Sì – aggiungi file per l’analisi | Si collega a Ollama locale tramite configurazione dell’estensione | Chat nel browser; gestione semplice dei modelli e integrazione con il contesto della pagina web. | Solo per browser; richiede l’installazione/configurazione di un’estensione. |

| Open WebUI | Applicazione web (self-hosted; Docker/PWA) | Sì – RAG integrato (carica documenti o aggiungili alla libreria) | Supporto diretto API Ollama o server bundle (configura URL di base) | Ricca di funzionalità (multi-LLM, offline, generazione immagini); compatibile con dispositivi mobili (PWA). | Configurazione più pesante (Docker/K8s); ampio ambito può essere eccessivo per un uso semplice. |

| LobeChat | Applicazione web (self-hosted; supporto PWA) | Sì – “Base di Conoscenza” con caricamento file (PDF, immagini, ecc.) | Supporta Ollama come uno dei vari backend AI (richiede l’attivazione dell’accesso API di Ollama) | Interfaccia simile a ChatGPT; chat vocale, plugin e supporto multi-modello. | Set di funzionalità complesso; richiede configurazione ambientale (ad esempio, cross-origin per Ollama). |

| LibreChat | Applicazione web (self-hosted; multi-utente) | Sì – “Chatta con i File” utilizzando RAG (tramite embedding) | Compatibile con Ollama e molti altri fornitori (intercambiabili per chat) | Interfaccia familiare stile ChatGPT; funzionalità ricche (agenti, interprete di codice, ecc.). | Installazione/configurazione può essere complessa; il progetto potrebbe essere più grande del necessario per un uso base. |

| AnythingLLM | Applicazione desktop (Windows, Mac, Linux) o web (Docker) | Sì – RAG integrato: trascinamento e rilascio di documenti (PDF, DOCX, ecc.) con citazioni | Ollama supportato come fornitore LLM (impostato in configurazione o ambiente Docker) | UI tutto-in-uno (ChatGPT privato con i tuoi documenti); costruttore di agenti senza codice, supporto multi-utente. | Uso maggiore delle risorse (database embedding, ecc.); l’applicazione desktop manca di alcune funzionalità multi-utente. |

| Chat-with-Notes | Applicazione web (server Flask leggero) | Sì – carica file di testo/PDF e chatta con il loro contenuto | Utilizza Ollama per tutte le risposte AI (richiede Ollama in esecuzione locale) | Configurazione e interfaccia molto semplici, focalizzate su domande e risposte sui documenti; i dati rimangono locali. | Interfaccia e funzionalità di base; singolo utente, un documento alla volta (nessuna funzione avanzata). |

Ogni uno di questi strumenti è attivamente mantenuto ed open-source. Successivamente, approfondiamo nei dettagli di ogni opzione, inclusa la loro interazione con Ollama, le funzionalità notevoli e i compromessi.

Page Assist (Estensione del Browser)

Page Assist è un’estensione del browser open-source che porta la chat LLM locale nel tuo browser. Supporta browser basati su Chromium e Firefox, offrendo una barra laterale o scheda simile a ChatGPT dove puoi conversare con un modello. Page Assist può collegarsi a Ollama in esecuzione localmente come fornitore di intelligenza artificiale, o altri backend locali, tramite le sue impostazioni. In particolare, ti permette di aggiungere file (ad esempio PDF o testo) per l’analisi da parte dell’AI all’interno della chat, abilitando flussi di lavoro RAG di base. Puoi anche farla assistere con il contenuto della pagina web corrente o eseguire ricerche sul web per informazioni.

La configurazione è semplice: installa l’estensione dal Chrome Web Store o Firefox Add-ons, assicurati che Ollama sia in esecuzione e seleziona Ollama come fornitore di intelligenza artificiale locale nelle impostazioni di Page Assist. L’interfaccia include funzionalità come la cronologia delle chat, la selezione del modello e un URL condivisibile opzionale per i risultati della chat. Un’interfaccia web è anche disponibile tramite una scorciatoia da tastiera se preferisci un’esperienza di chat a schermo intero.

Punti di forza: Page Assist è leggero e conveniente – poiché risiede nel browser, non c’è un server separato da eseguire. È ottimo per contesti di navigazione (puoi aprirlo su qualsiasi pagina web) e supporta l’integrazione della ricerca su internet e degli allegati di file per arricchire la conversazione. Fornisce anche funzionalità utili come scorciatoie da tastiera per nuove chat e attivazione/disattivazione della barra laterale.

Limitazioni: Essendo un’estensione, è limitata all’ambiente del browser. L’interfaccia è più semplice e leggermente meno ricca di funzionalità rispetto alle app di chat autonome complete. Ad esempio, la gestione multi-utente o i plugin avanzati per agenti non sono nel campo di applicazione. Inoltre, la configurazione iniziale potrebbe richiedere la costruzione/caricamento dell’estensione se una versione preconfezionata non è disponibile per il tuo browser (il progetto fornisce istruzioni di build utilizzando Bun o npm). In generale, Page Assist è ideale per l’uso individuale quando si desidera un accesso rapido alla chat potenziata da Ollama durante la navigazione web, con capacità RAG moderate.

Open WebUI (Applicazione Web Self-Hosted)

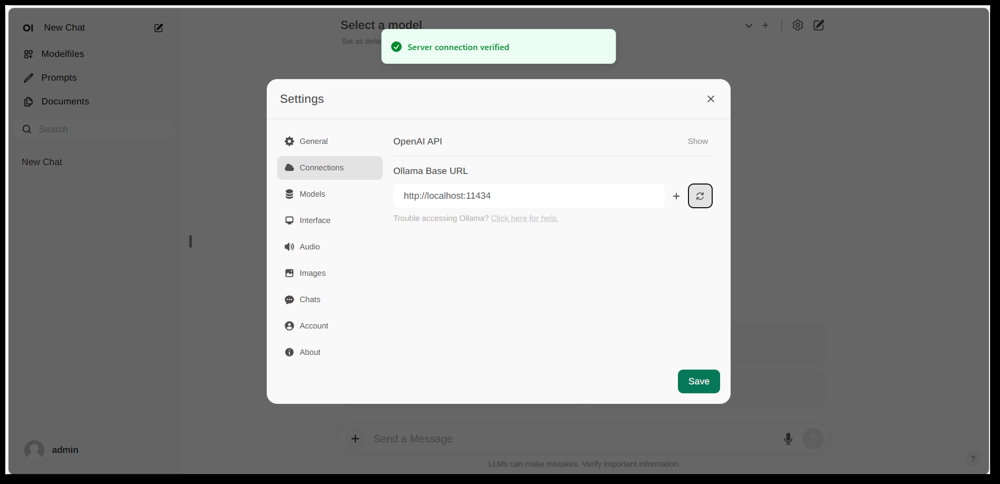

L’interfaccia delle impostazioni di Open WebUI che mostra una connessione Ollama configurata (URL di base impostato sull’API locale di Ollama). L’UI include una sezione Documenti, abilitando flussi di lavoro RAG.

Open WebUI è un potente front-end di chat a scopo generale originariamente creato per funzionare con Ollama, e ora espanso per supportare vari backend LLM. Funziona come un’applicazione web self-hosted ed è tipicamente distribuita tramite Docker o Kubernetes per facilitare la configurazione. Una volta in esecuzione, vi accedi tramite il tuo browser (con supporto per l’installazione come Progressive Web App su dispositivi mobili).

Open WebUI offre una completa interfaccia di chat con supporto multi-utente, gestione dei modelli e funzionalità estese. Criticamente, ha capacità RAG integrate – puoi caricare o importare documenti in una libreria di documenti e poi fare domande con recupero aumentato. L’interfaccia permette di caricare documenti direttamente in una sessione di chat o mantenere una libreria persistente di conoscenze. Supporta anche l’esecuzione di ricerche sul web e l’iniezione dei risultati nella conversazione per informazioni aggiornate.

Integrazione con Ollama: Open WebUI si collega a Ollama tramite la sua API. Puoi eseguire il contenitore Docker di Open WebUI insieme a un server Ollama e impostare una variabile d’ambiente per puntare all’URL di Ollama, oppure utilizzare un’immagine Docker speciale che bundle Ollama con l’interfaccia web. In pratica, dopo aver avviato i container, visiterai Open WebUI nel tuo browser e vedrai “Connessione al server verificata” se configurato correttamente (come mostrato nell’immagine sopra). Questo significa che l’UI è pronta per utilizzare i tuoi modelli locali Ollama per la chat. Open WebUI supporta anche endpoint compatibili con API OpenAI, quindi può interfacciarsi con LM Studio, OpenRouter, ecc., oltre a Ollama.

Punti di forza: Questa soluzione è una delle UI più ricche di funzionalità e flessibile. Supporta più modelli e thread di conversazione simultanei, prompt di sistema o “personaggi” personalizzati, generazione di immagini e altro ancora. L’implementazione RAG è robusta – ottieni un’interfaccia completa per la gestione dei documenti e persino la configurazione del vettore store o servizio di ricerca da utilizzare per il recupero. Open WebUI è anche attivamente sviluppato (con una comunità estesa, come indicato dal suo alto numero di stelle su GitHub) e progettato per l’estensibilità e la scalabilità. È una buona scelta se desideri un’interfaccia di chat tutto-in-uno completa per modelli locali, specialmente in uno scenario con più utenti o casi d’uso complessi.

Limitazioni: Con grande potenza arriva maggiore complessità. Open WebUI può essere eccessivo per un uso personale semplice – distribuire container Docker e gestire la configurazione potrebbe essere intimidatorio se non sei familiare. Consuma più risorse rispetto a un’app leggera, poiché esegue un server web, un database opzionale per la cronologia delle chat, ecc. Inoltre, funzionalità come il controllo degli accessi basato sui ruoli e la gestione degli utenti, sebbene utili, indicano che è orientato verso una configurazione di server – un singolo utente su un PC domestico potrebbe non aver bisogno di tutto questo. In breve, la configurazione è più pesante e l’interfaccia può sembrare complessa se hai solo bisogno di un clone base di ChatGPT. Ma per coloro che hanno bisogno della sua ampiezza di funzionalità (o vogliono facilmente passare tra Ollama e altri fornitori di modelli in una singola UI), Open WebUI è un forte concorrente.

LobeChat (Framework Simile a ChatGPT con Plugin)

Banner dell’interfaccia di LobeChat che mostra “Ollama Supportato” e più modelli locali. LobeChat ti permette di distribuire un’app web stile ChatGPT utilizzando Ollama o altri fornitori, con funzionalità come input vocale e plugin.

LobeChat è un framework di chat open-source che mette l’accento su un’esperienza utente raffinata e flessibilità. È essenzialmente una applicazione web simile a ChatGPT che puoi ospitare tu stesso, con supporto per più fornitori di IA – da OpenAI e Anthropic ai modelli open via Ollama. LobeChat è progettato pensando alla privacy (lo esegui tu stesso) e ha un’interfaccia moderna che include comodità come la memoria delle conversazioni, la modalità di conversazione vocale e persino la generazione di immagini da testo tramite plugin.

Una delle caratteristiche chiave di LobeChat è la sua capacità di Knowledge Base. Puoi caricare documenti (in formati come PDF, immagini, audio, video) e creare una knowledge base che può essere consultata durante la chat. Questo significa che puoi fare domande sul contenuto dei tuoi file – un flusso di lavoro RAG che LobeChat supporta fuori dalla scatola. L’interfaccia fornisce la gestione di questi file/knowledge base e consente di attivare o disattivare il loro utilizzo nella conversazione, offrendo un’esperienza Q&A più ricca rispetto al semplice LLM.

Per utilizzare LobeChat con Ollama, distribuisci l’app LobeChat (ad esempio, tramite un’immagine Docker fornita o uno script) e configura Ollama come backend. LobeChat riconosce Ollama come fornitore di primo livello – offre persino uno script di distribuzione one-click tramite il browser Pinokio AI se lo usi. In pratica, potresti dover regolare le impostazioni di Ollama (come abilitare CORS secondo la documentazione di LobeChat) in modo che l’interfaccia web di LobeChat possa accedere all’API HTTP di Ollama. Una volta configurato, puoi scegliere un modello ospitato da Ollama nell’interfaccia utente di LobeChat e conversare con esso, inclusa la consultazione dei tuoi documenti caricati.

Punti di forza: L’interfaccia utente di LobeChat è spesso lodata per essere pulita e user-friendly, che imita molto da vicino l’aspetto e la sensazione di ChatGPT (il che può facilitare l’adozione). Aggiunge valore con extra come input/output vocale per conversazioni parlate e un sistema di plugin per estendere le funzionalità (simile ai plugin di ChatGPT, abilitando cose come la navigazione web o la generazione di immagini). Il supporto multi-modello significa che puoi facilmente passare tra, ad esempio, un modello locale Ollama e un modello API OpenAI nella stessa interfaccia. Supporta anche l’installazione come PWA compatibile con i dispositivi mobili, quindi puoi accedere alla tua chat locale in movimento.

Limitazioni: Configurare LobeChat può essere più complesso rispetto ad alcune alternative. È un’applicazione full-stack (spesso eseguita con Docker Compose), quindi c’è un po’ di overhead. In particolare, la configurazione dell’integrazione Ollama richiede l’abilitazione delle richieste cross-origin dal lato di Ollama e assicurarsi che i porti siano allineati – un compito una tantum, ma tecnico. Inoltre, sebbene LobeChat sia piuttosto potente, non tutte le funzionalità potrebbero essere necessarie per ogni utente; ad esempio, se non hai bisogno del supporto multi-fornitore o dei plugin, l’interfaccia potrebbe sembrare affollata rispetto a uno strumento minimale. Infine, alcune funzionalità avanzate come la distribuzione one-click presuppongono ambienti specifici (browser Pinokio o Vercel), che potresti o meno utilizzare. Nel complesso, LobeChat è ideale se desideri un alternativa completa a ChatGPT che si esegue localmente con Ollama e non ti dispiace un po’ di configurazione iniziale per arrivarci.

LibreChat (Clone di ChatGPT con Supporto Multi-Provider)

LibreChat (in precedenza noto come ChatGPT-Clone o UI) è un progetto open-source che mira a replicare ed estendere l’interfaccia e le funzionalità di ChatGPT. Può essere distribuito localmente (o sul tuo server) e supporta una varietà di backend IA – inclusi modelli open-source tramite Ollama. Essenzialmente, LibreChat fornisce l’esperienza di chat familiare (interfaccia di dialogo con cronologia, messaggi utente e assistente) permettendoti di collegare diversi fornitori di modelli sul backend.

LibreChat supporta interazione con documenti e RAG tramite un add-on chiamato API RAG e servizi di embedding. Nell’interfaccia, puoi utilizzare funzionalità come “Chat with Files”, che ti permette di caricare documenti e poi fare domande su di essi. Sotto il cofano, questo utilizza embeddings e un vector store per recuperare contesti rilevanti dai tuoi file. Questo significa che puoi ottenere un effetto simile a ChatGPT + conoscenza personalizzata, tutto localmente. Il progetto fornisce persino un repository separato per il servizio RAG se desideri ospitarlo tu stesso.

Utilizzare LibreChat con Ollama comporta generalmente l’esecuzione del server LibreChat (ad esempio tramite Node/Docker) e assicurarsi che possa raggiungere il servizio Ollama. LibreChat ha una impostazione “Custom Endpoint” dove puoi inserire un URL API compatibile con OpenAI. Poiché Ollama può esporre un’API locale compatibile con OpenAI, LibreChat può essere puntato su http://localhost:11434 (o dove sta ascoltando Ollama). In effetti, LibreChat elenca Ollama tra i suoi fornitori di IA supportati – insieme ad altri come OpenAI, Cohere, ecc. Una volta configurato, puoi selezionare il modello (il modello di Ollama) in un menu a discesa e iniziare a chattare. LibreChat consente anche di cambiare modelli o fornitori persino durante la conversazione e supporta più preset/contesti di chat.

Punti di forza: Il principale vantaggio di LibreChat è il ricco set di funzionalità costruite intorno all’esperienza di chat. Include cose come ramificazione delle conversazioni, ricerca dei messaggi, supporto integrato per l’Interprete di Codice (esecuzione sicura del codice in sandbox) e integrazioni strumenti/agenti. È essenzialmente ChatGPT++, con la capacità di integrare modelli locali. Per chi ama l’interfaccia utente di ChatGPT, LibreChat sembrerà molto familiare e richiede poca curva di apprendimento. Il progetto è attivo e guidato dalla comunità (come dimostrato dai suoi aggiornamenti frequenti e discussioni), ed è piuttosto flessibile: puoi connetterti a molti tipi di endpoint LLM o persino eseguirlo multi-utente con autenticazione per un ambiente di squadra.

Limitazioni: Con le sue molte funzionalità, LibreChat può essere più pesante da eseguire. L’installazione potrebbe comportare la configurazione di un database per memorizzare le chat e l’impostazione delle variabili d’ambiente per varie API. Se abiliti tutti i componenti (RAG, agenti, generazione di immagini, ecc.), è uno stack piuttosto complesso. Per un singolo utente che ha bisogno solo di una chat di base con un modello locale, LibreChat potrebbe essere più del necessario. Inoltre, l’interfaccia utente, sebbene familiare, non è altamente specializzata per il QA dei documenti – fa il lavoro ma manca di un’interfaccia dedicata alla “libreria di documenti” (i caricamenti vengono generalmente effettuati all’interno di una chat o tramite API). In breve, LibreChat brilla quando desideri un ambiente simile a ChatGPT con una gamma di funzionalità in esecuzione localmente, ma soluzioni più semplici potrebbero essere sufficienti per casi d’uso strettamente focalizzati.

AnythingLLM (App Desktop o Server Tutto-in-Uno)

AnythingLLM è un’applicazione AI tutto-in-uno che mette l’accento su RAG e facilità d’uso. Ti permette di “chattare con i tuoi documenti” utilizzando sia modelli LLMs open-source che persino i modelli di OpenAI, il tutto attraverso una singola interfaccia unificata. Notevolmente, AnythingLLM è disponibile sia come app desktop cross-platform (per Windows, Mac, Linux) che come server web self-hosted (via Docker). Questa flessibilità significa che puoi eseguirlo come un’applicazione normale sul tuo PC o distribuirlo per più utenti su un server.

La gestione dei documenti è al cuore di AnythingLLM. Puoi trascinare e rilasciare documenti (PDF, TXT, DOCX, ecc.) nell’app e verrà automaticamente indicizzato in un database vettoriale (viene fornito LanceDB per impostazione predefinita). Nell’interfaccia di chat, quando fai domande, recupererà frammenti rilevanti dai tuoi documenti e fornirà risposte citate, quindi saprai da quale file e sezione provengono le informazioni. Essenzialmente, costruisce una knowledge base privata per te e permette all’LLM di utilizzarla come contesto. Puoi organizzare i documenti in “spazi di lavoro” (ad esempio, uno spazio di lavoro per progetto o argomento), isolando i contesti quando necessario.

Utilizzare Ollama con AnythingLLM è semplice. Nella configurazione, scegli Ollama come fornitore LLM. Se esegui tramite Docker, imposti variabili d’ambiente come LLM_PROVIDER=ollama e fornisci il OLLAMA_BASE_PATH (l’URL della tua istanza Ollama). Il server AnythingLLM invierà quindi tutte le query del modello all’API di Ollama. Ollama è ufficialmente supportato, e la documentazione nota che puoi utilizzarlo per eseguire vari modelli open-source (come Llama 2, Mistral, ecc.) localmente. In effetti, gli sviluppatori sottolineano che combinare AnythingLLM con Ollama sblocca potenti capacità RAG offline: Ollama gestisce l’inferenza del modello e AnythingLLM gestisce embeddings e la logica UI/agente.

Punti di forza: AnythingLLM fornisce una soluzione completa per Q&A e chat privata. I punti di forza chiave includono: una configurazione facile per RAG (il lavoro pesante degli embedding e della memorizzazione dei vettori è automatizzato), supporto multi-documento con citazioni chiare delle fonti e funzionalità aggiuntive come Agenti AI (ha un costruttore di agenti senza codice dove puoi creare flussi di lavoro personalizzati e utilizzo degli strumenti). È anche multi-utente fuori dalla scatola (soprattutto in modalità server), con account utente e autorizzazioni se necessario. L’interfaccia è progettata per essere semplice (scatola di chat + barra laterale dei documenti/spazi di lavoro) ma potente sotto il cofano. Per l’uso personale, l’app desktop è un grande vantaggio – ottieni un’applicazione con sensazione nativa senza dover aprire un browser o eseguire comandi e memorizza i dati localmente per impostazione predefinita.

Limitazioni: Poiché integra molti componenti (API LLM, modelli di embedding, database vettoriale, ecc.), AnythingLLM può essere intensivo in termini di risorse. Quando inserisci documenti, potrebbe richiedere tempo e memoria per generare embeddings (supporta persino l’uso di Ollama stesso o modelli locali per gli embedding con modelli come nomic-embed). L’app desktop semplifica l’utilizzo, ma se hai molti documenti o file molto grandi, aspetta un po’ di elaborazione pesante sullo sfondo. Un’altra limitazione è che gli utenti avanzati potrebbero trovarla meno configurabile rispetto all’assemblaggio del proprio stack – ad esempio, attualmente utilizza LanceDB o Chroma; se volessi un diverso store vettoriale, dovresti immergerti nella configurazione o nel codice. Inoltre, sebbene il supporto multi-fornitore sia disponibile, l’interfaccia è davvero orientata verso un modello alla volta (cambieresti l’impostazione del fornitore globale se volessi utilizzare un modello diverso). In sintesi, AnythingLLM è una soluzione fuori dalla scatola eccellente per la chat di documenti locali, specialmente con Ollama, ma è un’applicazione più grande da eseguire rispetto alle interfacce minime.

Chat-with-Notes (Interfaccia di Chat Minimale per Documenti)

Chat-with-Notes è un’applicazione minimalista specificamente costruita per chattare con file di testo locali utilizzando modelli gestiti da Ollama. Si tratta essenzialmente di un leggero server web Flask che si esegue sul proprio PC, fornendo una semplice pagina web dove è possibile caricare un documento e iniziare una chat su di esso. L’obiettivo di questo progetto è la semplicità: non ha molte funzionalità extra, ma svolge il compito principale di risposta alle domande sui documenti con un modello locale LLM.

L’uso di Chat-with-Notes prevede innanzitutto l’accertamento che la vostra istanza Ollama stia eseguendo un modello (ad esempio, è possibile avviare Ollama con ollama run llama2 o un altro modello). Poi si avvia l’app Flask (python app.py) e si apre il sito web locale. L’interfaccia utente vi chiederà di caricare un file (i formati supportati includono testo semplice, Markdown, file di codice, HTML, JSON e PDF). Una volta caricato, il contenuto del file viene visualizzato e potete porre domande o chattare con l’IA su quel contenuto. La conversazione avviene in un formato tipico a bolle di chat. Se si carica un nuovo file durante la conversazione, l’app vi chiederà se volete iniziare una nuova chat o mantenere il contesto della chat corrente e aggiungere semplicemente le informazioni del nuovo file. In questo modo è possibile parlare di più file sequenzialmente se necessario. Ci sono anche pulsanti per cancellare la chat o esportare la conversazione in un file di testo.

Sotto il cofano, Chat-with-Notes interroga l’API Ollama per generare le risposte. Ollama gestisce l’inferenza del modello e Chat-with-Notes fornisce solo il prompt (che include parti rilevanti del testo caricato). Non utilizza un database vettoriale; invece, invia semplicemente tutto il contenuto del file (o porzioni di esso) insieme alla vostra domanda al modello. Questo approccio funziona meglio per documenti di dimensioni ragionevoli che si adattano alla finestra di contesto del modello.

Punti di forza: L’app è estremamente semplice da distribuire e utilizzare. Non c’è una configurazione complessa – se avete Python e Ollama impostati, potete farlo funzionare in un minuto o due. L’interfaccia è pulita e minimalista, concentrata sul contenuto del testo e sulla Q&A. Essendo così focalizzata, garantisce che tutti i dati rimangano locali e solo in memoria (nessuna chiamata esterna tranne quella a Ollama su localhost). È una scelta eccellente se si desidera specificamente chattare con file e non è necessario un dialogo generale senza documento.

Limitazioni: Il minimalismo di Chat-with-Notes significa che mancano molte funzionalità presenti in altre interfacce utente. Ad esempio, non supporta l’uso di più modelli o fornitori (è progettato solo per Ollama), e non mantiene una libreria a lungo termine di documenti – si caricano i file secondo necessità per sessione, e non c’è un indice vettoriale persistente. Scalare a documenti molto grandi potrebbe essere complicato senza aggiustamenti manuali, poiché potrebbe cercare di includere molta testo nel prompt. Inoltre, l’interfaccia utente, pur essendo funzionale, non è così raffinata (nessun modo scuro, nessuna formattazione del testo ricco delle risposte, ecc.). In sostanza, questo strumento è ideale per analisi rapide e una tantum di file con un modello Ollama. Se le vostre esigenze crescono (ad esempio, molti documenti o desiderio di un’interfaccia utente più raffinata), potreste superare Chat-with-Notes. Ma come punto di partenza o soluzione personale “chiedi al mio PDF” su Ollama, è molto efficace.

Conclusione

Ogni una di queste interfacce utente open-source può migliorare la vostra esperienza con modelli locali Ollama fornendo un’interfaccia di chat user-friendly e capacità extra come la risposta alle domande sui documenti. La scelta migliore dipende dalle vostre esigenze e dal comfort tecnico:

- Per una configurazione rapida e l’uso basato su browser: Page Assist è una scelta eccellente, integrandosi direttamente nella navigazione web con il minimo sforzo.

- Per un ambiente di app web completo: Open WebUI o LibreChat offrono funzionalità estese e flessibilità multi-modello, adatte per utenti avanzati o configurazioni multi-utente.

- Per un’alternativa a ChatGPT raffinata con potenziale plugin: LobeChat offre un buon equilibrio di usabilità e funzionalità in un pacchetto self-hosted.

- Per interazioni focalizzate sui documenti: AnythingLLM fornisce una soluzione all-in-one (soprattutto se vi piace avere un’app desktop), mentre Chat-with-Notes offre un approccio minimalista per la Q&A su singoli documenti.

Tutti questi strumenti sono attivamente mantenuti, quindi potete aspettarvi miglioramenti e supporto della comunità. Scegliendo una di queste interfacce utente, sarete in grado di chattare con i vostri modelli locali ospitati da Ollama in modo conveniente – sia che si tratti di analizzare documenti, codificare con assistenza o semplicemente avere un’IA conversazionale disponibile senza dipendenze cloud. Ogni soluzione sopra è open-source, quindi potete ulteriormente personalizzarle secondo le vostre esigenze o addirittura contribuire al loro sviluppo.

Buona chat con il vostro LLM locale!