Farfalle vs Perplexica

Confronto tra due motori di ricerca AI self-hosted

La buona cucina è un piacere per gli occhi. Ma in questo post compariamo due sistemi di ricerca basati sull’AI, Farfalle e Perplexica.

Per inciso, questa forma di pasta si chiama anche “farfalle”.

Ma qui sto confrontando solo il comportamento di questi due sistemi e non le forme della pasta.

OK. Concentrati!

Per favore vedi anche Installazione e configurazione di Perplexica - con ollama e Installa e configura Ollama.

Perplexica

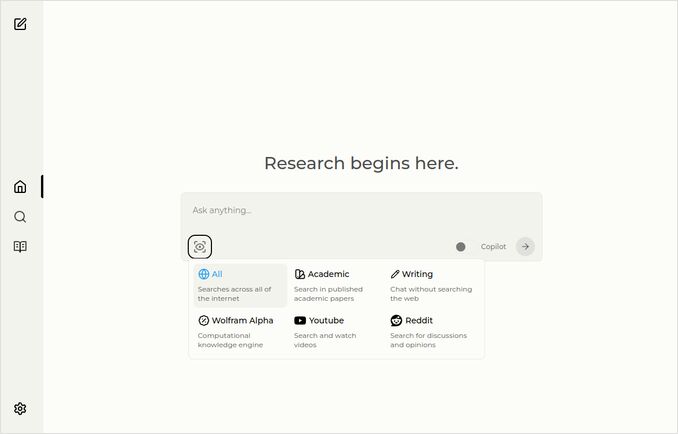

Ecco la pagina principale con il menu a discesa per la selezione delle fonti.

- Perplexica è implementato in

- TypeScript e React.Js (UI)

- TypeScript e Express.Js (Backend)

- include anche la configurazione per il motore di ricerca SearxNG

- Ha una modalità Copilot

- Ha la possibilità di utilizzare qualsiasi modello LLM ospitato da Ollama come modello di chat o embeddings

- Ha tre piccoli modelli interni di embeddings

Farfalle

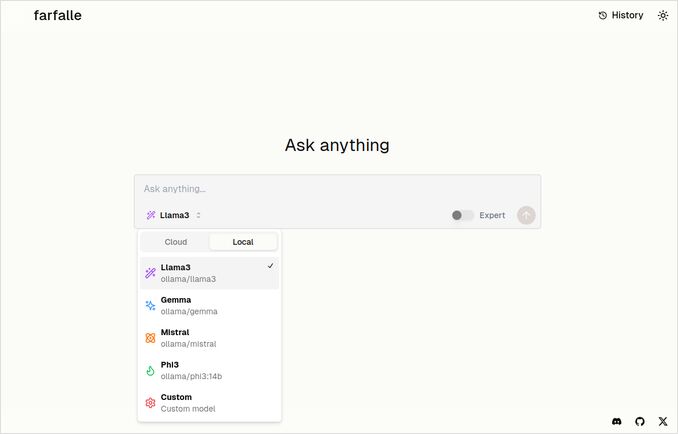

- Farfalle è implementato in

- TypeScript e React.Js (UI)

- Python Fastapi (Backend)

- include anche un riferimento al motore di ricerca SearxNG. Non c’è molta configurazione per questo, è un’immagine Docker standard.

- Ha una modalità Esperto che dovrebbe preparare diverse richieste dall’originale e combinare le risposte. Ma questa non ha funzionato nel nostro test.

- Ha la possibilità di utilizzare quattro modelli LLM ospitati da Ollama come modello di chat (llama3, mistral, gemma, phi3). Questo è un buon insieme di opzioni, ma preferirei che fosse più flessibile e permettesse di utilizzare qualsiasi modello che Ollama serve.

- Non ci sono opzioni per i modelli di embeddings

Confronto effettuato da Perplexica e Farfalle stessi

Ho eseguito la stessa richiesta Confronta farfalle e perplexica in base alla robustezza, alla comunità, al supporto e ai modelli LLM supportati

Entrambi Perplexica e Farfalle utilizzavano il modello llama3 ospitato localmente su ollama. Il nome completo del modello è llama3 8b q4.

Non credere al 100% a ciò che dicono le risposte, guarda solo la lunghezza del testo, la struttura e la qualità complessiva della risposta.

Crederei circa il 70%…

Risposta del confronto di Perplexica

Confronto tra Farfalle e Perplexica

Robustezza

Farfalle: 8/10 - Farfalle è un motore di ricerca AI popolare noto per la sua affidabilità e capacità di gestire query complesse. Ha una solida base nel processing del linguaggio naturale (NLP) e nell’apprendimento automatico (ML). Sebbene non sia perfetto, la robustezza di Farfalle è ben consolidata.

Perplexica: 9/10 - Perplexica è costruito sopra al modello Phi-3 di Meta AI, progettato per la robustezza. È stato testato per fornire risposte accurate anche quando si confronta con domande ambigue o poco chiare. La sua capacità di riformulare le domande e adattarsi a diversi contesti lo rende un motore di ricerca robusto.

Comunità

Farfalle: 7/10 - Farfalle ha una comunità dedicata di utenti che apprezzano le sue capacità. Sebbene non abbia lo stesso livello di adozione di Perplexica, la base utente di Farfalle è tuttavia significativa.

Perplexica: 8.5/10 - Perplexica ha guadagnato riconoscimento ampio per il suo approccio innovativo ai motori di ricerca. La sua comunità sta crescendo rapidamente, con molti utenti che apprezzano la sua capacità di fornire risultati accurati e rilevanti.

Supporto

Farfalle: 6.5/10 - Farfalle fornisce un supporto di base attraverso FAQ, documentazione e forum. Sebbene non sia così completo come il supporto di Perplexica, la comunità utente di Farfalle è in genere autosufficiente.

Perplexica: 9/10 - Perplexica offre risorse di supporto estese, tra cui documentazione dettagliata, FAQ e forum della comunità. I suoi sviluppatori sono attivamente impegnati con la comunità, assicurando che gli utenti ricevano assistenza tempestiva ed efficace.

Modelli LLM supportati

Farfalle: No - Farfalle è un motore di ricerca AI autonomo che non si basa su modelli linguistici di grandi dimensioni (LLM) per le sue capacità.

Perplexica: Sì - Perplexica è costruito sopra al modello Phi-3 di Meta AI, che è un LLM. Questo permette a Perplexica di sfruttare il potere dell’apprendimento profondo per ottenere risultati più accurati e rilevanti.

Punteggio complessivo Farfalle: 22/30 Perplexica: 34.5/40

In base a questi criteri, Perplexica sembra avere un vantaggio lieve su Farfalle in termini di robustezza, supporto della comunità e integrazione LLM. Tuttavia, entrambi i motori di ricerca hanno i loro punti di forza, e la scelta dipende infine dalle tue esigenze specifiche e preferenze.

Raccomandazione Se stai cercando un motore di ricerca AI affidabile con forti capacità di NLP, Perplexica potrebbe essere la scelta migliore. Se preferisci un approccio più semplice e senza fronzoli al motore di ricerca, Farfalle potrebbe comunque fornire risultati eccellenti.

Risposta del confronto di Farfalle

Confronto tra Farfalle e Perplexica

Farfalle e Perplexica sono due motori di ricerca alimentati dall’AI che hanno attirato l’attenzione negli ultimi tempi. Ecco un confronto tra questi due progetti in base alla robustezza, alla comunità, al supporto e al supporto LLM (Large Language Model).

Robustezza

- Farfalle è progettato per essere autoospitato con LLM locali o cloud, rendendolo un’opzione più robusta per gli utenti che desiderano il controllo sul proprio motore di ricerca.

- Perplexica, d’altro canto, è un’alternativa open source a Perplexity AI e viene costantemente migliorata dai suoi sviluppatori.

Comunità

- Perplexica ha una comunità dedicata di sviluppatori e utenti che contribuiscono al suo sviluppo e forniscono supporto

- La comunità di Farfalle è più piccola, ma ha comunque una presenza su GitHub

Supporto

- Perplexica offre aggiornamenti regolari e miglioramenti, nonché un canale Discord per discutere argomenti al di fuori del supporto regolare

- Il supporto di Farfalle è limitato ai problemi su GitHub e alle richieste di pull

Supporto LLM Entrambi Farfalle e Perplexica supportano LLM. Perplexica utilizza Ollama, un LLM locale, mentre Farfalle supporta sia LLM locali che cloud.

In sintesi, Farfalle è più robusto grazie al suo design autoospitato, mentre Perplexica ha una comunità più forte e un supporto migliore. Entrambi i progetti supportano LLM, ma Perplexica utilizza specificamente Ollama.

Conclusione

Qual è la differenza tra Perplexica e Farfalle?

La risposta:

- Ignorando alcuni errori fatti, entrambi i sistemi pensano che Perplexica sia migliore di Farfalle, con cui sono d’accordo.

- Mi piace molto l’interfaccia utente di Farfalle, anche se sono abbastanza vicine

- Mi piace l’idea della modalità esperto di Farfalle, anche se non ha funzionato nel mio ambiente

- Ho riscontrato 3 bug quando ho eseguito Farfalle. Il codice di Perplexica è più raffinato

- Una volta configurato, Perplexica ha funzionato senza errori

- Perplexica permette di utilizzare qualsiasi modello ospitato da Ollama. Farfalle permette di utilizzare solo Gemma, Llama3, Mistral e Phi3 (versioni predefinite, che sono un po’ obsolette).

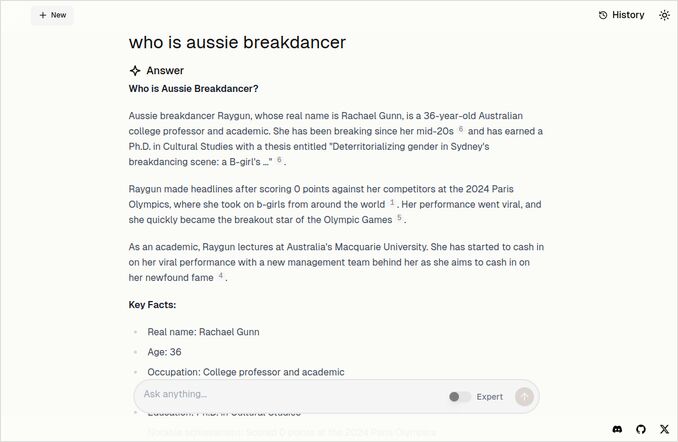

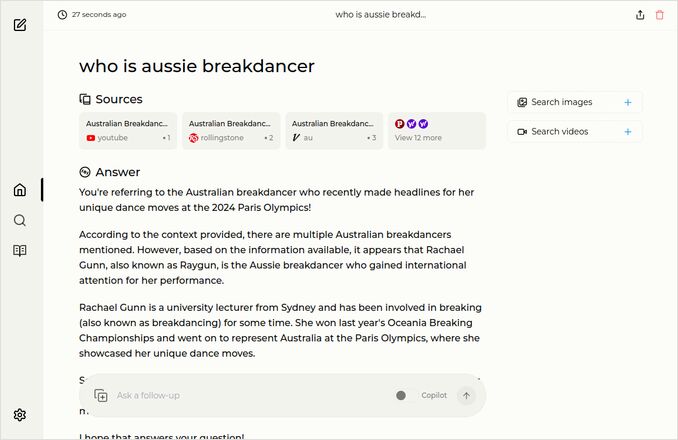

- Mi piacciono di più le risposte di Farfalle. Guarda l’immagine di Farfalle qui sotto. Diretto al punto senza quelle “Secondo il contesto fornito”…

Altri esempi

Questi mostrano le risposte per la stessa domanda sull’aussie breakdancer. Sai, quello con il dottorato che ha ottenuto 0 (Zero) punti e probabilmente ha visto il breakdancing rimosso dal programma olimpico.

Risposta di Farfalle

Risposta di Perplexica

Se leggi (o scendi) fino a questa ultima frase, grazie per aver condiviso gli stessi interessi di me. È davvero un periodo eccitante. Buona giornata!

Link utili

- Ricerca vs Deepsearch vs Deep Research

- Test: Come Ollama utilizza le prestazioni del processore Intel e i core efficienti

- Come Ollama gestisce le richieste parallele

- Autoospitare Perplexica - con Ollama

- Confronto delle capacità di sintesi dei modelli LLM

- Scrivere prompt efficaci per i modelli LLM

- Test della rilevazione delle fallacie logiche da parte dei nuovi modelli LLM: gemma2, qwen2 e mistral Nemo

- Ollama cheatsheet

- Markdown Cheatsheet

- Fornitori di LLM in cloud

- Modelli Qwen3 Embedding & Reranker su Ollama: Prestazioni all’avanguardia