Spostare i modelli Ollama in una posizione diversa

I file del modello LLM di Ollama occupano molto spazio.

Dopo l’installazione di ollama è meglio riconfigurare ollama per archiviarli in un nuovo luogo subito. In questo modo, dopo aver scaricato un nuovo modello, non verrà scaricato nella vecchia posizione.

Informazioni su Ollama

Ollama è un’interfaccia basata su testo per modelli AI LLM e un’API che può ospitare anche questi ultimi.

Installare Ollama

Vai a https://ollama.com/download

Per installare Ollama su Linux:

curl -fsSL https://ollama.com/install.sh | sh

Ollama su Windows è disponibile alla pagina: https://ollama.com/download/windows Ollama per Mac è disponibile qui: https://ollama.com/download/macOllamaSetup.exe

Scaricare, elencare e rimuovere i modelli Ollama

Per scaricare alcuni modelli Ollama: Vai alla Libreria Ollama (https://ollama.com/library) e trova il modello di cui hai bisogno, puoi trovare anche i tag e le dimensioni dei modelli.

Poi esegui:

ollama pull gemma2:latest

# Oppure ottieni un modello leggermente più intelligente che si adatta comunque a 16 GB di VRAM:

ollama pull gemma2:27b-instruct-q3_K_S

# Oppure:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

Per controllare i modelli Ollama presenti nel repository locale:

ollama list

Per rimuovere un modello non necessario:

ollama rm qwen2:7b-instruct-q8_0 # ad esempio

Posizione dei modelli Ollama

Per default i file dei modelli sono archiviati:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

Configurare il percorso dei modelli Ollama su Windows

Per creare una variabile ambiente su Windows puoi seguire queste istruzioni:

- Apri le Impostazioni di Windows.

- Vai a Sistema.

- Seleziona Informazioni.

- Seleziona Impostazioni avanzate del sistema.

- Vai alla scheda Avanzate.

- Seleziona Variabili ambiente…

- Clicca su Nuovo…

- Crea una variabile chiamata OLLAMA_MODELS che punta al luogo in cui desideri archiviare i modelli.

Spostare i modelli Ollama su Linux

Modifica i parametri del servizio systemd di Ollama

sudo systemctl edit ollama.service

o

sudo xed /etc/systemd/system/ollama.service

Questo aprirà un editor.

Per ogni variabile ambiente, aggiungi una riga Environment sotto la sezione [Service]:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

Salva e esci.

Esiste anche un parametro User e Group, questi devono avere accesso a questa cartella.

Ricarica systemd e riavvia Ollama:

sudo systemctl daemon-reload

sudo systemctl restart ollama

se qualcosa è andato storto

systemctl status ollama.service

sudo journalctl -u ollama.service

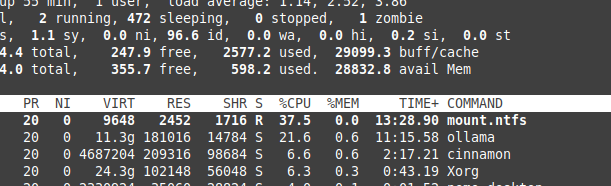

Archiviazione dei file su partizione NTFS

Ti preghiamo di essere consapevole che se stai eseguendo Linux e mantieni i tuoi modelli su una partizione formattata NTFS, i tuoi modelli saranno caricati molto più lentamente, più del 20%.

Installare Ollama su Windows in una cartella specifica

Insieme ai modelli

.\OllamaSetup.exe /DIR=D:\OllamaDir

Esporre l’API Ollama alla rete interna

Interno qui significa rete locale.

Aggiungi alla configurazione del servizio:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Link utili

- Test: Come Ollama utilizza le prestazioni e i core efficienti del processore Intel

- Come Ollama gestisce le richieste parallele

- Test di Deepseek-r1 su Ollama

- Prestazioni LLM e Lanes PCIe: Considerazioni chiave

- Rilevamento di fallacie logiche con LLM

- Confronto delle prestazioni di velocità LLM

- Confronto delle capacità di sintesi LLM

- Scrittura di prompt efficaci per LLM

- Autohosting di Perplexica con Ollama

- Conda Cheatsheet

- Docker Cheatsheet

- Fornitori di LLM in cloud

- Modelli di embedding e riconoscimento Qwen3 su Ollama: Prestazioni all’avanguardia