Proxmox im Jahr 2025: Ein praktischer, all-in-one-Virtualisierungs-Stack

Was ist Proxmox?

Proxmox Virtual Environment (Proxmox VE) ist eine Open-Source-, Typ-1-Hypervisor- und Rechenzentrums-Orchestrierungsplattform, die auf Debian basiert.

Was ist Proxmox?

Proxmox Virtual Environment (Proxmox VE) ist eine Open-Source-, Typ-1-Hypervisor- und Rechenzentrums-Orchestrierungsplattform, die auf Debian basiert.

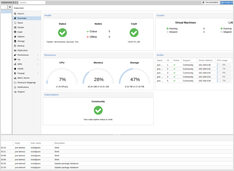

Preise für AI-geeignete Consumer-GPUs - RTX 5080 und RTX 5090

Wiederholt vergleichen wir die Preise für High-End-Consumer-GPUs, die insbesondere für LLMs und allgemein für KI geeignet sind. Speziell betrachte ich die Preise für RTX-5080 und RTX-5090. Diese sind leicht gesunken.

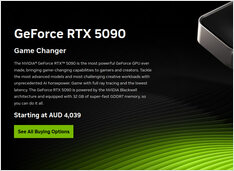

Kurze Liste von Anwendungen zur Überwachung der GPU-Auslastung

GPU-Lastüberwachungsanwendungen: nvidia-smi vs nvtop vs nvitop vs KDE plasma systemmonitor.

Im Juli 2025 sollte es bald verfügbar sein

Nvidia steht kurz vor der Veröffentlichung von NVIDIA DGX Spark - einem kleinen AI-Supercomputer auf Blackwell-Architektur mit 128+GB einheitlichem RAM und 1 PFLOPS AI-Leistung. Eine schöne Vorrichtung, um LLMs auszuführen.

Aktualisierung der Preise für KI-geeignete GPUs - RTX 5080 und RTX 5090

Lassen Sie uns die Preise für Top-Level-Consumer-GPUs vergleichen, die insbesondere für LLMs und KI im Allgemeinen geeignet sind. Speziell schauen Sie sich die RTX 5080- und RTX 5090-Preise an. Sie sind leicht gesunken.

Preisrealitätscheck - RTX 5080 und RTX 5090

Vor nur 3 Monaten sahen wir die RTX 5090 noch nicht in den Geschäften, und jetzt sind sie da, aber die Preise liegen etwas höher als der MRSP. Lassen Sie uns die günstigsten Preise für RTX 5080 und RTX 5090 in Australien vergleichen und sehen, wie sich die Dinge entwickeln.

Mehr RAM, weniger Stromverbrauch und trotzdem teuer wie...

Top automatisiertes System für einen fantastischen Job.

Überlegen Sie, eine zweite GPU für LLMs zu installieren?

Wie PCIe-Lanes die LLM-Performance beeinflussen? Je nach Aufgabe. Bei Training und Multi-GPU- Inferenz ist der Leistungsverlust erheblich.

Und warum sehe ich diesen BSOD immer wieder...

Ich wurde von diesem Problem stark getroffen. Aber Sie sollten Ihre PC-Systeme untersuchen und testen, wenn Ihr BSOD wie meiner ist.

Die Ursache lag bei Intel’s CPU Degradation Issue in 13th and 14th generation.

Ollama auf Intel CPU: Effiziente vs. Leistungscores

Ich habe eine Theorie, die ich testen möchte – wenn man alle Kerne eines Intel-Prozessors nutzt, würde das die Geschwindigkeit von LLMs erhöhen? Test: Wie Ollama die Leistung und effizienten Kerne von Intel-Prozessoren nutzt

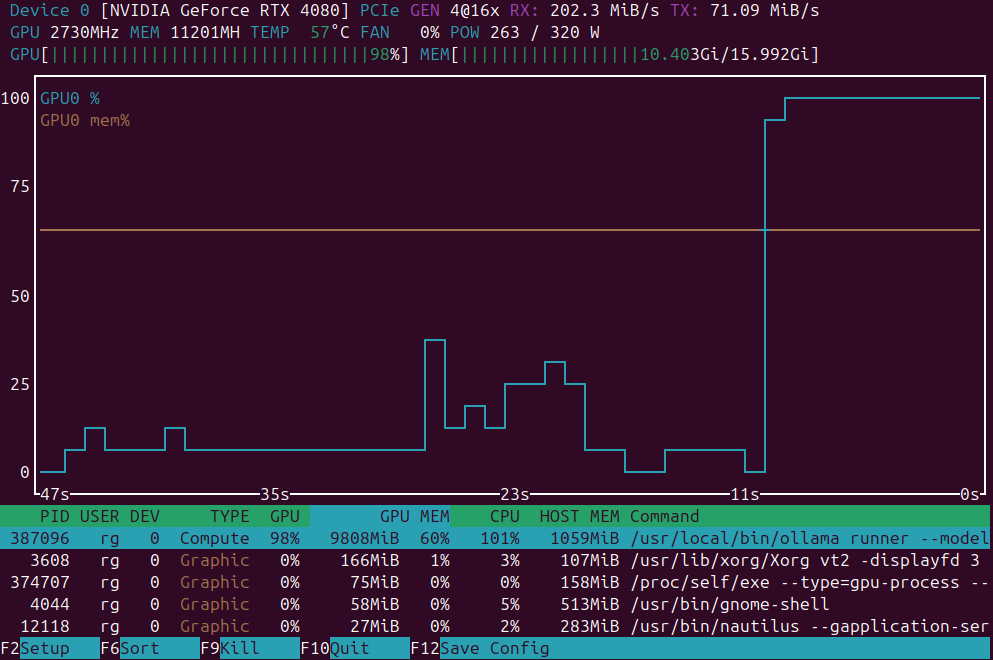

Es stört mich, dass das neue Gemma3-Modell mit 27 Bit (gemma3:27b, 17 GB auf Ollama) nicht in die 16 GB VRAM meines GPUs passt und teilweise auf dem CPU läuft.

KI benötigt viel Leistung...

Inmitten der Turbulenzen der modernen Welt hier vergleiche ich die technischen Spezifikationen verschiedener Grafikkarten für KI-Aufgaben

(Deep Learning,

Objekterkennung

und LLMs).

Sie sind jedoch alle unglaublich teuer.

Konfigurieren Sie ollama für die parallele Ausführung von Anfragen.

Wenn der Ollama-Server zwei Anfragen gleichzeitig erhält, hängt sein Verhalten von seiner Konfiguration und den verfügbaren Systemressourcen ab.

Es ist viel einfacher im Vergleich zu alten Druckertreibern

Die Installation des ET-8500 auf Windows ist gut dokumentiert. Die ET-8500 Linux-Treiber-Installation ist einfach, aber nicht trivial.

Testen wir die Geschwindigkeit der LLMs auf GPU im Vergleich zu CPU

Vergleich der Vorhersagegeschwindigkeit verschiedener Versionen von LLMs: llama3 (Meta/Facebook), phi3 (Microsoft), gemma (Google), mistral (Open Source) auf CPU und GPU.