Кросс-модальные вложения: объединение модулей ИИ

Объедините текст, изображения и аудио в общих пространствах встраивания

Кросc-модальные вложения представляют собой прорыв в искусственном интеллекте, позволяя понимать и анализировать различные типы данных в едином пространстве представления.

Эта технология питает современные мультимодальные приложения от поиска изображений до генерации контента.

На этом изображении представлена статья:

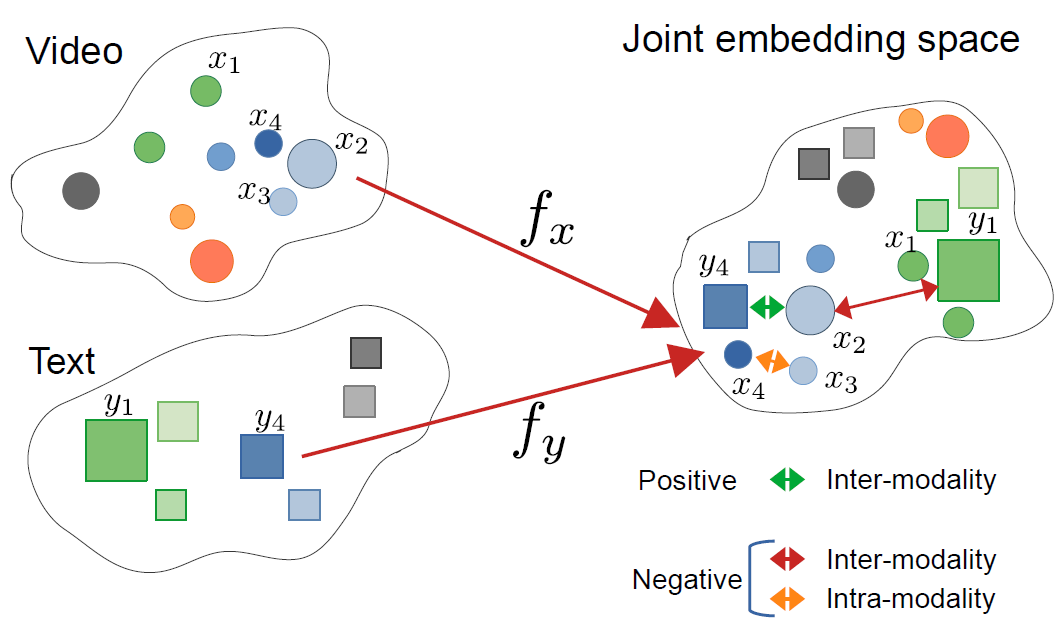

CrossCLR: кросc-модальное контрастное обучение для мультимодальных видео-представлений, автор Mohammadreza Zolfaghari и другие

На этом изображении представлена статья:

CrossCLR: кросc-модальное контрастное обучение для мультимодальных видео-представлений, автор Mohammadreza Zolfaghari и другие

Понимание кросc-модальных вложений

Кросc-модальные вложения - это векторные представления, которые кодируют информацию из разных модальностей - таких как текст, изображения, аудио и видео - в общее пространство вложений. В отличие от традиционных одномодальных вложений, кросc-модальные подходы учатся создавать единое представление, где семантически схожие концепции группируются вместе, независимо от их исходного формата.

Что такое кросc-модальные вложения?

В своей основе, кросc-модальные вложения решают критическую задачу в ИИ: как сравнивать и связывать информацию между разными типами данных. Традиционный классификатор изображений может работать только с изображениями, а текстовая модель - только с текстом. Кросc-модальные вложения преодолевают этот разрыв, проектируя разные модальности в общее векторное пространство, где:

- Изображение кошки и слово “кошка” имеют схожие векторные представления

- Сохраняются семантические отношения между модальностями

- Метрики расстояния (косинусная схожесть, евклидово расстояние) измеряют кросc-модальную схожесть

Это единое представление позволяет реализовать мощные возможности, такие как поиск изображений по текстовым запросам, генерация подписей к изображениям или даже классификация без специфической обучающей выборки.

Архитектура кросc-модального обучения

Современные кросc-модальные системы обычно используют архитектуру с двойными энкодерами и контрастным обучением:

Двойные энкодеры: Отдельные нейронные сети кодируют каждую модальность. Например, CLIP использует:

- Визуальный трансформер (ViT) или ResNet для изображений

- Текстовый энкодер на основе трансформера для языка

Контрастное обучение: Модель обучается, максимизируя схожесть между соответствующими парами (например, изображение и его подпись), в то время как схожесть между несоответствующими парами минимизируется. Функция контрастной потери может быть выражена как:

[ \mathcal{L} = -\log \frac{\exp(\text{sim}(v_i, t_i) / \tau)}{\sum_{j=1}^{N} \exp(\text{sim}(v_i, t_j) / \tau)} ]

где (v_i) - это вложение изображения, (t_i) - вложение текста, (\text{sim}) - это схожесть (обычно косинусная), а (\tau) - параметр температуры.

Ключевые технологии и модели

CLIP: Пионер в понимании изображения и текста

CLIP (Contrastive Language-Image Pre-training) от OpenAI революционизировал область, обучаясь на 400 миллионах пар изображений и текстов из интернета. Архитектура модели состоит из:

import torch

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

# Загрузка предобученной модели CLIP

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# Подготовка входных данных

image = Image.open("example.jpg")

texts = ["фото кошки", "фото собаки", "фото птицы"]

# Обработка и получение вложений

inputs = processor(text=texts, images=image, return_tensors="pt", padding=True)

# Получение оценок кросc-модальной схожести

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = logits_per_image.softmax(dim=1)

print(f"Вероятности: {probs}")

Основная инновация CLIP - это масштаб и простота. Обучаясь на огромных веб-данных без ручной аннотации, он достиг удивительных возможностей нулевого обучения. Как CLIP отличается от традиционных визуальных моделей? В отличие от супервизорных классификаторов, обученных на фиксированных наборах меток, CLIP учится на естественном языковом супервизоре, что делает его адаптивным к любому визуальному концепту, описуемому в тексте.

ImageBind: Расширение до шести модальностей

ImageBind от Meta расширяет кросc-модальные вложения за пределы зрения и языка, чтобы включить:

- Аудио (звуки окружающей среды, речь)

- Информацию о глубине

- Термическое изображение

- Данные IMU (датчики движения)

Это создает действительно мультимодальное пространство вложений, где все шесть модальностей выровнены. Ключевая идея заключается в том, что изображения служат в качестве “связующей” модальности - связывая изображения с другими модальностями и используя существующее выравнивание зрения и языка, ImageBind создает единое пространство без необходимости обучать все возможные пары модальностей во время обучения.

Открытые альтернативы

Экосистема расширилась с несколькими открытыми реализациями:

OpenCLIP: Комьюнити-реализация, предлагающая более крупные модели и разнообразные рецепты обучения:

import open_clip

model, _, preprocess = open_clip.create_model_and_transforms(

'ViT-L-14',

pretrained='laion2b_s32b_b82k'

)

tokenizer = open_clip.get_tokenizer('ViT-L-14')

Модели LAION-5B: Обученные на огромном открытом наборе данных LAION-5B, предоставляют альтернативы проприетарным моделям с сопоставимой или лучшей производительностью.

Для разработчиков, заинтересованных в передовых открытых решениях для текстовых вложений, Qwen3 Embedding & Reranker Models on Ollama предлагают отличную мультиязычную производительность с простым локальным развертыванием.

Стратегии реализации

Создание системы кросc-модального поиска

Практическая реализация кросc-модальных вложений для семантического поиска включает несколько компонентов. Какие основные применения кросc-модальных вложений? Они питают кейсы от поиска товаров в интернет-магазинах до модерации контента и творческих инструментов.

import numpy as np

from typing import List, Tuple

import faiss

from transformers import CLIPModel, CLIPProcessor

class CrossModalSearchEngine:

def __init__(self, model_name: str = "openai/clip-vit-base-patch32"):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.image_index = None

self.image_metadata = []

def encode_images(self, images: List) -> np.ndarray:

"""Кодирование изображений в вложения"""

inputs = self.processor(images=images, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_image_features(**inputs)

return embeddings.cpu().numpy()

def encode_text(self, texts: List[str]) -> np.ndarray:

"""Кодирование текстовых запросов в вложения"""

inputs = self.processor(text=texts, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_text_features(**inputs)

return embeddings.cpu().numpy()

def build_index(self, image_embeddings: np.ndarray):

"""Создание индекса FAISS для эффективного поиска схожести"""

dimension = image_embeddings.shape[1]

# Нормализация вложений для косинусной схожести

faiss.normalize_L2(image_embeddings)

# Создание индекса (использование HNSW для масштабируемого развертывания)

self.image_index = faiss.IndexHNSWFlat(dimension, 32)

self.image_index.hnsw.efConstruction = 40

self.image_index.add(image_embeddings)

def search(self, query: str, k: int = 10) -> List[Tuple[int, float]]:

"""Поиск изображений по текстовым запросам"""

query_embedding = self.encode_text([query])

faiss.normalize_L2(query_embedding)

distances, indices = self.image_index.search(query_embedding, k)

return list(zip(indices[0], distances[0]))

# Пример использования

engine = CrossModalSearchEngine()

# Построение индекса из коллекции изображений

image_embeddings = engine.encode_images(image_collection)

engine.build_index(image_embeddings)

# Поиск по тексту

results = engine.search("закат над горами", k=5)

Тонкая настройка для специфичных задач

Хотя предобученные модели хорошо работают для общих целей, специфичные для домена приложения выигрывают от тонкой настройки:

from transformers import CLIPModel, CLIPProcessor, AdamW

import torch.nn as nn

class FineTuneCLIP:

def __init__(self, model_name: str, num_epochs: int = 10):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.num_epochs = num_epochs

def contrastive_loss(self, image_embeddings, text_embeddings, temperature=0.07):

"""Вычисление контрастной потери InfoNCE"""

# Нормализация вложений

image_embeddings = nn.functional.normalize(image_embeddings, dim=1)

text_embeddings = nn.functional.normalize(text_embeddings, dim=1)

# Вычисление матрицы схожести

logits = torch.matmul(image_embeddings, text_embeddings.T) / temperature

# Метки - это диагональ (соответствующие пары)

labels = torch.arange(len(logits), device=logits.device)

# Симметричная потеря

loss_i = nn.functional.cross_entropy(logits, labels)

loss_t = nn.functional.cross_entropy(logits.T, labels)

return (loss_i + loss_t) / 2

def train(self, dataloader, learning_rate=5e-6):

"""Тонкая настройка на специфичных для домена данных"""

optimizer = AdamW(self.model.parameters(), lr=learning_rate)

self.model.train()

for epoch in range(self.num_epochs):

total_loss = 0

for batch in dataloader:

images, texts = batch['images'], batch['texts']

# Обработка входных данных

inputs = self.processor(

text=texts,

images=images,

return_tensors="pt",

padding=True

)

# Прямой проход

outputs = self.model(**inputs, return_loss=True)

loss = outputs.loss

# Обратный проход

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"Эпоха {epoch+1}/{self.num_epochs}, Потеря: {avg_loss:.4f}")

Рассмотрения развертывания в производственной среде

Оптимизация производительности инференса

Как можно оптимизировать кросс-модальные эмбеддинги для производства? Оптимизация производительности критически важна для реального развертывания:

Квантование модели: Уменьшение размера модели и увеличение скорости инференса:

import torch

from torch.quantization import quantize_dynamic

# Динамическое квантование для инференса на CPU

quantized_model = quantize_dynamic(

model,

{torch.nn.Linear},

dtype=torch.qint8

)

Конвертация в ONNX: Экспорт в ONNX для оптимизированного инференса:

import torch.onnx

dummy_input = processor(text=["sample"], return_tensors="pt")

torch.onnx.export(

model,

tuple(dummy_input.values()),

"clip_model.onnx",

input_names=['input_ids', 'attention_mask'],

output_names=['output'],

dynamic_axes={

'input_ids': {0: 'batch_size'},

'attention_mask': {0: 'batch_size'}

}

)

Пакетная обработка: Максимальное использование GPU за счет пакетизации:

def batch_encode(items: List, batch_size: int = 32):

"""Обработка элементов пакетами для повышения эффективности"""

embeddings = []

for i in range(0, len(items), batch_size):

batch = items[i:i+batch_size]

batch_embeddings = encode_batch(batch)

embeddings.append(batch_embeddings)

return np.concatenate(embeddings, axis=0)

Масштабируемое хранение векторов

Для крупномасштабных приложений векторные базы данных являются необходимыми. Какие фреймворки поддерживают реализации кросс-модальных эмбеддингов? Помимо самих моделей, важна инфраструктура:

FAISS (Facebook AI Similarity Search): Эффективная библиотека поиска сходства

- Поддержка миллиардов векторов

- Различные типы индексов (плоские, IVF, HNSW)

- Доступна ускорение на GPU

Milvus: Открытая векторная база данных

from pymilvus import connections, Collection, FieldSchema, CollectionSchema, DataType

# Определение схемы

fields = [

FieldSchema(name="id", dtype=DataType.INT64, is_primary=True, auto_id=True),

FieldSchema(name="embedding", dtype=DataType.FLOAT_VECTOR, dim=512),

FieldSchema(name="metadata", dtype=DataType.JSON)

]

schema = CollectionSchema(fields, description="Эмбеддинги изображений")

# Создание коллекции

collection = Collection("images", schema)

# Создание индекса

index_params = {

"metric_type": "IP", # Внутреннее произведение (косинусное сходство)

"index_type": "IVF_FLAT",

"params": {"nlist": 1024}

}

collection.create_index("embedding", index_params)

Pinecone/Weaviate: Управляемые векторные базы данных, предлагающие легкое масштабирование и обслуживание.

Дополнительные случаи использования и приложения

Классификация без обучения (Zero-Shot Classification)

Кросс-модальные эмбеддинги позволяют классифицировать без специфичного обучения. Эта возможность выходит за рамки традиционных подходов компьютерного зрения — например, если вас интересует более специализированное обнаружение объектов с TensorFlow, это представляет собой дополняющий подход обучения с учителем для конкретных задач обнаружения.

def zero_shot_classify(image, candidate_labels: List[str], model, processor):

"""Классификация изображения в произвольные категории"""

# Создание текстовых запросов

text_inputs = [f"a photo of a {label}" for label in candidate_labels]

# Получение эмбеддингов

inputs = processor(

text=text_inputs,

images=image,

return_tensors="pt",

padding=True

)

outputs = model(**inputs)

# Вычисление вероятностей

logits = outputs.logits_per_image

probs = logits.softmax(dim=1)

# Возврат ранжированных предсказаний

sorted_indices = probs.argsort(descending=True)[0]

return [(candidate_labels[idx], probs[0][idx].item()) for idx in sorted_indices]

# Пример использования

labels = ["cat", "dog", "bird", "fish", "horse"]

predictions = zero_shot_classify(image, labels, model, processor)

print(f"Top prediction: {predictions[0]}")

Мультимодальный RAG (Retrieval-Augmented Generation)

Комбинация кросс-модальных эмбеддингов с языковыми моделями создает мощные мультимодальные системы RAG. После извлечения релевантных документов, переранжирование с моделями эмбеддингов может значительно улучшить качество результатов за счет переупорядочивания извлеченных кандидатов на основе релевантности:

class MultimodalRAG:

def __init__(self, clip_model, llm_model):

self.clip = clip_model

self.llm = llm_model

self.knowledge_base = []

def add_documents(self, images, texts, metadata):

"""Добавление мультимодальных документов в базу знаний"""

image_embeds = self.clip.encode_images(images)

text_embeds = self.clip.encode_text(texts)

# Хранение объединенной информации

for i, (img_emb, txt_emb, meta) in enumerate(

zip(image_embeds, text_embeds, metadata)

):

self.knowledge_base.append({

'image_embedding': img_emb,

'text_embedding': txt_emb,

'metadata': meta,

'index': i

})

def retrieve(self, query: str, k: int = 5):

"""Извлечение релевантного мультимодального контента"""

query_embedding = self.clip.encode_text([query])[0]

# Вычисление сходства

similarities = []

for doc in self.knowledge_base:

# Среднее сходство по модальностям

img_sim = np.dot(query_embedding, doc['image_embedding'])

txt_sim = np.dot(query_embedding, doc['text_embedding'])

combined_sim = (img_sim + txt_sim) / 2

similarities.append((combined_sim, doc))

# Возврат top-k

similarities.sort(reverse=True)

return [doc for _, doc in similarities[:k]]

def answer_query(self, query: str):

"""Ответ на запрос с использованием извлеченного мультимодального контекста"""

retrieved_docs = self.retrieve(query)

# Конструирование контекста из извлеченных документов

context = "\n".join([doc['metadata']['text'] for doc in retrieved_docs])

# Генерация ответа с LLM

prompt = f"Context:\n{context}\n\nQuestion: {query}\n\nAnswer:"

answer = self.llm.generate(prompt)

return answer, retrieved_docs

Если вы реализуете производственные системы RAG на Go, вам может быть полезно это руководство по переранжированию текстовых документов с Ollama и моделью Qwen3 Embedding на Go для оптимизации качества извлечения.

Контент-модерация и безопасность

Кросс-модальные эмбеддинги превосходно справляются с обнаружением недопустимого контента в различных модальностях:

class ContentModerator:

def __init__(self, model, processor):

self.model = model

self.processor = processor

# Определение категорий безопасности

self.unsafe_categories = [

"violent content",

"adult content",

"hateful imagery",

"graphic violence",

"explicit material"

]

self.safe_categories = [

"safe for work",

"family friendly",

"educational content"

]

def moderate_image(self, image, threshold: float = 0.3):

"""Проверка изображения на наличие небезопасного контента"""

# Объединение всех категорий

all_categories = self.unsafe_categories + self.safe_categories

text_inputs = [f"image containing {cat}" for cat in all_categories]

# Получение предсказаний

inputs = self.processor(

text=text_inputs,

images=image,

return_tensors="pt"

)

outputs = self.model(**inputs)

probs = outputs.logits_per_image.softmax(dim=1)[0]

# Проверка небезопасных категорий

unsafe_scores = probs[:len(self.unsafe_categories)]

max_unsafe_score = unsafe_scores.max().item()

return {

'is_safe': max_unsafe_score < threshold,

'confidence': 1 - max_unsafe_score,

'flagged_categories': [

self.unsafe_categories[i]

for i, score in enumerate(unsafe_scores)

if score > threshold

]

}

Лучшие практики и распространенные ошибки

Предварительная обработка данных

Правильная предварительная обработка критически важна для оптимальной производительности:

from torchvision import transforms

# Стандартная предобработка для CLIP

clip_transform = transforms.Compose([

transforms.Resize(224, interpolation=transforms.InterpolationMode.BICUBIC),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(

mean=[0.48145466, 0.4578275, 0.40821073],

std=[0.26862954, 0.26130258, 0.27577711]

)

])

Обработка предвзятости и справедливости

Кросс-модальные модели могут унаследовать предвзятость из обучающих данных:

Стратегии снижения предвзятости:

- Оценка на разнообразных демографических группах

- Использование техник снижения предвзятости при тонкой настройке

- Реализация справедливого извлечения

- Регулярный аудит и мониторинг в производственной среде

Оценка качества эмбеддингов

Мониторинг качества эмбеддингов в производственной среде:

def assess_embedding_quality(embeddings: np.ndarray):

"""Вычисление метрик для качества эмбеддингов"""

# Вычисление среднего парного расстояния

distances = np.linalg.norm(

embeddings[:, None] - embeddings[None, :],

axis=2

)

avg_distance = distances.mean()

# Проверка на кластеризацию (низкое внутрикластерное расстояние)

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=10)

labels = kmeans.fit_predict(embeddings)

# Вычисление коэффициента силуэта

from sklearn.metrics import silhouette_score

score = silhouette_score(embeddings, labels)

return {

'avg_pairwise_distance': avg_distance,

'silhouette_score': score

}

Пример развертывания Docker

Упакуйте ваше кроссмодальное приложение для легкого развертывания:

FROM nvidia/cuda:11.8.0-cudnn8-runtime-ubuntu22.04

# Установка Python и зависимостей

RUN apt-get update && apt-get install -y python3-pip

WORKDIR /app

# Установка требований

COPY requirements.txt .

RUN pip3 install --no-cache-dir -r requirements.txt

# Копирование кода приложения

COPY . .

# Открытие порта API

EXPOSE 8000

# Запуск сервера API

CMD ["uvicorn", "api:app", "--host", "0.0.0.0", "--port", "8000"]

# api.py - FastAPI сервер для кроссмодальных эмбеддингов

from fastapi import FastAPI, File, UploadFile

from pydantic import BaseModel

import torch

from PIL import Image

import io

app = FastAPI()

# Загрузка модели при старте

@app.on_event("startup")

async def load_model():

global model, processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

if torch.cuda.is_available():

model = model.cuda()

class TextQuery(BaseModel):

text: str

@app.post("/embed/text")

async def embed_text(query: TextQuery):

inputs = processor(text=[query.text], return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_text_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/embed/image")

async def embed_image(file: UploadFile = File(...)):

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(images=image, return_tensors="pt")

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_image_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/similarity")

async def compute_similarity(

text: TextQuery,

file: UploadFile = File(...)

):

# Получение обоих эмбеддингов

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(text=[text.text], images=image, return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

outputs = model(**inputs)

similarity = outputs.logits_per_image[0][0].item()

return {"similarity": similarity}

Перспективы развития

Область кроссмодальных эмбеддингов продолжает быстро развиваться:

Более широкое покрытие модальностей: Будущие модели, вероятно, будут включать дополнительные модальности, такие как осязание (тактильная обратная связь), запах и вкус, для действительно всеобъемлющего мультимодального понимания.

Повышенная эффективность: Исследования в области дистилляции и эффективных архитектур сделают мощные кроссмодальные модели доступными на устройствах края сети.

Лучшее выравнивание: Продвинутые техники для более точного выравнивания модальностей, включая циклосохраняющие потери и противоборствующее обучение.

Композиционное понимание: Переход от простого распознавания объектов к пониманию сложных отношений и композиций между модальностями.

Временное моделирование: Лучшее обращение с видеоданными и временными рядами с явным временным рассуждением в пространствах эмбеддингов.

Полезные ссылки

- OpenAI CLIP Repository

- OpenCLIP: Открытая реализация

- Документация Hugging Face Transformers

- Meta ImageBind

- Набор данных LAION-5B

- Документация FAISS

- База данных векторов Milvus

- База данных векторов Pinecone

- Статья: Обучение переносимым визуальным моделям с естественного языкового супервизора

- Статья: ImageBind: One Embedding Space To Bind Them All

- Обнаружение объектов с использованием тензорфлоу

- Ранжирование с моделями эмбеддингов

- Ранжирование текстовых документов с Ollama и моделью Qwen3 Embedding - на Go

- Модели Qwen3 Embedding & Reranker на Ollama: передовые технологии

Кроссмодальные эмбеддинги представляют собой парадигмальный сдвиг в том, как системы ИИ обрабатывают и понимают информацию. Разрушая барьеры между различными типами данных, эти техники позволяют создавать более естественные и способные приложения ИИ. Будь то создание систем поиска, инструментов модерации контента или творческих приложений, освоение кроссмодальных эмбеддингов открывает мир возможностей для инноваций в мультимодальном ИИ.