Docker Model Runner против Ollama (2026): что лучше для локальных LLMs?

Сравните Docker Model Runner и Ollama для локальных LLM

Запуск больших языковых моделей (LLM) локально стал все более популярным из-за приватности, контроля затрат и возможностей офлайн-работы. Ландшафт значительно изменился в апреле 2025 года, когда Docker представил Docker Model Runner (DMR), свое официальное решение для развертывания моделей ИИ.

Теперь три подхода конкурируют за внимание разработчиков: нативный Model Runner от Docker, сторонние контейнеризованные решения (vLLM, TGI) и автономная платформа Ollama.

Для более широкого обзора, включающего облачные провайдеры и компромиссы инфраструктуры, см. Хостинг LLM: локальный, саморазвертывание и облачная инфраструктура.

TL;DR – Docker Model Runner vs Ollama

Это сравнение сосредоточено на запуске больших языковых моделей (LLM) локально с использованием Docker или автономных рантаймов, включая производительность, поддержку GPU, совместимость API и сценарии развертывания в производстве.

- Лучше всего для Docker-нативных рабочих процессов: Docker Model Runner

- Лучше всего для простоты и быстрого прототипирования: Ollama

- Лучше всего для Kubernetes и оркестрации: настройки на основе Docker

- Лучше всего для разработки на одном компьютере: Ollama

Если вы уже активно используете Docker, то DMR имеет смысл. Если вы хотите самый быстрый способ запуска LLM локально, то Ollama проще.

Если вы сравниваете больше, чем просто Docker Model Runner и Ollama, посмотрите наше полное сравнение Ollama vs vLLM vs LM Studio и другие локальные инструменты LLM. Это руководство сравнивает зрелость API, поддержку оборудования, вызов инструментов и готовность к производству для 12+ локальных рантаймов LLM.

Docker Model Runner vs Ollama: прямое сравнение

С появлением официального решения Docker в пространстве LLM-раннеров сравнение становится более интересным. Вот как DMR и Ollama соотносятся друг с другом:

| Функция | Docker Model Runner | Ollama |

|---|---|---|

| Установка | Docker Desktop AI вкладка или docker-model-plugin |

Одна команда: curl | sh |

| Стиль команд | docker model pull/run/package |

ollama pull/run/list |

| Формат модели | GGUF (OCI Artifacts) | GGUF (нативный) |

| Распределение модели | Docker Hub, OCI реестры | Реестр Ollama |

| Настройка GPU | Автоматическая (проще, чем традиционный Docker) | Автоматическая |

| API | Совместимый с OpenAI | Совместимый с OpenAI |

| Интеграция с Docker | Нативная (это Docker) | Запускается в Docker при необходимости |

| Поддержка Compose | Нативная | Через Docker-образ |

| Кривая обучения | Низкая (для пользователей Docker) | Самая низкая (для всех) |

| Партнеры экосистемы | Google, Hugging Face, VMware | LangChain, CrewAI, Open WebUI |

| Лучше всего для | Docker-нативных рабочих процессов | Простота автономной работы |

Ключевое наблюдение: DMR приносит рабочие процессы Docker в развертывание LLM, в то время как Ollama остается независимым от фреймворков с более простой автономной работой. Ваша существующая инфраструктура имеет большее значение, чем технические различия.

Лучше ли Docker Model Runner, чем Ollama?

Это зависит от вашего рабочего процесса.

- Выберите Docker Model Runner (DMR), если ваша команда уже сильно полагается на Docker, OCI артефакты и оркестрацию контейнеров.

- Выберите Ollama, если вы хотите самый простой способ запуска LLM локально с минимальной настройкой и быстрым прототипированием.

Для большинства настроек на одном компьютере Ollama проще в использовании. Для Docker-нативных CI/CD конвейеров и корпоративных контейнерных рабочих процессов DMR интегрируется более естественно.

Как запустить LLM в Docker: DMR vs Ollama

Если ваша цель просто запустить LLM внутри Docker, оба решения — Docker Model Runner и Ollama в Docker-контейнерах — могут это сделать.

Docker Model Runner использует нативные команды docker model pull и docker model run, упаковывая модели как OCI артефакты.

Ollama также может запускаться внутри Docker с использованием официального образа ollama/ollama, предоставляя совместимый с OpenAI API на порту 11434.

Ключевое различие заключается в интеграции рабочих процессов:

- DMR естественно вписывается в Docker-нативные CI/CD конвейеры.

- Ollama в Docker предлагает более простое управление моделями с гибкостью оркестрации Docker.

Понимание Docker Model Runners

На основе контейнеризации модели-раннеры Docker упаковывают движки инференса LLM вместе с их зависимостями. Ландшафт включает как официальное решение Docker, так и сторонние фреймворки.

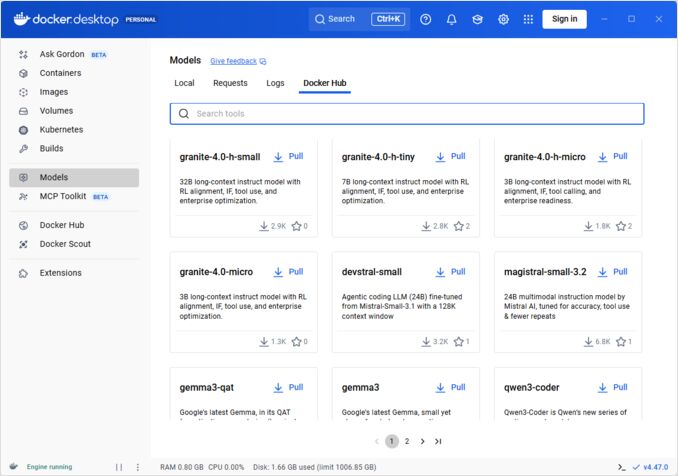

Docker Model Runner (DMR) - официальное решение

В апреле 2025 года Docker представил Docker Model Runner (DMR), официальный продукт, предназначенный для упрощения запуска моделей ИИ локально с использованием инфраструктуры Docker. Это демонстрирует приверженность Docker упрощению развертывания моделей ИИ так же, как развертывания контейнеров.

Основные функции DMR:

- Нативная интеграция с Docker: Использует знакомые команды Docker (

docker model pull,docker model run,docker model package) - Упаковка OCI Artifacts: Модели упаковываются как OCI Artifacts, что позволяет их распространение через Docker Hub и другие реестры

- API, совместимый с OpenAI: Замена для конечных точек OpenAI, упрощающая интеграцию

- Ускорение GPU: Нативная поддержка GPU без сложной конфигурации nvidia-docker

- Поддержка формата GGUF: Работает с популярными квантованными форматами моделей

- Интеграция с Docker Compose: Легко настраивайте и развертывайте модели с использованием стандартных инструментов Docker

- Поддержка Testcontainers: Бесшовная интеграция с фреймворками тестирования

Установка:

- Docker Desktop: Включите через вкладку AI в настройках

- Docker Engine: Установите пакет

docker-model-plugin

Пример использования:

# Загрузка модели из Docker Hub

docker model pull ai/smollm2

# Запуск инференса

docker model run ai/smollm2 "Объясните Docker Model Runner"

# Упаковка пользовательской модели

docker model package --gguf /path/to/model.gguf --push myorg/mymodel:latest

Для полного справочника команд docker model, вариантов упаковки, флагов конфигурации и практических примеров см. наше подробное руководство Docker Model Runner Cheatsheet: Commands & Examples. Оно охватывает загрузку моделей, упаковку, конфигурацию и лучшие практики для развертывания LLM локально с Docker.

DMR сотрудничает с Google, Hugging Face и VMware Tanzu для расширения экосистемы моделей ИИ, доступных через Docker Hub. Если вы новичок в Docker или вам нужна refresher по командам Docker, наше руководство Docker Cheatsheet предоставляет всестороннее руководство по основным операциям Docker.

Сторонние решения на основе Docker

Помимо DMR, экосистема включает установленные фреймворки:

- Контейнеры vLLM: Сервер инференса с высокой пропускной способностью, оптимизированный для пакетной обработки

- Text Generation Inference (TGI): Производственное решение от Hugging Face

- Контейнеры llama.cpp: Легковесная реализация на C++ с квантованием

- Пользовательские контейнеры: Обертки для PyTorch, Transformers или проприетарных фреймворков

Преимущества подхода Docker

Гибкость и независимость от фреймворков: Docker-контейнеры могут запускать любой фреймворк LLM, от PyTorch до ONNX Runtime, давая разработчикам полный контроль над стеком инференса.

Изоляция ресурсов: Каждый контейнер работает в изолированных средах с определенными ограничениями ресурсов (CPU, память, GPU), предотвращая конфликты ресурсов при развертывании нескольких моделей.

Поддержка оркестрации: Docker интегрируется бесшовно с Kubernetes, Docker Swarm и облачными платформами для масштабирования, балансировки нагрузки и высокой доступности.

Контроль версий: Разные версии моделей или фреймворков могут сосуществовать на одной системе без конфликтов зависимостей.

Недостатки подхода Docker

Сложность: Требует понимания контейнеризации, монтирования томов, сетевой конфигурации и передачи GPU (nvidia-docker).

Накладные расходы: Хотя минимальные, Docker добавляет тонкий слой абстракции, который немного влияет на время запуска и использование ресурсов.

Нагрузка на конфигурацию: Каждое развертывание требует тщательной настройки Dockerfile, переменных окружения и параметров времени выполнения.

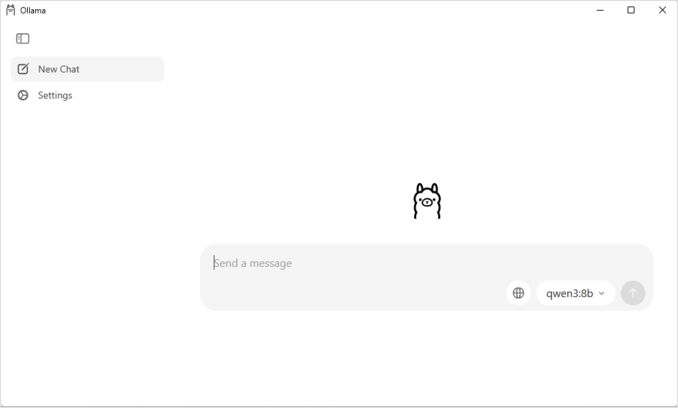

Понимание Ollama

Ollama — это специализированное приложение для запуска LLM локально, разработанное с упором на простоту как на его основной принцип. Оно предоставляет:

- Нативный бинарный файл для Linux, macOS и Windows

- Встроенная библиотека моделей с установкой в одну команду

- Автоматическое обнаружение и оптимизация GPU

- RESTful API, совместимый с форматом OpenAI

- Управление контекстом и состоянием модели

Преимущества Ollama

Простота: Установка проста (curl | sh на Linux), и запуск моделей требует только ollama run llama2. Для полного справочника команд CLI Ollama, таких как ollama serve, ollama run, ollama ps, и рабочих процессов управления моделями, см. наше руководство Ollama CLI Cheatsheet.

Оптимизированная производительность: Построенная на llama.cpp, Ollama высоко оптимизирована для скорости инференса с поддержкой квантования (Q4, Q5, Q8).

Управление моделями: Встроенный реестр моделей с командами ollama pull, ollama list, и ollama rm упрощает жизненный цикл модели.

Опыт разработчика: Чистый API, обширная документация и растущая экосистема интеграций (LangChain, CrewAI и др.). Гибкость Ollama распространяется на специализированные случаи использования, такие как переранжирование текстовых документов с моделями встраивания.

Эффективность использования ресурсов: Автоматическое управление памятью и разгрузка моделей при простое сохраняют системные ресурсы.

Недостатки Ollama

Зависимость от фреймворка: Основная поддержка моделей, совместимых с llama.cpp, ограничивает гибкость для фреймворков, таких как vLLM или пользовательские движки инференса.

Ограниченная настраиваемость: Расширенные конфигурации (пользовательское квантование, конкретные CUDA-потоки) менее доступны, чем в Docker-средах.

Проблемы оркестрации: Хотя Ollama может запускаться в контейнерах, он не поддерживает нативно расширенные функции оркестрации, такие как горизонтальное масштабирование.

Сравнение производительности

Скорость инференса

Docker Model Runner: Производительность сопоставима с Ollama, так как обе поддерживают квантованные модели GGUF. Для Llama 2 7B (Q4) ожидайте 20-30 токенов в секунду на CPU и 50-80 токенов в секунду на средних GPU. Минимальные накладные расходы контейнера.

Ollama: Использует высокооптимизированный бэкенд llama.cpp с эффективной квантованием. Для Llama 2 7B (Q4) ожидайте 20-30 токенов в секунду на CPU и 50-80 токенов в секунду на средних GPU. Нет накладных расходов на контейнеризацию. Для подробностей о том, как Ollama обрабатывает параллельные запросы, см. наш анализ на как Ollama обрабатывает параллельные запросы.

Docker (vLLM): Оптимизирован для пакетной обработки с непрерывным пакетным формированием. Одиночные запросы могут быть немного медленнее, но пропускная способность превосходит при высокой одновременной нагрузке (100+ токенов в секунду на модель с пакетным формированием).

Docker (TGI): Аналогично vLLM с отличной производительностью пакетного формирования. Добавляет функции, такие как потоковая передача и генерация токен за токеном.

Использование памяти

Docker Model Runner: Аналогично Ollama с автоматической загрузкой моделей. Модели GGUF Q4 обычно используют 4-6 ГБ ОЗУ. Накладные расходы контейнера минимальны (десятки МБ).

Конфигурация размера контекста может значительно влиять на использование памяти и поведение модели. По умолчанию некоторые образы Docker Model Runner CUDA жестко зашивают ограничение в 4096 токенов, даже если в docker-compose указаны более высокие значения. Для подробных шагов по изменению этого поведения и упаковке моделей с пользовательскими размерами контекста см. наше руководство по настройке размера контекста в Docker Model Runner.

Ollama: Автоматическое управление памятью загружает модели по требованию и разгружает при простое. Модель 7B Q4 обычно использует 4-6 ГБ ОЗУ. Наиболее эффективна для сценариев с одной моделью.

Традиционные Docker-решения: Использование памяти зависит от фреймворка. vLLM предварительно выделяет память GPU для оптимальной производительности, в то время как контейнеры на основе PyTorch могут использовать больше ОЗУ для весов модели и KV-кэша (8-14 ГБ для моделей 7B).

Время запуска

Docker Model Runner: Запуск контейнера добавляет ~1 секунду, плюс загрузка модели (2-5 секунды). Всего: 3-6 секунд для средних моделей.

Ollama: Почти мгновенный запуск с загрузкой модели, занимающей 2-5 секунд для моделей среднего размера. Самый быстрый холодный запуск.

Традиционные Docker: Запуск контейнера добавляет 1-3 секунды, плюс время загрузки модели. Предварительный нагрев контейнеров снижает это в производственных развертываниях.

Рекомендации по выбору сценариев использования

Выбирайте Docker Model Runner, когда

- Рабочий процесс на основе Docker: Ваша команда уже активно использует Docker

- Единые инструменты: Вы хотите использовать один инструмент (Docker) для контейнеров и моделей

- Распределение артефактов OCI: Вам нужна интеграция с корпоративными реестрами

- Интеграция с Testcontainers: Вы тестируете функции ИИ в CI/CD

- Предпочтение Docker Hub: Вы хотите распространять модели через знакомые каналы

Выбирайте Ollama, когда

- Быстрое прототипирование: Быстрое экспериментирование с разными моделями

- Независимость от фреймворка: Не привязаны к экосистеме Docker

- Абсолютная простота: Минимальная настройка и обслуживание

- Развертывание на одном сервере: Работа на ноутбуках, рабочих станциях или одном виртуальном машине

- Большая библиотека моделей: Доступ к обширному предварительно настроенному реестру моделей

Выбирайте сторонние Docker-решения, когда

- Производственные развертывания: Необходимость в продвинутой оркестрации и мониторинге

- Сервирование нескольких моделей: Запуск разных фреймворков (vLLM, TGI) одновременно

- Оркестрация Kubernetes: Масштабирование по кластерам с балансировкой нагрузки

- Пользовательские фреймворки: Использование Ray Serve или проприетарных движков инференса

- Строгий контроль ресурсов: Ограничение CPU/GPU на модель

Гибридные подходы: Лучшее из обоих миров

Вы не ограничены одним подходом. Рассмотрите эти гибридные стратегии:

Вариант 1: Docker Model Runner + Традиционные контейнеры

Используйте DMR для стандартных моделей и сторонние контейнеры для специализированных фреймворков:

# Загрузка стандартной модели с DMR

docker model pull ai/llama2

# Запуск vLLM для сценариев с высокой пропускной способностью

docker run --gpus all vllm/vllm-openai

Вариант 2: Ollama в Docker

Запускайте Ollama внутри Docker-контейнеров для возможностей оркестрации:

docker run -d \

--name ollama \

--gpus all \

-v ollama:/root/.ollama \

-p 11434:11434 \

ollama/ollama

Это обеспечивает:

- Интуитивное управление моделями Ollama

- Возможности оркестрации и изоляции Docker

- Развертывание в Kubernetes со стандартными манифестами

Вариант 3: Комбинирование по сценариям

- Разработка: Ollama для быстрой итерации

- Тестирование: Docker Model Runner для интеграционного тестирования

- Производство: vLLM/TGI в Kubernetes для масштабирования

Совместимость API

Все современные решения сходятся на совместимых с OpenAI API, упрощая интеграцию:

API Docker Model Runner: Совместимые с OpenAI конечные точки автоматически обслуживаются при запуске моделей. Дополнительная настройка не требуется.

# Модель запускается с автоматически открытым API

docker model run ai/llama2

# Использование совместимого с OpenAI конечного пункта

curl http://localhost:8080/v1/chat/completions -d '{

"model": "llama2",

"messages": [{"role": "user", "content": "Почему небо голубое?"}]

}'

API Ollama: Совместимые с OpenAI конечные точки делают его прямой заменой для приложений, использующих SDK OpenAI. Потоковая передача полностью поддерживается.

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt": "Почему небо голубое?"

}'

API сторонних Docker-решений: vLLM и TGI предлагают совместимые с OpenAI конечные точки, в то время как пользовательские контейнеры могут реализовывать проприетарные API.

Совместимость с OpenAI означает, что вы можете переключаться между решениями с минимальными изменениями кода.

Управление ресурсами

Ускорение на GPU

Docker Model Runner: Нативная поддержка GPU без сложной настройки nvidia-docker. Автоматически обнаруживает и использует доступные GPU, значительно упрощая работу с GPU в Docker по сравнению с традиционными контейнерами.

Если вы используете GPU NVIDIA и хотите правильно настроить ускорение CUDA, см. наше подробное руководство по добавлению поддержки GPU NVIDIA в Docker Model Runner. Оно охватывает настройку Docker daemon, установку NVIDIA Container Toolkit и как проверить, что ваша LLM действительно использует память GPU, а не переходит на инференс на CPU.

# Ускорение GPU работает автоматически

docker model run ai/llama2

Ollama: Автоматическое обнаружение GPU на CUDA-совместимых GPU NVIDIA. Не требуется настройка, кроме установки драйверов.

Традиционные Docker-контейнеры: Требуется runtime nvidia-docker и явное выделение GPU:

docker run --gpus all my-llm-container

Резервное копирование на CPU

Оба плавно переходят на инференс на CPU, когда GPU недоступны, хотя производительность значительно снижается (в 5-10 раз медленнее для больших моделей). Для получения информации о производительности только на CPU на современных процессорах прочитайте наш тест на как Ollama использует производительные и эффективные ядра Intel CPU.

Поддержка нескольких GPU

Ollama: Поддерживает тензорное параллелизм на нескольких GPU для больших моделей.

Docker: Зависит от фреймворка. vLLM и TGI поддерживают инференс на нескольких GPU с правильной настройкой.

Сообщество и экосистема

Docker Model Runner: Запущен в апреле 2025 года с сильной корпоративной поддержкой. Партнерства с Google, Hugging Face и VMware Tanzu AI Solutions обеспечивают широкое наличие моделей. Интеграция с огромным сообществом разработчиков Docker (миллионы пользователей) обеспечивает мгновенный доступ к экосистеме. Пока создаются ресурсы, специфичные для сообщества, как новый продукт.

Ollama: Быстро растущее сообщество с 50K+ звездами на GitHub. Сильная интеграция с экосистемой (LangChain, LiteLLM, Open WebUI, CrewAI) и активное сообщество в Discord. Много сторонних инструментов и руководств доступны. Более зрелые документация и ресурсы сообщества. Для всестороннего обзора доступных интерфейсов см. наше руководство по открытым исходным чат-интерфейсам для локальных инстансов Ollama. Как и в случае любого быстро растущего проекта с открытым исходным кодом, важно следить за направлением проекта - прочитайте наш анализ первых признаков ухудшения Ollama для понимания потенциальных проблем.

Сторонние Docker-решения: vLLM и TGI имеют зрелые экосистемы с корпоративной поддержкой. Много производственных кейсов, руководств по оптимизации и паттернов развертывания от Hugging Face и сообщества.

Рассмотрение затрат

Docker Model Runner: Бесплатен с Docker Desktop (личное/образовательное) или Docker Engine. Docker Desktop требует подписки для крупных организаций (250+ сотрудников или доход $10M+). Модели, распространяемые через Docker Hub, следуют ценообразованию Docker (бесплатные публичные репозитории, платные частные репозитории).

Ollama: Полностью бесплатный и с открытым исходным кодом без лицензионных затрат независимо от размера организации. Затраты на ресурсы зависят только от оборудования.

Сторонние Docker-решения: Бесплатны для фреймворков с открытым исходным кодом (vLLM, TGI). Возможные затраты на платформы оркестрации контейнеров (ECS, GKE) и хранение в частных реестрах.

Рассмотрение безопасности

Docker Model Runner: Использует модель безопасности Docker с изоляцией контейнеров. Модели, упакованные как артефакты OCI, могут быть проверены и подписаны. Распределение через Docker Hub обеспечивает контроль доступа и сканирование уязвимостей для корпоративных пользователей.

Ollama: Работает как локальный сервис с API, открытым на localhost по умолчанию. Сетевое взаимодействие требует явной настройки. Реестр моделей доверен (курируется Ollama), снижая риски цепочки поставок.

Традиционные Docker-решения: Встроенная сетевая изоляция. Сканирование безопасности контейнеров (Snyk, Trivy) и подпись изображений являются стандартными практиками в производственных средах.

Все решения требуют внимания к:

- Происхождение модели: Недоверенные модели могут содержать вредоносный код или бэкдоры

- Аутентификация API: Реализация аутентификации/авторизации в производственных развертываниях

- Ограничение скорости: Предотвращение злоупотреблений и истощения ресурсов

- Сетевое взаимодействие: Убедитесь, что API не случайно открыты в интернет

- Конфиденциальность данных: Модели обрабатывают конфиденциальные данные; обеспечьте соответствие нормам защиты данных

Пути миграции

От Ollama к Docker Model Runner

Поддержка GGUF в Docker Model Runner делает миграцию простой:

- Включите Docker Model Runner в Docker Desktop или установите

docker-model-plugin - Преобразуйте ссылки на модели:

ollama run llama2→docker model pull ai/llama2иdocker model run ai/llama2 - Обновите конечные точки API с

localhost:11434на конечную точку DMR (обычноlocalhost:8080) - Оба используют совместимые с OpenAI API, поэтому код приложения требует минимальных изменений

От Docker Model Runner к Ollama

Переход на Ollama для более простой автономной работы:

- Установите Ollama:

curl -fsSL https://ollama.ai/install.sh | sh. Для полного списка команд CLI Ollama и параметров конфигурации обратитесь к шпаргалке CLI Ollama. - Загрузите эквивалентные модели:

ollama pull llama2 - Обновите конечные точки API до

localhost:11434Ollama - Проверьте с

ollama run llama2, чтобы убедиться в работоспособности

От традиционных Docker-контейнеров к DMR

Упростите настройку Docker LLM:

- Включите Docker Model Runner

- Замените пользовательские Dockerfile командами

docker model pull - Удалите настройки nvidia-docker (DMR автоматически обрабатывает GPU)

- Используйте

docker model runвместо сложных командdocker run

От любого решения к Ollama в Docker

Подход “лучшее из обоих миров”:

docker pull ollama/ollama- Запуск:

docker run -d --gpus all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama - Используйте команды Ollama как обычно:

docker exec -it ollama ollama pull llama2 - Получите оркестрацию Docker с простотой Ollama

Мониторинг и наблюдаемость

Ollama: Базовые метрики через API (/api/tags, /api/ps). Третьими лицами разработаны инструменты, такие как Open WebUI, предоставляющие дашборды.

Docker: Полная интеграция с Prometheus, Grafana, ELK stack и облачными сервисами мониторинга. Метрики контейнеров (CPU, память, GPU) легко доступны.

Заключение

Ландшафт локального развертывания LLM значительно эволюционировал с появлением Docker Model Runner (DMR) в 2025 году. Выбор теперь зависит от ваших конкретных требований:

- Для разработчиков, ищущих интеграцию с Docker: DMR предоставляет нативную интеграцию с Docker с командами

docker model - Для максимальной простоты: Ollama остается самым простым решением с управлением моделей в один клик

- Для производства и корпоративного использования: как DMR, так и сторонние решения (vLLM, TGI) в Docker предлагают оркестрацию, мониторинг и масштабируемость

- Для лучшего из обоих: Запускайте Ollama в Docker-контейнерах, чтобы сочетать простоту с производственной инфраструктурой

Появление DMR сокращает разрыв между Docker и Ollama в плане удобства использования. Ollama все еще выигрывает в простоте для быстрого прототипирования, в то время как DMR преуспевает для команд, уже использующих рабочие процессы Docker. Оба подхода активно развиваются, готовы к производству, и экосистема достаточно зрелая, чтобы переключение между ними было относительно безболезненным.

Итог: Если вы уже активно используете Docker, DMR — естественный выбор. Если вы хотите самый простой опыт, независимо от инфраструктуры, выберите Ollama. Чтобы сравнить эти локальные варианты с облачными API и другими самоподдерживаемыми настройками, ознакомьтесь с нашим руководством LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Полезные ссылки

Docker Model Runner

- Официальная страница Docker Model Runner

- Документация Docker Model Runner

- Руководство по началу работы с Docker Model Runner

- Блог с объявлением Docker Model Runner

Ollama

Другие решения Docker

- Документация vLLM

- Hugging Face Text Generation Inference

- Репозиторий llama.cpp на GitHub

- NVIDIA Container Toolkit