Интерфейсы чатов для локальных Ollama сервисов

Краткий обзор наиболее заметных интерфейсов для Ollama в 2025 году

Локально установленные сервис Ollama позволяет запускать большие языковые модели на вашем собственном компьютере, но использование его через командную строку не очень удобно. Вот несколько открытых проектов, которые предоставляют интерфейсы в стиле ChatGPT, подключающиеся к локальному Ollama.

Эти интерфейсы поддерживают разговорный чат, часто с функциями, такими как загрузка документов для генерации с дополнением извлечения (RAG), и работают как веб- или настольные приложения. Ниже приведена сравнительная таблица ключевых вариантов, за которой следуют подробные разделы о каждом.

Сравнение интерфейсов, совместимых с Ollama

| Инструмент интерфейса | Платформа | Поддержка документов | Интеграция с Ollama | Сильные стороны | Ограничения |

|---|---|---|---|---|---|

| Page Assist | Расширение для браузера (Chrome, Firefox) | Да – добавление файлов для анализа | Подключается к локальному Ollama через настройки расширения | Чат в браузере; простое управление моделями и интеграция контекста веб-страницы. | Только для браузера; требуется установка/настройка расширения. |

| Open WebUI | Веб-приложение (самостоятельный хостинг; Docker/PWA) | Да – встроенная RAG (загрузка документов или добавление в библиотеку) | Прямая поддержка API Ollama или встроенный сервер (настройка базового URL) | Богатый функционал (множество LLM, офлайн-режим, генерация изображений); мобильная дружелюбность (PWA). | Настройка сложнее (Docker/K8s); широкий функционал может быть избыточным для простого использования. |

| LobeChat | Веб-приложение (самостоятельный хостинг; поддержка PWA) | Да – «База знаний» с загрузкой файлов (PDF, изображения и т.д.) | Поддерживает Ollama как один из нескольких бэкендов ИИ (требуется включение доступа к API Ollama) | Элегантный интерфейс в стиле ChatGPT; голосовой чат, плагины и поддержка нескольких моделей. | Сложный функционал; требуется настройка окружения (например, межпроисхождение для Ollama). |

| LibreChat | Веб-приложение (самостоятельный хостинг; много пользователей) | Да – «Чат с файлами» с использованием RAG (через встраивания) | Совместим с Ollama и многими другими поставщиками (переключаемый на уровне чата) | Знакомый интерфейс в стиле ChatGPT; богатый функционал (агенты, интерпретатор кода и т.д.). | Установка/настройка может быть сложной; большой проект может быть избыточным для базового использования. |

| AnythingLLM | Настольное приложение (Windows, Mac, Linux) или веб (Docker) | Да – встроенная RAG: перетаскивание документов (PDF, DOCX и т.д.) с цитатами | Ollama поддерживается как поставщик LLM (устанавливается в конфигурации или Docker env) | Все в одном интерфейсе (частный ChatGPT с вашими документами); конструктор агентов без кода, поддержка нескольких пользователей. | Более высокое потребление ресурсов (база данных встраиваний и т.д.); настольное приложение не имеет некоторых функций для нескольких пользователей. |

| Chat-with-Notes | Веб-приложение (легковесный сервер Flask) | Да – загрузка текстовых/PDF-файлов и чат с их содержимым | Использует Ollama для всех ответов ИИ (требуется локальный запуск Ollama) | Очень простая установка и интерфейс, ориентированный на документный Q&A; данные остаются локально. | Базовый интерфейс и функционал; один пользователь, один документ за раз (нет продвинутых функций). |

Каждый из этих инструментов активно поддерживается и является открытым исходным кодом. Далее мы углубляемся в детали каждого варианта, включая то, как они работают с Ollama, заметные функции и компромиссы.

Page Assist (Расширение для браузера)

Page Assist — это открытое расширение для браузера, которое добавляет локальный чат с LLM в ваш браузер. Оно поддерживает браузеры на основе Chromium и Firefox, предлагая боковую панель или вкладку в стиле ChatGPT, где вы можете общаться с моделью. Page Assist может подключаться к локально работающему Ollama в качестве поставщика ИИ или другим локальным бэкендам через свои настройки. Особенно стоит отметить, что оно позволяет добавлять файлы (например, PDF или текст) для анализа ИИ в чате, что обеспечивает базовые рабочие процессы RAG. Вы даже можете использовать его для помощи с содержимым текущей веб-страницы или выполнения веб-поиска для получения информации.

Установка проста: установите расширение из Chrome Web Store или Firefox Add-ons, убедитесь, что Ollama работает, и выберите Ollama в качестве локального поставщика ИИ в настройках Page Assist. Интерфейс включает функции, такие как история чатов, выбор модели и опциональная общедоступная ссылка для результатов чата. Также доступен веб-интерфейс через горячую клавишу, если вы предпочитаете полноэкранный чат.

Сильные стороны: Page Assist легковесный и удобный — поскольку он находится в браузере, не требуется отдельный сервер. Он отлично подходит для контекста просмотра (вы можете открыть его на любой веб-странице) и поддерживает интеграцию интернет-поиска и вложения файлов для обогащения разговора. Он также предоставляет полезные функции, такие как горячие клавиши для нового чата и переключения боковой панели.

Ограничения: Будучи расширением, оно ограничено браузерной средой. Интерфейс проще и несколько менее функционален, чем полноценные автономные чат-приложения. Например, управление несколькими пользователями или продвинутые агентские плагины не входят в его задачи. Также начальная настройка может потребовать сборки/загрузки расширения, если для вашего браузера нет предварительно упакованной версии (проект предоставляет инструкции по сборке с использованием Bun или npm). В целом, Page Assist лучше всего подходит для индивидуального использования, когда вы хотите быстрый доступ к чату, работающему на основе Ollama, во время просмотра веб-страниц, с умеренными возможностями RAG.

Open WebUI (Самостоятельное веб-приложение)

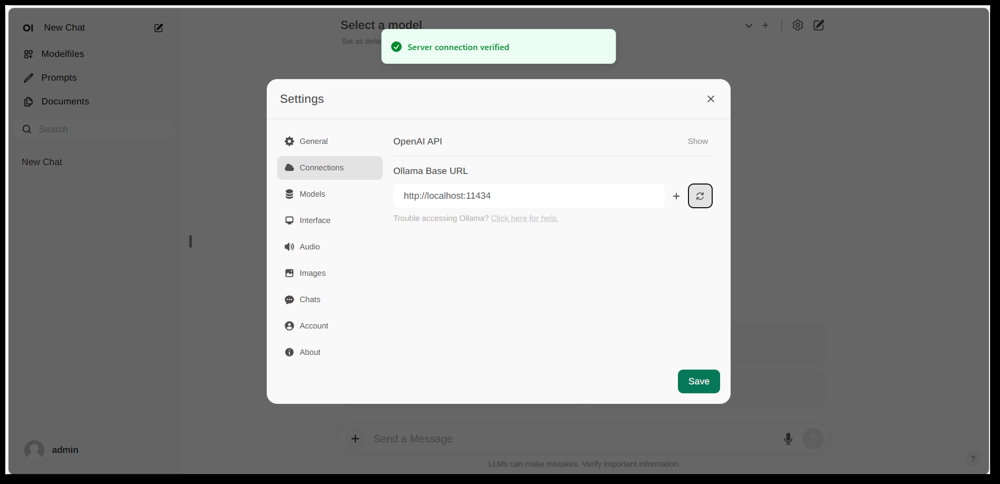

Интерфейс настроек Open WebUI, показывающий подключение к Ollama (базовый URL установлен на локальный API Ollama). Интерфейс включает раздел Документы, обеспечивающий рабочие процессы RAG.

Open WebUI — это мощное, универсальное фронтенд-приложение для чата, изначально созданное для работы с Ollama, и теперь расширенное для поддержки различных бэкендов LLM. Оно работает как самостоятельное веб-приложение и обычно развертывается через Docker или Kubernetes для упрощения настройки. После запуска вы получаете к нему доступ через браузер (с поддержкой установки в качестве Progressive Web App на мобильных устройствах).

Open WebUI предлагает полный интерфейс чата с поддержкой нескольких пользователей, управлением моделями и обширным функционалом. Критически важно, что у него есть встроенные возможности RAG — вы можете загружать или импортировать документы в библиотеку документов, а затем задавать вопросы с дополнением извлечения. Интерфейс позволяет загружать документы непосредственно в сессию чата или поддерживать постоянную библиотеку знаний. Он даже поддерживает выполнение веб-поиска и вставку результатов в разговор для получения актуальной информации.

Интеграция с Ollama: Open WebUI подключается к Ollama через его API. Вы можете либо запустить контейнер Open WebUI Docker вместе с сервером Ollama и установить переменную окружения для указания URL Ollama, либо использовать специальный образ Docker, который включает Ollama с веб-интерфейсом. На практике, после запуска контейнеров, вы посетите Open WebUI в своем браузере и увидите «Подтверждение подключения к серверу», если настроено правильно (как показано на изображении выше). Это означает, что интерфейс готов использовать ваши локальные модели Ollama для чата. Open WebUI также поддерживает совместимые с OpenAI API конечные точки, поэтому он может взаимодействовать с LM Studio, OpenRouter и т.д., помимо Ollama.

Сильные стороны: Это решение является одним из наиболее функционально богатых и гибких интерфейсов. Оно поддерживает несколько одновременно работающих моделей и потоков разговоров, пользовательские «персонажи» или системные подсказки, генерацию изображений и многое другое. Реализация RAG надежна — вы получаете полный интерфейс для управления документами и даже настройки, какой векторное хранилище или сервис поиска использовать для извлечения. Open WebUI также активно разрабатывается (с обширным сообществом, что подтверждается высоким количеством звезд на GitHub) и разработан для расширяемости и масштабируемости. Это хороший выбор, если вы хотите всестороннее, универсальное чат-интерфейс для локальных моделей, особенно в сценарии с несколькими пользователями или сложными случаями использования.

Ограничения: С большой мощностью приходит большая сложность. Open WebUI может быть избыточным для простого личного использования — развертывание контейнеров Docker и управление конфигурацией могут быть пугающими, если вы не знакомы. Он потребляет больше ресурсов, чем легковесное приложение, поскольку запускает веб-сервер, опциональную базу данных для истории чатов и т.д. Также функции, такие как управление доступом на основе ролей и управление пользователями, хотя и полезны, указывают на то, что он ориентирован на серверную установку — один пользователь на домашнем ПК может не нуждаться во всем этом. Короче говоря, настройка сложнее, и интерфейс может показаться сложным, если вам нужен просто базовый клон ChatGPT. Но для тех, кто действительно нуждается в его обширном функционале (или хочет легко переключаться между Ollama и другими поставщиками моделей в одном интерфейсе), Open WebUI является одним из лучших вариантов.

LobeChat (Фреймворк в стиле ChatGPT с плагинами)

Баннер интерфейса LobeChat, показывающий поддержку “Ollama” и несколько локальных моделей. LobeChat позволяет развернуть веб-приложение в стиле ChatGPT с помощью Ollama или других провайдеров, включая функции ввода голоса и плагинов.

LobeChat — это открытый фреймворк для чатов, который делает акцент на отточенном пользовательском опыте и гибкости. Это, по сути, веб-приложение в стиле ChatGPT, которое можно развернуть на своем сервере, с поддержкой нескольких поставщиков ИИ — от OpenAI и Anthropic до открытых моделей через Ollama. LobeChat разработан с учетом конфиденциальности (вы запускаете его самостоятельно) и имеет современный интерфейс, включающий удобства, такие как память беседы, режим голосового общения и даже генерация текста в изображение через плагины.

Одной из ключевых особенностей LobeChat является возможность базы знаний. Вы можете загружать документы (в форматах, таких как PDF, изображения, аудио, видео) и создавать базу знаний, которую можно использовать во время чата. Это означает, что вы можете задавать вопросы о содержимом своих файлов — рабочий процесс RAG, который LobeChat поддерживает из коробки. Интерфейс предоставляет управление этими файлами/базами знаний и позволяет включать/выключать их использование в беседе, что дает более богатый опыт Q&A за пределами базового LLM.

Чтобы использовать LobeChat с Ollama, вам нужно развернуть приложение LobeChat (например, с помощью предоставленного Docker-образа или скрипта) и настроить Ollama в качестве бэкенда. LobeChat распознает Ollama как поставщика первого класса — он даже предлагает скрипт развертывания в один клик через браузер Pinokio AI, если вы его используете. На практике, возможно, вам потребуется настроить параметры Ollama (например, включить CORS в соответствии с документацией LobeChat), чтобы веб-интерфейс LobeChat мог получить доступ к HTTP API Ollama. После настройки вы можете выбрать модель, размещенную на Ollama, в интерфейсе LobeChat и общаться с ней, включая запросы к загруженным документам.

Преимущества: Интерфейс LobeChat часто хвалят за его чистоту и удобство использования, он очень похож на внешний вид и ощущения ChatGPT (что облегчает адаптацию). Он добавляет ценность с дополнительными функциями, такими как ввод/вывод голоса для устных разговоров и система плагинов для расширения функциональности (похожая на плагины ChatGPT, позволяющая такие вещи, как просмотр веб-страниц или генерация изображений). Поддержка нескольких моделей означает, что вы можете легко переключаться между, например, локальной моделью Ollama и моделью OpenAI API в одном интерфейсе. Он также поддерживает установку в виде мобильного PWA, поэтому вы можете получить доступ к своему локальному чату в пути.

Ограничения: Настройка LobeChat может быть сложнее, чем у некоторых альтернатив. Это полноценное приложение (часто запускаемое с Docker Compose), поэтому есть некоторая нагрузка. В частности, настройка интеграции с Ollama требует включения межпроисходных запросов с стороны Ollama и обеспечения совпадения портов — это разовая задача, но техническая. Кроме того, хотя LobeChat довольно мощный, не все функции могут быть нужны каждому пользователю; например, если вам не нужна поддержка нескольких поставщиков или плагины, интерфейс может показаться перегруженным по сравнению с минимальным инструментом. Наконец, некоторые продвинутые функции, такие как развертывание в один клик, предполагают определенные среды (браузер Pinokio или Vercel), которые вы можете или не использовать. В целом, LobeChat идеален, если вы хотите полнофункциональную альтернативу ChatGPT, которая работает локально с Ollama, и вам не против немного начальной настройки, чтобы этого достичь.

LibreChat (Клон ChatGPT с поддержкой нескольких поставщиков)

LibreChat (ранее известный как ChatGPT-Clone или UI) — это открытый проект, направленный на воспроизведение и расширение интерфейса и функциональности ChatGPT. Его можно развернуть локально (или на своем сервере) и он поддерживает различные бэкенды ИИ — включая открытые модели через Ollama. Суть LibreChat заключается в предоставлении знакомого чат-опыта (интерфейс диалога с историей, сообщениями пользователя и ассистента), позволяя подключать различные поставщики моделей на бэкенде.

LibreChat поддерживает взаимодействие с документами и RAG через дополнение, называемое RAG API и сервисами встраивания. В интерфейсе вы можете использовать функции, такие как «Чат с файлами», которые позволяют загружать документы и затем задавать вопросы о них. Под капотом это использует встраивания и векторное хранилище для получения релевантного контекста из ваших файлов. Это означает, что вы можете достичь аналогичного эффекта, как ChatGPT + пользовательские знания, все локально. Проект даже предоставляет отдельный репозиторий для сервиса RAG, если вы хотите его самостоятельно развернуть.

Использование LibreChat с Ollama обычно включает запуск сервера LibreChat (например, через Node/Docker) и обеспечение его возможности доступа к сервису Ollama. LibreChat имеет настройку «Пользовательский конечный пункт», где можно ввести URL API, совместимого с OpenAI. Поскольку Ollama может экспонировать локальный API, совместимый с OpenAI, LibreChat можно направить на http://localhost:11434 (или куда бы ни слушал Ollama). На самом деле, LibreChat явно перечисляет Ollama среди поддерживаемых поставщиков ИИ — наряду с другими, такими как OpenAI, Cohere и т.д. После настройки вы можете выбрать модель (модель Ollama) в выпадающем списке и начать чат. LibreChat также позволяет переключаться между моделями или поставщиками даже в середине беседы и поддерживает несколько чат-пресетов/контекстов.

Преимущества: Основное преимущество LibreChat — это богатый набор функций, построенных вокруг чат-опыта. Он включает такие вещи, как ветвление бесед, поиск сообщений, встроенная поддержка Code Interpreter (безопасное выполнение кода в песочнице) и интеграции инструментов/агентов. Это, по сути, ChatGPT++, с возможностью интеграции локальных моделей. Для тех, кто любит интерфейс ChatGPT, LibreChat будет очень знакомым и потребует минимального обучения. Проект активен и поддерживается сообществом (как свидетельствуют его частые обновления и обсуждения), и он очень гибкий: вы можете подключаться к различным конечным точкам LLM или даже запускать его в многопользовательском режиме с аутентификацией для командной работы.

Ограничения: С множеством функций LibreChat может быть более тяжелым для запуска. Установка может включать настройку базы данных для хранения чатов и конфигурацию переменных окружения для различных API. Если вы включите все компоненты (RAG, агенты, генерацию изображений и т.д.), это довольно сложная структура. Для одного пользователя, которому нужен только базовый чат с одной локальной моделью, LibreChat может быть избыточным. Кроме того, хотя интерфейс знакомый, он не сильно специализирован для работы с документами — он выполняет свою работу, но не имеет выделенного интерфейса «библиотеки документов» (загрузки обычно выполняются внутри чата или через API). Короче говоря, LibreChat сияет, когда вы хотите полноценную среду в стиле ChatGPT с рядом функций, работающую локально, но более простые решения могут быть достаточными для узкоспециализированных сценариев.

AnythingLLM (Все-в-одном настольное или серверное приложение)

AnythingLLM — это все-в-одном приложение ИИ, которое делает акцент на RAG и простоте использования. Оно позволяет «общаться с вашими документами» с использованием либо открытых моделей LLM, либо моделей OpenAI, все через единый интерфейс. Особенно стоит отметить, что AnythingLLM доступен как кроссплатформенное настольное приложение (для Windows, Mac, Linux) и как саморазвертываемый веб-сервер (через Docker). Эта гибкость означает, что вы можете запускать его как обычное приложение на вашем ПК или развернуть его для нескольких пользователей на сервере.

Обработка документов — это основа AnythingLLM. Вы можете перетаскивать документы (PDF, TXT, DOCX и т.д.) в приложение, и оно автоматически индексирует их в векторную базу данных (по умолчанию используется LanceDB). В интерфейсе чата, когда вы задаете вопросы, он будет извлекать релевантные фрагменты из ваших документов и предоставлять цитируемые ответы, чтобы вы знали, из какого файла и раздела поступила информация. Суть в том, что он создает для вас частную базу знаний и позволяет LLM использовать ее в качестве контекста. Вы можете организовывать документы в «рабочих пространствах» (например, одно рабочее пространство на проект или тему), изолируя контексты по мере необходимости.

Использование Ollama с AnythingLLM просто. В настройках вы выбираете Ollama в качестве поставщика LLM. Если вы запускаете через Docker, вы устанавливаете переменные окружения, такие как LLM_PROVIDER=ollama и предоставляете OLLAMA_BASE_PATH (URL вашего экземпляра Ollama). Сервер AnythingLLM затем будет отправлять все запросы моделей в API Ollama. Ollama официально поддерживается, и в документации отмечается, что вы можете использовать его для запуска различных открытых моделей (например, Llama 2, Mistral и т.д.) локально. Фактически, разработчики подчеркивают, что комбинация AnythingLLM с Ollama разблокирует мощные возможности оффлайн RAG: Ollama обрабатывает инференцию модели, а AnythingLLM обрабатывает встраивания и логику интерфейса/агента.

Преимущества: AnythingLLM предоставляет комплексное решение для частного Q&A и чата. Ключевые преимущества включают: простую настройку для RAG (тяжелая работа по встраиванию и хранению векторов автоматизирована), поддержку нескольких документов с четким цитированием источников и дополнительные функции, такие как ИИ-агенты (у него есть конструктор агентов без кода, где вы можете создавать пользовательские рабочие процессы и использование инструментов). Он также поддерживает многопользовательский режим из коробки (особенно в серверном режиме), с учетными записями пользователей и разрешениями при необходимости. Интерфейс разработан для простоты (чат-бокс + боковая панель с документами/рабочими пространствами), но мощный под капотом. Для личного использования настольное приложение — это большое преимущество — вы получаете приложение с нативным ощущением без необходимости открывать браузер или запускать команды, и оно хранит данные локально по умолчанию.

Ограничения: Поскольку он интегрирует множество компонентов (API LLM, модели встраивания, векторная БД и т.д.), AnythingLLM может быть ресурсоемким. При импорте документов может потребоваться время и память для генерации встраиваний (он даже поддерживает использование самого Ollama или локальных моделей для встраиваний с моделями, такими как nomic-embed). Настольное приложение упрощает использование, но если у вас много документов или очень большие файлы, ожидайте некоторой тяжелой обработки в фоне. Еще одно ограничение заключается в том, что продвинутые пользователи могут найти его менее настраиваемым, чем сборка собственного стека — например, в настоящее время он использует LanceDB или Chroma; если вы хотели бы другую векторную хранилище, вам пришлось бы погружаться в конфигурацию или код. Также, хотя поддержка нескольких поставщиков поддерживается, интерфейс действительно настроен на одну модель за раз (вы бы изменили глобальную настройку поставщика, если хотите использовать другую модель). В итоге, AnythingLLM — это отличное решение из коробки для локального чата с документами, особенно с Ollama, но это более крупное приложение для запуска по сравнению с минимальными интерфейсами.

Chat-with-Notes (Минимальный интерфейс чата с документами)

Chat-with-Notes — это минималистичное приложение, специально разработанное для общения с локальными текстовыми файлами с использованием моделей, управляемых Ollama. Это, по сути, легковесный веб-сервер Flask, который вы запускаете на своем ПК, предоставляя простую веб-страницу, где можно загрузить документ и начать с ним чат. Основная цель этого проекта — простота: в нем нет множества дополнительных функций, но он выполняет основную задачу — ответы на вопросы по документу с использованием локальной LLM.

Использование Chat-with-Notes начинается с проверки, что ваш экземпляр Ollama запускает модель (например, вы можете запустить Ollama с командой ollama run llama2 или другой моделью). Затем вы запускаете приложение Flask (python app.py) и открываете локальный веб-сайт. Интерфейс предложит вам загрузить файл (поддерживаются форматы: обычный текст, Markdown, файлы кода, HTML, JSON и PDF). После загрузки текстовое содержимое файла отображается, и вы можете задавать вопросы или общаться с ИИ о его содержимом. Общение происходит в привычном формате чат-окон. Если вы загрузите новый файл в середине беседы, приложение спросит, хотите ли вы начать новый чат или сохранить текущий контекст и просто добавить информацию из нового файла. Таким образом, вы можете обсуждать несколько файлов последовательно, если это необходимо. Также есть кнопки для очистки чата или экспорта беседы в текстовый файл.

Под капотом Chat-with-Notes обращается к API Ollama для генерации ответов. Ollama управляет инференсом модели, а Chat-with-Notes просто предоставляет промпт (который включает соответствующие части загруженного текста). Он не использует векторную базу данных; вместо этого он просто отправляет все содержимое файла (или его части) вместе с вашим вопросом модели. Этот подход лучше всего работает для документов разумного размера, которые помещаются в окно контекста модели.

Преимущества: Приложение чрезвычайно простое в развертывании и использовании. Нет сложной настройки — если у вас установлены Python и Ollama, вы сможете его запустить за минуту или две. Интерфейс чистый и минималистичный, сосредоточенный на текстовом содержимом и вопросах и ответах. Благодаря своей сосредоточенности, он гарантирует, что все данные остаются локальными и только в оперативной памяти (нет внешних вызовов, кроме вызовов Ollama на localhost). Это отличный выбор, если вы хотите конкретно общаться с файлами и не нуждаетесь в общем общении без документа.

Ограничения: Минимализм Chat-with-Notes означает, что он не имеет многих функций, которые есть в других интерфейсах. Например, он не поддерживает использование нескольких моделей или поставщиков (он работает только с Ollama по дизайну), и он не поддерживает долгосрочную библиотеку документов — вы загружаете файлы по мере необходимости в каждой сессии, и нет постоянного векторного индекса. Масштабирование на очень большие документы может быть проблематичным без ручных настроек, так как он может пытаться включить много текста в промпт. Также интерфейс, хотя и функциональный, не такой полированный (нет темного режима, нет форматирования ответов с использованием богатого текста и т. д.). В сущности, этот инструмент идеален для быстрого анализа файлов с моделью Ollama. Если ваши потребности растут (например, много документов или желание более красивого интерфейса), вы можете перерасти Chat-with-Notes. Но как точка отправления или личное решение «задай вопрос моему PDF» на основе Ollama, он очень эффективен.

Заключение

Каждый из этих открытых интерфейсов может улучшить ваш опыт работы с локальными моделями Ollama, предоставляя удобный интерфейс чата и дополнительные возможности, такие как ответы на вопросы по документам. Лучший выбор зависит от ваших требований и технического комфорта:

- Для быстрой настройки и использования в браузере: Page Assist — отличный выбор, интегрирующийся непосредственно в ваш веб-серфинг с минимальными хлопотами.

- Для полнофункциональной веб-приложения: Open WebUI или LibreChat предлагают обширные функции и гибкость работы с несколькими моделями, подходящие для опытных пользователей или многопользовательских настроек.

- Для полированного аналога ChatGPT с потенциалом плагинов: LobeChat предлагает хороший баланс удобства использования и функций в самодостаточном пакете.

- Для взаимодействий, ориентированных на документы: AnythingLLM предлагает решение все-в-одном (особенно если вам нравится наличие настольного приложения), тогда как Chat-with-Notes предлагает минималистичный подход для ответов на вопросы по одному документу.

Все эти инструменты активно поддерживаются, поэтому вы можете рассчитывать на улучшения и поддержку сообщества. Выбрав один из этих интерфейсов, вы сможете общаться со своими локальными моделями, размещенными на Ollama, удобным способом — будь то анализ документов, помощь в кодировании или просто наличие разговорного ИИ без облачных зависимостей. Каждое из вышеуказанных решений открытого исходного кода, поэтому вы можете дополнительно адаптировать их под свои нужды или даже внести свой вклад в их развитие.

Приятного общения с вашим локальным LLM!