Фарфалле против Перплексики

Сравнение двух самонастраиваемых поисковых движков ИИ

Вкусная еда - это удовольствие не только для глаз. Но в этом посте мы сравним две системы поиска на основе ИИ, Farfalle и Perplexica.

Кстати, такую форму пасты тоже называют “фарфалле”.

Но здесь я сравниваю только то, как эти две системы ведут себя. Не формы пасты.

Хорошо. Сконцентрируйтесь!

Пожалуйста, также посмотрите Установка и настройка Perplexica - с ollama и Установка и настройка Ollama.

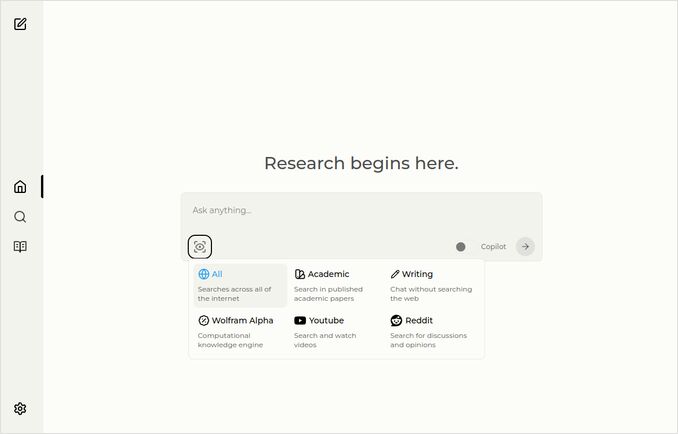

Perplexica

Вот главная страница с выпадающим списком источников.

- Perplexica реализована на

- TypeScript и React.Js (интерфейс)

- TypeScript и Express.Js (бэкенд)

- также включает настройки для метапоискового движка SearxNG

- Имеет режим Copilot

- Имеет возможность использования любой модели ИИ, размещенной на Ollama, в качестве чат-бота или модели эмбеддингов

- Имеет три небольшие внутренние модели эмбеддингов

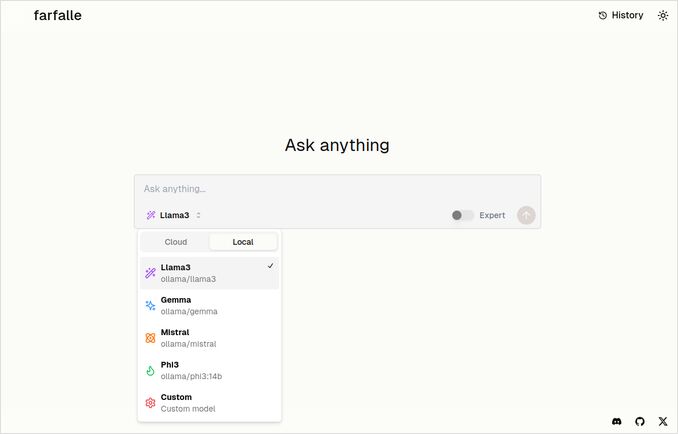

Farfalle

- Farfalle реализована на

- TypeScript и React.Js (интерфейс)

- Python Fastapi (бэкенд)

- также включает ссылку на метапоисковый движок SearxNG. Нет сложных настроек для этого, довольно стандартный docker-образ.

- Имеет режим Expert, который должен подготовить несколько запросов из оригинального и объединить ответы. Но это не сработало в нашем тесте.

- Имеет возможность использования четырех моделей ИИ, размещенных на Ollama, в качестве чат-бота (llama3, mistral, gemma, phi3). Это хороший набор опций, но я бы предпочел, чтобы он был более гибким и позволял использовать любую модель, которую предоставляет Ollama.

- Нет опций для модели эмбеддингов

Сравнение, выполненное Perplexica и Farfalle самими

Я запустил тот же запрос: Сравнить farfalle и perplexica на основе надежности, сообщества, поддержки и поддерживаемых моделей ИИ

Обе системы Perplexica и Farfalle использовали модель llama3, размещенную на локальном ollama. Полное название модели - llama3 8b q4.

Не верьте на 100% тому, что говорят ответы, просто посмотрите на длину текста, структуру и общее качество ответа.

Я бы поверил примерно на 70%…

Ответ Perplexica на сравнение

Сравнение Farfalle и Perplexica

Надежность

Farfalle: 8/10 - Farfalle - это популярный поисковый движок на основе ИИ, известный своей надежностью и способностью обрабатывать сложные запросы. Он имеет прочную основу в обработке естественного языка (NLP) и машинном обучении (ML). Хотя он не идеален, надежность Farfalle хорошо установлена.

Perplexica: 9/10 - Perplexica построена на модели Phi-3 от Meta AI, которая разработана для надежности. Она была протестирована на предоставление точных ответов даже при столкновении с неоднозначными или неясными запросами. Ее способность перефразировать вопросы и адаптироваться к разным контекстам делает ее надежным поисковым движком.

Сообщество

Farfalle: 7/10 - У Farfalle есть преданное сообщество пользователей, которые ценят его возможности. Хотя он не имеет такого же уровня принятия, как Perplexica, база пользователей Farfalle все еще значительна.

Perplexica: 8.5/10 - Perplexica получила широкое признание за свой инновационный подход к поисковым системам. Ее сообщество быстро растет, и многие пользователи ценят ее способность предоставлять точные и релевантные результаты.

Поддержка

Farfalle: 6.5/10 - Farfalle предоставляет базовую поддержку через FAQ, документацию и форумы. Хотя она не такая всеобъемлющая, как поддержка Perplexica, база пользователей Farfalle в целом самодостаточна.

Perplexica: 9/10 - Perplexica предлагает обширные ресурсы поддержки, включая подробную документацию, FAQ и сообщества форумов. Ее разработчики активно взаимодействуют с сообществом, обеспечивая своевременную и эффективную помощь пользователям.

Поддерживаемые модели ИИ

Farfalle: Нет - Farfalle - это автономный поисковый движок на основе ИИ, который не полагается на большие языковые модели (LLMs) для своих возможностей.

Perplexica: Да - Perplexica построена на модели Phi-3 от Meta AI, которая является LLM. Это позволяет Perplexica использовать мощь глубокого обучения для более точных и релевантных результатов.

Общий балл Farfalle: 22/30 Perplexica: 34.5/40

На основе этих критериев, Perplexica, кажется, имеет небольшое преимущество перед Farfalle в плане надежности, поддержки сообщества и интеграции LLM. Однако обе поисковые системы имеют свои сильные стороны, и выбор в конечном итоге зависит от ваших конкретных потребностей и предпочтений.

Рекомендация Если вы ищете надежный поисковый движок на основе ИИ с сильными возможностями NLP, Perplexica может быть лучшим выбором. Если вы предпочитаете более простой, без излишеств подход к поиску, Farfalle все равно может предоставить отличные результаты.

Ответ Farfalle на сравнение

Сравнение Farfalle и Perplexica

Farfalle и Perplexica - это два поисковых движка на основе ИИ, которые привлекли внимание в последнее время. Вот сравнение этих двух проектов на основе надежности, сообщества, поддержки и поддержки LLM (Large Language Model).

Надежность

- Farfalle разработана для саморазмещения с локальными или облачными LLMs, что делает ее более надежным вариантом для пользователей, которые хотят контролировать свой поисковый движок.

- Perplexica, с другой стороны, является открытым аналогом Perplexity AI и постоянно улучшается ее разработчиками.

Сообщество

- У Perplexica есть преданное сообщество разработчиков и пользователей, которые вносят свой вклад в развитие и предоставляют поддержку

- Сообщество Farfalle меньше, но оно все еще присутствует на GitHub

Поддержка

- Perplexica предлагает регулярные обновления и улучшения, а также канал Discord для обсуждения вопросов вне обычной поддержки

- Поддержка Farfalle ограничена вопросами и pull requests на GitHub

Поддержка LLM Обе системы Farfalle и Perplexica поддерживают LLMs. Perplexica использует Ollama, локальный LLM, в то время как Farfalle поддерживает как локальные, так и облачные LLMs.

В итоге, Farfalle более надежна благодаря своему саморазмещенному дизайну, в то время как Perplexica имеет более сильное сообщество и лучшую поддержку. Оба проекта поддерживают LLMs, но Perplexica использует конкретно Ollama.

Заключение

Какая разница между Perplexica и Farfalle?

Ответ:

- Отложив в сторону некоторые фактические ошибки, обе системы считают, что Perplexica лучше, чем Farfalle, с чем я бы согласился.

- Мне действительно нравится интерфейс Farfalle, хотя они довольно близки

- Мне нравится идея экспертного режима Farfalle, хотя он не работал в моей среде

- Я столкнулся с 3 багами при запуске Farfalle. Код Perplexica более отполирован

- После настройки Perplexica работала без ошибок

- Perplexica позволяет использовать любую модель, размещенную на Ollama. А Farfalle позволяет использовать только Gemma, Llama3, Mistral и Phi3 (предопределенные версии, которые немного устарели).

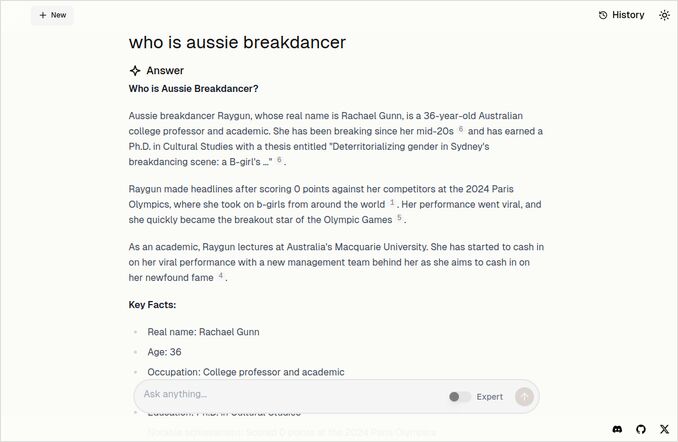

- Мне нравятся ответы Farfalle больше. Посмотрите на изображение Farfalle ниже. Без лишних “Согласно предоставленному контексту”…

Больше примеров

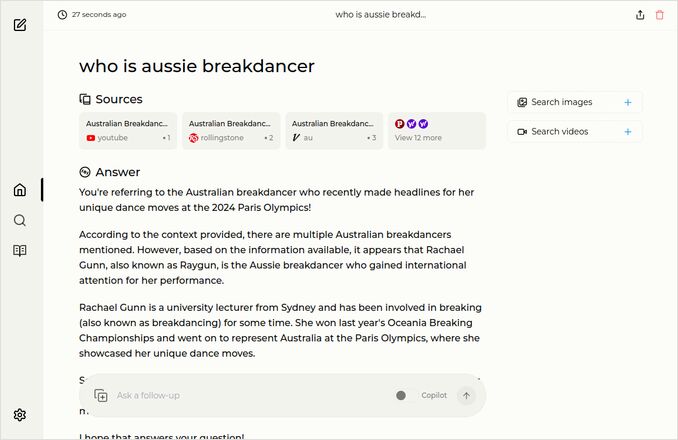

Эти примеры показывают ответы на тот же вопрос о австралийском брейкдансере. Вы знаете, того, с PhD, который получил 0 (ноль) баллов и, вероятно, исключил брейкданс из программы Олимпийских игр.

Ответ Farfalle

Ответ Perplexica

Если вы прочитаете (или пролистаете) этот последний абзац, спасибо за то, что разделяете мои интересы. Это действительно захватывающие времена. Хорошего дня!