Переместить модели Ollama в другое место

Файлы моделей LLM Ollama занимают много места

После установки ollama лучше сразу переконфигурировать ollama для хранения их в новом месте. Таким образом, после того как мы загрузим новую модель, она не будет скачана в старое место.

О программе Ollama

Ollama — это текстовый интерфейс для работы с моделями ИИ LLM и API, который также может их хостить. Для более широкого сравнения Ollama с vLLM, Docker Model Runner, LocalAI и облачными провайдерами — включая затраты и компромиссы инфраструктуры — см. Хостинг LLM: локальный, самостоятельный и облачная инфраструктура.

Установка Ollama

Перейдите по ссылке https://ollama.com/download

Для установки Ollama на linux:

curl -fsSL https://ollama.com/install.sh | sh

Ollama для Windows находится на странице: https://ollama.com/download/windows Ollama для Mac тоже есть: https://ollama.com/download/macOllamaSetup.exe

Загрузка, список и удаление моделей Ollama

Чтобы загрузить некоторые модели Ollama: Перейдите в библиотеку Ollama (https://ollama.com/library) и найдите нужную модель, там вы также можете найти теги и размеры моделей.

Затем выполните:

ollama pull gemma2:latest

# Или возьмите немного умнее, но все еще хорошо помещающуюся в 16ГБ VRAM:

ollama pull gemma2:27b-instruct-q3_K_S

# Или:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

Чтобы проверить модели, которые Ollama имеет в локальном репозитории:

ollama list

Чтобы удалить ненужную модель:

ollama rm qwen2:7b-instruct-q8_0 # например

Расположение моделей Ollama

По умолчанию файлы моделей хранятся:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

Настройка пути к моделям Ollama в Windows

Чтобы создать переменную окружения в Windows, вы можете следовать этим инструкциям:

- Откройте параметры Windows.

- Перейдите в раздел Система.

- Выберите Сведения

- Выберите Параметры системы

- Перейдите на вкладку Дополнительно.

- Выберите Переменные среды….

- Нажмите на Новый…

- И создайте переменную с именем OLLAMA_MODELS, указывающую на место, где вы хотите хранить модели

Перемещение моделей Ollama на Linux

Редактирование параметров сервиса ollama systemd

sudo systemctl edit ollama.service

или

sudo xed /etc/systemd/system/ollama.service

Это откроет редактор.

Для каждой переменной окружения добавьте строку Environment под разделом [Service]:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

Сохраните и закройте.

Также есть параметры User и Group, у которых должен быть доступ к этой папке.

Перезагрузите systemd и перезапустите Ollama:

sudo systemctl daemon-reload

sudo systemctl restart ollama

если что-то пошло не так

systemctl status ollama.service

sudo journalctl -u ollama.service

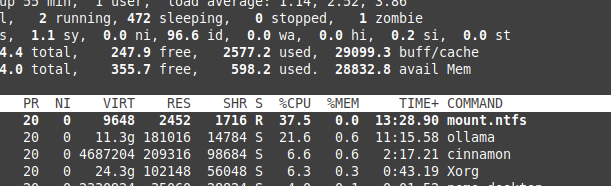

Хранение файлов на NTFS с избыточными накладными расходами

Обратите внимание, что если вы используете linux и храните свои модели на разделе с файловой системой NTFS, ваши модели будут загружаться намного медленнее — более чем на 20%.

Установка Ollama на Windows в конкретную папку

Вместе с моделями

.\OllamaSetup.exe /DIR=D:\OllamaDir

Открытие API Ollama для внутренней сети

Внутренняя сеть означает локальную сеть.

Добавьте в конфигурацию сервиса:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Чтобы узнать, как Ollama сочетается с другими локальными и облачными вариантами LLM, ознакомьтесь с нашим руководством Хостинг LLM: локальный, самостоятельный и облачная инфраструктура.

Полезные ссылки

- Тест: Использование Ollama производительностью и эффективными ядрами Intel CPU

- Как Ollama обрабатывает параллельные запросы

- Производительность LLM и PCIe-каналы: ключевые моменты

- Сравнение скорости LLM

- Сравнение способностей LLM к суммированию

- Написание эффективных запросов для LLM

- Самостоятельный хостинг Perplexica - с Ollama

- Облачные провайдеры LLM