Ubuntu に Mumble サーバーをインストールし、Android および iOS で Mumble を使用する方法

代替のVoIP通信プラットフォーム

Mumble は、主にリアルタイムの音声通話を目的とした、無料でオープンソースのVoIP(Voice over IP)アプリケーションです。クライアント-サーバーのアーキテクチャを使用しており、ユーザーは共有サーバーに接続してお互いに話すことができます。

代替のVoIP通信プラットフォーム

Mumble は、主にリアルタイムの音声通話を目的とした、無料でオープンソースのVoIP(Voice over IP)アプリケーションです。クライアント-サーバーのアーキテクチャを使用しており、ユーザーは共有サーバーに接続してお互いに話すことができます。

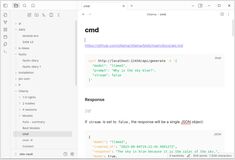

2025年のOllamaで最も注目されているUIの概要

ローカルにホストされた Ollama は、自分のマシンで大規模な言語モデルを実行できるが、コマンドラインで使用するのはユーザーにとって使いにくい。

以下は、ローカルの Ollama に接続する ChatGPT スタイルのインターフェース を提供するいくつかのオープンソースプロジェクトである。

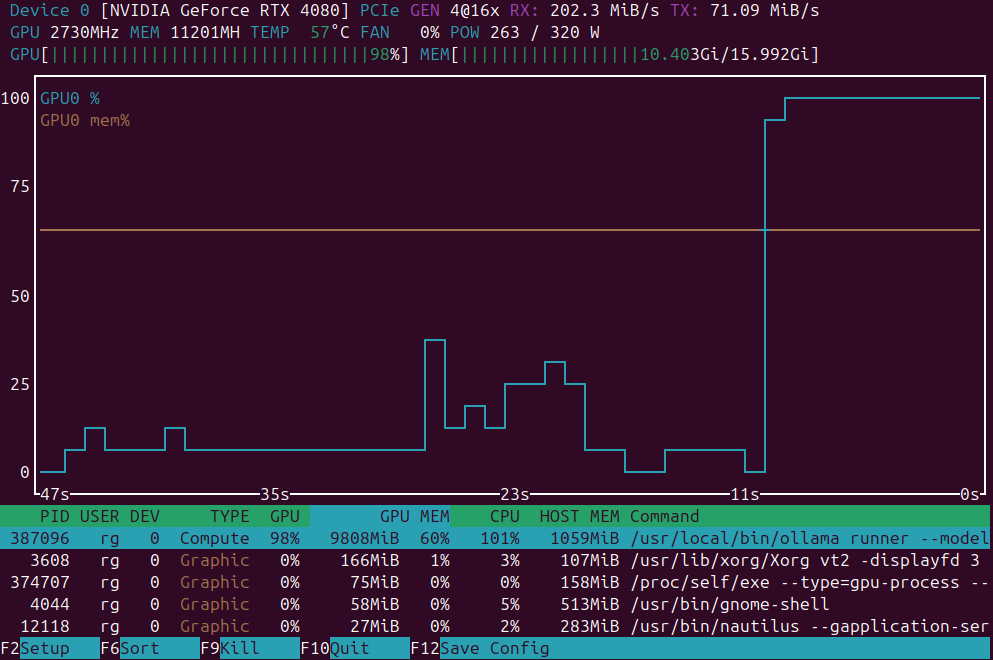

GPU負荷監視用のアプリケーションの簡単な一覧

GPU負荷監視アプリケーション: nvidia-smi vs nvtop vs nvitop vs KDE plasma systemmonitor.

ホームラボクラスターにlittle k3s Kubernetesをインストールする

以下は、提供されたHugoページの英語から日本語への翻訳です。すべての技術的なフォーマット、構造、Hugo固有の要素は維持されています。

ここでは、裸の金属サーバー(1マスター + 2ワーカー)上で**3ノードK3sクラスターのインストール**を行うステップバイステップのガイドを紹介します。

Kubernetesのバリエーションの簡単な概要

自己ホスティング可能な Kubernetes の配布版を比較し、裸金属やホームサーバーでのホスティングに焦点を当て、インストールの容易さ、パフォーマンス、システム要件、機能セットを比較します。

家庭用ラボ用に最適なKubernetesのバージョンを選ぶ

私は、Ubuntuベースのホームラボで3ノード(16GB RAM、各4コア)に適した、インストールとメンテナンスが簡単で、永続ボリュームとロードバランサーをサポートする自己ホスト型Kubernetesのバリエーションを比較しています。

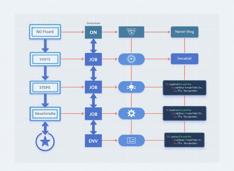

GitHub Actions の一般的な構造について少し説明します。

GitHub Actions

は、プッシュ、プルリクエスト、またはスケジュールなどのイベントに基づいてコードを構築、テスト、デプロイするためのGitHub内での自動化およびCI/CDプラットフォームです。

ちなみに、docker-compose は docker compose とは異なります…

以下は、Docker Composeに関するヒントと例を含む、日本語に翻訳されたHugoページのコンテンツです。

Docker Compose チートシート

注釈付きの例を用いて、Composeファイルとコマンドを素早くマスターするのに役立ちます。

Obsidianについて……

以下は、提供されたHugoページコンテンツの日本語への翻訳です。すべての技術的なフォーマット、構造、Hugo固有の要素は保持されています。

以下は、Obsidianが**個人知識管理(PKM)**に強力なツールとしてどのように機能するかの詳細な解説です。Obsidian as a powerful tool for personal knowledge management (PKM)。そのアーキテクチャ、機能、強み、そして現代の知識ワークフローをどのようにサポートするかについて説明しています。

2025年7月にはすぐに利用可能になるはずです。

NVIDIAは、NVIDIA DGX Sparkを近日中にリリースする予定です。これは、ブラックウェルアーキテクチャを採用し、128GB以上の統合RAMと1 PFLOPSのAI性能を備えた小型のAIスーパーコンピュータです。LLMを実行するための非常に便利なデバイスです。

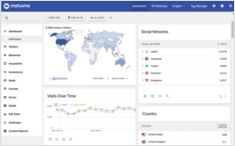

ウェブ解析システムとして、ウェブサイトで使用すべきものは?

Matomo、Plausible、Google およびその他のウェブ解析プロバイダやシステムについて、セルフホスティング可能なものを確認し、それらを比較してみましょう。

Ubuntu 24.04 標準インストール手順に関するメモ

Ubuntu 24.04 のインストール時に私が好むステップについてご紹介します。ここでの魅力は、NVIDIAドライバをインストールする必要がないことです。それらは自動的にインストールされます。

私はDokuwikiを個人的な知識ベースとして使用していました。

Dokuwikiは、データベースを必要とせず、オンプレミスで簡単にホストできるセルフホスト型のウィキパediaです。

私は、ペットのKubernetesクラスター上でDocker化してDokuwikiを運用していました。

AIに最適なGPU価格の更新 - RTX 5080およびRTX 5090

トップレベルの消費者向けGPUの価格を比較しましょう。特にLLM(大規模言語モデル)やAI全体に適したGPUについて詳しく見てみましょう。

具体的には、RTX 5080およびRTX 5090の価格を見てみましょう。わずかに価格が下がっています。

Pythonを用いたETS/MLOPS向けの優れたフレームワーク

Apache Airflow は、Python コードを使用してワークフローをプログラマティックに作成、スケジュール、監視するためのオープンソースプラットフォームです。伝統的な、手動の、またはUIベースのワークフローツールの代替として、柔軟で強力な選択肢を提供します。

RAGを実装中ですか?ここにGoのコードの一部 - 2...

標準的な Ollama には直接のリランク API がありませんので、 クエリとドキュメントのペアに対して埋め込みを生成し、それらをスコアリングすることで、Qwen3 リランカーを使用したリランキング(GO 言語で) を実装する必要があります。