オープンウェブUI: 自己ホスト型LLMインターフェース

ローカルLLM用のセルフホスト型ChatGPT代替ソフトウェア

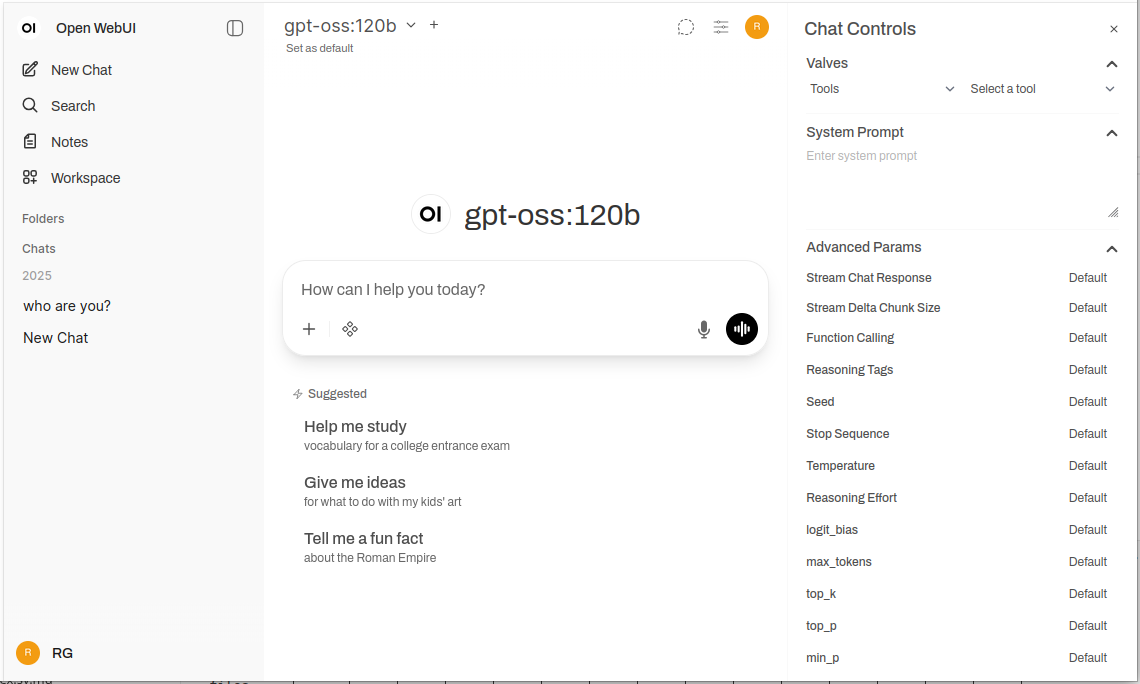

Open WebUI は、大規模言語モデルと対話するための強力で拡張性があり、機能豊富な自己ホスト型ウェブインターフェースです。

Ollama と OpenAI 互換の API をサポートしており、完全なプライバシー、オフライン機能、企業向けの機能を備えた、なじみのある ChatGPT 体験をインフラに導入できます。ローカルとクラウドのLLMバックエンド(Ollama、vLLM、Docker Model Runner、LocalAI およびクラウドプロバイダー)の比較については、LLM ホスティング: ローカル、自己ホスト型およびクラウドインフラの比較 をご参照ください。

Open WebUI とは?

Open WebUI は、大規模言語モデルと対話するための現代的なチャットインターフェースを提供するオープンソースの自己ホスト型ウェブアプリケーションです。クラウドベースのAIサービスと異なり、Open WebUI は完全にあなたのインフラ上で動作し、データ、会話、モデル選択を完全にコントロールできます。

Open WebUI は Ollama とよく一緒に使用されるため、「Ollama WebUI」と非公式に呼ばれることがありますが、実際にはバックエンドに依存しないプラットフォームです。Ollama のAPIを使用してローカルモデルを実行できますが、vLLM、LocalAI、LM Studio、Text Generation WebUI、さらにはクラウドプロバイダーのOpenAI 互換エンドポイントもサポートしています。この柔軟性により、Open WebUI は複数のバックエンドをサポートし、ドキュメントチャット用のRAG(Retrieval-Augmented Generation)、マルチユーザー認証、音声機能、広範なカスタマイズオプションを備えた包括的なソリューションとなります。ノートPC、ホームサーバー、Kubernetes クラスター上にモデルを実行している場合でも、Open WebUI はあなたのニーズに応じてスケールします。

なぜ Open WebUI を選ぶべきか?

プライバシー第一:すべてのデータはあなたのインフラに残ります。外部APIを明示的に構成しない限り、会話、ドキュメント、プロンプトはネットワーク外に出ません。

オフライン対応:空気隔離環境、制限されたネットワーク、インターネット接続が不安定または禁止されている状況に最適です。Ollama または vLLM を使用してローカルでモデルを実行すると、クラウドサービスへの依存を完全に解消できます。

機能豊富:自己ホスト型であるにもかかわらず、ドキュメントアップロードとRAG、セマンティック検索付きの会話履歴、プロンプトテンプレートと共有、モデル管理、音声入力/出力、モバイル対応デザイン、ダーク/ライトテーマを備えており、商用製品と競い合うことができます。

マルチユーザー対応:ロールベースのアクセス制御(管理者、ユーザー、保留中)付きの組み込み認証システム、ユーザー管理ダッシュボード、会話の分離、チーム間で共有されるプロンプトとモデル。

クイックインストールガイド

Open WebUI をすぐに開始する最も簡単な方法は Docker を使用することです。このセクションでは、一般的な展開シナリオをカバーします。

基本的なインストール(既存の Ollama に接続)

システム上で Ollama がすでに実行されている場合、次のコマンドを使用してください:

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

これにより、ポート 3000 上で Open WebUI が実行され、Docker ボリュームにデータを永続化します。http://localhost:3000 でアクセスできます。

パッケージ付きインストール(Open WebUI + Ollama)

Ollama を含む完全なワンストップ設定を行うには:

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

--gpus all フラグは、GPU アクセスを有効にして推論を高速化します。CPU専用で実行する場合は、このフラグを省略してください。

Docker Compose 設定

本番展開では、Docker Compose がより良いメンテナビリティを提供します:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

docker-compose up -d で展開してください。

Kubernetes 展開

企業向けの展開では、Open WebUI は Helm チャートを提供します:

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

これにより、永続ストレージ、ヘルスチェック、オプションのイングレス構成を備えた本番環境用の展開が作成されます。

核心機能の詳細解析

RAG とドキュメントチャット

Open WebUI の RAG 実装により、ドキュメントをアップロードし、モデルが会話でそれらを参照できるようになります。システムはドキュメントを自動的にチャンク化し、埋め込みを生成し、ベクトルデータベースに保存し、質問時に関連するコンテキストを取得します。

サポートされているフォーマット:PDF、DOCX、TXT、Markdown、CSV など、組み込みのパーサーを使用して。

使用方法:チャット画面の ‘+’ ボタンをクリックし、「ファイルのアップロード」を選択し、ドキュメントを選択して質問を開始してください。モデルは応答時に関連するパッセージとページ番号を引用します。

設定:管理者設定でチャンクサイズ、オーバーラップ、埋め込みモデル、取得パラメータを調整して、ドキュメントタイプに最適なパフォーマンスを実現できます。

マルチユーザー認証と管理

Open WebUI には、チームや組織利用に適した完全な認証システムが含まれています:

- ローカル認証:セキュアなパスワードハッシュを使用したユーザー名/パスワード

- OAuth/OIDC 統合:既存のアイデンティティプロバイダー(Google、GitHub、Keycloak など)に接続

- LDAP/Active Directory:企業ディレクトリ統合

- ロールベースアクセス:管理者(完全なコントロール)、ユーザー(標準アクセス)、保留中(承認が必要)

管理者はユーザーを管理し、使用状況を監視し、ユーザー/グループごとにモデルアクセスを構成し、会話保持ポリシーを設定できます。

音声入力と出力

組み込みの音声インタラクションサポートにより、Open WebUI はアクセスしやすく便利です:

- 音声認識:Web Speech API または構成済みの外部STTサービスを使用

- テキスト読み上げ:複数のTTSエンジンがサポート(ブラウザベース、Coqui TTS、ElevenLabs など)

- 言語サポート:TTS/STT 設定に応じて複数の言語に対応

プロンプトエンジニアリングツール

Open WebUI はプロンプト管理のための堅牢なツールを提供します:

- プロンプトライブラリ:よく使うプロンプトをテンプレートとして保存

- 変数とプレースホルダー:動的なコンテンツを持つ再利用可能なプロンプトを作成

- プロンプト共有:効果的なプロンプトをチームと共有

- プロンプトバージョン管理:変更と改善の履歴を追跡

モデル管理

UI で簡単なモデル切り替えと管理:

- モデルカタログ:Ollama ライブラリから直接モデルをブラウズして取得

- カスタムモデル:カスタム GGUF モデルをアップロードして構成

- モデルパラメータ:会話ごとに温度、top-p、コンテキスト長さ、その他のサンプリングパラメータを調整

- モデルメタデータ:モデルの詳細、サイズ、量子化、機能を表示

設定とカスタマイズ

環境変数

主要な設定オプションは環境変数を通じて:

# バックエンドURL(Ollamaまたはその他のOpenAI互換API)

OLLAMA_BASE_URL=http://localhost:11434

# 認証を有効にする

WEBUI_AUTH=true

# デフォルトユーザー役割(user, admin, pending)

DEFAULT_USER_ROLE=pending

# ユーザー登録を有効にする

ENABLE_SIGNUP=true

# 管理者メール(管理者アカウントを自動作成)

WEBUI_ADMIN_EMAIL=admin@example.com

# データベース(デフォルトSQLite、または本番環境ではPostgreSQL)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# RAGを有効にする

ENABLE_RAG=true

# RAGの埋め込みモデル

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

代替バックエンドへの接続

Open WebUI は任意のOpenAI互換APIと動作します。設定 → 接続でベースURLを構成:

- vLLM:

http://localhost:8000/v1 - LocalAI:

http://localhost:8080 - LM Studio:

http://localhost:1234/v1 - Text Generation WebUI:

http://localhost:5000/v1 - OpenAI:

https://api.openai.com/v1(APIキーが必要) - Azure OpenAI: カスタムエンドポイントURL

リバースプロキシ設定

本番展開では、Open WebUI をリバースプロキシの背後に実行してください:

Nginx の例:

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# WebSocketサポート

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Traefik の例(Docker ラベル):

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

パフォーマンス最適化

データベースチューニング

マルチユーザー展開ではSQLiteからPostgreSQLに切り替えてください:

# 依存関係をインストール

pip install psycopg2-binary

# データベースURLを構成

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

PostgreSQL は複数のユーザーをよりよく処理し、会話検索とRAG操作のクエリパフォーマンスを改善します。

埋め込みモデル選択

RAGのパフォーマンスは埋め込みモデルの選択に大きく依存します:

- 高速/リソース制限:

all-MiniLM-L6-v2(384次元、約80MB) - バランス:

all-mpnet-base-v2(768次元、約420MB) - 最高品質:

bge-large-en-v1.5(1024次元、約1.3GB)

設定 → RAG → 埋め込みモデルで構成してください。

キャッシュ戦略

繰り返しのAPI呼び出しを減らすために会話キャッシュを有効にしてください:

- モデルキャッシュ: Ollama はロードされたモデルをメモリに自動的にキャッシュ

- 応答キャッシュ: Open WebUI は同一のプロンプトをキャッシュ(構成可能)

- 埋め込みキャッシュ: 以前に処理されたドキュメントの埋め込みを再利用

セキュリティベストプラクティス

Open WebUI を本番環境で展開する際は、以下のセキュリティガイドラインに従ってください:

- 認証を有効にする:公開ネットワークでOpen WebUIを無認証で実行しないこと

- HTTPSを使用する:常にTLS/SSLを使用したリバースプロキシの背後に展開すること

- 定期的なアップデート:セキュリティパッチのためにOpen WebUIとOllamaを最新版に保つこと

- アクセスを制限する:信頼できるネットワークにアクセスを制限するファイアウォールルールを使用すること

- APIキーを安全に:外部APIに接続する場合、環境変数を使用し、APIキーをハードコードしないこと

- 監査ログを有効にする:不正な活動を監視するためにアクセスログを有効にして監視すること

- データをバックアップ:

/app/backend/dataボリュームを定期的にバックアップすること - データベース暗号化:本番環境ではPostgreSQLで暗号化を有効にする

- レート制限:乱用を防止するためにレート制限を構成すること

- コンテンツフィルタリング:組織に適したコンテンツポリシーを実装すること

使用ケースと現実の応用

個人的な知識アシスタント

Open WebUI をローカルモデルとRAGと組み合わせて、プライベートな知識ベースを作成してください。ノート、研究論文、プロジェクトドキュメント、個人ドキュメントをアップロードしてください。クラウドサービスにデータを送信することなく、会話的にクエリを実行できます。研究者、学生、知識労働者にとってプライバシーを重視する場合に最適です。

開発チームの協力

技術ドキュメント、API仕様、コードベースの知識に共有アクセスを提供するためにOpen WebUIを展開してください。RAG機能により、数千ページのドキュメントから関連情報をすぐに見つけることができ、会話履歴はアーキテクチャ決定や技術的な議論をトラッキングします。

企業内部のチャットボット

組織はSAML統合を介してOpen WebUIを自社のファイアウォールの背後に展開し、従業員に内部のWiki、ポリシー、手順にアクセスできるAIアシスタントを提供できます。ロールベースのアクセスにより、機密情報が適切にセグメント化され、管理者のコントロールによりガバナンスとコンプライアンスが維持されます。

教育とトレーニング

教育機関はOpen WebUIを使用して、プライバシーの懸念なく学生や教員にAI支援を提供できます。コース資料、教科書、講義ノートをアップロードして文脈に応じたQ&Aを実現します。マルチユーザーシステムにより、使用状況をトラッキングしながら学生データをプライバシー保護します。

医療および法務応用

データプライバシーが重要な規制産業では、Open WebUIはHIPAAまたはGDPR準拠のAI支援ワークフローを実現します。医療専門家は薬物データベースや治療プロトコルをクエリし、法務チームは判例や契約を検索できますが、すべてのデータは管理されたインフラ内に残ります。

エアギャップおよびオフライン環境

政府機関、研究施設、セキュアな運用センターはエアギャップネットワークでOpen WebUIを使用します。完全なオフライン機能により、インターネット接続がなくてもAI支援が利用可能で、機密環境や遠隔地で非常に重要です。

一般的な問題のトラブルシューティング

接続問題

問題:Open WebUI が Ollama に接続できません

解決策:Ollama が実行されているかを確認(curl http://localhost:11434)、OLLAMA_BASE_URL 環境変数を確認し、接続を許可するファイアウォールルールがあるかを確認してください。Docker 展開では、http://ollama:11434 ではなくサービス名を使用してください。

問題:UI 上にモデルが表示されません

解決策:モデルがインストールされているかを確認(ollama list)、Open WebUI の設定でモデルリストをリフレッシュし、ブラウザのコンソールでAPIエラーを確認してください。

RAG およびドキュメントアップロードの問題

問題:ドキュメントアップロードに失敗

解決策:設定でファイルサイズ制限を確認し、サポートされているファイル形式を確認し、データボリュームに十分なディスクスペースがあるかを確認し、コンテナログでパースエラーを確認してください。

問題:RAG の応答がアップロードされたドキュメントを参照しません

解決策:埋め込みモデルがダウンロードされ、実行されているかを確認し、チャンクサイズ設定を確認(より小さなチャンクで精度を高める)、RAG 設定で取得するチャンク数を増やす、クエリがドキュメント内容に関連しているかを確認してください。

パフォーマンス問題

問題:応答時間が遅い

解決策:GPU 加速が利用可能であれば有効にし、モデルサイズを減らすか、量子化されたバージョンを使用する、OLLAMA_NUM_PARALLEL を増やして同時リクエストを処理し、Docker コンテナにさらにRAMを割り当てる。

問題:メモリ不足エラー

解決策:より小さなモデル(7B ではなく 13B パラメータ)を使用し、モデルパラメータでコンテキスト長さを減らし、同時ユーザーを制限する、またはシステムにさらにRAM/スワップスペースを追加する。

認証とアクセス

問題:ログインまたは管理者アカウントの作成ができない

解決策:WEBUI_AUTH=true を設定し、WEBUI_ADMIN_EMAIL を自動で管理者を作成するように設定し、ブラウザのクッキーとキャッシュをクリアし、コンテナログでデータベースエラーを確認してください。

問題:ユーザーが登録できない

解決策:ENABLE_SIGNUP=true を確認し、DEFAULT_USER_ROLE 設定(user で自動承認、pending で手動承認)を確認し、データベースが書き込み可能であることを確認してください。

Open WebUI の代替手段

Open WebUI は、強力な Ollama 統合を備えた自己ホスト型インターフェースを提供しますが、いくつかの代替手段が同じ問題空間に対して異なるアプローチを提供しています。あなたの選択は、マルチプロバイダの柔軟性、専門的なドキュメント処理、極めて単純な操作、または企業向けの機能を必要とするかどうかに依存します。

LibreChat は、OpenAI、Anthropic、Azure OpenAI、Google Vertex AI、AWS Bedrock、Ollama を単一のインターフェースでネイティブにサポートする最もプロバイダに無関係なソリューションです。そのプラグインアーキテクチャと、複数テナント、詳細なアクセス制御、使用量クォータなどの企業向け機能により、複数のAIプロバイダをサポートする必要がある組織や、詳細な監査トレースが必要な場合に最適です。トレードオフは複雑さで、LibreChat はOpen WebUI よりも設置労力が高く、リソースが重く、Ollama のサポートはクラウドプロバイダに比べて二次的なものです。チームがClaudeで書き、GPT-4でコーディング、プライバシー感覚のある作業ではローカルモデルを使用する場合、LibreChatの統合インターフェースが輝きます。

ドキュメント中心のワークフローでは、AnythingLLM は基本的なRAGを超える知識ベースファーストアプローチを採用しています。そのワークスペースモデルはドキュメントと会話を孤立した環境に整理し、高度な検索機能にはハイブリッド検索、リランク、引用追跡が含まれています。データコネクタはGitHub、Confluence、Google Driveからコンテンツを取得し、エージェント機能によりマルチステップの推論とワークフロー自動化が可能になります。これにより、複数クライアントの知識ベースを管理するコンサルティングファームや、豊富なドキュメントを扱うサポートチームにとってAnythingLLMは最適です。チャットインターフェースはOpen WebUIより磨かれていないかもしれませんが、大規模なドキュメントコレクションをクエリする主なニーズがある場合、高度な検索機能は学習曲線が急でも価値があります。

LobeChat は、機能の深さよりもユーザー体験を優先し、モバイル対応でプログレッシブウェブアプリ(PWA)機能を持つスリムなインターフェースを提供します。その現代的なデザイン、滑らかなアニメーション、強力な音声/マルチモーダルサポートにより、デザイナーや非技術ユーザーがAIアシスタントをデバイス間でスムーズに使用できるようにします。PWA実装により、Open WebUI にはないアプリライクなモバイル体験が提供されます。ただし、企業機能は限定的で、プラグインエコシステムは小さい、RAG機能はOpen WebUI およびAnythingLLM よりも後れを取っています。

デスクトップアプリを好むユーザーのために、Jan.ai はクロスプラットフォームインストーラー(Windows、macOS、Linux)を提供し、ゼロ構成のローカルモデル管理を提供します。Ollama を個別にインストールしたり、Docker と戯れたりする必要がなく、Jan はネイティブアプリとしてシステムトレイサポートとワンクリックモデルダウンロードを提供します。この「ただ動く」哲学により、家族やコラボレーターがコマンドラインツールに不慣れでもローカルLLMを提供するのに最適です。トレードオフはマルチユーザーのサポートがない、高度な機能が少ない、リモートアクセス機能がないことです。

Chatbox は軽量なニッチを占めています——最小限のクロスプラットフォームクライアントでOpenAI、Claude、Gemini、ローカルAPIをサポートし、非常に低いリソースオーバーヘッドがあります。開発者がさまざまなAPIプロバイダを迅速にテストする必要がある開発者やリソース制限されたハードウェアを持つユーザーに最適です。セットアップの摩擦は最小ですが、いくつかの機能はサブスクリプション制限付き、完全にオープンソースではない、RAGサポートは限定されています。

Ollama専用の最小限のUIがいくつか存在します——「ちょうど十分な」インターフェースを望むユーザーのために:Hollamaは複数のOllamaサーバーを異なるマシンに管理し、Ollama UIは基本的なチャットとPDFアップロードで非常に簡単なデプロイを提供し、OtermはSSHセッションとtmuxワークフローのための驚くほど機能的なターミナルベースインターフェースを提供します。これらは機能を犠牲にしてシンプルさと速度を追求しています。

企業がベンダーのサポートを必要とする場合は、TypingMind Team、BionicGPT、Dust.tt などの商用オプションが自社ホスティングと専門のサポート、コンプライアンス認証、SLAを提供します。これらはオープンソースの自由をトレードオフにし、保証された稼働時間、セキュリティ監査、責任を提供します——組織が企業グレードのサポート契約が必要な場合に適しています。

賢く選ぶ:Open WebUI は、ほぼすべての自社ホスト型Ollama展開にとって最適なバランスを提供します。プロバイダの柔軟性が最優先事項であればLibreChat、複雑なドキュメントワークフローが必要であればAnythingLLM、モバイルファーストまたはデザイン志向のユーザーであればLobeChat、非技術的なデスクトップユーザーであればJan、ベンダーのサポートが必要な場合は商用オプションを選択してください。大多数のローカルモデルを実行する技術ユーザーにとって、Open WebUI の活発な開発、強力なコミュニティ、優れたRAG実装により、おすすめの出発点となります。

今後の開発とロードマップ

Open WebUI はいくつかのエキサイティングな機能がロードマップにあるため、急速な開発を続けています:

改善されたマルチモーダルサポート:LLaVA および Bakllava などのモデルによる画像、視覚モデル、マルチモーダル会話のより良い処理。

強化されたエージェント機能:AutoGPT パターンに類似した関数呼び出し、ツール使用、マルチステップの推論ワークフロー。

より良いモバイルアプリ:現在のPWA実装を超えるネイティブのiOSおよびAndroidアプリで、改善されたモバイル体験を提供します。

高度なRAG機能:グラフベースのRAG、セマンティックチャンク、マルチクエリ検索、親ドキュメント検索によるより良いコンテキスト。

協力機能:共有会話、チームワークスペース、プロンプトおよびドキュメントに対するリアルタイム協力。

企業向け統合:より深いSSOサポート、SCIMプロビジョニング、高度な監査ログ、規制産業向けのコンプライアンスレポート。

プロジェクトは後方互換性とセマンティックバージョン管理を維持しており、アップグレードは簡単です。活発なGitHubリポジトリでは毎日のコミットと対応する問題管理が行われています。

結論

Open WebUI は、単なるOllamaのフロントエンドから、自社ホスト型AIインタラクションの包括的なプラットフォームへと進化してきました。プライバシー、機能、展開の容易さの組み合わせにより、個人、チーム、組織がローカルLLMを使用して能力を犠牲にすることなく、非常に良い選択肢となっています。

開発者がモデルをテストしている場合、内部AIツールを構築している組織、またはプライバシーを重視する個人であれば、Open WebUI は強力で自社ホスト型AIワークフローの基礎を提供します。活発なコミュニティ、定期的なアップデート、拡張可能なアーキテクチャにより、自社ホスト型AI空間におけるリーディングオプションのままになります。

基本的なDockerインストールから始め、いくつかのドキュメントをアップロードしてRAGを試し、Ollamaライブラリからさまざまなモデルを試してみてください。必要に応じて高度な機能を徐々に探索してください。学習曲線は穏やかですが、天井は高いため、Open WebUI は個人のノートPCから企業のKubernetesクラスターまでスケール可能です。

代替手段を比較している場合、Open WebUI のOllamaファースト設計、バランスの取れた機能セット、活発な開発により、大多数の自社ホスト型LLM展開のための推奨される出発点となります。特定のニーズが生じた場合にのみ、より専門的なソリューションに移行する必要があり、多くのユーザーはOpen WebUI の機能が実験から本番まで十分であることを発見します。

Open WebUI の典型的なバックエンド(Ollama、vLLM など)がDocker Model Runner、LocalAI、クラウドプロバイダーとどのように適合するかについては、LLM ホスティング: ローカル、自己ホスト型およびクラウドインフラの比較 ガイドを参照してください。

有用なリンク

Open WebUI環境を設定する際には、ローカルLLMホスティングおよび展開オプションの広範なエコシステムを理解することが役立ちます。ローカルLLMホスティング: 2025年完全ガイド - Ollama、vLLM、LocalAI、Jan、LM Studio およびその他 は、Ollama、vLLM、LocalAI およびその他を含む12以上のローカルLLMツールを比較し、Open WebUI 展開に最適なバックエンドを選択するためのAPIの成熟度、ツール呼び出しの能力、パフォーマンスベンチマークを提供します。

本番展開においてスループットとレイテンシーが重要である場合、vLLMクイックスタート: 高性能LLMサービング ガイドを参照してください。これは、Docker、OpenAI APIの互換性、PagedAttention最適化を含むvLLMのセットアップをカバーします。これは、Open WebUI が複数の同時ユーザーにサービスを提供し、Ollamaのパフォーマンスがボトルネックになる場合に特に価値があります。

バックエンドが並列リクエストをどのように処理するかを理解することは、容量計画に不可欠です。Ollamaが並列リクエストを処理する方法 は、Ollamaのリクエストキューイング、GPUメモリ管理、並列実行モデルを説明し、Open WebUI 展開のマルチユーザーシナリオにおける適切な制限と期待値を設定するのに役立ちます。

外部リソース

公式ドキュメントおよびコミュニティサポートについては、以下の外部リソースを参照してください: