Docker Model Runner vs Ollama (2026): Qual è il migliore per i modelli LLM locali?

Confronta Docker Model Runner e Ollama per LLM locali

Running large language models (LLMs) locally ha guadagnato popolarità per la privacy, il controllo dei costi e le capacità offline. Il panorama si è notevolmente modificato nel aprile 2025 quando Docker ha introdotto Docker Model Runner (DMR), la sua soluzione ufficiale per il deployment di modelli AI.

Ora tre approcci competono per l’attenzione dei programmatori: il Model Runner nativo di Docker, le soluzioni containerizzate di terze parti (vLLM, TGI) e la piattaforma standalone Ollama.

Per una visione più ampia che include i fornitori di cloud e i trade-off infrastrutturali, vedi LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

TL;DR – Docker Model Runner vs Ollama

Questo confronto si concentra sull’esecuzione di modelli linguistici di grandi dimensioni (LLMs) localmente utilizzando Docker o runtimes standalone, coprendo prestazioni, supporto GPU, compatibilità API e scenari di deployment in produzione.

- Migliore per i workflow nativi di Docker: Docker Model Runner

- Migliore per la semplicità e la prototipazione rapida: Ollama

- Migliore per Kubernetes & orchestrazione: Configurazioni basate su Docker

- Migliore per lo sviluppo su singola macchina: Ollama

Se stai già utilizzando intensamente Docker, DMR ha senso.

Se vuoi il modo più veloce per eseguire localmente gli LLM, Ollama è più semplice.

Se stai confrontando più di solo Docker Model Runner e Ollama, consulta la nostra analisi completa di Ollama vs vLLM vs LM Studio e altri strumenti locali per LLM. Quella guida confronta la maturità API, il supporto hardware, il tool calling e la prontezza per la produzione su 12+ runtimes locali per LLM.

Docker Model Runner vs Ollama: Confronto diretto

Con l’ingresso ufficiale di Docker nello spazio dei runner LLM, il confronto diventa più interessante. Ecco come DMR e Ollama si confrontano direttamente:

| Funzione | Docker Model Runner | Ollama |

|---|---|---|

| Installazione | Scheda AI di Docker Desktop o docker-model-plugin |

Comando singolo: curl | sh |

| Stile del comando | docker model pull/run/package |

ollama pull/run/list |

| Formato del modello | GGUF (OCI Artifacts) | GGUF (nativo) |

| Distribuzione del modello | Docker Hub, registri OCI | Registri Ollama |

| Configurazione GPU | Automatica (più semplice della tradizionale Docker) | Automatica |

| API | Compatibile con OpenAI | Compatibile con OpenAI |

| Integrazione Docker | Nativa (è Docker) | Esegue in Docker se necessario |

| Supporto Compose | Nativo | Attraverso l’immagine Docker |

| Curva di apprendimento | Bassa (per gli utenti Docker) | Più bassa (per tutti) |

| Partner dell’ecosistema | Google, Hugging Face, VMware | LangChain, CrewAI, Open WebUI |

| Migliore per | Workflow nativi di Docker | Semplificazione standalone |

Osservazione chiave: DMR porta i workflow Docker nell’hosting di modelli AI, mentre Ollama rimane agnostico rispetto ai framework con un’operazione standalone più semplice. L’infrastruttura esistente è più rilevante delle differenze tecniche.

Docker Model Runner è migliore di Ollama?

Dipende dal tuo workflow.

- Scegli Docker Model Runner (DMR) se il tuo team si basa già pesantemente su Docker, OCI artifacts e orchestrazione container.

- Scegli Ollama se vuoi il modo più semplice per eseguire localmente gli LLM con la minima configurazione e prototipazione rapida.

Per la maggior parte delle configurazioni su singola macchina, Ollama è più facile da usare.

Per i pipeline CI/CD nativi di Docker e i workflow container in azienda, DMR si integra più naturalmente.

Come eseguire un LLM in Docker: DMR vs Ollama

Se l’obiettivo è semplicemente eseguire un LLM all’interno di Docker, sia Docker Model Runner che Ollama in contenitori Docker possono raggiungere questo obiettivo.

Docker Model Runner utilizza i comandi nativi docker model pull e docker model run, imballando i modelli come OCI artifacts.

Ollama può anche eseguire all’interno di Docker utilizzando l’immagine ufficiale ollama/ollama, esponendo un’API compatibile con OpenAI sulla porta 11434.

La differenza principale risiede nell’integrazione del workflow:

- DMR si adatta naturalmente ai pipeline CI/CD nativi di Docker.

- Ollama in Docker offre una gestione più semplice dei modelli con flessibilità nell’orchestrazione Docker.

Comprendere i runner di modelli Docker

I runner di modelli basati su Docker utilizzano la containerizzazione per imballare i motori di inferenza degli LLM insieme ai loro dipendenze. Il panorama include sia la soluzione ufficiale di Docker che i framework di terze parti.

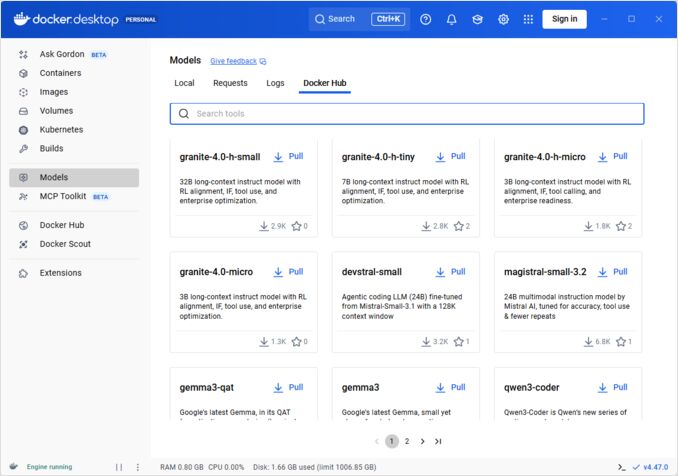

Docker Model Runner (DMR) - Soluzione ufficiale

Nell’aprile 2025, Docker ha introdotto Docker Model Runner (DMR), un prodotto ufficiale progettato per semplificare l’esecuzione di modelli AI localmente utilizzando l’infrastruttura di Docker. Questo rappresenta l’impegno di Docker a rendere l’hosting di modelli AI altrettanto semplice quanto l’hosting di container.

Funzionalità chiave di DMR:

- Integrazione nativa di Docker: Utilizza comandi familiari di Docker (

docker model pull,docker model run,docker model package) - Imballaggio come OCI Artifacts: I modelli vengono imballati come OCI Artifacts, abilitando la distribuzione attraverso Docker Hub e altri registri

- API compatibile con OpenAI: Sostituzione diretta per gli endpoint OpenAI, semplificando l’integrazione

- Accelerazione GPU: Supporto nativo GPU senza complessa configurazione nvidia-docker

- Supporto GGUF: Funziona con formati popolari di modelli quantizzati

- Integrazione Docker Compose: Configura e distribuisci facilmente i modelli utilizzando gli strumenti standard di Docker

- Supporto Testcontainers: Integra senza sforzo con i framework di testing

Installazione:

- Docker Desktop: Abilita tramite scheda AI nelle impostazioni

- Docker Engine: Installa il pacchetto

docker-model-plugin

Esempio di utilizzo:

# Scarica un modello da Docker Hub

docker model pull ai/smollm2

# Esegui inferenza

docker model run ai/smollm2 "Spiega Docker Model Runner"

# Imballa un modello personalizzato

docker model package --gguf /path/to/model.gguf --push myorg/mymodel:latest

Per un riferimento completo dei comandi docker model, delle opzioni di imballaggio, dei flag di configurazione e degli esempi pratici, vedi la nostra guida dettagliata Docker Model Runner Cheatsheet: Comandi & Esempi. Copre il pulling dei modelli, l’imballaggio, la configurazione e le best practice per distribuire localmente gli LLM con Docker.

DMR collabora con Google, Hugging Face e VMware Tanzu per espandere l’ecosistema dei modelli AI disponibile tramite Docker Hub. Se sei nuovo a Docker o hai bisogno di un rinfresco sui comandi Docker, il nostro Docker Cheatsheet fornisce una guida completa alle operazioni essenziali di Docker.

Soluzioni Docker di terze parti

Oltre a DMR, l’ecosistema include framework stabiliti:

- Contenitori vLLM: Server di inferenza ad alta capacità ottimizzato per il processing batch

- Text Generation Inference (TGI): Soluzione pronta per la produzione di Hugging Face

- Contenitori llama.cpp: Implementazione leggera in C++ con quantizzazione

- Contenitori personalizzati: Wrapping di PyTorch, Transformers o framework proprietari

Vantaggi dell’approccio Docker

Flessibilità e agnosticismo del framework: I contenitori Docker possono eseguire qualsiasi framework LLM, da PyTorch a ONNX Runtime, dando ai programmatori il controllo completo sullo stack di inferenza.

Isolamento delle risorse: Ogni contenitore opera in ambienti isolati con limiti definiti delle risorse (CPU, memoria, GPU), prevenendo conflitti di risorse in deployment multi-modello.

Supporto all’orchestrazione: Docker si integra senza sforzo con Kubernetes, Docker Swarm e piattaforme cloud per lo scaling, il bilanciamento del carico e la disponibilità elevata.

Controllo delle versioni: Diverse versioni di modello o framework possono coesistere sullo stesso sistema senza conflitti di dipendenze.

Svantaggi dell’approccio Docker

Complessità: Richiede la comprensione della containerizzazione, dei montaggi di volumi, della configurazione di rete e del pass through GPU (nvidia-docker).

Overhead: Sebbene minimo, Docker aggiunge uno strato sottile di astrazione che influisce leggermente sul tempo di avvio e sull’utilizzo delle risorse.

Onere di configurazione: Ogni deployment richiede una configurazione attenta dei Dockerfile, delle variabili ambiente e dei parametri di runtime.

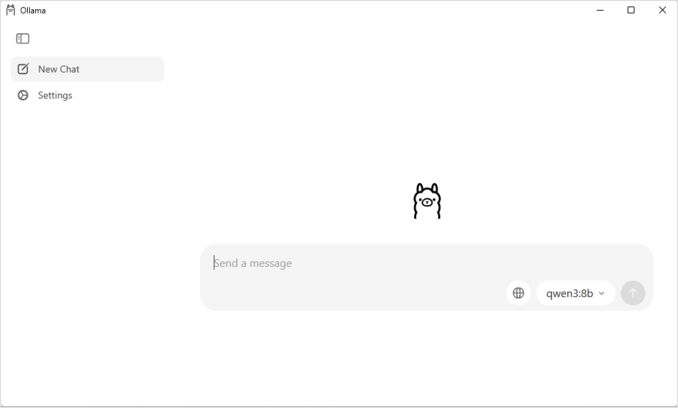

Comprendere Ollama

Ollama è un’applicazione progettata specificamente per eseguire localmente gli LLM, con la semplicità come principio centrale. Fornisce:

- Binario nativo per Linux, macOS e Windows

- Libreria di modelli incorporata con installazione in un solo comando

- Rilevamento automatico della GPU e ottimizzazione

- API RESTful compatibile con il formato OpenAI

- Gestione del contesto e stato del modello

Vantaggi di Ollama

Semplicità: L’installazione è semplice (curl | sh su Linux), e l’esecuzione dei modelli richiede solo ollama run llama2. Per un riferimento completo dei comandi CLI di Ollama come ollama serve, ollama run, ollama ps e i flussi di lavoro di gestione dei modelli, vedi la nostra Ollama CLI Cheatsheet.

Prestazioni ottimizzate: Costruito su llama.cpp, Ollama è altamente ottimizzato per la velocità di inferenza con supporto alla quantizzazione (Q4, Q5, Q8).

Gestione dei modelli: Registri incorporati dei modelli con comandi come ollama pull, ollama list e ollama rm semplificano il ciclo di vita dei modelli.

Esperienza per gli sviluppatori: API pulita, documentazione estesa e ecosistema in crescita di integrazioni (LangChain, CrewAI, ecc.). La versatilità di Ollama si estende a casi d’uso specializzati come riordinare documenti di testo con modelli di embedding.

Efficienza delle risorse: Gestione automatica della memoria e disimballaggio dei modelli quando inattivi conserva le risorse del sistema.

Svantaggi di Ollama

Lock-in del framework: Supporta principalmente modelli compatibili con llama.cpp, limitando la flessibilità per framework come vLLM o motori di inferenza personalizzati.

Limitata personalizzazione: Configurazioni avanzate (quantizzazione personalizzata, stream CUDA specifici) sono meno accessibili rispetto agli ambienti Docker.

Sfide nell’orchestrazione: Sebbene Ollama possa eseguire in contenitori, non ha supporto nativo per funzionalità avanzate di orchestrazione come lo scaling orizzontale.

Confronto delle prestazioni

Velocità di inferenza

Docker Model Runner: Prestazioni paragonabili a Ollama poiché entrambi supportano modelli quantizzati GGUF. Per Llama 2 7B (Q4), si prevedono 20-30 token/secondo sulla CPU e 50-80 token/secondo su GPU di medio livello. Overhead del contenitore minimo.

Ollama: Sfrutta il backend altamente ottimizzato di llama.cpp con quantizzazione efficiente. Per Llama 2 7B (Q4), si prevedono 20-30 token/secondo sulla CPU e 50-80 token/secondo su GPU di medio livello. Nessun overhead di containerizzazione. Per dettagli su come Ollama gestisce le richieste parallele, vedi l’analisi su come Ollama gestisce le richieste parallele.

Docker (vLLM): Ottimizzato per il processing batch con batch continuo. Richieste singole potrebbero essere leggermente più lente, ma la throughput eccelle sotto carico elevato (100+ token/secondo per modello con batch).

Docker (TGI): Simile a vLLM con eccellenti prestazioni di batch. Aggiunge funzionalità come streaming e generazione token-by-token.

Utilizzo della memoria

Docker Model Runner: Simile a Ollama con caricamento automatico dei modelli. I modelli GGUF Q4 tipicamente utilizzano 4-6 GB di RAM. L’overhead del contenitore è minimo (decine di MB).

La configurazione della dimensione del contesto può influenzare significativamente l’utilizzo della memoria e il comportamento del modello. Per impostazione predefinita, alcuni immagini Docker Model Runner CUDA impongono un limite di 4096 token, anche se valori più elevati vengono specificati in docker-compose. Per dettagli sui passaggi per sovrascrivere questo comportamento e imballare i modelli con dimensioni di contesto personalizzate, vedi la nostra guida su configurare la dimensione del contesto in Docker Model Runner.

Ollama: Gestione automatica della memoria carica i modelli su richiesta e li disimballa quando inattivi. Un modello 7B Q4 tipicamente utilizza 4-6 GB di RAM. Più efficiente per scenari a singolo modello.

Soluzioni Docker tradizionali: L’utilizzo della memoria dipende dal framework. vLLM prealloca la memoria GPU per prestazioni ottimali, mentre i contenitori basati su PyTorch potrebbero utilizzare più RAM per i pesi del modello e il KV cache (8-14 GB per modelli 7B).

Tempo di avvio

Docker Model Runner: L’avvio del contenitore aggiunge ~1 secondo, più il caricamento del modello (2-5 secondi). Totale: 3-6 secondi per modelli medi.

Ollama: Avvio quasi istantaneo con caricamento del modello che richiede 2-5 secondi per modelli medi. Esperienza di avvio più rapida.

Docker tradizionale: L’avvio del contenitore aggiunge 1-3 secondi, più il tempo di caricamento del modello. L’uso di contenitori pre-warmed attenua questo problema nei deployment di produzione.

Consigli per l’uso

Scegli Docker Model Runner quando

- Workflow Docker-first: Il tuo team utilizza già intensamente Docker

- Strumenti unificati: Vuoi uno strumento (Docker) per i contenitori e i modelli

- Distribuzione OCI artifact: Hai bisogno di integrazione con registri enterprise

- Integrazione Testcontainers: Stai testando funzionalità AI in CI/CD

- Preferenza per Docker Hub: Vuoi la distribuzione dei modelli attraverso canali familiari

Scegli Ollama quando

- Prototipazione rapida: Sperimentazione rapida con diversi modelli

- Agnostico del framework: Non legato all’ecosistema Docker

- Massima semplicità: Minima configurazione e overhead di manutenzione

- Deployment su singola macchina: Esecuzione su laptop, workstation o singoli VM

- Grande libreria di modelli: Accesso a un ampio registro di modelli pre-configurati

Scegli soluzioni Docker di terze parti quando

- Deployment in produzione: Necessità di orchestrazione avanzata e monitoraggio

- Serving multi-modello: Esecuzione contemporanea di diversi framework (vLLM, TGI)

- Orchestrazione Kubernetes: Scaling su cluster con bilanciamento del carico

- Framework personalizzati: Utilizzo di Ray Serve o motori di inferenza proprietari

- Controllo rigoroso delle risorse: Impostazione di limiti granulari di CPU/GPU per modello

Approcci ibridi: I migliori di entrambi

Non sei limitato a un solo approccio. Considera queste strategie ibride:

Opzione 1: Docker Model Runner + Contenitori tradizionali

Utilizza DMR per i modelli standard e contenitori di terze parti per framework specializzati:

# Scarica un modello standard con DMR

docker model pull ai/llama2

# Esegui vLLM per scenari ad alta capacità

docker run --gpus all vllm/vllm-openai

Opzione 2: Ollama in Docker

Esegui Ollama all’interno di contenitori Docker per capacità di orchestrazione:

docker run -d \

--name ollama \

--gpus all \

-v ollama:/root/.ollama \

-p 11434:11434 \

ollama/ollama

Questo fornisce:

- La gestione intuitiva dei modelli di Ollama

- Le capacità di orchestrazione e isolamento di Docker

- Deployment su Kubernetes con manifesti standard

Opzione 3: Mescola e usa per caso d’uso

- Sviluppo: Ollama per iterazioni rapide

- Staging: Docker Model Runner per test di integrazione

- Produzione: vLLM/TGI in Kubernetes per scalabilità

Compatibilità API

Tutte le soluzioni moderne convergono su API compatibili con OpenAI, semplificando l’integrazione:

API Docker Model Runner: Endpoint compatibili con OpenAI forniti automaticamente quando si eseguono i modelli. Non è necessaria alcuna configurazione aggiuntiva.

# I modelli vengono eseguiti con API esposta automaticamente

docker model run ai/llama2

# Usa endpoint compatibili con OpenAI

curl http://localhost:8080/v1/chat/completions -d '{

"model": "llama2",

"messages": [{"role": "user", "content": "Perché il cielo è blu?"}]

}'

API Ollama: Endpoint compatibili con OpenAI rendono Ollama una sostituzione diretta per applicazioni che utilizzano l’SDK OpenAI. È supportato il streaming.

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt": "Perché il cielo è blu?"

}'

API Docker di terze parti: vLLM e TGI offrono endpoint compatibili con OpenAI, mentre i contenitori personalizzati potrebbero implementare API proprietarie.

La convergenza su OpenAI significa che puoi passare tra le soluzioni con minime modifiche al codice.

Gestione delle risorse

Accelerazione GPU

Docker Model Runner: Supporto nativo GPU senza complessa configurazione nvidia-docker. Rileva automaticamente e utilizza le GPU disponibili, semplificando notevolmente l’esperienza di Docker GPU rispetto ai contenitori tradizionali.

Se stai utilizzando GPU NVIDIA e vuoi configurare correttamente l’accelerazione CUDA, consulta la nostra guida dettagliata su aggiungere il supporto NVIDIA GPU a Docker Model Runner. Copre la configurazione del daemon Docker, l’installazione del NVIDIA Container Toolkit e come verificare che il tuo LLM utilizzi effettivamente la memoria GPU invece di ricadere sulla CPU.

# L'accelerazione GPU funziona automaticamente

docker model run ai/llama2

Ollama: Rilevamento automatico della GPU su GPU NVIDIA con capacità CUDA. Non è necessaria alcuna configurazione oltre all’installazione del driver.

Contenitori Docker tradizionali: Richiede il runtime nvidia-docker e l’allocazione esplicita delle GPU:

docker run --gpus all my-llm-container

Rientro alla CPU

Entrambi passano automaticamente alla CPU quando le GPU non sono disponibili, sebbene le prestazioni diminuiscano significativamente (5-10 volte più lente per i modelli grandi). Per informazioni sui test di prestazioni CPU su processori moderni, leggi il nostro test su come Ollama utilizza le prestazioni e i core efficienti della CPU Intel.

Supporto multi-GPU

Ollama: Supporta la parallelizzazione tensoriale su più GPU per modelli grandi.

Docker: Dipende dal framework. vLLM e TGI supportano l’inferenza su più GPU con configurazione appropriata.

Comunità e ecosistema

Docker Model Runner: Lanciato nell’aprile 2025 con forte supporto aziendale. Le partnership con Google, Hugging Face e VMware Tanzu AI Solutions garantiscono una vasta disponibilità di modelli. L’integrazione con la vasta comunità di sviluppatori di Docker (milioni di utenti) fornisce accesso immediato all’ecosistema. Ancora in fase di costruzione di risorse specifiche per la comunità come prodotto nuovo.

Ollama: Comunità in rapida crescita con oltre 50K stelle su GitHub. Ecosistema di integrazione forte (LangChain, LiteLLM, Open WebUI, CrewAI) e comunità attiva su Discord. Strumenti e tutorial di terze parti estesi disponibili. Documentazione e risorse della comunità più mature. Per una panoramica completa degli interfacce disponibili, vedi la nostra guida su interfacce open-source per istanze locali Ollama. Come con ogni progetto open-source in rapida crescita, è importante monitorare la direzione del progetto - leggi l’analisi su primi segni di Ollama enshittification per comprendere le potenziali preoccupazioni.

Soluzioni Docker di terze parti: vLLM e TGI hanno ecosistemi maturi con supporto aziendale. Ampie case studio di produzione, guide di ottimizzazione e modelli di deployment da Hugging Face e contributori della comunità.

Considerazioni sui costi

Docker Model Runner: Gratuito con Docker Desktop (personale/educativo) o Docker Engine. Docker Desktop richiede una sottoscrizione per organizzazioni più grandi (250+ dipendenti o $10M+ di ricavi). I modelli distribuiti attraverso Docker Hub seguono i prezzi del registro Docker (repo pubblici gratuiti, repo privati a pagamento).

Ollama: Completamente gratuito e open-source senza costi di licenza indipendentemente dalla dimensione dell’organizzazione. I costi delle risorse dipendono solo dall’hardware.

Soluzioni Docker di terze parti: Gratuito per framework open-source (vLLM, TGI). Potenziali costi per piattaforme di orchestrazione container (ECS, GKE) e storage di registri privati.

Considerazioni sulla sicurezza

Docker Model Runner: Sfrutta il modello di sicurezza di Docker con isolamento dei contenitori. I modelli imballati come OCI Artifacts possono essere scansionati e firmati. La distribuzione attraverso Docker Hub abilita il controllo degli accessi e la scansione delle vulnerabilità per gli utenti enterprise.

Ollama: Esegue come servizio locale con API esposta su localhost per default. L’esposizione di rete richiede una configurazione esplicita. Il registro dei modelli è attendibile (curato da Ollama), riducendo i rischi della catena di fornitura.

Soluzioni Docker tradizionali: L’isolamento di rete è integrato. La scansione della sicurezza dei contenitori (Snyk, Trivy) e la firma delle immagini sono pratiche standard negli ambienti di produzione.

Tutte le soluzioni richiedono attenzione a:

- Provenienza del modello: I modelli non attendibili possono contenere codice dannoso o backdoor

- Autenticazione API: Implementare autenticazione/autorizzazione nei deployment in produzione

- Limitazione della velocità: Prevenire l’abuso e l’esaurimento delle risorse

- Esposizione di rete: Assicurarsi che le API non siano accidentalmente esposte a Internet

- Privacy dei dati: I modelli elaborano dati sensibili; assicurarsi di rispettare le normative sulla protezione dei dati

Percorsi di migrazione

Da Ollama a Docker Model Runner

Il supporto GGUF di Docker Model Runner rende la migrazione semplice:

- Abilita Docker Model Runner in Docker Desktop o installa

docker-model-plugin - Converte i riferimenti ai modelli:

ollama run llama2→docker model pull ai/llama2edocker model run ai/llama2 - Aggiorna gli endpoint API da

localhost:11434a DMR endpoint (tipicamentelocalhost:8080) - Entrambi utilizzano API compatibili con OpenAI, quindi il codice applicativo richiede solo modifiche minime

Da Docker Model Runner a Ollama

Passare a Ollama per un’operazione standalone più semplice:

- Installa Ollama:

curl -fsSL https://ollama.ai/install.sh | sh. Per un elenco completo dei comandi CLI di Ollama e delle opzioni di configurazione, consulta la Ollama CLI cheatsheet. - Scarica i modelli equivalenti:

ollama pull llama2 - Aggiorna gli endpoint API a quelli di Ollama

localhost:11434 - Testa con

ollama run llama2per verificare la funzionalità

Da contenitori Docker tradizionali a DMR

Semplifica il tuo setup LLM Docker:

- Abilita Docker Model Runner

- Sostituisci i Dockerfile personalizzati con comandi

docker model pull - Rimuovi la configurazione nvidia-docker (DMR gestisce automaticamente la GPU)

- Usa

docker model runinvece di comandi complessidocker run

Da qualsiasi soluzione a Ollama in Docker

Approccio migliore di entrambi:

docker pull ollama/ollama- Esegui:

docker run -d --gpus all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama - Usa i comandi Ollama come al solito:

docker exec -it ollama ollama pull llama2 - Otteni l’orchestrazione Docker con la semplicità di Ollama

Monitoraggio e osservabilità

Ollama: Metriche di base tramite API (/api/tags, /api/ps). Strumenti di terze parti come Open WebUI forniscono dashboard.

Docker: Integrazione completa con Prometheus, Grafana, ELK stack e servizi di monitoraggio cloud. Le metriche del contenitore (CPU, memoria, GPU) sono disponibili facilmente.

Conclusione

Il panorama dell’hosting locale degli LLM si è evoluto notevolmente con l’introduzione da parte di Docker di Docker Model Runner (DMR) nel 2025. La scelta ora dipende dalle tue esigenze specifiche:

- Per gli sviluppatori che cercano integrazione Docker: DMR fornisce un’integrazione nativa del workflow Docker con i comandi

docker model - Per la massima semplicità: Ollama rimane la soluzione più semplice con la gestione dei modelli in un solo comando

- Per la produzione e le aziende: Sia DMR che le soluzioni di terze parti (vLLM, TGI) in Docker offrono orchestrazione, monitoraggio e scalabilità

- Per il meglio di entrambi: Esegui Ollama in contenitori Docker per combinare la semplicità con l’infrastruttura di produzione

L’introduzione di DMR riduce la differenza tra Docker e Ollama in termini di facilità d’uso. Ollama vince comunque per la semplicità per la prototipazione rapida, mentre DMR eccelle per i team già investiti nei workflow Docker. Entrambi gli approcci sono attivamente sviluppati, pronti per la produzione e l’ecosistema è maturo abbastanza da rendere il passaggio tra di loro relativamente indolore.

Linea guida finale: Se stai già utilizzando intensamente Docker, DMR è la scelta naturale. Se vuoi l’esperienza più semplice possibile indipendentemente dall’infrastruttura, scegli Ollama. Per confrontare queste opzioni locali con API cloud e altre configurazioni self-hosted, consulta la nostra LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Link utili

Docker Model Runner

- Pagina ufficiale di Docker Model Runner

- Documentazione di Docker Model Runner

- Guida di avvio rapido di Docker Model Runner

- Blog dell’annuncio di Docker Model Runner

Ollama

Altre soluzioni Docker

- Documentazione vLLM

- Text Generation Inference di Hugging Face

- GitHub di llama.cpp

- NVIDIA Container Toolkit