Hardware

Hébergement autonome des LLM et souveraineté de l'IA

Contrôlez les données et les modèles avec des LLM hébergés localement

L’hébergement local des LLM permet de garder les données, les modèles et l’inférence sous votre contrôle - une approche pratique pour atteindre l’autonomie en matière d’IA pour les équipes, les entreprises et les nations.

Voici : ce qu’est l’autonomie en matière d’IA, quels aspects et méthodes sont utilisés pour la construire, comment l’hébergement local des LLM s’intègre, et comment les pays abordent ce défi.

Meilleurs LLMs pour Ollama sur GPU avec 16 Go de VRAM

Test de vitesse de LLM sur RTX 4080 avec 16 Go de VRAM

Exécuter de grands modèles de langage localement vous offre une confidentialité, une capacité hors ligne et des coûts d’API nuls. Ce benchmark révèle exactement ce que l’on peut attendre de 9 modèles de langage populaires LLMs sur Ollama sur un RTX 4080.

Hausse des prix des GPU et RAM en Australie : RTX 5090 en hausse de 15 %, RAM en hausse de 38 % - janvier 2026

Vérification des prix des GPU et RAM en janvier 2025

Aujourd’hui, nous examinons les GPU grand public haut de gamme et les modules de RAM. Plus précisément, j’étudie les prix des RTX-5080 et RTX-5090, ainsi que les modules de 32GB (2x16GB) DDR5 6000.

Meilleurs émulateurs de terminal Linux : comparaison 2026

Choisissez le terminal adapté à votre flux de travail Linux

L’un des outils les plus essentiels pour les utilisateurs de Linux est l’émulateur de terminal (https://www.glukhov.org/fr/post/2026/01/terminal-emulators-for-linux-comparison/ “Linux l’émulateur de terminal”).

Prix de DGX Spark AU : 6 249 $ - 7 999 $ chez les grands détaillants

Tarification réelle de l'AUD par les détaillants australiens maintenant

Le NVIDIA DGX Spark (GB10 Grace Blackwell) est maintenant disponible en Australie chez les principaux détaillants de PC avec des stocks locaux. Si vous avez suivi les prix et disponibilités mondiaux du DGX Spark, vous serez intéressé de savoir que les prix australiens vont de 6 249 à 7 999 AUD selon la configuration de stockage et le détaillant.

Auto-hébergement de Cognee : Tests de performance des LLM

Test de Cognee avec des LLMs locaux - résultats réels

Cognee est un framework Python pour construire des graphes de connaissances à partir de documents en utilisant des LLMs. Mais fonctionne-t-il avec des modèles auto-hébergés ?

Ubuntu a perdu la connexion réseau après une mise à niveau du noyau

Comment j'ai résolu les problèmes de réseau sous Ubuntu

Après avoir installé automatiquement un nouveau noyau, Ubuntu 24.04 a perdu la connexion réseau Ethernet. Ce problème frustrant s’est produit une deuxième fois pour moi, donc je documente la solution ici pour aider les autres confrontés au même problème.

Prix de la RAM en Australie - décembre 2025

Courte mise à jour, juste pour noter le prix

Avec cette folle volatilité des prix de la RAM, pour former et avoir une meilleure idée, traçons d’abord nous-mêmes le prix de la RAM en Australie.

Augmentation du prix de la RAM : jusqu'à 619 % en 2025

Les prix de la mémoire RAM augmentent de 163 à 619 % en raison de la demande accrue d'IA qui met la pression sur l'offre.

Le marché de la mémoire connaît une volatilité de prix sans précédent à la fin de 2025, avec une hausse dramatique des prix de la RAM sur tous les segments : augmentation des prix de la RAM.

Prix de la carte graphique NVidia RTX 5080 et RTX 5090 en Australie - novembre 2025

Prix des GPU pour consommateurs compatibles avec l'IA - RTX 5080 et RTX 5090

Commençons par comparer les prix des cartes graphiques de haut de gamme destinées aux consommateurs, qui sont particulièrement adaptées aux LLM et plus généralement à l’IA. Plus précisément, je regarde prix des RTX-5080 et RTX-5090.

Infrastructure d'IA sur le matériel grand public

Déployez l'intelligence artificielle d'entreprise sur des matériels abordables avec des modèles open source

La démocratisation de l’IA est ici. Avec des LLM open source comme Llama 3, Mixtral et Qwen qui rivalisent désormais avec les modèles propriétaires, les équipes peuvent construire une infrastructure puissante d’IA à l’aide du matériel grand public - réduisant les coûts tout en maintenant un contrôle complet sur la confidentialité des données et le déploiement.

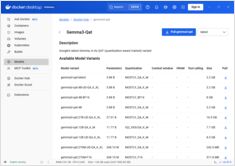

Ajout de la prise en charge des GPU NVIDIA dans Docker Model Runner

Activez l'accélération GPU pour Docker Model Runner avec le support NVIDIA CUDA

Docker Model Runner est l’outil officiel de Docker pour exécuter des modèles d’IA localement, mais l’activation de l’accélération GPU NVidia dans Docker Model Runner nécessite une configuration spécifique.

NVIDIA DGX Spark vs Mac Studio vs RTX-4080 : Comparaison des performances d'Ollama

Benchmarks GPT-OSS 120b sur trois plateformes d'IA

J’ai découvert quelques tests de performance intéressants du modèle GPT-OSS 120b exécuté sur Ollama sur trois plateformes différentes : NVIDIA DGX Spark, Mac Studio et RTX 4080. Le modèle GPT-OSS 120b de la bibliothèque Ollama pèse 65 Go, ce qui signifie qu’il ne peut pas s’adapter dans les 16 Go de VRAM d’une RTX 4080 (ou même sur la nouvelle RTX 5080).

Fiche de raccourcis Docker Model Runner : commandes et exemples

Référence rapide des commandes de Docker Model Runner

Docker Model Runner (DMR) est la solution officielle de Docker pour exécuter des modèles d’IA localement, introduite en avril 2025. Cette fiche de référence fournit un aperçu rapide de toutes les commandes essentielles, configurations et bonnes pratiques.

GNOME Boxes : Un guide complet sur les fonctionnalités, les avantages, les défis et les alternatives

Gestion simple de VM pour Linux avec GNOME Boxes

Dans le paysage actuel de l’informatique, la virtualisation est devenue essentielle pour le développement, les tests et le fonctionnement de plusieurs systèmes d’exploitation. Pour les utilisateurs de Linux souhaitant gérer des machines virtuelles de manière simple et intuitive, GNOME Boxes se distingue comme une option légère et conviviale qui privilégie l’ergonomie sans sacrifier la fonctionnalité.