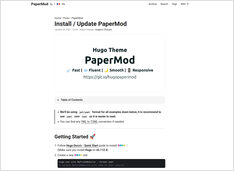

Temas populares de Hugo

Temas más populares para Hugo

Vamos a ver en GitHub la lista de los mejores temas para Hugo generador de sitios estáticos,

y revisar su calificación de estrellas.

Puedes ir a la lista oficial de temas de Hugo: https://themes.gohugo.io/