Hardware

Autohospedaje de LLM y soberanía de la IA

Controla los datos y los modelos con LLMs autohospedados

Autogestión de LLMs mantiene los datos, modelos e inferencia bajo su control: un camino práctico hacia la soberanía en IA para equipos, empresas y naciones. Aquí: qué es la soberanía en IA, qué aspectos y métodos se utilizan para construirla, cómo la autogestión de LLMs encaja en ello, cómo los países abordan el desafío.

Mejores LLMs para Ollama en GPU con 16 GB de VRAM

Prueba de velocidad de LLM en RTX 4080 con 16 GB de VRAM

Ejecutar modelos de lenguaje grandes localmente te brinda privacidad, capacidad para trabajar sin conexión y cero costos de API. Este benchmark revela exactamente lo que se puede esperar de 9 populares LLMs en Ollama en una RTX 4080.

Aumentan los precios de las GPU y la RAM en Australia: RTX 5090 sube un 15%, la RAM un 38% - enero de 2026

Verificación de precios de GPU y RAM en enero de 2025

Hoy nos estamos enfocando en las GPUs de consumo de alto nivel y módulos de RAM. Específicamente, me estoy enfocando en precios de RTX-5080 y RTX-5090, y 32GB (2x16GB) DDR5 6000.

Mejores emuladores de terminal para Linux: Comparativa de 2026

Elige el terminal adecuado para tu flujo de trabajo en Linux

Precios de DGX Spark AU: $6,249-$7,999 en principales retailers

Precios reales en AUD de retailers australianos ahora

El

NVIDIA DGX Spark

(GB10 Grace Blackwell) ahora está

disponible en Australia

en principales retailers de PC con stock local.

Si has estado siguiendo la

disponibilidad y precios globales del DGX Spark,

te interesará saber que los precios en Australia van desde $6,249 a $7,999 AUD según la configuración de almacenamiento y el retailer.

Autogestión de Cognee: Pruebas de rendimiento de LLM

Pruebas de Cognee con LLMs locales - resultados reales

Cognee es un marco de Python para construir grafos de conocimiento a partir de documentos utilizando LLMs. ¿Pero funciona con modelos autohospedados?

Ubuntu perdió la red después de la actualización del kernel

Cómo solucioné problemas de red en Ubuntu

Después de instalar automáticamente un nuevo núcleo, Ubuntu 24.04 ha perdido la conexión de red ethernet. Este problema frustrante ocurrió de nuevo para mí, así que estoy documentando la solución aquí para ayudar a otros que enfrenten el mismo problema.

Precio de la RAM en Australia - Diciembre 2025

Entrada corta, solo indicando el precio

Con esta volatilidad loca de los precios de la RAM, para formar y tener una mejor imagen, primero vamos a rastrear el precio de la RAM en Australia nosotros mismos.

Aumento del precio de la RAM: hasta un 619% en 2025

Los precios de la RAM aumentan un 163-619% debido a la demanda de IA que agota el suministro

El mercado de la memoria está experimentando una volatilidad de precios sin precedentes a finales de 2025, con los precios de la RAM aumentando drásticamente en todos los segmentos.

Precios de la NVidia RTX 5080 y RTX 5090 en Australia - noviembre de 2025

Precios de GPU para consumidor adecuadas para IA - RTX 5080 y RTX 5090

Vamos a comparar precios para tarjetas gráficas de alto nivel para consumidores, que son adecuadas para LLMs en particular y la IA en general.

Específicamente, me estoy enfocando en

precios de RTX-5080 y RTX-5090.

Infraestructura de IA en hardware de consumo

Implemente inteligencia artificial empresarial en hardware de presupuesto con modelos abiertos

La democratización de la IA está aquí. Con LLMs de código abierto como Llama 3, Mixtral y Qwen ahora rivales de modelos propietarios, los equipos pueden construir una poderosa infraestructura de IA usando hardware de consumo - reduciendo costos mientras se mantiene el control total sobre la privacidad de los datos y la implementación.

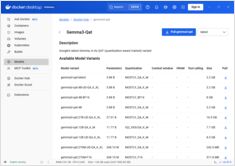

Añadir soporte para GPU de NVIDIA al ejecutor de modelos de Docker

Habilite la aceleración de GPU para Docker Model Runner con soporte de NVIDIA CUDA

Docker Model Runner es la herramienta oficial de Docker para ejecutar modelos de IA localmente, pero habilitar la aceleración de GPU de NVidia en Docker Model Runner requiere una configuración específica.

NVIDIA DGX Spark vs Mac Studio vs RTX-4080: Comparación de rendimiento de Ollama

Resultados de benchmarks de GPT-OSS 120b en tres plataformas de IA

Investigué algunos interesantes tests de rendimiento del modelo GPT-OSS 120b ejecutándose en Ollama en tres plataformas diferentes: NVIDIA DGX Spark, Mac Studio y RTX 4080. El modelo GPT-OSS 120b del repositorio Ollama tiene un tamaño de 65 GB, lo que significa que no cabe en los 16 GB de VRAM de una RTX 4080 (ni en la más reciente RTX 5080).

Docker Model Runner Guía Rápida: Comandos y Ejemplos

Referencia rápida para comandos de Docker Model Runner

Docker Model Runner (DMR) es la solución oficial de Docker para ejecutar modelos de IA localmente, introducida en abril de 2025. Esta guía rápida proporciona una referencia rápida para todos los comandos esenciales, configuraciones y mejores prácticas.

GNOME Boxes: Una guía completa sobre características, ventajas, desafíos y alternativas

Gestión sencilla de máquinas virtuales para Linux con GNOME Boxes

En el panorama actual de la computación, la virtualización se ha convertido en esencial para el desarrollo, las pruebas y la ejecución de múltiples sistemas operativos. Para usuarios de Linux que buscan una forma sencilla e intuitiva de gestionar máquinas virtuales, GNOME Boxes destaca como una opción liviana y amigable con el usuario que prioriza la facilidad de uso sin sacrificar la funcionalidad.