Cross-Modal-Einbettungen: Brücken zwischen KI-Modalen

Vereinheitlichen Sie Text, Bilder und Audio in gemeinsamen Einbettungsräumen

Cross-modale Einbettungen stellen einen Durchbruch in der künstlichen Intelligenz dar und ermöglichen das Verständnis und die Schlussfolgerung über verschiedene Datentypen hinweg in einem einheitlichen Darstellungsraum.

Diese Technologie treibt moderne multimodale Anwendungen an, von der Bildersuche bis zur Inhaltsgenerierung.

Dieses Bild stammt aus dem Artikel:

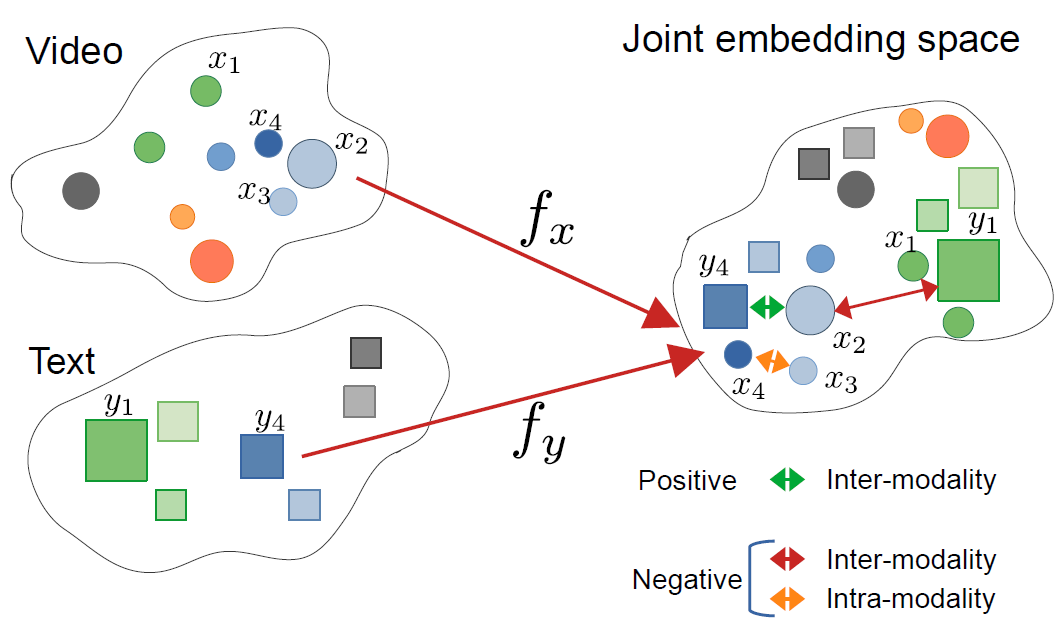

CrossCLR: cross-modal contrastive learning for multi-modal video representations, von Mohammadreza Zolfaghari und anderen

Dieses Bild stammt aus dem Artikel:

CrossCLR: cross-modal contrastive learning for multi-modal video representations, von Mohammadreza Zolfaghari und anderen

Verständnis von Cross-Modal-Einbettungen

Cross-modale Einbettungen sind Vektorrepräsentationen, die Informationen aus verschiedenen Modalitäten - wie Text, Bilder, Audio und Video - in einen gemeinsamen Einbettungsraum codieren. Im Gegensatz zu traditionellen Einbettungen mit einer einzigen Modalität lernen cross-modale Ansätze eine einheitliche Darstellung, bei der semantisch ähnliche Konzepte zusammengefasst werden, unabhängig von ihrem ursprünglichen Format.

Was sind Cross-Modal-Einbettungen?

Im Kern lösen cross-modale Einbettungen eine kritische Herausforderung in der KI: Wie man Informationen über verschiedene Datentypen hinweg vergleichen und in Beziehung setzen kann. Ein traditioneller Bildklassifikator kann nur mit Bildern arbeiten, während ein Textmodell nur Text verarbeitet. Cross-modale Einbettungen überbrücken diese Lücke, indem sie verschiedene Modalitäten in einen gemeinsamen Vektorraum projizieren, in dem:

- Ein Bild einer Katze und das Wort “Katze” ähnliche Einbettungsvektoren haben

- Semantische Beziehungen über Modalitäten hinweg erhalten bleiben

- Abstandsmetriken (Kosinus-Ähnlichkeit, euklidischer Abstand) die cross-modale Ähnlichkeit messen

Diese einheitliche Darstellung ermöglicht leistungsstarke Fähigkeiten wie die Suche nach Bildern mit Textabfragen, die Generierung von Bildunterschriften oder sogar die Zero-Shot-Klassifizierung ohne aufgabenbezogenes Training.

Die Architektur hinter dem Cross-Modal-Lernen

Moderne cross-modale Systeme nutzen typischerweise Dual-Encoder-Architekturen mit kontrastiven Lernzielen:

Dual Encoder: Separate neuronale Netze codieren jede Modalität. Zum Beispiel verwendet CLIP:

- Einen Vision Transformer (ViT) oder ResNet für Bilder

- Einen transformerbasierten Textencoder für Sprache

Kontrastives Lernen: Das Modell lernt, indem es die Ähnlichkeit zwischen passenden Paaren (z. B. Bild und seine Bildunterschrift) maximiert, während es die Ähnlichkeit zwischen nicht passenden Paaren minimiert. Die kontrastive Verlustfunktion kann wie folgt ausgedrückt werden:

[ \mathcal{L} = -\log \frac{\exp(\text{sim}(v_i, t_i) / \tau)}{\sum_{j=1}^{N} \exp(\text{sim}(v_i, t_j) / \tau)} ]

wobei (v_i) die Bildeinbettung, (t_i) die Texteinbettung, (\text{sim}) die Ähnlichkeit (typischerweise Kosinus) und (\tau) ein Temperaturparameter ist.

Wichtige Technologien und Modelle

CLIP: Pionierarbeit im Bereich Vision-Language-Verständnis

OpenAIs CLIP (Contrastive Language-Image Pre-training) revolutionierte das Feld, indem es auf 400 Millionen Bild-Text-Paare aus dem Internet trainiert wurde. Die Modellarchitektur besteht aus:

import torch

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

# Laden des vorab trainierten CLIP-Modells

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# Vorbereiten der Eingaben

image = Image.open("example.jpg")

texts = ["ein Foto einer Katze", "ein Foto eines Hundes", "ein Foto eines Vogels"]

# Verarbeiten und Einbettungen erhalten

inputs = processor(text=texts, images=image, return_tensors="pt", padding=True)

# Cross-modale Ähnlichkeitsbewertungen erhalten

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = logits_per_image.softmax(dim=1)

print(f"Wahrscheinlichkeiten: {probs}")

Die entscheidende Innovation von CLIP war die Skalierung und Einfachheit. Durch das Training auf massiven, web-basierten Daten ohne manuelle Annotation erreichte es bemerkenswerte Zero-Shot-Transferfähigkeiten. Wie unterscheidet sich CLIP von traditionellen Visuellen Modellen? Im Gegensatz zu überwachten Klassifikatoren, die auf festen Labelsätzen trainiert werden, lernt CLIP aus natürlicher Sprachüberwachung, was es anpassbar an jedes visuelle Konzept macht, das in Text beschrieben werden kann.

ImageBind: Erweiterung auf sechs Modalitäten

Metas ImageBind erweitert cross-modale Einbettungen über Vision und Sprache hinaus und umfasst:

- Audio (Umgebungsgeräusche, Sprache)

- Tiefeninformationen

- Wärmekamerabilder

- IMU (Bewegungsmessersensor)-Daten

Dies schafft einen wirklich multimodalen Einbettungsraum, in dem alle sechs Modalitäten abgestimmt sind. Die entscheidende Erkenntnis ist, dass Bilder als “Bindungsmodalität” dienen - durch das Koppeln von Bildern mit anderen Modalitäten und das Nutzen der bestehenden Vision-Sprache-Abstimmung schafft ImageBind einen einheitlichen Raum, ohne dass alle möglichen Modalitätspaare während des Trainings erforderlich sind.

Open-Source-Alternativen

Das Ökosystem hat sich mit mehreren Open-Source-Implementierungen erweitert:

OpenCLIP: Eine Community-Implementierung, die größere Modelle und diverse Trainingsrezepte bietet:

import open_clip

model, _, preprocess = open_clip.create_model_and_transforms(

'ViT-L-14',

pretrained='laion2b_s32b_b82k'

)

tokenizer = open_clip.get_tokenizer('ViT-L-14')

LAION-5B-Modelle: Trainiert auf dem massiven Open-Source-Datensatz LAION-5B, bieten sie Alternativen zu proprietären Modellen mit vergleichbarer oder besserer Leistung.

Für Entwickler, die an state-of-the-art Open-Source-Text-Einbettungslösungen interessiert sind, bieten die Qwen3 Embedding & Reranker Modelle auf Ollama hervorragende mehrsprachige Leistung mit einfacher lokaler Bereitstellung.

Implementierungsstrategien

Aufbau eines Cross-Modal-Suchsystems

Eine praktische Implementierung von cross-modalen Einbettungen für die semantische Suche umfasst mehrere Komponenten. Welche sind die Hauptanwendungen von cross-modalen Einbettungen? Sie ermöglichen Anwendungsfälle von der E-Commerce-Produktsuche bis zur Inhaltsmoderation und kreativen Tools.

import numpy as np

from typing import List, Tuple

import faiss

from transformers import CLIPModel, CLIPProcessor

class CrossModalSearchEngine:

def __init__(self, model_name: str = "openai/clip-vit-base-patch32"):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.image_index = None

self.image_metadata = []

def encode_images(self, images: List) -> np.ndarray:

"""Bilder in Einbettungen codieren"""

inputs = self.processor(images=images, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_image_features(**inputs)

return embeddings.cpu().numpy()

def encode_text(self, texts: List[str]) -> np.ndarray:

"""Textabfragen in Einbettungen codieren"""

inputs = self.processor(text=texts, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_text_features(**inputs)

return embeddings.cpu().numpy()

def build_index(self, image_embeddings: np.ndarray):

"""FAISS-Index für effiziente Ähnlichkeitsuche erstellen"""

dimension = image_embeddings.shape[1]

# Einbettungen für Kosinus-Ähnlichkeit normalisieren

faiss.normalize_L2(image_embeddings)

# Index erstellen (HNSW für großflächige Bereitstellung)

self.image_index = faiss.IndexHNSWFlat(dimension, 32)

self.image_index.hnsw.efConstruction = 40

self.image_index.add(image_embeddings)

def search(self, query: str, k: int = 10) -> List[Tuple[int, float]]:

"""Suche nach Bildern mit Textabfrage"""

query_embedding = self.encode_text([query])

faiss.normalize_L2(query_embedding)

distances, indices = self.image_index.search(query_embedding, k)

return list(zip(indices[0], distances[0]))

# Beispiel für die Verwendung

engine = CrossModalSearchEngine()

# Index aus Bildsammlung erstellen

image_embeddings = engine.encode_images(image_collection)

engine.build_index(image_embeddings)

# Suche mit Text

results = engine.search("Sonnenuntergang über Bergen", k=5)

Feinabstimmung für domänenspezifische Aufgaben

Während vorab trainierte Modelle für allgemeine Zwecke gut funktionieren, profitieren domänenspezifische Anwendungen von der Feinabstimmung:

from transformers import CLIPModel, CLIPProcessor, AdamW

import torch.nn as nn

class FineTuneCLIP:

def __init__(self, model_name: str, num_epochs: int = 10):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.num_epochs = num_epochs

def contrastive_loss(self, image_embeddings, text_embeddings, temperature=0.07):

"""InfoNCE kontrastive Verlust berechnen"""

# Einbettungen normalisieren

image_embeddings = nn.functional.normalize(image_embeddings, dim=1)

text_embeddings = nn.functional.normalize(text_embeddings, dim=1)

# Ähnlichkeitsmatrix berechnen

logits = torch.matmul(image_embeddings, text_embeddings.T) / temperature

# Labels sind diagonal (passende Paare)

labels = torch.arange(len(logits), device=logits.device)

# Symmetrischer Verlust

loss_i = nn.functional.cross_entropy(logits, labels)

loss_t = nn.functional.cross_entropy(logits.T, labels)

return (loss_i + loss_t) / 2

def train(self, dataloader, learning_rate=5e-6):

"""Feinabstimmung auf domänenspezifische Daten"""

optimizer = AdamW(self.model.parameters(), lr=learning_rate)

self.model.train()

for epoch in range(self.num_epochs):

total_loss = 0

for batch in dataloader:

images, texts = batch['images'], batch['texts']

# Eingaben verarbeiten

inputs = self.processor(

text=texts,

images=images,

return_tensors="pt",

padding=True

)

# Vorwärtsdurchlauf

outputs = self.model(**inputs, return_loss=True)

loss = outputs.loss

# Rückwärtsdurchlauf

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"Epoch {epoch+1}/{self.num_epochs}, Loss: {avg_loss:.4f}")

Produktionsbereitstellungsüberlegungen

Optimierung der Inferenzleistung

Wie kann ich Cross-Modal-Embeddings für die Produktion optimieren? Die Leistungsoptimierung ist für die reale Bereitstellung entscheidend:

Modellquantisierung: Reduzieren Sie die Modellgröße und erhöhen Sie die Inferenzgeschwindigkeit:

import torch

from torch.quantization import quantize_dynamic

# Dynamische Quantisierung für CPU-Inferenz

quantized_model = quantize_dynamic(

model,

{torch.nn.Linear},

dtype=torch.qint8

)

ONNX-Konvertierung: Exportieren Sie für optimierte Inferenz:

import torch.onnx

dummy_input = processor(text=["sample"], return_tensors="pt")

torch.onnx.export(

model,

tuple(dummy_input.values()),

"clip_model.onnx",

input_names=['input_ids', 'attention_mask'],

output_names=['output'],

dynamic_axes={

'input_ids': {0: 'batch_size'},

'attention_mask': {0: 'batch_size'}

}

)

Batch-Verarbeitung: Maximieren Sie die GPU-Nutzung durch Batching:

def batch_encode(items: List, batch_size: int = 32):

"""Verarbeiten Sie Elemente in Batches für Effizienz"""

embeddings = []

for i in range(0, len(items), batch_size):

batch = items[i:i+batch_size]

batch_embeddings = encode_batch(batch)

embeddings.append(batch_embeddings)

return np.concatenate(embeddings, axis=0)

Skalierbare Vektorspeicherung

Für groß angelegte Anwendungen sind Vektordatenbanken essenziell. Welche Frameworks unterstützen Cross-Modal-Embedding-Implementierungen? Neben den Modellen selbst ist die Infrastruktur wichtig:

FAISS (Facebook AI Similarity Search): Effiziente Ähnlichkeits-Suchbibliothek

- Unterstützt Milliarden von Vektoren

- Mehrere Index-Typen (flat, IVF, HNSW)

- GPU-Beschleunigung verfügbar

Milvus: Open-Source-Vektordatenbank

from pymilvus import connections, Collection, FieldSchema, CollectionSchema, DataType

# Definieren Sie das Schema

fields = [

FieldSchema(name="id", dtype=DataType.INT64, is_primary=True, auto_id=True),

FieldSchema(name="embedding", dtype=DataType.FLOAT_VECTOR, dim=512),

FieldSchema(name="metadata", dtype=DataType.JSON)

]

schema = CollectionSchema(fields, description="Bildeinbettungen")

# Erstellen Sie eine Sammlung

collection = Collection("images", schema)

# Erstellen Sie einen Index

index_params = {

"metric_type": "IP", # Inner product (Kosinus-Ähnlichkeit)

"index_type": "IVF_FLAT",

"params": {"nlist": 1024}

}

collection.create_index("embedding", index_params)

Pinecone/Weaviate: Verwaltete Vektordatenbankdienste, die einfache Skalierung und Wartung bieten.

Fortgeschrittene Anwendungsfälle und Anwendungen

Zero-Shot-Klassifizierung

Cross-Modal-Embeddings ermöglichen Klassifizierung ohne aufgaben-spezifisches Training. Diese Fähigkeit geht über traditionelle Computer-Vision-Ansätze hinaus—for instance, wenn Sie an spezialisierter Objekterkennung mit TensorFlow interessiert sind, stellt dies einen komplementären überwachten Lernansatz für spezifische Erkennungsaufgaben dar.

def zero_shot_classify(image, candidate_labels: List[str], model, processor):

"""Klassifizieren Sie Bilder in beliebige Kategorien"""

# Erstellen Sie Text-Prompts

text_inputs = [f"a photo of a {label}" for label in candidate_labels]

# Holen Sie sich die Embeddings

inputs = processor(

text=text_inputs,

images=image,

return_tensors="pt",

padding=True

)

outputs = model(**inputs)

# Berechnen Sie Wahrscheinlichkeiten

logits = outputs.logits_per_image

probs = logits.softmax(dim=1)

# Geben Sie die sortierten Vorhersagen zurück

sorted_indices = probs.argsort(descending=True)[0]

return [(candidate_labels[idx], probs[0][idx].item()) for idx in sorted_indices]

# Beispielverwendung

labels = ["cat", "dog", "bird", "fish", "horse"]

predictions = zero_shot_classify(image, labels, model, processor)

print(f"Top prediction: {predictions[0]}")

Multimodales RAG (Retrieval-Augmented Generation)

Die Kombination von Cross-Modal-Embeddings mit Sprachmodellen schafft leistungsstarke multimodale RAG-Systeme. Sobald Sie relevante Dokumente abgerufen haben, kann Reranking mit Embedding-Modellen die Qualität der Ergebnisse deutlich verbessern, indem abgerufene Kandidaten basierend auf der Relevanz neu geordnet werden:

class MultimodalRAG:

def __init__(self, clip_model, llm_model):

self.clip = clip_model

self.llm = llm_model

self.knowledge_base = []

def add_documents(self, images, texts, metadata):

"""Fügen Sie multimodale Dokumente zur Wissensbasis hinzu"""

image_embeds = self.clip.encode_images(images)

text_embeds = self.clip.encode_text(texts)

# Speichern Sie kombinierte Informationen

for i, (img_emb, txt_emb, meta) in enumerate(

zip(image_embeds, text_embeds, metadata)

):

self.knowledge_base.append({

'image_embedding': img_emb,

'text_embedding': txt_emb,

'metadata': meta,

'index': i

})

def retrieve(self, query: str, k: int = 5):

"""Rufen Sie relevante multimodale Inhalte ab"""

query_embedding = self.clip.encode_text([query])[0]

# Berechnen Sie Ähnlichkeiten

similarities = []

for doc in self.knowledge_base:

# Durchschnittliche Ähnlichkeit über Modalitäten

img_sim = np.dot(query_embedding, doc['image_embedding'])

txt_sim = np.dot(query_embedding, doc['text_embedding'])

combined_sim = (img_sim + txt_sim) / 2

similarities.append((combined_sim, doc))

# Rückgabe der Top-k

similarities.sort(reverse=True)

return [doc for _, doc in similarities[:k]]

def answer_query(self, query: str):

"""Beantworten Sie die Abfrage unter Verwendung des abgerufenen multimodalen Kontexts"""

retrieved_docs = self.retrieve(query)

# Konstruieren Sie den Kontext aus den abgerufenen Dokumenten

context = "\n".join([doc['metadata']['text'] for doc in retrieved_docs])

# Generieren Sie die Antwort mit LLM

prompt = f"Context:\n{context}\n\nQuestion: {query}\n\nAnswer:"

answer = self.llm.generate(prompt)

return answer, retrieved_docs

Wenn Sie Produktions-RAG-Systeme in Go implementieren, könnte dieser Leitfaden zu Reranking von Textdokumenten mit Ollama und Qwen3 Embedding-Modell in Go besonders nützlich sein, um die Abrufeffizienz zu optimieren.

Inhaltsmoderation und Sicherheit

Cross-Modal-Embeddings eignen sich hervorragend zur Erkennung unangemessener Inhalte über verschiedene Modalitäten hinweg:

class ContentModerator:

def __init__(self, model, processor):

self.model = model

self.processor = processor

# Definieren Sie Sicherheitskategorien

self.unsafe_categories = [

"gewaltinhalt",

"erwachseneninhalte",

"hassbilder",

"graphische gewalt",

"explizite materialien"

]

self.safe_categories = [

"sicher für die arbeit",

"familienfreundlich",

"bildungsinhalte"

]

def moderate_image(self, image, threshold: float = 0.3):

"""Überprüfen Sie, ob das Bild unsicheren Inhalt enthält"""

# Kombinieren Sie alle Kategorien

all_categories = self.unsafe_categories + self.safe_categories

text_inputs = [f"image containing {cat}" for cat in all_categories]

# Holen Sie sich die Vorhersagen

inputs = self.processor(

text=text_inputs,

images=image,

return_tensors="pt"

)

outputs = self.model(**inputs)

probs = outputs.logits_per_image.softmax(dim=1)[0]

# Überprüfen Sie unsichere Kategorien

unsafe_scores = probs[:len(self.unsafe_categories)]

max_unsafe_score = unsafe_scores.max().item()

return {

'is_safe': max_unsafe_score < threshold,

'confidence': 1 - max_unsafe_score,

'flagged_categories': [

self.unsafe_categories[i]

for i, score in enumerate(unsafe_scores)

if score > threshold

]

}

Best Practices und häufige Fallstricke

Datenvorverarbeitung

Eine ordnungsgemäße Vorverarbeitung ist für eine optimale Leistung entscheidend:

from torchvision import transforms

# Standard-CLIP-Vorverarbeitung

clip_transform = transforms.Compose([

transforms.Resize(224, interpolation=transforms.InterpolationMode.BICUBIC),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(

mean=[0.48145466, 0.4578275, 0.40821073],

std=[0.26862954, 0.26130258, 0.27577711]

)

])

Umgang mit Bias und Fairness

Cross-Modal-Modelle können Bias aus den Trainingsdaten übernehmen:

Abschwächungsstrategien:

- Bewertung auf vielfältigen demografischen Gruppen

- Verwendung von Entbiasing-Techniken während des Feintunings

- Implementierung von Fairness-aware Retrieval

- Regelmäßige Überprüfung und Überwachung in der Produktion

Bewertung der Embedding-Qualität

Überwachen Sie die Embedding-Qualität in der Produktion:

def assess_embedding_quality(embeddings: np.ndarray):

"""Berechnen Sie Metriken für die Embedding-Qualität"""

# Berechnen Sie den durchschnittlichen paarweisen Abstand

distances = np.linalg.norm(

embeddings[:, None] - embeddings[None, :],

axis=2

)

avg_distance = distances.mean()

# Überprüfen Sie auf Clustering (geringer intra-Cluster-Abstand)

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=10)

labels = kmeans.fit_predict(embeddings)

# Berechnen Sie den Silhouetten-Score

from sklearn.metrics import silhouette_score

score = silhouette_score(embeddings, labels)

return {

'avg_pairwise_distance': avg_distance,

'silhouette_score': score

}

Docker-Deploymentsbeispiel

Paketieren Sie Ihre crossmodale Anwendung für eine einfache Bereitstellung:

FROM nvidia/cuda:11.8.0-cudnn8-runtime-ubuntu22.04

# Installieren Sie Python und Abhängigkeiten

RUN apt-get update && apt-get install -y python3-pip

WORKDIR /app

# Installieren Sie Anforderungen

COPY requirements.txt .

RUN pip3 install --no-cache-dir -r requirements.txt

# Kopieren Sie den Anwendungscode

COPY . .

# API-Port freigeben

EXPOSE 8000

# Führen Sie den API-Server aus

CMD ["uvicorn", "api:app", "--host", "0.0.0.0", "--port", "8000"]

# api.py - FastAPI-Server für crossmodale Einbettungen

from fastapi import FastAPI, File, UploadFile

from pydantic import BaseModel

import torch

from PIL import Image

import io

app = FastAPI()

# Laden Sie das Modell beim Start

@app.on_event("startup")

async def load_model():

global model, processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

if torch.cuda.is_available():

model = model.cuda()

class TextQuery(BaseModel):

text: str

@app.post("/embed/text")

async def embed_text(query: TextQuery):

inputs = processor(text=[query.text], return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_text_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/embed/image")

async def embed_image(file: UploadFile = File(...)):

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(images=image, return_tensors="pt")

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_image_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/similarity")

async def compute_similarity(

text: TextQuery,

file: UploadFile = File(...)

):

# Holen Sie sich beide Einbettungen

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(text=[text.text], images=image, return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

outputs = model(**inputs)

similarity = outputs.logits_per_image[0][0].item()

return {"similarity": similarity}

Zukunftsrichtungen

Das Feld der crossmodalen Einbettungen entwickelt sich weiterhin extrem schnell:

Größere Modalitätsabdeckung: Zukünftige Modelle werden wahrscheinlich zusätzliche Modalitäten wie Berührung (haptisches Feedback), Geruch und Geschmacksdaten für ein wirklich umfassendes multimodales Verständnis einbeziehen.

Verbesserte Effizienz: Forschung zu Destillation und effizienten Architekturen wird leistungsstarke crossmodale Modelle auf Edge-Geräten zugänglich machen.

Bessere Ausrichtung: Fortgeschrittene Techniken zur präziseren Ausrichtung von Modalitäten, einschließlich Zyklus-Konsistenzverluste und adversarisches Training.

Zusammensetzungsverständnis: Über einfaches Objekterkennen hinausgehen, um komplexe Beziehungen und Kompositionen über Modalitäten hinweg zu verstehen.

Temporale Modellierung: Bessere Handhabung von Videodaten und Zeitreihendaten mit expliziter zeitlicher Vernunft in Einbettungsräumen.

Nützliche Links

- OpenAI CLIP Repository

- OpenCLIP: Open-Source-Implementierung

- Hugging Face Transformers Dokumentation

- Meta ImageBind

- LAION-5B Dataset

- FAISS Dokumentation

- Milvus Vector Database

- Pinecone Vector Database

- Paper: Learning Transferable Visual Models From Natural Language Supervision

- Paper: ImageBind: One Embedding Space To Bind Them All

- Concrete Reinforcement Bar Caps Objekterkennung mit TensorFlow

- Reranking mit Einbettungsmodellen

- Reranking von Textdokumenten mit Ollama und Qwen3 Embedding-Modell - in Go

- Qwen3 Embedding & Reranker-Modelle auf Ollama: State-of-the-Art-Leistung

Crossmodale Einbettungen stellen einen Paradigmenwechsel in der Art und Weise dar, wie KI-Systeme Informationen verarbeiten und verstehen. Durch das Überwinden der Barrieren zwischen verschiedenen Datentypen ermöglichen diese Techniken natürlichere und leistungsfähigere KI-Anwendungen. Ob Sie Suchsysteme, Inhaltsmoderationstools oder kreative Anwendungen entwickeln, die Beherrschung von crossmodalen Einbettungen eröffnet eine Welt von Möglichkeiten für Innovationen in der multimodalen KI.