FLUX.1-dev mit GGUF Q8 ausführen

Beschleunigen Sie FLUX.1-dev mit GGUF-Quantisierung

FLUX.1-dev ist ein leistungsstarkes Text-zu-Bild-Modell, das beeindruckende Ergebnisse liefert, aber dessen Speicherbedarf von über 24GB die Nutzung auf vielen Systemen erschwert. GGUF-Quantisierung von FLUX.1-dev bietet eine Lösung, indem sie den Speicherbedarf um etwa 50% reduziert, während die Bildqualität erhalten bleibt.

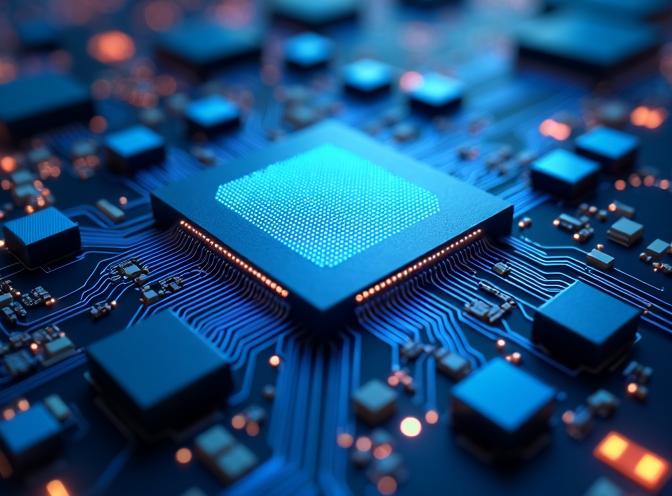

Dieses Bild wurde mit dem Q8 quantisierten FLUX.1-dev-Modell im GGUF-Format erzeugt und zeigt, dass die Qualität auch bei reduziertem Speicherbedarf erhalten bleibt.

Dieses Bild wurde mit dem Q8 quantisierten FLUX.1-dev-Modell im GGUF-Format erzeugt und zeigt, dass die Qualität auch bei reduziertem Speicherbedarf erhalten bleibt.

Was ist GGUF-Quantisierung?

GGUF (GPT-Generated Unified Format) ist ein Quantisierungsformat, das ursprünglich für Sprachmodelle entwickelt wurde, aber nun auch für Diffusionsmodelle wie FLUX unterstützt wird. Quantisierung reduziert die Modellgröße, indem Gewichte in Formaten mit geringerer Präzision (8-Bit, 6-Bit oder 4-Bit) statt in voller 16-Bit- oder 32-Bit-Präzision gespeichert werden.

Für FLUX.1-dev kann die Transformer-Komponente (der größte Teil des Modells) quantisiert werden, wodurch sich der Speicherbedarf von etwa 24GB auf 12GB mit Q8_0-Quantisierung oder sogar weniger mit aggressiveren Quantisierungsstufen reduziert.

Vorteile der GGUF-Quantisierung

Die Hauptvorteile der Verwendung von GGUF-quantisierten FLUX-Modellen umfassen:

- Reduzierter Speicherbedarf: VRAM-Anforderungen werden halbiert, wodurch FLUX.1-dev auf mehr Hardware zugänglich wird

- Beibehaltung der Qualität: Q8_0-Quantisierung erhält die Bildqualität mit minimalen sichtbaren Unterschieden

- Schnelleres Laden: Quantisierte Modelle laden schneller aufgrund kleinerer Dateigrößen

- Geringerer Stromverbrauch: Reduzierter Speicherbedarf führt zu einem geringeren Stromverbrauch während der Inferenz

In unseren Tests verwendet das quantisierte Modell etwa 12-15GB VRAM im Vergleich zu 24GB+ für das Vollmodell, während die Generierungszeit ähnlich bleibt.

Installation und Einrichtung

Um das GGUF-quantisierte FLUX.1-dev zu verwenden, benötigen Sie zusätzlich zum Standard-Diffusers-Paket das gguf-Paket. Wenn Sie bereits FLUX für Text-zu-Bild-Generierung nutzen, sind Ihnen die Grundlagen der Einrichtung bekannt.

Wenn Sie uv als Ihr Python-Paketmanager verwenden, können Sie die erforderlichen Pakete mit folgendem Befehl installieren:

uv pip install -U diffusers torch transformers gguf

Oder mit standardmäßigem pip:

pip install -U diffusers torch transformers gguf

Implementierung

Der wesentliche Unterschied bei der Verwendung von GGUF-quantisierten Modellen besteht darin, dass Sie den Transformer separat mit FluxTransformer2DModel.from_single_file() und GGUFQuantizationConfig laden und ihn dann an die Pipeline übergeben. Wenn Sie eine schnelle Referenz für die Python-Syntax benötigen, werfen Sie einen Blick auf den Python-Cheatsheet. Hier ist ein vollständiges funktionierendes Beispiel:

import os

import torch

from diffusers import FluxPipeline, FluxTransformer2DModel, GGUFQuantizationConfig

# Pfade

gguf_model_path = "/pfad/zu/flux1-dev-Q8_0.gguf"

base_model_path = "/pfad/zu/FLUX.1-dev-config" # Nur Konfigurationsdateien

# Laden des GGUF-quantisierten Transformers

print(f"Laden des GGUF-quantisierten Transformers von: {gguf_model_path}")

transformer = FluxTransformer2DModel.from_single_file(

gguf_model_path,

quantization_config=GGUFQuantizationConfig(compute_dtype=torch.bfloat16),

config=base_model_path,

subfolder="transformer",

torch_dtype=torch.bfloat16,

)

# Erstellen der Pipeline mit quantisiertem Transformer

print(f"Erstellen der Pipeline mit Basis-Modell: {base_model_path}")

pipe = FluxPipeline.from_pretrained(

base_model_path,

transformer=transformer,

torch_dtype=torch.bfloat16,

)

# Aktivieren von CPU-Offloading (erforderlich für GGUF)

pipe.enable_model_cpu_offload()

# Hinweis: enable_sequential_cpu_offload() ist NICHT mit GGUF kompatibel

# Bild generieren

prompt = "Eine futuristische Stadtlandschaft bei Sonnenuntergang mit Neonlichtern"

image = pipe(

prompt,

height=496,

width=680,

guidance_scale=3.5,

num_inference_steps=60,

max_sequence_length=512,

generator=torch.Generator("cpu").manual_seed(42)

).images[0]

image.save("output.jpg")

Wichtige Überlegungen

Modellkonfigurationsdateien

Bei der Verwendung von GGUF-Quantisierung benötigen Sie weiterhin die Modellkonfigurationsdateien des ursprünglichen FLUX.1-dev-Modells. Dazu gehören:

model_index.json- Pipeline-Struktur- Komponenten-Konfigurationen (Transformer, text_encoder, text_encoder_2, vae, scheduler)

- Tokenizer-Dateien

- Text-Encoder- und VAE-Gewichte (diese werden nicht quantisiert)

Die Transformer-Gewichte stammen aus der GGUF-Datei, aber alle anderen Komponenten erfordern die ursprünglichen Modelldateien.

CPU-Offloading-Kompatibilität

Wichtig: enable_sequential_cpu_offload() ist nicht mit GGUF-quantisierten Modellen kompatibel und führt zu einem KeyError: None-Fehler. Stattdessen verwende ich enable_model_cpu_offload(), wenn ich mit quantisierten Transformern arbeite.

Quantisierungsstufen

Verfügbare Quantisierungsstufen für FLUX.1-dev umfassen:

- Q8_0: Beste Qualität, ~14-15GB Speicher (empfohlen)

- Q6_K: Guter Kompromiss, ~12GB Speicher

- Q4_K: Maximale Kompression, ~8GB Speicher (ich nehme an, dass dies die Qualität nicht positiv beeinflusst)

Für die meisten Anwendungsfälle bietet Q8_0 das beste Gleichgewicht zwischen Speichereinsparung und Bildqualität.

Leistungsvergleich

In unseren Tests mit identischen Prompts und Einstellungen:

| Modell | VRAM-Verbrauch | Generierungszeit | Qualität |

|---|---|---|---|

| Vollständiges FLUX.1-dev | 24GB? | Ich habe keine GPU dieser Größe | Hervorragend (ich denke) |

| Vollständiges FLUX.1-dev | ~3GB mit sequential_cpu_offload() | ~329s | Hervorragend |

| GGUF Q8_0 | ~14-15GB | ~98s !!! | Hervorragend |

| GGUF Q6_K | ~10-12GB | ~116s | Sehr gut |

Das quantisierte Modell benötigt aufgrund des reduzierten CPU-Offloadings jetzt mehr als die dreifache Generierungsgeschwindigkeit bei deutlich geringerem Speicherbedarf, was es für Systeme mit begrenztem VRAM praktisch macht.

Ich habe beide Modelle mit dem folgenden Prompt getestet:

Eine futuristische Nahaufnahme eines Transformer-Inference-ASIC-Chips mit komplexer Schaltungsanordnung, blauem Licht, das von dichten Matrix-Multiplikationseinheiten und ALUs mit niedriger Präzision ausgeht, umgeben von On-Chip-SRAM-Puffern und Quantisierungspipelines, in hyperdetailliertem fotorealistischem Stil mit einer kalten, klinischen Beleuchtung dargestellt.

Die Beispielausgabe von FLUX.1-dev Q8 ist das Titelbild dieses Beitrags - siehe oben.

Die Beispielausgabe des nicht quantisierten FLUX.1-dev finden Sie unten:

Ich sehe kaum einen Unterschied in der Qualität.

Fazit

Die GGUF-Quantisierung macht FLUX.1-dev für eine breitere Palette von Hardware zugänglich, während die hohe Bildqualität erhalten bleibt, für die das Modell bekannt ist. Durch die Reduzierung des Speicherbedarfs um etwa 50% können Sie State-of-the-Art-Text-zu-Bild-Generierung auf kostengünstigerer Hardware ohne signifikanten Qualitätsverlust durchführen.

Die Implementierung ist mit der Diffusers-Bibliothek einfach und erfordert nur geringe Änderungen an der Standard-FLUX-Pipeline-Einrichtung. Für die meisten Benutzer bietet die Q8_0-Quantisierung das optimale Gleichgewicht zwischen Speichereffizienz und Bildqualität.

Wenn Sie mit FLUX.1-Kontext-dev für Bildvergrößerung arbeiten, könnten ähnliche Quantisierungstechniken in Zukunft verfügbar werden.

Verwandte Artikel

- Flux text to image - Anleitung zur Verwendung von FLUX.1-dev für Text-zu-Bild-Generierung

- FLUX.1-Kontext-dev: KI-Modell für Bildvergrößerung

- uv - Neuer Python-Paket-, Projekt- und Umgebungsmanager

- Python-Cheatsheet

Referenzen

- HuggingFace Diffusers GGUF-Dokumentation - Offizielle Dokumentation zur Verwendung von GGUF mit Diffusers

- Unsloth FLUX.1-dev-GGUF - Vorquantisierte GGUF-Modelle für FLUX.1-dev

- Black Forest Labs FLUX.1-dev - Originales FLUX.1-dev-Modell-Repository

- GGUF-Format-Spezifikation - Technische Details zum GGUF-Format