Docker Model Runner vs. Ollama (2026): Welches ist besser für lokale LLMs?

Vergleichen Sie Docker Model Runner und Ollama für lokale LLM

Große Sprachmodelle (LLMs) lokal ausführen wird zunehmend beliebt, um den Schutz der Privatsphäre, den Kostenkontroll und die Offline-Fähigkeiten zu gewährleisten. Der Markt hat sich im April 2025 deutlich verändert, als Docker Docker Model Runner (DMR) eingeführt hat, seine offizielle Lösung zur Bereitstellung von KI-Modellen.

Nun konkurrieren drei Ansätze um die Aufmerksamkeit der Entwickler: Docks native Model Runner, Drittanbieter-Containerlösungen (vLLM, TGI) und die eigenständige Plattform Ollama.

Für einen umfassenderen Überblick, der auch Cloud-Anbieter und Infrastruktur-Kompromisse einbezieht, siehe LLM-Hosting: Lokal, Selbstgehostet & Cloud-Infrastruktur im Vergleich.

TL;DR – Docker Model Runner vs Ollama

Dieser Vergleich konzentriert sich darauf, große Sprachmodelle (LLMs) lokal mithilfe von Docker oder eigenständigen Runtime-Systemen auszuführen, wobei Leistung, GPU-Unterstützung, API-Kompatibilität und Szenarien für die Produktionsbereitstellung abgedeckt werden.

- Beste Wahl für Docker-native Workflows: Docker Model Runner

- Beste Wahl für Einfachheit und schnelles Prototyping: Ollama

- Beste Wahl für Kubernetes & Orchestrierung: Docker-basierte Einrichtungen

- Beste Wahl für Einzelmaschinen-Entwicklung: Ollama

Wenn Sie Docker bereits intensiv nutzen, macht DMR Sinn.

Wenn Sie die schnellste Möglichkeit suchen, LLMs lokal auszuführen, ist Ollama einfacher.

Wenn Sie mehr als nur Docker Model Runner und Ollama vergleichen, sehen Sie unsere vollständige Analyse von Ollama vs vLLM vs LM Studio und anderen lokalen LLM-Tools. Dieser Leitfaden vergleicht die Reife der API, Hardware-Unterstützung, Tool-Aufruf und Produktionsbereitschaft bei über 12 lokalen LLM-Runtime-Systemen.

Docker Model Runner vs Ollama: Direkter Vergleich

Mit Docks offizieller Einführung in den Bereich der LLM-Runner wird der Vergleich interessanter. Hier ist, wie DMR und Ollama sich gegenseitig gegenüberstellen:

| Feature | Docker Model Runner | Ollama |

|---|---|---|

| Installation | Docker Desktop AI-Tab oder docker-model-plugin |

Ein Befehl: curl | sh |

| Befehlsstil | docker model pull/run/package |

ollama pull/run/list |

| Modellformat | GGUF (OCI-Artefakte) | GGUF (eigenständig) |

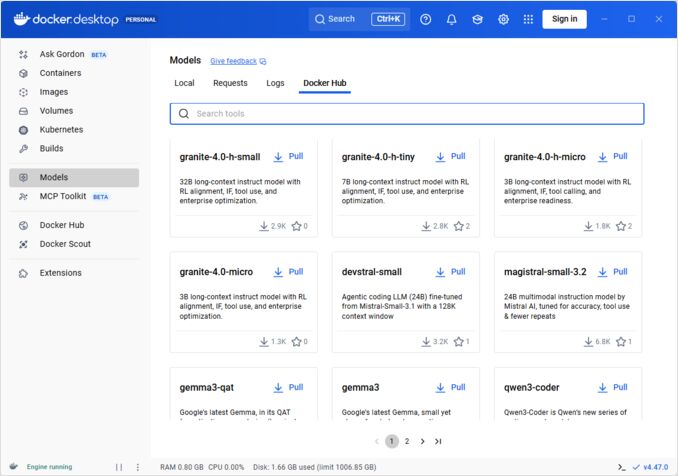

| Modellverteilung | Docker Hub, OCI-Registries | Ollama-Registrierung |

| GPU-Setup | Automatisch (einfacher als traditioneller Docker) | Automatisch |

| API | OpenAI-kompatibel | OpenAI-kompatibel |

| Docker-Integration | Native (ist Docker) | Läuft in Docker, wenn benötigt |

| Compose-Unterstützung | Native | Über Docker-Image |

| Lernkurve | Gering (für Docker-Nutzer) | Geringste (für alle) |

| Ecosystem-Partner | Google, Hugging Face, VMware | LangChain, CrewAI, Open WebUI |

| Beste für | Docker-native Workflows | Einfache Eigenständigkeit |

Schlüsselinsicht: DMR bringt Docker-Workflows in die LLM-Bereitstellung, während Ollama weiterhin unabhängig von Frameworks ist mit einfacherer eigenständiger Operation. Ihre bestehende Infrastruktur ist wichtiger als technische Unterschiede.

Ist Docker Model Runner besser als Ollama?

Es hängt von Ihrem Workflow ab.

- Wählen Sie Docker Model Runner (DMR), wenn Ihre Team bereits stark auf Docker, OCI-Artefakte und Container-Orchestrierung angewiesen ist.

- Wählen Sie Ollama, wenn Sie die einfachste Möglichkeit suchen, LLMs lokal mit minimaler Konfiguration und schnellem Prototyping auszuführen.

Für die meisten Einzelmaschinen-Einrichtungen ist Ollama einfacher zu verwenden.

Für Docker-native CI/CD-Pipelines und Unternehmenscontainer-Workflows integriert DMR sich natürlicher.

Wie man ein LLM in Docker ausführt: DMR vs Ollama

Wenn Ihr Ziel einfach darin besteht, ein LLM innerhalb von Docker auszuführen, können sowohl Docker Model Runner als auch Ollama in Docker-Containern dies erreichen.

Docker Model Runner verwendet native docker model pull und docker model run Befehle, um Modelle als OCI-Artefakte zu verpacken.

Ollama kann auch innerhalb von Docker mit dem offiziellen ollama/ollama Container-Image laufen, wodurch eine OpenAI-kompatible API auf Port 11434 bereitgestellt wird.

Der entscheidende Unterschied liegt in der Workflow-Integration:

- DMR passt sich natürlicher in Docker-native CI/CD-Pipelines an.

- Ollama in Docker bietet eine einfachere Modellverwaltung mit der Flexibilität der Docker-Orchestrierung.

Verständnis von Docker-Modell-Runnern

Docker-basierte Modell-Runner verwenden Containerisierung, um LLM-Verarbeitungsengines zusammen mit ihren Abhängigkeiten zu verpacken. Der Markt umfasst sowohl Docks offizielle Lösung als auch Drittanbieter-Frameworks.

Docker Model Runner (DMR) – Offizielle Lösung

Im April 2025 stellte Docker Docker Model Runner (DMR) als offizielle Produkt vor, das darauf abzielt, die Ausführung von KI-Modellen lokal mithilfe der Docker-Infrastruktur zu vereinfachen. Dies spiegelt Docks Engagement wider, die Bereitstellung von KI-Modellen so nahtlos wie die Container-Bereitstellung zu machen.

Wichtige Merkmale von DMR:

- Native Docker-Integration: Verwendet vertraute Docker-Befehle (

docker model pull,docker model run,docker model package) - Verpackung als OCI-Artefakte: Modelle werden als OCI-Artefakte verpackt, was die Verteilung über Docker Hub und andere Registries ermöglicht

- OpenAI-kompatible API: Direkter Ersatz für OpenAI-Endpunkte, was die Integration vereinfacht

- GPU-Beschleunigung: Native GPU-Unterstützung ohne komplexe nvidia-docker-Konfiguration

- GGUF-Formatunterstützung: Funktioniert mit beliebten quantisierten Modellformaten

- Docker Compose-Integration: Einfache Konfiguration und Bereitstellung von Modellen mithilfe standardmäßiger Docker-Tools

- Testcontainers-Unterstützung: Nahtlose Integration mit Testframeworks

Installation:

- Docker Desktop: Aktivieren Sie über den AI-Tab in den Einstellungen

- Docker Engine: Installieren Sie das

docker-model-plugin-Paket

Beispielverwendung:

# Ein Modell aus Docker Hub pullen

docker model pull ai/smollm2

# Inferenz durchführen

docker model run ai/smollm2 "Erkläre Docker Model Runner"

# Eigenes Modell verpacken

docker model package --gguf /path/to/model.gguf --push myorg/mymodel:latest

Für eine vollständige Referenz der docker model Befehle, Verpackungsoptionen, Konfigurationsflags und praktische Beispiele, siehe unsere detaillierte Docker Model Runner Cheatsheet: Befehle & Beispiele. Es behandelt das Pullen, Verpacken, Konfigurieren und beste Praktiken für die lokale Bereitstellung von LLMs mit Docker.

DMR kooperiert mit Google, Hugging Face und VMware Tanzu, um das AI-Modellökosystem, das über Docker Hub verfügbar ist, zu erweitern. Wenn Sie neu bei Docker sind oder eine Auffrischung zu Docker-Befehlen benötigen, bietet unser Docker Cheatsheet einen umfassenden Leitfaden zu essentiellen Docker-Operationen.

Drittanbieter-Docker-Lösungen

Jenseits von DMR umfasst das Ökosystem etablierte Frameworks:

- vLLM-Container: Hochdurchsatz-Verarbeitungsserver optimiert für Batch-Verarbeitung

- Text Generation Inference (TGI): Produktionstaugliche Lösung von Hugging Face

- llama.cpp-Container: Leichtgewichtige C++-Implementierung mit Quantisierung

- Eigene Container: Verpacken von PyTorch, Transformers oder proprietären Frameworks

Vorteile der Docker-Approach

Flexibilität und Framework-unabhängigkeit: Docker-Container können jedes LLM-Framework ausführen, von PyTorch bis ONNX Runtime, was Entwicklern volle Kontrolle über die Inferenz-Stack ermöglicht.

Ressourcenisolation: Jeder Container läuft in isolierten Umgebungen mit definierten Ressourcenbeschränkungen (CPU, Speicher, GPU), was Ressourcenkonflikte in mehreren Modellbereitstellungen verhindert.

Orchestrierungsunterstützung: Docker integriert sich nahtlos mit Kubernetes, Docker Swarm und Cloud-Plattformen für Skalierung, Lastverteilung und Hochverfügbarkeit.

Versionierung: Verschiedene Modellversionen oder Frameworks können auf demselben System koexistieren, ohne Abhängigkeitskonflikte.

Nachteile der Docker-Approach

Komplexität: Erfordert Kenntnisse über Containerisierung, Volume-Mounts, Netzwerkkonfiguration und GPU-Passthrough (nvidia-docker).

Überhead: Obwohl minimal, fügt Docker eine dünne Abstraktionsschicht hinzu, die leicht den Startzeit und Ressourcenverbrauch beeinflusst.

Konfigurationsaufwand: Jede Bereitstellung erfordert sorgfältige Konfiguration von Dockerfiles, Umgebungsvariablen und Laufzeitparametern.

Verständnis von Ollama

Ollama ist eine für die lokale Ausführung von LLMs entwickelte Anwendung, mit der Einfachheit als Kernprinzip. Es bietet:

- Native Binärdateien für Linux, macOS und Windows

- Ein eingebautes Modell-Register mit einem-Befehl-Installation

- Automatische Erkennung und Optimierung von GPU

- RESTful API kompatibel mit dem Format von OpenAI

- Modellkontext und Zustandsverwaltung

Vorteile von Ollama

Einfachheit: Die Installation ist einfach (curl | sh unter Linux), und das Ausführen von Modellen erfordert nur ollama run llama2. Für eine vollständige Referenz der Ollama CLI-Befehle wie ollama serve, ollama run, ollama ps und Modellverwaltungsworkflows siehe unsere Ollama CLI Cheatsheet.

Optimierte Leistung: Auf llama.cpp basierend ist Ollama stark optimiert für die Inferenzgeschwindigkeit mit Unterstützung für Quantisierung (Q4, Q5, Q8).

Modellverwaltung: Ein eingebautes Modell-Register mit Befehlen wie ollama pull, ollama list und ollama rm vereinfacht die Lebenszyklusverwaltung von Modellen.

Entwicklererfahrung: Saubere API, umfangreiche Dokumentation und wachsendes Ökosystem von Integrationen (LangChain, CrewAI usw.). Die Vielseitigkeit von Ollama erstreckt sich auch auf spezialisierte Anwendungsfälle wie Wiederbewertung von Textdokumenten mit Embedding-Modellen.

Ressourceneffizienz: Automatische Speicherverwaltung und Modellentladung bei Inaktivität sparen Systemressourcen.

Nachteile von Ollama

Framework-Lock-in: Unterstützt hauptsächlich llama.cpp-kompatible Modelle, was die Flexibilität für Frameworks wie vLLM oder eigene Inferenz-Engines begrenzt.

Eingeschränkte Anpassung: Fortgeschrittene Konfigurationen (eigene Quantisierung, spezifische CUDA-Streams) sind weniger zugänglich als in Docker-Umgebungen.

Orchestrierungsprobleme: Obwohl Ollama in Containern laufen kann, fehlt native Unterstützung für fortgeschrittene Orchestrierungsfunktionen wie horizontale Skalierung.

Leistungsvergleich

Inferenzgeschwindigkeit

Docker Model Runner: Leistung vergleichbar mit Ollama, da beide GGUF-quantisierte Modelle unterstützen. Für Llama 2 7B (Q4) erwarten Sie 20-30 Token/Sekunde auf der CPU und 50-80 Token/Sekunde auf mittleren GPUs. Minimaler Container-Überhead.

Ollama: Nutzt den hochoptimierten llama.cpp-Backend mit effizienter Quantisierung. Für Llama 2 7B (Q4) erwarten Sie 20-30 Token/Sekunde auf der CPU und 50-80 Token/Sekunde auf mittleren GPUs. Kein Containerisierungs-Überhead. Für Details dazu, wie Ollama parallele Anfragen verwaltet, siehe unsere Analyse zu wie Ollama parallele Anfragen verwaltet.

Docker (vLLM): Optimiert für Batch-Verarbeitung mit kontinuierlicher Batchverarbeitung. Einzelne Anfragen können etwas langsamer sein, aber der Durchsatz ist unter hohem parallelen Last (100+ Token/Sekunde pro Modell mit Batchverarbeitung) hervorragend.

Docker (TGI): Ähnlich wie vLLM mit hervorragender Batchverarbeitung. Fügt Funktionen wie Streaming und Token-Verarbeitung hinzu.

Speicherbedarf

Docker Model Runner: Ähnlich wie Ollama mit automatischer Modell-Ladung. GGUF Q4-Modelle verwenden typischerweise 4-6 GB RAM. Container-Überhead ist minimal (Zehntel von MB).

Die Konfiguration der Kontextgröße kann den Speicherbedarf und das Verhalten des Modells erheblich beeinflussen. Standardmäßig sind einige Docker Model Runner CUDA-Images mit einer festen Kontextgröße von 4096 Token versehen, auch wenn höhere Werte in docker-compose angegeben werden. Für detaillierte Schritte zur Überschreibung dieses Verhaltens und zur Verpackung von Modellen mit benutzerdefinierten Kontextgrößen, siehe unsere Anleitung zur Kontextgröße in Docker Model Runner konfigurieren.

Ollama: Automatische Speicherverwaltung lädt Modelle bei Bedarf und entlädt sie bei Inaktivität. Ein 7B Q4-Modell verwendet typischerweise 4-6 GB RAM. Am effizientesten für Einzelmodell-Szenarien.

Traditionelle Docker-Lösungen: Der Speicherbedarf hängt vom Framework ab. vLLM weist GPU-Speicher optimal zu, während PyTorch-basierte Container mehr RAM für Modellgewichte und KV-Cache verwenden können (8-14 GB für 7B-Modelle).

Startzeit

Docker Model Runner: Container-Start fügt ca. 1 Sekunde hinzu, plus Modell-Ladung (2-5 Sekunden). Gesamt: 3-6 Sekunden für mittelgroße Modelle.

Ollama: Nahezu sofortiger Start mit Modell-Ladung, die 2-5 Sekunden für mittelgroße Modelle benötigt. Schnellste kalte Start-Erfahrung.

Traditionelle Docker: Container-Start fügt 1-3 Sekunden hinzu, plus Modell-Ladung. Vorheizen von Containern mildert dies in Produktionsbereitstellungen.

Empfehlungen für Use Cases

Wählen Sie Docker Model Runner, wenn

- Docker-first Workflow: Ihr Team nutzt Docker bereits intensiv

- Einheitliche Tooling: Sie möchten ein Tool (Docker) für Container und Modelle

- OCI-Artifact-Verteilung: Sie benötigen Enterprise-Registrierungsintegration

- Testcontainers-Integration: Sie testen AI-Funktionen in CI/CD

- Docker Hub-Präferenz: Sie möchten Modelle über vertraute Kanäle verteilen

Wählen Sie Ollama, wenn

- Schnelles Prototyping: Schnelles Experimentieren mit verschiedenen Modellen

- Framework-unabhängig: Nicht an das Docker-Ökosystem gebunden

- Absolute Einfachheit: Minimale Konfiguration und Wartungsaufwand

- Einzelserver-Bereitstellungen: Auf Laptops, Workstations oder Einzel-VMs laufen

- Großes Modell-Register: Zugang zu umfangreichen vorkonfigurierten Modellregistern

Wählen Sie Drittanbieter-Docker-Lösungen, wenn

- Produktionsbereitstellungen: Für fortgeschrittene Orchestrierung und Monitoring

- Multi-Modell-Bereitstellung: Verschiedene Frameworks (vLLM, TGI) gleichzeitig laufen

- Kubernetes-Orchestrierung: Skalierung über Cluster mit Lastverteilung

- Eigene Frameworks: Nutzung von Ray Serve oder proprietären Inferenz-Engines

- Strenge Ressourcenkontrolle: Verpflichtung zu granularen CPU/GPU-Grenzen pro Modell

Hybridansätze: Das Beste aus beiden Welten

Sie sind nicht auf einen Ansatz beschränkt. Überlegen Sie sich diese hybriden Strategien:

Option 1: Docker Model Runner + Traditionelle Container

Verwenden Sie DMR für Standardmodelle und Drittanbieter-Container für spezialisierte Frameworks:

# Ein Standardmodell mit DMR pullen

docker model pull ai/llama2

# vLLM für Hochdurchsatz-Szenarien ausführen

docker run --gpus all vllm/vllm-openai

Option 2: Ollama in Docker

Führen Sie Ollama in Docker-Containern aus, um Orchestrierungsfähigkeiten zu erhalten:

docker run -d \

--name ollama \

--gpus all \

-v ollama:/root/.ollama \

-p 11434:11434 \

ollama/ollama

Dies bietet:

- Ollamas intuitive Modellverwaltung

- Docks Orchestrierungsfähigkeiten und Isolationsfähigkeit

- Kubernetes-Bereitstellung mit standardmäßigen Manifesten

Option 3: Mischen und Verwenden je nach Use Case

- Entwicklung: Ollama für schnelles Iterieren

- Staging: Docker Model Runner für Integrationstests

- Produktion: vLLM/TGI in Kubernetes für Skalierung

API-Kompatibilität

Alle modernen Lösungen konvergieren zu OpenAI-kompatiblen APIs, was die Integration vereinfacht:

Docker Model Runner API: OpenAI-kompatible Endpunkte werden automatisch bereitgestellt, wenn Modelle ausgeführt werden. Keine zusätzliche Konfiguration erforderlich.

# Modelle laufen mit API automatisch aus

docker model run ai/llama2

# Verwenden Sie OpenAI-kompatiblen Endpunkt

curl http://localhost:8080/v1/chat/completions -d '{

"model": "llama2",

"messages": [{"role": "user", "content": "Warum ist der Himmel blau?"}]

}'

Ollama API: OpenAI-kompatible Endpunkte machen es zu einem direkten Ersatz für Anwendungen, die die OpenAI SDK verwenden. Streaming wird vollständig unterstützt.

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt": "Warum ist der Himmel blau?"

}'

Drittanbieter-Docker-APIS: vLLM und TGI bieten OpenAI-kompatible Endpunkte, während eigene Container proprietäre APIs implementieren können.

Die Konvergenz auf OpenAI-Kompatibilität bedeutet, dass Sie zwischen Lösungen mit minimalen Codeänderungen wechseln können.

Ressourcenverwaltung

GPU-Beschleunigung

Docker Model Runner: Native GPU-Unterstützung ohne komplexe nvidia-docker-Konfiguration. Erkennt und nutzt automatisch verfügbare GPUs, was die Docker-GPU-Erfahrung erheblich vereinfacht im Vergleich zu traditionellen Containern.

Wenn Sie NVIDIA-GPUs verwenden und die Konfiguration von CUDA-Beschleunigung richtig durchführen möchten, sehen Sie unseren detaillierten Leitfaden zu Hinzufügen von NVIDIA-GPU-Unterstützung zu Docker Model Runner. Er behandelt die Konfiguration des Docker-Daemons, die Einrichtung des NVIDIA Container Toolkits und wie Sie überprüfen können, ob Ihr LLM tatsächlich GPU-Speicher verwendet und nicht auf die CPU-Infereenz zurückgreift.

# GPU-Beschleunigung funktioniert automatisch

docker model run ai/llama2

Ollama: Automatische GPU-Erkennung auf CUDA-fähigen NVIDIA-GPUs. Keine Konfiguration erforderlich, außer der Treiberinstallation.

Traditionelle Docker-Container: Erfordert nvidia-docker Runtime und explizite GPU-Zuordnung:

docker run --gpus all my-llm-container

CPU-Backup

Beide wechseln sanft auf CPU-Infereenz, wenn GPUs nicht verfügbar sind, wobei die Leistung erheblich abnimmt (5-10-mal langsamer für große Modelle). Für Einblicke in die CPU-Leistung auf modernen Prozessoren, lesen Sie unseren Test zu wie Ollama Intel CPU-Performance und Efficient Cores verwendet.

Mehr-GPU-Unterstützung

Ollama: Unterstützt Tensorparallelismus über mehrere GPUs für große Modelle.

Docker: Hängt vom Framework ab. vLLM und TGI unterstützen mehrere GPU-Infereenz mit der richtigen Konfiguration.

Community und Ökosystem

Docker Model Runner: Eingeführt im April 2025 mit starkem Unternehmenshintergrund. Partnerschaften mit Google, Hugging Face und VMware Tanzu AI Solutions gewährleisten eine breite Modellverfügbarkeit. Integration mit Docks riesiger Entwicklergemeinschaft (Millionen von Nutzern) bietet sofortigen Ökosystemzugang. Noch immer werden community-spezifische Ressourcen als neues Produkt gebaut.

Ollama: Schnell wachsende Community mit 50K+ GitHub-Sternen. Starke Integration (LangChain, LiteLLM, Open WebUI, CrewAI) und aktive Discord-Community. Umfangreiche Drittanbieter-Tools und Tutorials verfügbar. Reifere Dokumentation und Community-Ressourcen. Für einen umfassenden Überblick über verfügbare Schnittstellen, siehe unseren Leitfaden zu Open-Source-Chat-UIs für lokale Ollama-Instanzen. Wie bei jedem schnell wachsenden Open-Source-Projekt ist es wichtig, den Projektverlauf zu überwachen – lesen Sie unsere Analyse zu frühen Zeichen von Ollama Enshittification, um potenzielle Bedenken zu verstehen.

Drittanbieter-Docker-Lösungen: vLLM und TGI haben reife Ökosysteme mit Unternehmenssupport. Umfangreiche Produktionsfallstudien, Optimierungshandbücher und Bereitstellungsmodelle von Hugging Face und Community-Beitragenden.

Kostenüberlegungen

Docker Model Runner: Kostenlos mit Docker Desktop (privat/educativ) oder Docker Engine. Docker Desktop erfordert eine Abonnement für größere Organisationen (250+ Mitarbeiter oder $10M+ Umsatz). Modelle, die über Docker Hub verteilt werden, folgen Docks Registry-Preisen (kostenlose öffentliche Repons, kostenpflichtige private Repons).

Ollama: Vollständig kostenlos und Open-Source mit keiner Lizenzkosten, unabhängig von der Organisationgröße. Ressourkosten hängen nur von der Hardware ab.

Drittanbieter-Docker-Lösungen: Kostenlos für Open-Source-Frameworks (vLLM, TGI). Potenzielle Kosten für Container-Orchestrierungsplattformen (ECS, GKE) und private Registrierungsspeicher.

Sicherheitsüberlegungen

Docker Model Runner: Nutzt Docks Sicherheitsmodell mit Container-Isolation. Modelle, die als OCI-Artefakte verpackt sind, können gescannt und signiert werden. Verteilung über Docker Hub ermöglicht Zugriffssteuerung und Schwachstellenanalyse für Enterprise-Nutzer.

Ollama: Läuft als lokaler Dienst mit API, die standardmäßig auf localhost bereitgestellt wird. Netzwerkexposition erfordert explizite Konfiguration. Modell-Register ist vertrauenswürdig (Ollama-kuratiert), was Lieferkettenrisiken reduziert.

Traditionelle Docker-Lösungen: Netzwerkisolation ist standardmäßig integriert. Container-Sicherheitsscanning (Snyk, Trivy) und Image-Signierung sind Standardpraktiken in Produktionsumgebungen.

Alle Lösungen erfordern Aufmerksamkeit für:

- Modellherkunft: Unvertrauenswürdige Modelle können Schadcode oder Hintertüren enthalten

- API-Authentifizierung: Implementieren Sie Authentifizierung/Autorisierung in Produktionsbereitstellungen

- Rate-Limiting: Verhindern Sie Missbrauch und Ressourcenerschöpfung

- Netzwerkexposition: Stellen Sie sicher, dass APIs nicht versehentlich ins Internet ausgesetzt werden

- Datenschutz: Modelle verarbeiten sensible Daten; gewährleisten Sie die Einhaltung von Datenschutzvorschriften

Migrationspfade

Von Ollama zu Docker Model Runner

Die GGUF-Unterstützung von Docker Model Runner macht die Migration einfach:

- Aktivieren Sie Docker Model Runner in Docker Desktop oder installieren Sie

docker-model-plugin - Konvertieren Sie Modellverweise:

ollama run llama2→docker model pull ai/llama2unddocker model run ai/llama2 - Aktualisieren Sie die API-Endpunkte von

localhost:11434zu DMR-Endpunkt (typischerweiselocalhost:8080) - Beide verwenden OpenAI-kompatible APIs, also erfordert Anwendungscode nur minimale Änderungen

Von Docker Model Runner zu Ollama

Zur Vereinfachung der eigenständigen Operation:

- Installieren Sie Ollama:

curl -fsSL https://ollama.ai/install.sh | sh. Für eine vollständige Liste der Ollama CLI-Befehle und Konfigurationsoptionen, siehe das Ollama CLI Cheatsheet. - Pullen Sie äquivalente Modelle:

ollama pull llama2 - Aktualisieren Sie die API-Endpunkte auf Ollamas

localhost:11434 - Testen Sie mit

ollama run llama2, um die Funktionalität zu überprüfen

Von traditionellen Docker-Containern zu DMR

Vereinfachen Sie Ihre Docker-LLM-Einrichtung:

- Aktivieren Sie Docker Model Runner

- Ersetzen Sie benutzerdefinierte Dockerfiles mit

docker model pullBefehlen - Entfernen Sie nvidia-docker-Konfiguration (DMR verarbeitet GPU automatisch)

- Verwenden Sie

docker model runanstelle komplexerdocker runBefehle

Von jeder Lösung zu Ollama in Docker

Best-of-both-worlds-Ansatz:

docker pull ollama/ollama- Führen Sie aus:

docker run -d --gpus all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama - Verwenden Sie Ollama-Befehle wie gewohnt:

docker exec -it ollama ollama pull llama2 - Erhalten Sie Docker-Orchestrierung mit Ollama-Einfachheit

Monitoring und Beobachtung

Ollama: Grundlegende Metriken über API (/api/tags, /api/ps). Drittanbieter-Tools wie Open WebUI liefern Dashboards.

Docker: Vollständige Integration mit Prometheus, Grafana, ELK-Stack und Cloud-Monitoring-Dienste. Container-Metriken (CPU, RAM, GPU) sind leicht verfügbar.

Schlussfolgerung

Der Markt für lokale LLM-Bereitstellung hat sich erheblich verändert, seit Docks Einführung von Docker Model Runner (DMR) im Jahr 2025. Die Wahl hängt nun von Ihren spezifischen Anforderungen ab:

- Für Entwickler, die Docker-Integration suchen: DMR bietet native Docker-Workflow-Integration mit

docker modelBefehlen - Für maximale Einfachheit: Ollama bleibt die einfachste Lösung mit ihrer ein-Befehl-Modellverwaltung

- Für Produktion und Unternehmen: Sowohl DMR als auch Drittanbieter-Lösungen (vLLM, TGI) in Docker bieten Orchestrierung, Monitoring und Skalierbarkeit

- Für das Beste aus beiden: Führen Sie Ollama in Docker-Containern aus, um Einfachheit mit Produktionsinfrastruktur zu kombinieren

Die Einführung von DMR schrumpft den Abstand zwischen Docker und Ollama in Bezug auf Benutzerfreundlichkeit. Ollama gewinnt immer noch bei Einfachheit für schnelles Prototyping, während DMR bei Teams, die bereits in Docker-Workflows investiert haben, hervorragt. Beide Ansätze werden aktiv weiterentwickelt, sind produktionsreif und das Ökosystem ist reif genug, um zwischen ihnen zu wechseln, relativ schmerzlos.

Zusammenfassung: Wenn Sie Docker bereits intensiv nutzen, ist DMR die natürliche Wahl. Wenn Sie die absolute einfachste Erfahrung unabhängig von der Infrastruktur wünschen, wählen Sie Ollama. Um diese lokalen Optionen mit Cloud-APIs und anderen selbstgehosteten Einrichtungen zu vergleichen, prüfen Sie unseren LLM-Hosting: Lokal, Selbstgehostet & Cloud-Infrastruktur im Vergleich Leitfaden.

Nützliche Links

Docker Model Runner

- Docker Model Runner offizielle Seite

- Docker Model Runner Dokumentation

- Docker Model Runner Einstiegsguide

- Docker Model Runner Ankündigungsblog