NVIDIA DGX Spark vs. Mac Studio vs. RTX-4080: Ollama-Leistungsvergleich

GPT-OSS 120b Benchmarks auf drei KI-Plattformen

Ich habe einige interessante Leistungsuntersuchungen zu GPT-OSS 120b ausgegraben, das auf Ollama auf drei verschiedenen Plattformen läuft: NVIDIA DGX Spark, Mac Studio und RTX 4080. Das GPT-OSS 120b-Modell aus der Ollama-Bibliothek wiegt 65 GB, was bedeutet, dass es nicht in die 16 GB VRAM einer RTX 4080 (oder der neueren RTX 5080) passt.

Ja, das Modell kann mit teilweiser Auslagerung auf die CPU laufen, und wenn Sie 64 GB System-RAM haben (wie ich), können Sie es ausprobieren. Diese Konfiguration würde jedoch nicht als irgendwie produktionsreif betrachtet werden. Für wirklich anspruchsvolle Workloads benötigen Sie möglicherweise etwas wie den NVIDIA DGX Spark, der speziell für hochkapazitive KI-Workloads entwickelt wurde.

Ich erwartete, dass dieses LLM deutlich von der Ausführung auf einem “High-RAM-AI-Gerät” wie dem DGX Spark profitieren würde. Während die Ergebnisse gut sind, sind sie nicht so dramatisch besser, wie man angesichts des Preisunterschieds zwischen DGX Spark und günstigeren Optionen erwarten könnte.

TL;DR

Ollama mit GPT-OSS 120b Leistungsvergleich über drei Plattformen:

| Gerät | Prompt-Auswertungsleistung (Tokens/Sekunde) | Generierungsleistung (Tokens/Sekunde) | Hinweise |

|---|---|---|---|

| NVIDIA DGX Spark | 1159 | 41 | Beste Gesamtleistung, vollständig GPU-beschleunigt |

| Mac Studio | Unbekannt | 34 → 6 | Ein Test zeigte eine Verschlechterung mit zunehmender Kontextgröße |

| RTX 4080 | 969 | 12.45 | 78% CPU / 22% GPU-Aufteilung aufgrund von VRAM-Grenzen |

Modellspezifikationen:

- Modell: GPT-OSS 120b

- Parameter: 117B (Mixture-of-Experts-Architektur)

- Aktive Parameter pro Durchlauf: 5.1B

- Quantisierung: MXFP4

- Modellgröße: 65GB

Dies ist ähnlich in der Architektur zu anderen MoE-Modellen wie Qwen3:30b, aber in einem viel größeren Maßstab.

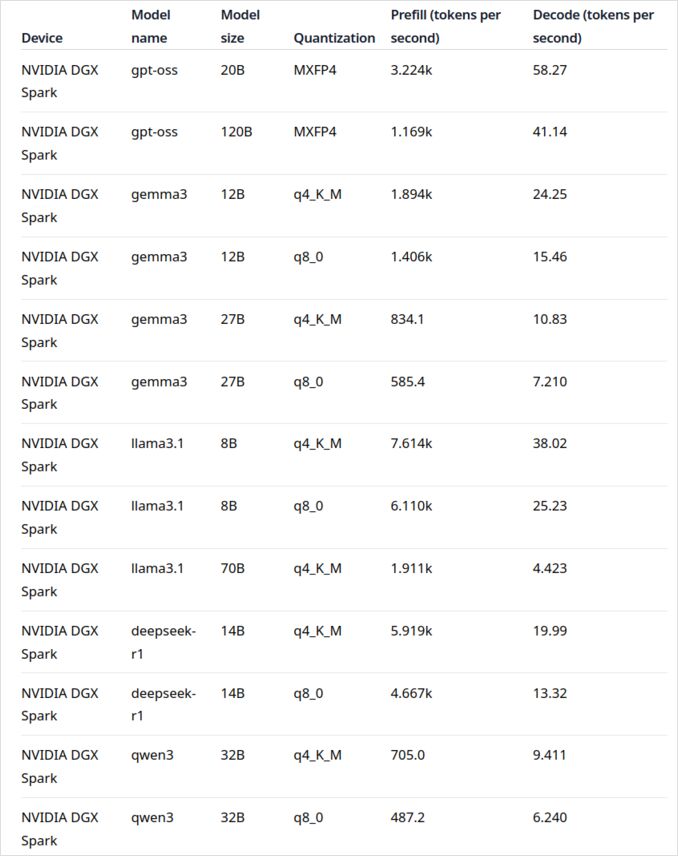

GPT-OSS 120b auf NVIDIA DGX Spark

Die LLM-Leistungsdaten für NVIDIA DGX Spark stammen aus dem offiziellen Ollama-Blogbeitrag (verlinkt unten im Abschnitt Nützliche Links). Der DGX Spark stellt NVIDIAs Einstieg in den Markt für persönliche KI-Supercomputer dar und verfügt über 128 GB gemeinsamen Speicher, der speziell für das Ausführen großer Sprachmodelle entwickelt wurde.

Die Leistung von GPT-OSS 120b sieht beeindruckend aus mit 41 Tokens/Sekunde für die Generierung. Dies macht es zum klaren Gewinner für dieses bestimmte Modell und zeigt, dass die zusätzliche Speicherkapazität einen echten Unterschied für extrem große Modelle machen kann.

Allerdings sieht die Leistung von mittelgroßen bis großen LLMs nicht so überzeugend aus. Dies ist besonders auffällig bei Qwen3:32b und Llama3.1:70b - genau die Modelle, bei denen man erwarten würde, dass die hohe RAM-Kapazität glänzt. Die Leistung auf DGX Spark für diese Modelle ist nicht inspirierend im Vergleich zum Preisaufschlag. Wenn Sie hauptsächlich mit Modellen im Bereich von 30-70B Parametern arbeiten, sollten Sie möglicherweise Alternativen wie einen gut konfigurierten Arbeitsplatzrechner) oder sogar eine Quadro RTX 5880 Ada mit ihren 48GB VRAM in Betracht ziehen.

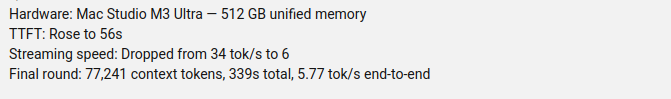

GPT-OSS 120b auf Mac Studio Max

Der Slinging Bits YouTube-Kanal führte umfassende Tests mit GPT-OSS 120b auf Ollama mit unterschiedlichen Kontextgrößen durch. Die Ergebnisse zeigen ein erhebliches Leistungsproblem: Die Generierungsgeschwindigkeit des Modells sank dramatisch von 34 Tokens/s auf nur noch 6 Tokens/s, wenn die Kontextgröße zunahm.

Diese Leistungsverschlechterung ist wahrscheinlich auf Speicherdruck und die Art und Weise zurückzuführen, wie macOS die Architektur des gemeinsamen Speichers verwaltet. Obwohl das Mac Studio Max beeindruckenden gemeinsamen Speicher (bis zu 192GB in der M2 Ultra-Konfiguration) hat, unterscheidet sich die Art und Weise, wie es sehr große Modelle unter zunehmender Kontextlast behandelt, deutlich von dediziertem GPU-VRAM.

Für Anwendungen, die eine konsistente Leistung über unterschiedliche Kontextlängen hinweg erfordern, macht das Mac Studio weniger ideal für GPT-OSS 120b, trotz seiner ansonsten hervorragenden Fähigkeiten für KI-Workloads. Sie könnten mit kleineren Modellen bessere Ergebnisse erzielen oder die Ollama-Parallelanfragen-Verarbeitung nutzen, um die Durchsatzleistung in Produktionsszenarien zu maximieren.

GPT-OSS 120b auf RTX 4080

Ich dachte zunächst, dass das Ausführen von Ollama mit GPT-OSS 120b auf meinem Consumer-PC nicht besonders aufregend sein würde, aber die Ergebnisse haben mich positiv überrascht. Hier ist, was passiert ist, als ich es mit dieser Abfrage getestet habe:

$ ollama run gpt-oss:120b --verbose Compare the weather in state capitals of Australia

Thinking...

We need to compare weather in state capitals of Australia. Provide a comparison, perhaps include

...

*All data accessed September 2024; any updates from the BOM after that date may slightly adjust the

numbers, but the broad patterns remain unchanged.*

total duration: 4m39.942105769s

load duration: 75.843974ms

prompt eval count: 75 token(s)

prompt eval duration: 77.341981ms

prompt eval rate: 969.72 tokens/s

eval count: 3483 token(s)

eval duration: 4m39.788119563s

eval rate: 12.45 tokens/s

Jetzt kommt der interessante Teil - Ollama mit diesem LLM lief hauptsächlich auf der CPU! Das Modell passt einfach nicht in die 16GB VRAM, also hat Ollama intelligent den größten Teil davon in den System-RAM ausgelagert. Sie können dieses Verhalten mit dem Befehl ollama ps sehen:

$ ollama ps

NAME ID SIZE PROCESSOR CONTEXT

gpt-oss:120b a951a23b46a1 65 GB 78%/22% CPU/GPU 4096

Trotz des Laufens mit einer 78% CPU / 22% GPU-Aufteilung liefert die RTX 4080 eine respektable Leistung für ein Modell dieser Größe. Die Prompt-Auswertung ist blitzschnell mit 969 Tokens/s, und selbst die Generierungsgeschwindigkeit von 12.45 Tokens/s ist für viele Anwendungen brauchbar.

Dies ist besonders beeindruckend, wenn man bedenkt, dass:

- Das Modell fast 4-mal größer ist als der verfügbare VRAM

- Der größte Teil der Berechnung auf der CPU stattfindet (die von meinem 64GB System-RAM profitiert)

- Das Verständnis wie Ollama CPU-Kerne nutzt kann diese Einrichtung weiter optimieren

Wer hätte gedacht, dass eine Consumer-GPU ein 117B-Parameter-Modell überhaupt verarbeiten kann, geschweige denn mit brauchbarer Leistung? Dies demonstriert die Macht der intelligenten Speicherverwaltung von Ollama und die Bedeutung von ausreichend System-RAM. Wenn Sie daran interessiert sind, Ollama in Ihre Anwendungen zu integrieren, werfen Sie einen Blick auf diese Anleitung zur Verwendung von Ollama mit Python.

Hinweis: Während dies für Experimente und Tests funktioniert, werden Sie feststellen, dass GPT-OSS einige Eigenheiten hat, insbesondere mit strukturierten Ausgabeformaten.

Primäre Quellen

- Ollama auf NVIDIA DGX Spark: Leistungsbenchmarks - Offizieller Ollama-Blogbeitrag mit umfassenden DGX Spark-Leistungsdaten

- GPT-OSS 120B auf Mac Studio - Slinging Bits YouTube - Detailliertes Video-Testing von GPT-OSS 120b mit unterschiedlichen Kontextgrößen

Weiterführende Literatur

Hardware-Vergleiche & Preise

- DGX Spark vs. Mac Studio: Ein praktischer, preisgeprüfter Blick auf NVIDIAs persönlichen KI-Supercomputer - Detaillierte Erklärung der DGX Spark-Konfigurationen, globale Preise und direkter Vergleich mit Mac Studio für lokale KI-Arbeit

- NVIDIA DGX Spark - Erwartungen - Frühe Berichterstattung über DGX Spark: Verfügbarkeit, Preise und technische Spezifikationen

- NVidia RTX 5080 und RTX 5090 Preise in Australien - Oktober 2025 - Aktuelle Marktpreise für Next-Gen-Consumer-GPUs

- Ist die Quadro RTX 5880 Ada 48GB gut? - Bewertung der 48GB-Workstation-GPU-Alternative für KI-Workloads

Ollama-Anleitungen & Leistung

- Ollama-Cheatsheet - Umfassender Befehlsreferenz und Tipps für Ollama

- Wie Ollama Parallelanfragen verarbeitet - Verständnis der parallelen Anfragenverarbeitung in der Produktion

- Wie Ollama Intel CPU Performance und Efficient Cores nutzt - Tiefgehende Analyse der CPU-Kernnutzungsmuster

- Integration von Ollama mit Python: REST-API- und Python-Client-Beispiele - Praktische Python-Integration mit REST-API und offiziellen Client

Modellvergleiche

- LLMs Vergleich: Qwen3:30b vs GPT-OSS:20b - Technischer Vergleich zweier beliebter MoE-Modelle

- Ollama GPT-OSS Structured Output Issues - Bekannte Einschränkungen bei der Verwendung von GPT-OSS für die Erzeugung strukturierter Daten