Chat-Oberflächen für lokale Ollama-Instanzen

Kurzer Überblick über die prominentesten UIs für Ollama im Jahr 2025

Lokal gehostetes Ollama ermöglicht den Betrieb großer Sprachmodelle auf Ihrem eigenen Gerät, aber die Nutzung über die Kommandozeile ist nicht besonders benutzerfreundlich. Hier sind mehrere Open-Source-Projekte, die ChatGPT-ähnliche Oberflächen bieten, die mit einem lokalen Ollama verbunden sind.

Diese Benutzeroberflächen unterstützen konversationsbasierten Chat, oft mit Funktionen wie Dokumentenhochladen für retrieval-augmented generation (RAG), und laufen als Web- oder Desktop-Anwendungen. Unten finden Sie einen Vergleich der wichtigsten Optionen, gefolgt von detaillierten Abschnitten zu jeder.

Vergleich von Ollama-kompatiblen Benutzeroberflächen

| UI-Tool | Plattform | Dokumentenunterstützung | Ollama-Integration | Stärken | Einschränkungen |

|---|---|---|---|---|---|

| Page Assist | Browser-Erweiterung (Chrome, Firefox) | Ja – Dateien hinzufügen zur Analyse | Verbindet mit lokalem Ollama über Erweiterungseinstellungen | In-Browser-Chat; einfache Modellverwaltung und Webseitenkontext-Integration. | Nur für Browser; erfordert Installation/Konfiguration einer Erweiterung. |

| Open WebUI | Web-App (selbstgehostet; Docker/PWA) | Ja – integriertes RAG (Dokumente hochladen oder zur Bibliothek hinzufügen) | Direkte Ollama-API-Unterstützung oder gebündelter Server (Grund-URL konfigurieren) | Funktionsreich (mehrere LLMs, Offline, Bildgenerierung); mobilfreundlich (PWA). | Einrichtung ist aufwendiger (Docker/K8s); breiter Umfang kann für einfache Nutzung überflüssig sein. |

| LobeChat | Web-App (selbstgehostet; PWA-Unterstützung) | Ja – „Wissensdatenbank“ mit Datei-Hochladen (PDF, Bilder, etc.) | Unterstützt Ollama als eines von mehreren KI-Backends (erfordert Aktivierung des Ollama-API-Zugangs) | Elegante ChatGPT-ähnliche Oberfläche; Sprachchat, Plugins und Multi-Modell-Unterstützung. | Komplexer Funktionsumfang; erfordert Umgebungsinstallation (z. B. Cross-Origin für Ollama). |

| LibreChat | Web-App (selbstgehostet; Multi-User) | Ja – „Chat mit Dateien“ mit RAG (über Einbettungen) | Kompatibel mit Ollama und vielen anderen Anbietern (wechselbar pro Chat) | Vertraute ChatGPT-ähnliche Oberfläche; reichhaltige Funktionen (Agenten, Code-Interpreter, etc.). | Installation/Konfiguration kann aufwendig sein; großes Projekt könnte für die Grundnutzung überflüssig sein. |

| AnythingLLM | Desktop-App (Windows, Mac, Linux) oder Web (Docker) | Ja – integriertes RAG: Dokumente per Drag-and-Drop (PDF, DOCX, etc.) mit Zitaten | Ollama wird als LLM-Anbieter unterstützt (in Konfiguration oder Docker-Umgebung festgelegt) | All-in-One-Oberfläche (privater ChatGPT mit Ihren Dokumenten); Agenten-Builder ohne Code, Multi-User-Unterstützung. | Höherer Ressourcenverbrauch (Einbettungsdatenbank, etc.); Desktop-App fehlen einige Multi-User-Funktionen. |

| Chat-with-Notes | Web-App (leichte Flask-Server) | Ja – Text-/PDF-Dateien hochladen und mit deren Inhalt chatten | Nutzt Ollama für alle KI-Antworten (erfordert lokal laufendes Ollama) | Sehr einfache Einrichtung und Oberfläche, die auf Dokumenten-Q&A fokussiert ist; Daten bleiben lokal. | Grundlegende Oberfläche und Funktionalität; Einzelnutzer, ein Dokument zur Zeit (keine erweiterten Funktionen). |

Jedes dieser Tools wird aktiv gepflegt und ist Open-Source. Im Folgenden gehen wir auf die Details jeder Option ein, einschließlich der Funktionsweise mit Ollama, bemerkenswerten Funktionen und Abwägungen.

Page Assist (Browser-Erweiterung)

Page Assist ist eine Open-Source-Browser-Erweiterung, die lokalen LLM-Chat in Ihren Browser bringt. Sie unterstützt Chromium-basierte Browser und Firefox und bietet eine ChatGPT-ähnliche Seitenleiste oder einen Tab, in dem Sie mit einem Modell chatten können. Page Assist kann mit lokal laufendem Ollama als KI-Anbieter verbunden werden oder mit anderen lokalen Backends über seine Einstellungen. Besonders hervorzuheben ist, dass Sie Dateien (z. B. PDFs oder Texte) hinzufügen können, damit die KI diese innerhalb des Chats analysiert und so grundlegende RAG-Workflows ermöglicht. Sie können sogar die Inhalte der aktuellen Webseite analysieren lassen oder Websuchen durchführen, um Informationen zu erhalten.

Die Einrichtung ist unkompliziert: Installieren Sie die Erweiterung aus dem Chrome Web Store oder den Firefox Add-ons, stellen Sie sicher, dass Ollama läuft, und wählen Sie Ollama als lokalen KI-Anbieter in den Page-Assist-Einstellungen aus. Die Oberfläche bietet Funktionen wie Chatverlauf, Modellauswahl und eine optionale freigebbare URL für Ihre Chatergebnisse. Eine Web-Oberfläche ist auch über eine Tastenkombination verfügbar, falls Sie ein Vollbild-Chat-Erlebnis bevorzugen.

Stärken: Page Assist ist leichtgewichtig und praktisch – da es im Browser läuft, muss kein separater Server betrieben werden. Es eignet sich hervorragend für Browsing-Kontexte (Sie können es auf jeder Webseite öffnen) und unterstützt Internet-Suchintegration und Dateianhänge, um die Konversation zu bereichern. Es bietet auch nützliche Funktionen wie Tastenkombinationen für neue Chats und das Ein- und Ausblenden der Seitenleiste.

Einschränkungen: Als Erweiterung ist es auf die Browser-Umgebung beschränkt. Die Oberfläche ist einfacher und etwas weniger funktionsreich als vollständige Standalone-Chat-Apps. Zum Beispiel sind Multi-User-Verwaltung oder erweiterte Agenten-Plugins nicht vorgesehen. Auch die anfängliche Einrichtung kann das Erstellen/Laden der Erweiterung erfordern, falls keine vorgefertigte Version für Ihren Browser verfügbar ist (das Projekt bietet Anleitungen zum Erstellen mit Bun oder npm). Insgesamt eignet sich Page Assist am besten für die individuelle Nutzung, wenn Sie schnellen Zugriff auf Ollama-gestützten Chat beim Web-Browsing wünschen, mit moderaten RAG-Fähigkeiten.

Open WebUI (Selbstgehostete Web-Anwendung)

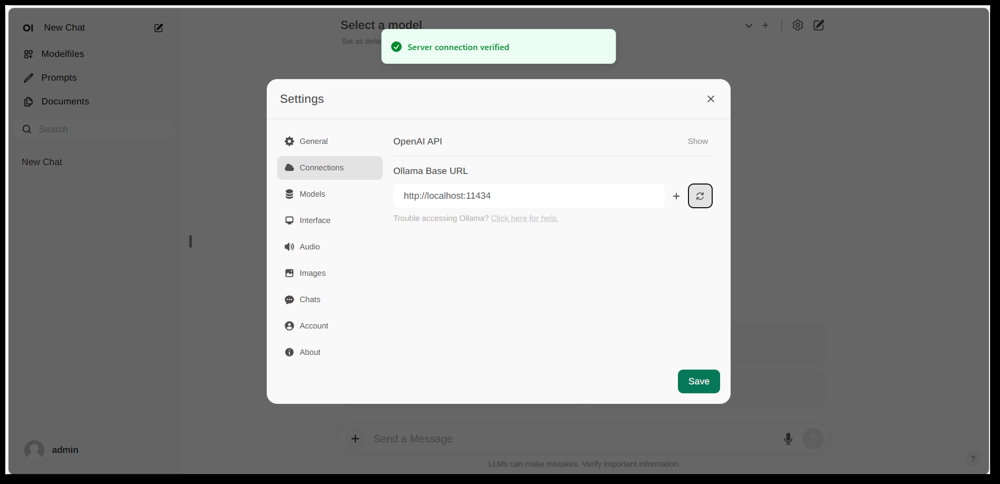

Die Einstellungensoberfläche von Open WebUI, die eine Ollama-Verbindung zeigt (Grund-URL auf die lokale Ollama-API eingestellt). Die Oberfläche enthält einen Dokumente-Bereich, der RAG-Workflows ermöglicht.

Open WebUI ist eine leistungsstarke, vielseitige Chat-Oberfläche, die ursprünglich für die Arbeit mit Ollama entwickelt wurde und nun auf verschiedene LLM-Backends erweitert wurde. Sie läuft als selbstgehostete Web-Anwendung und wird typischerweise über Docker oder Kubernetes eingerichtet. Sobald sie läuft, können Sie darauf über Ihren Browser zugreifen (mit Unterstützung für die Installation als Progressive Web App auf mobilen Geräten).

Open WebUI bietet eine vollständige Chat-Oberfläche mit Multi-User-Unterstützung, Modellverwaltung und umfangreichen Funktionen. Kritisch ist, dass sie integrierte RAG-Funktionen bietet – Sie können Dokumente hochladen oder in eine Dokumentenbibliothek importieren und dann Fragen mit Retrieval-Augmentation stellen. Die Oberfläche ermöglicht das Laden von Dokumenten direkt in eine Chat-Sitzung oder das Pflegen einer dauerhaften Wissensbibliothek. Sie unterstützt sogar das Durchführen von Websuchen und das Einfügen der Ergebnisse in die Konversation für aktuelle Informationen.

Ollama-Integration: Open WebUI verbindet sich mit Ollama über dessen API. Sie können entweder den Open WebUI Docker-Container neben einem Ollama-Server ausführen und eine Umgebungsvariable festlegen, um auf die Ollama-URL zu verweisen, oder ein spezielles Docker-Image verwenden, das Ollama mit der Web-Oberfläche bündelt. In der Praxis besuchen Sie nach dem Starten der Container die Open WebUI in Ihrem Browser und sehen die Meldung „Serververbindung überprüft“, wenn alles korrekt konfiguriert ist (wie im obigen Bild gezeigt). Dies bedeutet, dass die Oberfläche bereit ist, Ihre lokalen Ollama-Modelle für den Chat zu nutzen. Open WebUI unterstützt auch OpenAI-API-kompatible Endpunkte, sodass es mit LM Studio, OpenRouter usw. neben Ollama kommunizieren kann.

Stärken: Diese Lösung ist eine der funktionsreichsten und flexibelsten Oberflächen. Sie unterstützt mehrere gleichzeitige Modelle und Gesprächsfäden, benutzerdefinierte „Charaktere“ oder Systemaufforderungen, Bildgenerierung und mehr. Die RAG-Implementierung ist robust – Sie erhalten eine vollständige Oberfläche zur Verwaltung von Dokumenten und sogar zur Konfiguration des zu verwendenden Vektor-Speichers oder Suchdienstes für die Abfrage. Open WebUI wird auch aktiv weiterentwickelt (mit einer umfangreichen Community, wie durch die hohe Sternenanzahl auf GitHub angezeigt) und für Erweiterbarkeit und Skalierbarkeit konzipiert. Es ist eine gute Wahl, wenn Sie eine umfassende, All-in-One-Chat-Oberfläche für lokale Modelle wünschen, insbesondere in einem Szenario mit mehreren Benutzern oder komplexen Anwendungsfällen.

Einschränkungen: Mit großer Macht kommt größere Komplexität. Open WebUI kann überflüssig für einfache persönliche Nutzung sein – das Bereitstellen von Docker-Containern und das Verwalten der Konfiguration kann abschreckend sein, wenn Sie nicht vertraut sind. Es verbraucht mehr Ressourcen als eine leichtgewichtige App, da es einen Webserver, eine optionale Datenbank für Chatverläufe usw. ausführt. Auch Funktionen wie rollenbasierte Zugriffskontrolle und Benutzerverwaltung, obwohl nützlich, deuten darauf hin, dass es für eine Serverumgebung ausgelegt ist – ein einzelner Benutzer an einem Heim-PC könnte nicht alles davon benötigen. Kurz gesagt, die Einrichtung ist aufwendiger und die Oberfläche kann komplex wirken, wenn Sie nur eine einfache ChatGPT-Kopie benötigen. Aber für diejenigen, die tatsächlich dessen Funktionsumfang benötigen (oder leicht zwischen Ollama und anderen Modellanbietern in einer Oberfläche wechseln möchten), ist Open WebUI eine Top-Option.

LobeChat (ChatGPT-ähnlicher Framework mit Plugins)

LobeChat-Schnittstellenbanner mit „Ollama Supported“ und mehreren lokalen Modellen. LobeChat ermöglicht Ihnen die Bereitstellung einer stilvollen ChatGPT-ähnlichen Web-App mit Ollama oder anderen Anbietern, inklusive Sprach-Eingabe und Plugins.

LobeChat ist ein Open-Source-Chat-Framework, das eine polierte Benutzererfahrung und Flexibilität in den Vordergrund stellt. Es handelt sich im Wesentlichen um eine ChatGPT-ähnliche Web-Anwendung, die Sie selbst hosten können, mit Unterstützung für mehrere KI-Anbieter – von OpenAI und Anthropic bis hin zu Open-Source-Modellen über Ollama. LobeChat ist mit dem Datenschutz im Sinn gestaltet (Sie betreiben es selbst) und verfügt über eine moderne Schnittstelle, die Annehmlichkeiten wie Gesprächsspeicher, Sprachgesprächsmodus und sogar Text-zu-Bild-Generierung über Plugins bietet.

Eine der wichtigsten Funktionen von LobeChat ist die Knowledge-Base-Fähigkeit. Sie können Dokumente (in Formaten wie PDFs, Bildern, Audio, Video) hochladen und eine Knowledge Base erstellen, auf die während des Chats zurückgegriffen werden kann. Das bedeutet, Sie können Fragen zu den Inhalten Ihrer Dateien stellen – ein RAG-Workflow, den LobeChat standardmäßig unterstützt. Die Benutzeroberfläche bietet das Management dieser Dateien/Knowledge Bases und ermöglicht das Aktivieren/Deaktivieren ihrer Nutzung im Gespräch, was ein reichhaltigeres Frage-Antwort-Erlebnis jenseits des Grund-LLMs bietet.

Um LobeChat mit Ollama zu verwenden, stellen Sie die LobeChat-App bereit (z. B. über ein bereitgestelltes Docker-Image oder Skript) und konfigurieren Ollama als Backend. LobeChat erkennt Ollama als ersten Anbieter – es bietet sogar ein One-Click-Deployment-Skript über den Pinokio-AI-Browser, wenn Sie diesen verwenden. In der Praxis müssen Sie möglicherweise die Ollama-Einstellungen anpassen (wie das Aktivieren von CORS gemäß den LobeChat-Dokumentationen), damit die LobeChat-Web-Oberfläche auf die Ollama-HTTP-API zugreifen kann. Sobald die Konfiguration abgeschlossen ist, können Sie ein von Ollama gehostetes Modell in der LobeChat-Oberfläche auswählen und mit diesem kommunizieren, einschließlich der Abfrage Ihrer hochgeladenen Dokumente.

Stärken: Die LobeChat-Oberfläche wird oft für ihre saubere und benutzerfreundliche Gestaltung gelobt, die stark an das Aussehen und Gefühl von ChatGPT erinnert (was die Akzeptanz erleichtern kann). Es fügt Wert mit Extras wie Spracheingabe/-ausgabe für gesprochene Gespräche und einem Plugin-System hinzu, um die Funktionalität zu erweitern (ähnlich wie die ChatGPT-Plugins, die Dinge wie Web-Browsing oder Bildgenerierung ermöglichen). Die Unterstützung mehrerer Modelle bedeutet, dass Sie leicht zwischen z. B. einem lokalen Ollama-Modell und einem OpenAI-API-Modell in derselben Oberfläche wechseln können. Es unterstützt auch die Installation als mobilfreundliche PWA, sodass Sie auf Ihren lokalen Chat unterwegs zugreifen können.

Einschränkungen: Die Einrichtung von LobeChat kann komplexer sein als bei einigen Alternativen. Es handelt sich um eine Full-Stack-Anwendung (oft mit Docker Compose betrieben), sodass einige Überhead-Kosten entstehen. Insbesondere erfordert die Konfiguration der Ollama-Integration das Aktivieren von Cross-Origin-Anfragen auf Ollama-Seite und das Sicherstellen, dass die Ports übereinstimmen – eine einmalige Aufgabe, aber technisch. Darüber hinaus, obwohl LobeChat sehr leistungsfähig ist, müssen nicht alle Funktionen für jeden Benutzer benötigt werden; beispielsweise, wenn Sie keine Multi-Anbieter-Unterstützung oder Plugins benötigen, könnte die Oberfläche im Vergleich zu einem minimalen Tool überladen wirken. Schließlich setzen bestimmte erweiterte Funktionen wie das One-Click-Deploy spezifische Umgebungen voraus (Pinokio-Browser oder Vercel), die Sie möglicherweise nicht verwenden. Insgesamt ist LobeChat ideal, wenn Sie eine voll ausgestattete ChatGPT-Alternative wünschen, die lokal mit Ollama läuft, und Sie sich nicht an der anfänglichen Konfiguration stören.

LibreChat (ChatGPT-Klon mit Multi-Anbieter-Unterstützung)

LibreChat (früher bekannt als ChatGPT-Klon oder UI) ist ein Open-Source-Projekt, das darauf abzielt, die ChatGPT-Schnittstelle und -Funktionalität zu replizieren und zu erweitern. Es kann lokal (oder auf Ihrem eigenen Server) bereitgestellt werden und unterstützt eine Vielzahl von KI-Backends – einschließlich Open-Source-Modelle über Ollama. Im Wesentlichen bietet LibreChat das vertraute Chat-Erlebnis (Dialog-Schnittstelle mit Geschichte, Benutzer- und Assistentennachrichten) und lässt Sie verschiedene Modellanbieter im Backend einbinden.

LibreChat unterstützt Dokumenteninteraktion und RAG über ein Add-on namens RAG-API und Einbettungsdienste. In der Oberfläche können Sie Funktionen wie „Chat mit Dateien“ nutzen, die es Ihnen ermöglicht, Dokumente hochzuladen und dann Fragen dazu zu stellen. Unter der Haube verwendet dies Einbettungen und einen Vektor-Speicher, um relevante Kontexte aus Ihren Dateien abzurufen. Dies bedeutet, Sie können einen ähnlichen Effekt wie ChatGPT + benutzerdefinierte Knowledge erzielen, alles lokal. Das Projekt bietet sogar ein separates Repo für den RAG-Dienst, falls Sie diesen selbst hosten möchten.

Die Verwendung von LibreChat mit Ollama umfasst in der Regel das Ausführen des LibreChat-Servers (z. B. über Node/Docker) und das Sicherstellen, dass er auf den Ollama-Dienst zugreifen kann. LibreChat verfügt über eine „Benutzerdefinierte Endpunkt“ Einstellung, in der Sie eine OpenAI-kompatible API-URL eingeben können. Da Ollama eine lokale API exponieren kann, die OpenAI-kompatibel ist, kann LibreChat auf http://localhost:11434 (oder wo auch immer Ollama hört) gerichtet werden. Tatsächlich listet LibreChat Ollama explizit unter seinen unterstützten KI-Anbietern auf – neben anderen wie OpenAI, Cohere usw. Sobald die Konfiguration abgeschlossen ist, können Sie das Modell (Ollama-Modell) in einem Dropdown-Menü auswählen und loslegen. LibreChat ermöglicht auch das Wechseln von Modellen oder Anbietern sogar mitten im Gespräch und unterstützt mehrere Chat-Voreinstellungen/Kontexte.

Stärken: Der Hauptvorteil von LibreChat ist das reiche Set an Funktionen, das um das Chat-Erlebnis herum aufgebaut ist. Dazu gehören Dinge wie Gesprächsverzweigung, Nachrichten-Suche, eingebaute Code-Interpreter-Unterstützung (sichere sandkastenbasierte Code-Ausführung) und Tool/Agent-Integrationen. Es ist im Wesentlichen ChatGPT++, mit der Fähigkeit, lokale Modelle zu integrieren. Für jemanden, der die ChatGPT-Oberfläche mag, wird LibreChat sehr vertraut wirken und erfordert wenig Lernkurve. Das Projekt ist aktiv und communitygetrieben (wie durch seine häufigen Updates und Diskussionen belegt) und sehr flexibel: Sie können sich mit vielen Arten von LLM-Endpunkten verbinden oder es sogar mehrbenutzerfähig mit Authentifizierung für ein Team-Setting betreiben.

Einschränkungen: Mit seinen vielen Funktionen kann LibreChat schwerer zu betreiben sein. Die Installation könnte das Einrichten einer Datenbank zum Speichern von Chats und das Konfigurieren von Umgebungsvariablen für verschiedene APIs umfassen. Wenn Sie alle Komponenten aktivieren (RAG, Agenten, Bildgenerierung usw.), ist es ein recht komplexer Stack. Für einen einzelnen Benutzer, der nur einen einfachen Chat mit einem lokalen Modell benötigt, könnte LibreChat mehr sein, als benötigt wird. Zusätzlich ist die Oberfläche, obwohl vertraut, nicht hochspezialisiert für Dokumenten-QA – sie erledigt den Job, aber es fehlt eine dedizierte „Dokumentenbibliothek“-Oberfläche (Uploads werden typischerweise innerhalb eines Chats oder über die API durchgeführt). Kurz gesagt, LibreChat glänzt, wenn Sie eine volle ChatGPT-ähnliche Umgebung mit einer Reihe von Funktionen lokal betreiben möchten, aber einfachere Lösungen könnten für eng fokussierte Anwendungsfälle ausreichen.

AnythingLLM (All-in-One-Desktop- oder Server-App)

AnythingLLM ist eine All-in-One-KI-Anwendung, die RAG und Benutzerfreundlichkeit in den Vordergrund stellt. Sie ermöglicht Ihnen das „Chatten mit Ihren Dokumenten“ unter Verwendung von Open-Source-LLMs oder sogar OpenAI-Modellen, alles über eine einzige einheitliche Oberfläche. Bemerkenswert ist, dass AnythingLLM sowohl als plattformübergreifende Desktop-App (für Windows, Mac, Linux) als auch als selbst gehosteter Web-Server (über Docker) verfügbar ist. Diese Flexibilität bedeutet, dass Sie es wie eine normale Anwendung auf Ihrem PC ausführen oder es für mehrere Benutzer auf einem Server bereitstellen können.

Die Dokumentenhandhabung steht im Mittelpunkt von AnythingLLM. Sie können Dokumente per Drag-and-Drop (PDF, TXT, DOCX usw.) in die App ziehen, und es wird sie automatisch in eine Vektordatenbank indizieren (es kommt standardmäßig mit LanceDB). In der Chat-Oberfläche, wenn Sie Fragen stellen, wird es relevante Abschnitte aus Ihren Dokumenten abrufen und zitierte Antworten liefern, sodass Sie wissen, aus welcher Datei und welchem Abschnitt die Informationen stammen. Im Wesentlichen baut es eine private Knowledge Base für Sie auf und lässt den LLM diese als Kontext verwenden. Sie können Dokumente in „Arbeitsbereiche“ organisieren (z. B. einen Arbeitsbereich pro Projekt oder Thema), um Kontexte nach Bedarf zu isolieren.

Die Verwendung von Ollama mit AnythingLLM ist unkompliziert. In der Konfiguration wählen Sie Ollama als LLM-Anbieter. Wenn Sie es über Docker ausführen, legen Sie Umgebungsvariablen wie LLM_PROVIDER=ollama fest und geben Sie den OLLAMA_BASE_PATH (die URL zu Ihrer Ollama-Instanz) an. Der AnythingLLM-Server wird dann alle Modellabfragen an die Ollama-API senden. Ollama wird offiziell unterstützt, und die Dokumentation weist darauf hin, dass Sie es nutzen können, um verschiedene Open-Source-Modelle (wie Llama 2, Mistral usw.) lokal auszuführen. Tatsächlich heben die Entwickler hervor, dass die Kombination von AnythingLLM mit Ollama leistungsstarke Offline-RAG-Fähigkeiten freischaltet: Ollama übernimmt die Modellinferenz, und AnythingLLM übernimmt die Einbettungen und die UI/Agenten-Logik.

Stärken: AnythingLLM bietet eine umfassende Lösung für private Frage-Antwort- und Chat-Anwendungen. Wichtige Stärken sind: eine einfache Einrichtung für RAG (die schwere Arbeit der Einbettung und Speicherung von Vektoren wird automatisiert), Unterstützung für mehrere Dokumente mit klarer Zitierung der Quellen und zusätzliche Funktionen wie KI-Agenten (es hat einen No-Code-Agenten-Builder, mit dem Sie benutzerdefinierte Workflows und Tool-Nutzung erstellen können). Es ist auch von Haus aus mehrbenutzerfähig (insbesondere im Server-Modus), mit Benutzerkonten und Berechtigungen, falls erforderlich. Die Oberfläche ist so gestaltet, dass sie einfach (Chat-Box + Seitenleiste mit Dokumenten/Arbeitsbereichen) aber leistungsfähig unter der Haube ist. Für die persönliche Nutzung ist die Desktop-App ein großer Vorteil – Sie erhalten eine native wirkende App, ohne einen Browser öffnen oder Befehle ausführen zu müssen, und sie speichert Daten standardmäßig lokal.

Einschränkungen: Da es viele Komponenten integriert (LLM-API, Einbettungsmodelle, Vektor-DB usw.), kann AnythingLLM ressourcenintensiv sein. Wenn Sie Dokumente eingeben, kann es Zeit und Speicher in Anspruch nehmen, um Einbettungen zu generieren (es unterstützt sogar die Verwendung von Ollama selbst oder lokalen Modellen für Einbettungen mit Modellen wie nomic-embed). Die Desktop-App vereinfacht die Nutzung, aber wenn Sie viele Dokumente oder sehr große Dateien haben, erwarten Sie einige schwere Verarbeitung im Hintergrund. Eine weitere Einschränkung ist, dass fortgeschrittene Benutzer es möglicherweise weniger konfigurierbar finden als die Zusammenstellung ihres eigenen Stacks – beispielsweise verwendet es derzeit LanceDB oder Chroma; wenn Sie einen anderen Vektor-Speicher wünschen, müssten Sie in die Konfiguration oder den Code eintauchen. Auch wenn die Multi-Anbieter-Unterstützung unterstützt wird, ist die Oberfläche wirklich auf ein Modell zur gleichen Zeit ausgelegt (Sie würden die globale Anbieter-Einstellung ändern, wenn Sie ein anderes Modell verwenden möchten). Zusammenfassend ist AnythingLLM eine hervorragende Out-of-the-Box-Lösung für lokalen Dokumenten-Chat, insbesondere mit Ollama, aber es ist eine größere Anwendung im Vergleich zu minimalen Oberflächen.

Chat-with-Notes (Minimale Dokumenten-Chat-Oberfläche)

Chat-with-Notes ist eine minimalistische Anwendung, die speziell zum Chatten mit lokalen Textdateien unter Verwendung von Ollama-gesteuerten Modellen entwickelt wurde. Es handelt sich im Wesentlichen um einen leichten Flask-Webserver, den Sie auf Ihrem PC ausführen, und der eine einfache Webseite bereitstellt, auf der Sie ein Dokument hochladen und darüber chatten können. Das Ziel dieses Projekts ist Einfachheit: Es hat nicht viele Extras, erfüllt aber die Kernaufgabe der Dokumenten-Fragen-Beantwortung mit einem lokalen LLM.

Die Verwendung von Chat-with-Notes erfordert zunächst die Sicherstellung, dass Ihre Ollama-Instanz ein Modell ausführt (zum Beispiel könnten Sie Ollama mit ollama run llama2 oder einem anderen Modell starten). Dann starten Sie die Flask-App (python app.py) und öffnen die lokale Webseite. Die Benutzeroberfläche fordert Sie auf, eine Datei hochzuladen (unterstützte Formate sind einfache Texte, Markdown, Code-Dateien, HTML, JSON und PDFs). Nach dem Hochladen wird der Textinhalt der Datei angezeigt, und Sie können Fragen stellen oder mit der KI über diesen Inhalt chatten. Die Konversation findet im typischen Chat-Blasenformat statt. Wenn Sie während einer Konversation eine neue Datei hochladen, fragt die App, ob Sie einen neuen Chat beginnen oder den aktuellen Chat-Kontext beibehalten und einfach die Informationen der neuen Datei hinzufügen möchten. Auf diese Weise können Sie nacheinander über mehrere Dateien sprechen, wenn nötig. Es gibt auch Schaltflächen zum Löschen des Chats oder zum Exportieren der Konversation in eine Textdatei.

Unter der Haube fragt Chat-with-Notes die Ollama-API zur Generierung von Antworten ab. Ollama übernimmt die Modellinferenz, und Chat-with-Notes liefert nur die Eingabeaufforderung (die relevante Teile des hochgeladenen Textes enthält). Es verwendet keine Vektordatenbank; stattdessen sendet es den gesamten Dateiinhalt (oder Teile davon) zusammen mit Ihrer Frage an das Modell. Dieser Ansatz funktioniert am besten für vernünftig große Dokumente, die in das Kontextfenster des Modells passen.

Stärken: Die App ist extrem einfach zu deployen und zu verwenden. Es gibt keine komplexe Konfiguration – wenn Sie Python und Ollama eingerichtet haben, können Sie sie in ein paar Minuten zum Laufen bringen. Die Oberfläche ist sauber und minimalistisch und konzentriert sich auf den Textinhalt und die Frage-Antwort-Interaktion. Da sie so fokussiert ist, stellt sie sicher, dass alle Daten lokal bleiben und nur im Arbeitsspeicher (keine externen Aufrufe außer zu Ollama auf localhost). Sie ist eine gute Wahl, wenn Sie speziell mit Dateien chatten möchten und keine allgemeine Konversation ohne Dokument benötigen.

Einschränkungen: Die Minimalismus von Chat-with-Notes bedeutet, dass es viele Funktionen fehlen, die in anderen Oberflächen zu finden sind. Zum Beispiel unterstützt es nicht die Verwendung mehrerer Modelle oder Anbieter (es ist Ollama-only durch Design), und es unterhält keine langfristige Dokumentenbibliothek – Sie laden Dateien nach Bedarf pro Sitzung hoch, und es gibt keinen persistenten Vektorindex. Das Skalieren auf sehr große Dokumente könnte ohne manuelle Anpassungen schwierig sein, da es versuchen könnte, viel Text in die Eingabeaufforderung einzubeziehen. Auch die Oberfläche, obwohl funktional, ist nicht so ausgereift (kein Dunkelmodus, keine reiche Textformatierung der Antworten usw.). Im Wesentlichen ist dieses Tool ideal für schnelle, einmalige Analysen von Dateien mit einem Ollama-Modell. Wenn Ihre Anforderungen wachsen (z. B. viele Dokumente oder der Wunsch nach einer schickeren Oberfläche), könnten Sie Chat-with-Notes überwachsen. Aber als Ausgangspunkt oder persönliche „Frage mein PDF“-Lösung auf Basis von Ollama ist es sehr effektiv.

Fazit

Jede dieser Open-Source-Oberflächen kann Ihr Erlebnis mit lokalen Ollama-Modellen verbessern, indem sie eine benutzerfreundliche Chat-Oberfläche und zusätzliche Funktionen wie Dokumenten-Fragen-Beantwortung bieten. Die beste Wahl hängt von Ihren Anforderungen und Ihrem technischen Komfort ab:

- Für schnelle Einrichtung und browserbasierte Nutzung: Page Assist ist eine gute Wahl, die direkt in Ihr Web-Browsing integriert wird, mit minimalem Aufwand.

- Für eine voll ausgestattete Web-App-Umgebung: Open WebUI oder LibreChat bieten umfangreiche Funktionen und Multi-Modell-Flexibilität, geeignet für Power-User oder Multi-User-Einrichtungen.

- Für eine polierte ChatGPT-Alternative mit Plugin-Potenzial: LobeChat bietet eine gute Balance zwischen Benutzerfreundlichkeit und Funktionen in einem selbst gehosteten Paket.

- Für dokumentenorientierte Interaktionen: AnythingLLM liefert eine All-in-One-Lösung (insbesondere wenn Sie eine Desktop-App bevorzugen), während Chat-with-Notes einen minimalistischen Ansatz für die Einzeldokumenten-Fragen-Beantwortung bietet.

Da alle diese Tools aktiv gepflegt werden, können Sie auch auf Verbesserungen und Community-Unterstützung hoffen. Durch die Wahl einer dieser Oberflächen werden Sie in der Lage sein, mit Ihren lokalen Ollama-gehosteten Modellen auf bequeme Weise zu chatten – sei es zur Analyse von Dokumenten, zum Codieren mit Unterstützung oder einfach zum Verfügbarmachen von Konversations-KI ohne Cloud-Abhängigkeiten. Jede der oben genannten Lösungen ist Open-Source, sodass Sie sie weiter an Ihre Bedürfnisse anpassen oder sogar an ihrer Entwicklung beitragen können.

Viel Spaß beim Chatten mit Ihrem lokalen LLM!