Farfalle vs. Perplexica

Vergleich zweier selbstge LOGGER AI-Suchmaschinen

Hervorragende Nahrung ist auch ein Vergnügen für die Augen. Aber in diesem Beitrag vergleichen wir zwei AI-basierte Suchsysteme, Farfalle und Perplexica.

Übrigens heißt diese Form der Nudeln auch „farfalle“.

Aber hier vergleiche ich nur, wie diese beiden Systeme sich verhalten. Nicht die Nudelformen.

OK. Konzentrieren Sie sich!

Bitte siehe auch Perplexica Installation und Konfiguration - mit ollama und Installieren und konfigurieren Sie Ollama.

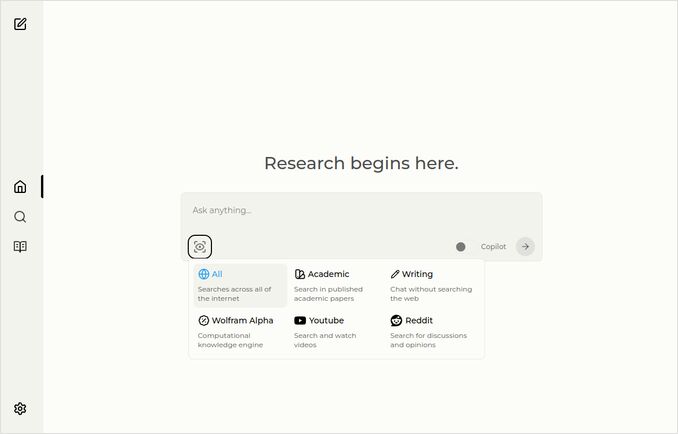

Perplexica

Hier ist die Startseite mit einem Dropdown-Menü zur Auswahl der Quellen.

- Perplexica ist in folgenden Technologien implementiert:

- TypeScript und React.Js (UI)

- TypeScript und Express.Js (Backend)

- enthält auch eine Konfiguration für das SearxNG-Metasearch-System

- Hat einen Copilot-Modus

- Kann beliebige von Ollama-gehosteten LLMs als Chat- oder Embedding-Modell verwenden

- Verfügt über drei kleine interne Embedding-Modelle

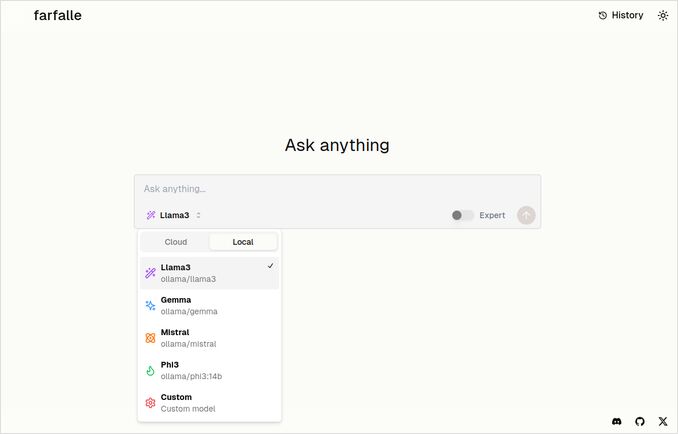

Farfalle

- Farfalle ist in folgenden Technologien implementiert:

- TypeScript und React.Js (UI)

- Python Fastapi (Backend)

- enthält auch eine Referenz für das SearxNG-Metasearch-System. Es gibt nicht viel Konfiguration für dieses, es ist eher ein Standard-Docker-Image.

- Hat einen Expertenmodus, der mehrere Anfragen aus der ursprünglichen Anfrage erstellen und die Antworten kombinieren soll. Dies funktionierte jedoch nicht in unserem Test.

- Kann vier von Ollama-gehosteten LLMs als Chat-Modell verwenden (llama3, mistral, gemma, phi3). Das ist eine gute Auswahl an Optionen, aber ich würde es vorziehen, wenn es flexibler wäre und beliebige Modelle verwenden könnte, die Ollama bereitstellt.

- Keine Optionen für Embedding-Modelle

Vergleich durchgeführt von Perplexica und Farfalle selbst

Ich habe dieselbe Anfrage gestellt: Vergleiche Farfalle und Perplexica basierend auf Robustheit, Community, Support und unterstützten LLMs

Beide, Perplexica und Farfalle, verwendeten das llama3-Modell, das lokal auf Ollama gehostet wurde. Der vollständige Name des Modells ist llama3 8b q4.

Glauben Sie nicht 100 %, was die Antworten sagen, sondern sehen Sie die Textlänge, Struktur und die allgemeine Qualität der Antwort.

Ich würde ungefähr 70 % glauben…

Perplexica-Vergleichsantwort

Vergleich zwischen Farfalle und Perplexica

Robustheit

Farfalle: 8/10 - Farfalle ist eine beliebte KI-Suchmaschine, bekannt für ihre Zuverlässigkeit und Fähigkeit, komplexe Abfragen zu verarbeiten. Sie hat eine starke Grundlage in der natürlichen Sprachverarbeitung (NLP) und maschinellem Lernen (ML). Obwohl sie nicht perfekt ist, ist die Robustheit von Farfalle gut etabliert.

Perplexica: 9/10 - Perplexica basiert auf dem Phi-3-Modell von Meta AI, das für Robustheit konzipiert ist. Es wurde getestet, um genaue Antworten auch bei unklaren oder mehrdeutigen Abfragen zu liefern. Ihre Fähigkeit, Fragen umzuformulieren und sich verschiedenen Kontexten anzupassen, macht es zu einer robusten Suchmaschine.

Community

Farfalle: 7/10 - Farfalle hat eine engagierte Nutzercommunity, die ihre Fähigkeiten schätzt. Obwohl sie nicht die gleiche Adoption wie Perplexica hat, ist ihre Nutzerbasis dennoch bedeutend.

Perplexica: 8,5/10 - Perplexica hat sich aufgrund ihres innovativen Ansatzes bei Suchmaschinen weit verbreitet. Ihre Community wächst schnell, viele Nutzer schätzen ihre Fähigkeit, präzise und relevante Ergebnisse zu liefern.

Support

Farfalle: 6,5/10 - Farfalle bietet grundlegenden Support über FAQs, Dokumentation und Foren. Obwohl er nicht so umfassend wie der Support von Perplexica ist, ist die Nutzerbasis von Farfalle in der Regel selbstständig.

Perplexica: 9/10 - Perplexica bietet umfangreiche Support-Ressourcen, einschließlich detaillierter Dokumentation, FAQs und Community-foren. Ihre Entwickler sind aktiv mit der Community verbunden, um Nutzern rechtzeitigen und effektiven Support zu gewährleisten.

Unterstützte LLMs

Farfalle: Nein - Farfalle ist eine eigenständige KI-Suchmaschine, die nicht auf große Sprachmodelle (LLMs) angewiesen ist, um ihre Fähigkeiten zu erbringen.

Perplexica: Ja - Perplexica basiert auf dem Phi-3-Modell von Meta AI, einem LLM. Dies ermöglicht es Perplexica, die Kraft des tiefen Lernens für genauere und relevantere Ergebnisse zu nutzen.

Gesamtwertung Farfalle: 22/30 Perplexica: 34,5/40

Basierend auf diesen Kriterien scheint Perplexica einen geringen Vorteil gegenüber Farfalle in Bezug auf Robustheit, Community-Unterstützung und LLM-Integration zu haben. Dennoch haben beide Suchmaschinen ihre Stärken, und die Wahl hängt letztendlich von Ihren spezifischen Bedürfnissen und Vorlieben ab.

Empfehlung Wenn Sie eine zuverlässige KI-Suchmaschine mit starken NLP-Fähigkeiten suchen, könnte Perplexica die bessere Wahl sein. Wenn Sie eine einfachere, unkompliziertere Suchmethode bevorzugen, könnte Farfalle dennoch hervorragende Ergebnisse liefern.

Farfalle-Vergleichsantwort

Vergleich zwischen Farfalle und Perplexica

Farfalle und Perplexica sind zwei KI-gestützte Suchmaschinen, die in jüngster Zeit Aufmerksamkeit erregt haben. Hier ist ein Vergleich dieser beiden Projekte basierend auf Robustheit, Community, Support und LLM (Large Language Model)-Unterstützung.

Robustheit

- Farfalle ist so konzipiert, dass sie lokal oder in der Cloud mit LLMs selbst gehostet werden kann, was sie zu einer robusteren Option für Nutzer macht, die Kontrolle über ihre Suchmaschine haben möchten.

- Perplexica ist eine Open-Source-Alternative zu Perplexity AI und wird ständig von ihren Entwicklern verbessert.

Community

- Perplexica hat eine engagierte Community von Entwicklern und Nutzern, die an ihrer Entwicklung und Unterstützung mitwirken.

- Die Community von Farfalle ist kleiner, hat aber dennoch eine Präsenz auf GitHub.

Support

- Perplexica bietet regelmäßige Updates und Verbesserungen sowie einen Discord-Kanal für Diskussionen außerhalb der regulären Unterstützung.

- Der Support von Farfalle ist auf GitHub-Issues und Pull-Requests beschränkt.

LLM-Unterstützung Beide, Farfalle und Perplexica, unterstützen LLMs. Perplexica verwendet Ollama, ein lokales LLM, während Farfalle sowohl lokale als auch Cloud-LLMs unterstützt.

Zusammenfassend ist Farfalle aufgrund ihres selbstgehosteten Designs robuster, während Perplexica eine stärkere Community und besseren Support hat. Beide Projekte unterstützen LLMs, wobei Perplexica Ollama speziell verwendet.

Schlussfolgerung

Was ist der Unterschied zwischen Perplexica und Farfalle?

Die Antwort:

- Abgesehen von einigen Faktenfehlern denken beide Systeme, dass Perplexica besser ist als Farfalle, was ich gerne zugeben würde.

- Ich mag die Benutzeroberfläche von Farfalle sehr, obwohl sie ziemlich ähnlich sind.

- Ich mag die Idee des Expertenmodus von Farfalle, obwohl er in meiner Umgebung nicht funktioniert hat.

- Ich stieß auf 3 Fehler, wenn ich Farfalle ausführte. Der Code von Perplexica ist besser poliert.

- Nach der Konfiguration lief Perplexica ohne Fehler.

- Perplexica erlaubt den Einsatz beliebiger von Ollama-gehosteten Modelle. Farfalle erlaubt den Einsatz nur von Gemma, Llama3, Mistral und Phi3 (vordefinierte Versionen, die etwas veraltet sind).

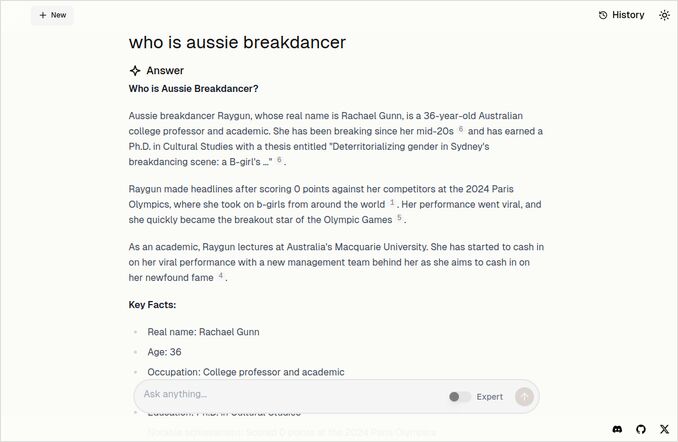

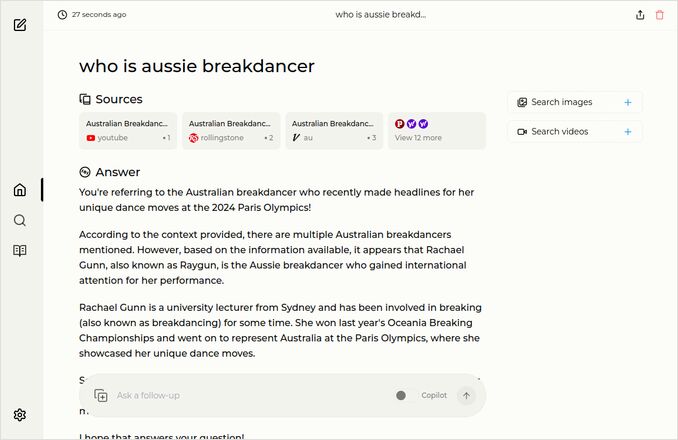

- Ich mag die Antworten von Farfalle mehr. Schauen Sie sich das untenstehende Farfalle-Bild an. Direkt zum Punkt, ohne diese „Gemäß dem gegebenen Kontext“…

Weitere Beispiele

Diese zeigen Antworten auf dieselbe Frage über den australischen Breakdancer. Sie wissen, den mit dem Doktortitel, der 0 (Null) Punkte erhielt und wahrscheinlich den Breakdancing aus dem Olympischen Programm entfernt wurde.

Farfalle-Antwort

Perplexica-Antwort

Wenn Sie den letzten Absatz lesen (oder runterblättern), vielen Dank, dass Sie dieselben Interessen haben wie ich. Es sind wirklich aufregende Zeiten. Haben Sie einen wunderbaren Tag!

Nützliche Links

- Suche vs Deepsearch vs Deep Research

- Test: Wie Ollama Intel CPU-Performance und Effiziente Kerne verwendet

- Wie Ollama parallele Anfragen verarbeitet

- Selbsthosting von Perplexica - mit Ollama

- Vergleich der Fähigkeiten von LLMs zur Zusammenfassung

- Schreiben effektiver Prompts für LLMs

- Test der logischen Fehlschlüsse-Erkennung durch neue LLMs: gemma2, qwen2 und mistral Nemo

- Ollama Cheatsheet

- Markdown Cheatsheet

- Cloud LLM-Anbieter

- Qwen3 Embedding & Reranker-Modelle auf Ollama: State-of-the-Art-Performance