Ollama-Modelle an einen anderen Ort verschieben

Ollama-LLM-Modelldateien benötigen viel Speicherplatz.

Nachdem Sie Ollama installiert haben, ist es besser, Ollama direkt so zu konfigurieren, dass die Modelle an einem neuen Ort gespeichert werden. So werden neue Modelle nicht mehr in den alten Speicherort heruntergeladen.

Über Ollama

Ollama ist eine textbasierte Oberfläche für LLM-AI-Modelle und eine API, die diese auch hosten kann.

Ollama installieren

Gehen Sie zu https://ollama.com/download

Um Ollama unter Linux zu installieren:

curl -fsSL https://ollama.com/install.sh | sh

Ollama unter Windows finden Sie auf der Seite: https://ollama.com/download/windows Für Mac ist Ollama ebenfalls verfügbar: https://ollama.com/download/macOllamaSetup.exe

Ollama-Modelle herunterladen, auflisten und entfernen

Um einige Ollama-Modelle herunterzuladen: Gehen Sie zur Ollama-Bibliothek (https://ollama.com/library) und suchen Sie das benötigte Modell, dort finden Sie auch Modell-Tag und -Größe.

Dann führen Sie Folgendes aus:

ollama pull gemma2:latest

# Oder eine etwas intelligentere Version, die gut in 16 GB VRAM passt:

ollama pull gemma2:27b-instruct-q3_K_S

# Oder:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

Um die Modelle anzuzeigen, die Ollama lokal im Repository hat:

ollama list

Um ein nicht benötigtes Modell zu entfernen:

ollama rm qwen2:7b-instruct-q8_0 # als Beispiel

Ollama-Modell-Ort

Standardmäßig werden die Modell-Dateien gespeichert:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

Ollama-Modellpfad unter Windows konfigurieren

Um eine Umgebungsvariable unter Windows zu erstellen, können Sie folgende Anweisungen befolgen:

- Öffnen Sie die Windows-Einstellungen.

- Gehen Sie zu System.

- Wählen Sie „Über“.

- Wählen Sie „Erweiterte Systemeinstellungen“.

- Gehen Sie zum Tab „Erweitert“.

- Wählen Sie „Umgebungsvariablen…“.

- Klicken Sie auf „Neu…“.

- Erstellen Sie eine Variable namens OLLAMA_MODELS, die auf den Ort verweist, an dem Sie die Modelle speichern möchten.

Ollama-Modelle unter Linux verschieben

Bearbeiten Sie die Parameter des Ollama-Systemdienstes:

sudo systemctl edit ollama.service

oder

sudo xed /etc/systemd/system/ollama.service

Dies öffnet einen Editor.

Für jede Umgebungsvariable fügen Sie eine Zeile Environment unter dem Abschnitt [Service] hinzu:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

Speichern Sie und beenden Sie den Editor.

Es gibt auch Parameter für Benutzer und Gruppe, diese müssen Zugriff auf diesen Ordner haben.

Laden Sie systemd neu und starten Sie Ollama neu:

sudo systemctl daemon-reload

sudo systemctl restart ollama

falls etwas schiefgelaufen ist:

systemctl status ollama.service

sudo journalctl -u ollama.service

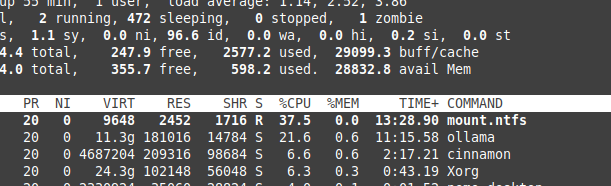

NTFS-Überlastung beim Speichern von Dateien

Bitte beachten Sie, dass wenn Sie Linux verwenden und Ihre Modelle auf einer NTFS-formatierten Partition speichern, Ihre Modelle deutlich langsamer geladen werden – mehr als 20 % langsamer.

Ollama unter Windows in einen bestimmten Ordner installieren

Zusammen mit den Modellen:

.\OllamaSetup.exe /DIR=D:\OllamaDir

Ollama-API innerhalb des internen Netzwerks exponieren

Intern bedeutet hier lokales Netzwerk.

Fügen Sie zur Dienstkonfiguration hinzu:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Nützliche Links

- Test: Wie Ollama Intel CPU-Performance und Effiziente Kerne nutzt

- Wie Ollama parallelle Anfragen verarbeitet

- Testen von Deepseek-r1 auf Ollama

- LLM-Performance und PCIe-Lanes: Wichtige Überlegungen

- Erkennung logischer Fehlschlüsse mit LLMs

- LLM-Geschwindigkeitsvergleich

- Vergleich der Zusammenfassungsfähigkeiten von LLMs

- Effektives Schreiben von Prompts für LLMs

- Selbsthosting von Perplexica mit Ollama

- Conda Cheatsheet

- Docker Cheatsheet

- Cloud-LLM-Anbieter

- Qwen3 Embedding & Reranker-Modelle auf Ollama: State-of-the-Art-Performance