Open WebUI: Interface de LLM Auto-Hospedada

Alternativa de ChatGPT auto-hospedada para LLMs locais

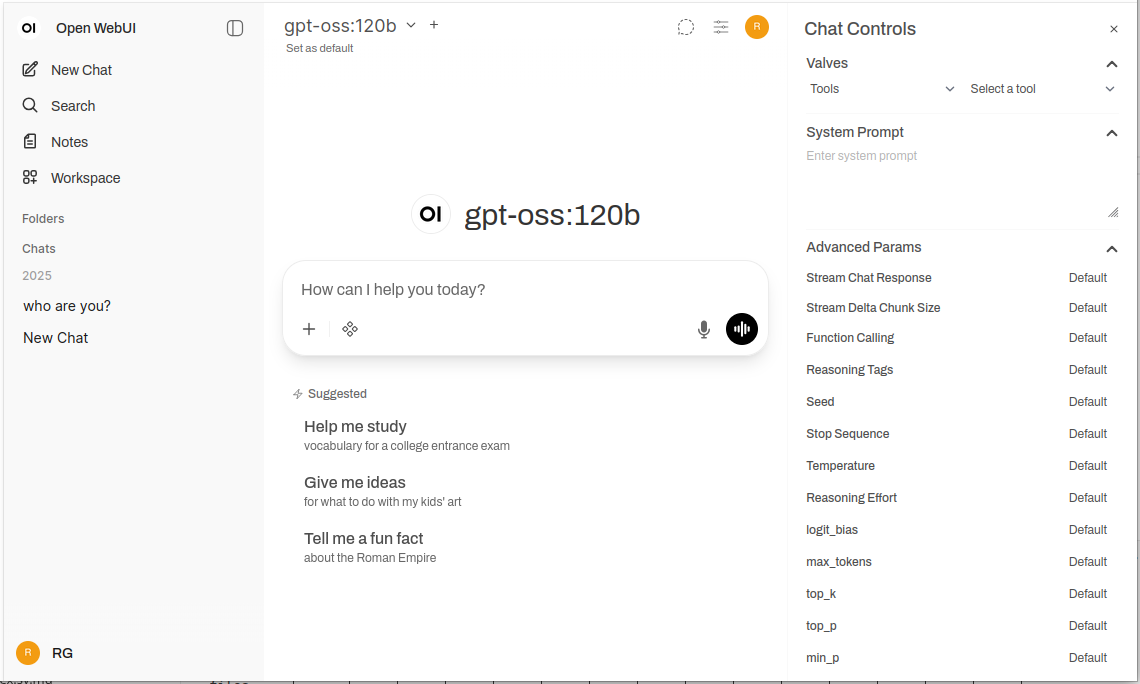

Open WebUI é uma poderosa, extensível e rica em recursos interface web autosservida para interagir com modelos de linguagem grandes.

Ele suporta Ollama e qualquer API compatível com OpenAI, trazendo a familiar experiência do ChatGPT para sua infraestrutura com privacidade total, capacidade offline e recursos empresariais de classe.

Para uma comparação mais ampla de backends locais e em nuvem de LLM — Ollama, vLLM, Docker Model Runner, LocalAI e provedores em nuvem — veja LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

O que é o Open WebUI?

O Open WebUI é uma aplicação web autosservida de código aberto que fornece uma interface moderna de chat para interagir com modelos de linguagem grandes. Ao contrário dos serviços de IA baseados em nuvem, o Open WebUI executa totalmente em sua infraestrutura, dando-lhe o controle total sobre seus dados, conversas e seleção de modelos.

Embora o Open WebUI seja comumente usado com Ollama (e às vezes chamado informalmente de “WebUI do Ollama”), é, de fato, uma plataforma independente do backend. Ele pode se conectar à API do Ollama para execução de modelos locais, mas também suporta qualquer endpoint compatível com OpenAI — incluindo vLLM, LocalAI, LM Studio, Text Generation WebUI e até provedores em nuvem. Essa flexibilidade torna o Open WebUI uma solução abrangente que suporta múltiplos backends, RAG (Geração Aumentada com Recuperação), documentação de chat, autenticação multiusuário, capacidades de voz e opções extensas de personalização. Seja você executando modelos em um laptop, um servidor doméstico ou um cluster Kubernetes, o Open WebUI se adapta às suas necessidades.

Por que escolher o Open WebUI?

Privacidade em primeiro lugar: Todos os dados permanecem em sua infraestrutura — nenhuma conversa, documento ou prompt sai da sua rede a menos que configure explicitamente APIs externas.

Capacidade offline: Perfeito para ambientes isolados, redes restritas ou situações onde o acesso à internet é instável ou proibido. Ao ser combinado com modelos locais executados via Ollama ou vLLM, você atinge a independência total dos serviços em nuvem.

Rico em recursos: Apesar de ser autosservido, o Open WebUI rivaliza com ofertas comerciais com upload de documentos e RAG, histórico de conversas com busca semântica, modelos de prompt e compartilhamento, gerenciamento de modelos, entrada/saída de voz, design responsivo para dispositivos móveis e temas claro/escuro.

Suporte a múltiplos usuários: Sistema de autenticação integrado com controle de acesso baseado em papéis (administrador, usuário, pendente), painel de gerenciamento de usuários, isolamento de conversas e prompts e modelos compartilhados entre equipes.

Guia Rápido de Instalação

A maneira mais rápida de começar com o Open WebUI é usando o Docker. Esta seção abrange os cenários de implantação mais comuns.

Instalação Básica (Conectando-se a um Ollama Existente)

Se você já tem o Ollama executando em seu sistema, use este comando:

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Isso executa o Open WebUI na porta 3000, persistindo os dados em um volume do Docker. Acesse-o em http://localhost:3000.

Instalação Completa (Open WebUI + Ollama)

Para uma configuração completa de tudo em um só lugar com Ollama incluído:

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

A bandeira --gpus all habilita o acesso à GPU para inferência mais rápida. Omita-a se estiver executando apenas em CPU.

Configuração com Docker Compose

Para implantações de produção, o Docker Compose oferece maior manutenibilidade:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

Implante com docker-compose up -d.

Implantação com Kubernetes

Para implantações empresariais, o Open WebUI fornece gráficos Helm:

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

Isso cria uma implantação pronta para produção com armazenamento persistente, verificações de saúde e configuração opcional de ingresso.

Análise Detalhada das Funcionalidades Principais

RAG e Chat com Documentos

A implementação de RAG do Open WebUI permite que você carregue documentos e tenha o modelo os referenciar em conversas. O sistema divide automaticamente os documentos, gera embeddings, armazena-os em um banco de dados vetorial e recupera o contexto relevante quando você faz perguntas.

Formatos suportados: PDF, DOCX, TXT, Markdown, CSV e mais através de analisadores integrados.

Uso: Clique no botão ‘+’ em uma conversa, selecione ‘Carregar Arquivos’, escolha seus documentos e comece a fazer perguntas. O modelo citará trechos relevantes e números de páginas em suas respostas.

Configuração: Você pode ajustar o tamanho do fragmento, o sobreposição, o modelo de embedding e os parâmetros de recuperação nas configurações do administrador para um desempenho ótimo com seus tipos de documento.

Autenticação e Gerenciamento de Múltiplos Usuários

O Open WebUI inclui um sistema completo de autenticação adequado para uso em equipes e organizações:

- Autenticação local: Nome de usuário/senha com hashing seguro de senha

- Integração OAuth/OIDC: Conecte-se a provedores de identidade existentes (Google, GitHub, Keycloak, etc.)

- LDAP/Active Directory: Integração com diretórios empresariais

- Acesso baseado em papel: Admin (controle total), Usuário (acesso padrão), Pendente (requer aprovação)

Administradores podem gerenciar usuários, monitorar uso, configurar acesso a modelos por usuário/grupo e definir políticas de retenção de conversas.

Entrada e Saída de Voz

O suporte integrado para interação por voz torna o Open WebUI acessível e conveniente:

- Fala para texto: Utiliza a API Web Speech ou serviços STT configurados externamente

- Texto para fala: Vários motores de TTS suportados (baseados em navegador, Coqui TTS, ElevenLabs, etc.)

- Suporte a idiomas: Funciona com múltiplos idiomas dependendo da sua configuração de TTS/STT

Ferramentas de Engenharia de Prompt

O Open WebUI fornece ferramentas robustas para gerenciamento de prompts:

- Biblioteca de prompts: Salve prompts frequentemente usados como modelos

- Variáveis e espaços reservados: Crie prompts reutilizáveis com conteúdo dinâmico

- Compartilhamento de prompts: Compartilhe prompts eficazes com sua equipe

- Versão de prompts: Rastreie alterações e melhorias ao longo do tempo

Gerenciamento de Modelos

Troca fácil e gerenciamento de modelos através da interface do usuário:

- Catálogo de modelos: Navegue e baixe modelos diretamente da biblioteca do Ollama

- Modelos personalizados: Carregue e configure modelos GGUF personalizados

- Parâmetros de modelos: Ajuste temperatura, top-p, comprimento do contexto e outros parâmetros de amostragem por conversa

- Metadados do modelo: Visualize detalhes do modelo, tamanho, quantização e capacidades

Configuração e Personalização

Variáveis de Ambiente

Opções importantes de configuração via variáveis de ambiente:

# URL do backend (Ollama ou outra API compatível com OpenAI)

OLLAMA_BASE_URL=http://localhost:11434

# Ativar autenticação

WEBUI_AUTH=true

# Papel de usuário padrão (usuário, administrador, pendente)

DEFAULT_USER_ROLE=pending

# Ativar cadastro de usuários

ENABLE_SIGNUP=true

# Email do administrador (cria automaticamente uma conta de administrador)

WEBUI_ADMIN_EMAIL=admin@example.com

# Banco de dados (padrão SQLite, ou PostgreSQL para produção)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# Ativar RAG

ENABLE_RAG=true

# Modelo de embedding para RAG

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

Conectando-se a Backends Alternativos

O Open WebUI funciona com qualquer API compatível com OpenAI. Configure a URL base em Configurações → Conexões:

- vLLM:

http://localhost:8000/v1 - LocalAI:

http://localhost:8080 - LM Studio:

http://localhost:1234/v1 - Text Generation WebUI:

http://localhost:5000/v1 - OpenAI:

https://api.openai.com/v1(requer chave de API) - Azure OpenAI: URL do endpoint personalizado

Configuração de Proxy Inverso

Para implantações de produção, execute o Open WebUI atrás de um proxy inverso:

Exemplo de Nginx:

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# Suporte a WebSockets

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Exemplo de Traefik (rótulos de Docker):

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

Otimização de Desempenho

Ajuste do Banco de Dados

Para implantações com múltiplos usuários, mude do SQLite para PostgreSQL:

# Instale dependências

pip install psycopg2-binary

# Configure a URL do banco de dados

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

O PostgreSQL lida melhor com usuários simultâneos e fornece desempenho de consulta melhor para busca de conversas e operações RAG.

Seleção do Modelo de Embedding

O desempenho do RAG depende muito da escolha do seu modelo de embedding:

- Rápido/Recursos limitados:

all-MiniLM-L6-v2(384 dimensões, ~80MB) - Equilibrado:

all-mpnet-base-v2(768 dimensões, ~420MB) - Qualidade superior:

bge-large-en-v1.5(1024 dimensões, ~1,3GB)

Configure em Configurações → RAG → Modelo de Embedding.

Estratégias de Caching

Ative o caching de conversas para reduzir chamadas repetidas à API:

- Caching de modelos: O Ollama automaticamente cacheia modelos carregados em memória

- Caching de respostas: O Open WebUI pode cacheiar prompts idênticos (configurável)

- Caching de embedding: Reutilize embeddings para documentos processados anteriormente

Boas Práticas de Segurança

Ao implantar o Open WebUI em produção, siga estas diretrizes de segurança:

- Ative autenticação: Nunca execute o Open WebUI sem autenticação em redes públicas

- Use HTTPS: Sempre implante atrás de um proxy inverso com TLS/SSL

- Atualizações regulares: Mantenha o Open WebUI e o Ollama atualizados para patches de segurança

- Restrinja o acesso: Use regras de firewall para limitar o acesso a redes confiáveis

- Proteja chaves de API: Se conectando a APIs externas, use variáveis de ambiente, nunca codifique chaves

- Registros de auditoria: Ative e monitore logs de acesso para atividade suspeita

- Backup de dados: Faça backups regulares do volume

/app/backend/data - Criptografia do banco de dados: Ative criptografia em repouso para PostgreSQL em produção

- Limitação de taxa: Configure limites de taxa para prevenir abusos

- Filtragem de conteúdo: Implemente políticas de conteúdo apropriadas para sua organização

Casos de Uso e Aplicações Reais

Assistente de Conhecimento Pessoal

Combine o Open WebUI com modelos locais e RAG para criar uma base de conhecimento privada. Carregue suas notas, artigos de pesquisa, documentação de projetos e documentos pessoais. Consulte-os de forma conversacional sem enviar dados para serviços em nuvem — perfeito para pesquisadores, estudantes e profissionais de conhecimento que valorizam a privacidade.

Colaboração da Equipe de Desenvolvimento

Implante o Open WebUI para sua equipe de desenvolvimento com acesso compartilhado a documentação técnica, especificações de API e conhecimento do código. A funcionalidade RAG permite que os desenvolvedores encontrem rapidamente informações relevantes em milhares de páginas de documentação, enquanto o histórico de conversas ajuda a acompanhar decisões arquitetônicas e discussões técnicas.

Chatbot Interno Empresarial

Organizações podem implantar o Open WebUI atrás de seu firewall com integração SSO, fornecendo aos funcionários um assistente de IA que tem acesso a wikis internos, políticas e procedimentos. O controle baseado em papéis garante que informações sensíveis permaneçam segmentadas apropriadamente, enquanto os controles de administrador mantêm governança e conformidade.

Educação e Treinamento

Instituições educacionais usam o Open WebUI para fornecer a alunos e professores assistência de IA sem preocupações de privacidade. Carregue materiais de curso, livros-texto e notas de aula para perguntas contextualizadas. O sistema de múltiplos usuários permite o rastreamento de uso enquanto mantém os dados dos alunos privados.

Aplicações de Saúde e Direito

Em indústrias regulamentadas onde a privacidade dos dados é crítica, o Open WebUI permite fluxos de trabalho assistidos por IA enquanto mantém a conformidade com HIPAA ou GDPR. Profissionais médicos podem consultar bancos de dados de medicamentos e protocolos de tratamento, enquanto equipes jurídicas podem pesquisar leis e contratos — tudo sem que os dados saiam da infraestrutura controlada.

Ambientes Desconectados e Offline

Agências governamentais, instalações de pesquisa e centros de operações seguros usam o Open WebUI em redes desconectadas. A capacidade total de funcionamento offline garante que a assistência de IA esteja disponível mesmo sem conexão com a internet, crítica para ambientes classificados ou locais remotos.

Solução de Problemas Comuns

Problemas de Conexão

Problema: O Open WebUI não consegue se conectar ao Ollama

Solução: Verifique se o Ollama está em execução (curl http://localhost:11434), confirme a variável de ambiente OLLAMA_BASE_URL, e certifique-se de que as regras de firewall permitem a conexão. Para implantações com Docker, use nomes de serviço (http://ollama:11434) em vez de localhost.

Problema: Modelos não aparecem na interface

Solução: Confirme se os modelos estão instalados (ollama list), atualize a lista de modelos nas configurações do Open WebUI e verifique os logs do navegador para erros de API.

Problemas de Upload de Documentos e RAG

Problema: Falha no upload de documentos

Solução: Verifique os limites de tamanho de arquivo nas configurações, confirme o formato de arquivo suportado, garanta que haja espaço suficiente no volume de dados e revise os logs do contêiner para erros de análise.

Problema: Respostas de RAG não referenciam documentos carregados

Solução: Verifique se o modelo de embedding está baixado e em execução, confirme as configurações de tamanho de fragmento (tente fragmentos menores para melhor granularidade), aumente o número de fragmentos recuperados nas configurações de RAG e certifique-se de que a pergunta esteja relacionada ao conteúdo do documento.

Problemas de Desempenho

Problema: Respostas lentas

Solução: Ative a aceleração por GPU se disponível, reduza o tamanho do modelo ou use versões quantizadas, aumente OLLAMA_NUM_PARALLEL para solicitações concorrentes e alocar mais RAM para contêineres do Docker.

Problema: Erros de memória insuficiente

Solução: Use modelos menores (7B em vez de 13B de parâmetros), reduza o comprimento do contexto nos parâmetros do modelo, limite usuários simultâneos ou adicione mais RAM/swap ao seu sistema.

Autenticação e Acesso

Problema: Não consigo me logar ou criar uma conta de administrador

Solução: Defina WEBUI_AUTH=true, configure WEBUI_ADMIN_EMAIL para criar automaticamente uma conta de administrador, limpe os cookies e cache do navegador e verifique os logs do contêiner para erros do banco de dados.

Problema: Usuários não conseguem se inscrever

Solução: Verifique ENABLE_SIGNUP=true, confirme a configuração DEFAULT_USER_ROLE (use user para aprovação automática ou pending para aprovação manual) e certifique-se de que o banco de dados está gravável.

Alternativas ao Open WebUI

Embora o Open WebUI excelente em fornecer uma interface autosservida com forte integração com Ollama, várias alternativas oferecem abordagens diferentes para o mesmo espaço de problema. Sua escolha depende de se você precisa de flexibilidade multi-provedor, manipulação especializada de documentos, simplicidade extrema ou recursos empresariais.

LibreChat se destaca como a solução mais agnóstica de provedor, oferecendo suporte nativo a OpenAI, Anthropic, Azure OpenAI, Google Vertex AI, AWS Bedrock e Ollama em uma única interface. Sua arquitetura de plugin e recursos empresariais como multi-tenancy, controles de acesso detalhados e quotas de uso tornam-a ideal para organizações que precisam suportar múltiplos provedores de IA ou requerem rastreamento de auditoria sofisticado. A compensação é a complexidade — LibreChat requer mais esforço de configuração e recursos mais pesados do que Open WebUI, e seu suporte a Ollama parece secundário aos provedores em nuvem. Se sua equipe usa Claude para escrever, GPT-4 para codificação e modelos locais para trabalhos sensíveis à privacidade, a interface unificada do LibreChat brilha.

Para fluxos de trabalho pesados em documentos, AnythingLLM adota uma abordagem de base de conhecimento primeiro que vai além do RAG básico. Seu modelo de workspace organiza documentos e conversas em ambientes isolados, enquanto recursos avançados de recuperação incluem busca híbrida, reclassificação e rastreamento de citações. Conectores de dados puxam conteúdo de GitHub, Confluence e Google Drive, e capacidades de agentes permitem raciocínio multi-etapa e automação de fluxo de trabalho. Isso torna o AnythingLLM excelente para consultorias que gerenciam múltiplas bases de conhecimento de clientes ou equipes de suporte que trabalham com documentação extensa. A interface de chat é menos polida do que a do Open WebUI, mas se a sua necessidade principal é consultar grandes coleções de documentos, as capacidades avançadas de recuperação justificam a curva de aprendizado mais acentuada.

LobeChat prioriza a experiência do usuário sobre a profundidade de recursos, oferecendo uma interface moderna e amigável para dispositivos móveis com capacidades de PWA. Seu design moderno, animações suaves e forte suporte a voz/multimodal tornam-no popular com designers e usuários não técnicos que desejam um assistente de IA que funcione de forma fluida em dispositivos. A implementação PWA fornece uma experiência de aplicativo semelhante à de mobile que o Open WebUI não iguala. No entanto, recursos empresariais são limitados, o ecossistema de plugins é menor e as capacidades de RAG ficam para trás tanto do Open WebUI quanto do AnythingLLM.

Para usuários que preferem aplicações de desktop, Jan.ai oferece instaladores multiplataforma (Windows, macOS, Linux) com gerenciamento local de modelos sem configuração. Não é necessário instalar o Ollama separadamente ou lidar com o Docker — o Jan embala tudo em uma aplicação nativa com suporte a bandeja do sistema e downloads de modelos com um clique. Essa filosofia de “funciona assim que você abre” torna o Jan ideal para dar LLMs locais a familiares ou colegas que não estão confortáveis com ferramentas de linha de comando. As compensações são a ausência de suporte multiusuário, menos recursos avançados e a ausência de capacidade de acesso remoto.

Chatbox ocupa o nicho leve — um cliente cross-platform mínimo que suporta OpenAI, Claude, Gemini e APIs locais com muito baixo custo de recursos. É perfeito para desenvolvedores que precisam testar rapidamente diferentes provedores de API ou usuários com hardware de recursos limitados. A fricção de instalação é mínima, mas alguns recursos são limitados por assinatura, não é totalmente aberto e o suporte a RAG é limitado.

Várias interfaces mínimas específicas para Ollama existem para usuários que desejam “apenas o suficiente”: Hollama gerencia múltiplos servidores Ollama em diferentes máquinas, Ollama UI fornece chat básico e upload de PDF com implantação extremamente fácil, e Oterm oferece uma interface baseada em terminal surpreendentemente capaz para sessões SSH e fluxos de trabalho tmux. Essas sacrificam recursos para simplicidade e velocidade.

Para organizações que exigem suporte de fornecedor, opções comerciais como TypingMind Team, BionicGPT e Dust.tt oferecem hospedagem autosservida com suporte profissional, certificações de conformidade e SLAs. Elas trocam a liberdade de código aberto por garantia de tempo de atividade, auditorias de segurança e responsabilidade — apropriadas quando sua organização precisa de contratos de suporte empresarial.

Escolha sabiamente: O Open WebUI atinge o ponto ideal para a maioria das implantações autosservidas de Ollama, equilibrando recursos abrangentes com complexidade gerenciável. Escolha o LibreChat quando a flexibilidade multi-provedor for primordial, o AnythingLLM para fluxos de trabalho de documentos sofisticados, o LobeChat para usuários móveis ou conscientes de design, o Jan para usuários de desktop não técnicos ou opções comerciais quando você precisar de suporte de fornecedor. Para a maioria dos usuários técnicos que executam modelos locais, o Open WebUI, com seu desenvolvimento ativo, forte comunidade e excelente implementação de RAG, é a escolha recomendada para começar.

Desenvolvimentos Futuros e Roadmap

O Open WebUI continua com desenvolvimento rápido com várias funcionalidades emocionantes no roadmap:

Melhor suporte multimodal: Melhor tratamento de imagens, modelos de visão e conversas multimodais com modelos como LLaVA e Bakllava.

Capacidades de agentes aprimoradas: Chamada de função, uso de ferramentas e fluxos de trabalho de raciocínio multi-etapa semelhantes aos padrões do AutoGPT.

Melhores apps para dispositivos móveis: Aplicações nativas para iOS e Android além da atual implementação PWA para melhor experiência móvel.

Funcionalidades avançadas de RAG: RAG baseado em gráfico, chunking semântico, recuperação de multi-consulta e recuperação de documentos-pai para melhor contexto.

Funcionalidades colaborativas: Conversas compartilhadas, espaços de trabalho de equipe e colaboração em tempo real em prompts e documentos.

Integrações empresariais: Suporte mais profundo a SSO, provisionamento SCIM, logs de auditoria avançados e relatórios de conformidade para indústrias regulamentadas.

O projeto mantém a compatibilidade para trás e versionamento semântico, tornando as atualizações fáceis. O repositório ativo no GitHub vê commits diários e gestão de problemas responsiva.

Conclusão

O Open WebUI evoluiu de uma simples interface frontend do Ollama para uma plataforma abrangente para interações de IA autosservida. Sua combinação de privacidade, recursos e facilidade de implantação o torna uma excelente escolha para indivíduos, equipes e organizações que desejam aproveitar modelos de LLM locais sem sacrificar capacidades.

Seja você um desenvolvedor testando modelos, uma organização construindo ferramentas de IA internas ou um indivíduo priorizando privacidade, o Open WebUI fornece a base para fluxos de trabalho de IA autosservida poderosos. A comunidade ativa, atualizações regulares e arquitetura extensível garantem que ele permaneça uma opção líder no espaço de IA autosservida.

Comece com a instalação básica do Docker, experimente o RAG carregando alguns documentos, tente diferentes modelos da biblioteca do Ollama e gradualmente explore funcionalidades avançadas conforme suas necessidades crescem. A curva de aprendizado é suave, mas o teto é alto — o Open WebUI escala de um laptop pessoal a um cluster Kubernetes empresarial.

Para aqueles que estão comparando alternativas, o design Ollama-first do Open WebUI, seu conjunto equilibrado de recursos e seu desenvolvimento ativo o tornam o ponto de partida recomendado para a maioria das implantações de LLM autosservidas. Você sempre pode migrar para soluções mais especializadas se surgirem necessidades específicas, mas muitos usuários encontram as capacidades do Open WebUI suficientes para sua jornada completa de experimentação até produção.

Para ver como os backends típicos do Open WebUI (Ollama, vLLM, etc.) se encaixam com o Docker Model Runner, LocalAI e provedores em nuvem, consulte nosso guia LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Links Úteis

Ao configurar seu ambiente do Open WebUI, você se beneficiará de compreender o ecossistema mais amplo de hospedagem e opções de implantação de LLM locais. O guia abrangente Local LLM Hosting: Complete 2025 Guide - Ollama, vLLM, LocalAI, Jan, LM Studio & More compara 12+ ferramentas locais de LLM incluindo Ollama, vLLM, LocalAI e outras, ajudando você a escolher o backend ideal para sua implantação do Open WebUI com base na maturidade da API, capacidades de chamada de ferramentas e benchmarks de desempenho.

Para implantações de produção de alto desempenho onde throughput e latência são críticos, explore o guia vLLM Quickstart: High-Performance LLM Serving, que abrange a configuração do vLLM com Docker, compatibilidade com API OpenAI e otimização PagedAttention. Isso é particularmente valioso se o Open WebUI estiver servindo múltiplos usuários simultâneos e o desempenho do Ollama se tornar um gargalo.

Entender como seu backend lida com solicitações concorrentes é crucial para planejamento de capacidade. O artigo How Ollama Handles Parallel Requests explica a filas de solicitações do Ollama, gerenciamento de memória da GPU e modelo de execução concorrente, ajudando você a configurar limites e expectativas apropriados para cenários de múltiplos usuários em sua implantação do Open WebUI.

Recursos Externos

Para documentação oficial e suporte da comunidade, consulte estes recursos externos: