Zaawansowane reprezentacje przekrojowe: łączenie trybów AI

Zjednocz tekst, obrazy i dźwięk w współdzielonych przestrzeniach osadzeń.

Przestrzenne reprezentacje przekrojowe stanowią przełom w sztucznej inteligencji, umożliwiając zrozumienie i rozumowanie na przekrój danych w jednolitej przestrzeni reprezentacji.

Ta technologia napędza współczesne aplikacje wieloczuciowe od wyszukiwania obrazów po generowanie treści.

Ten obraz pochodzi z artykułu:

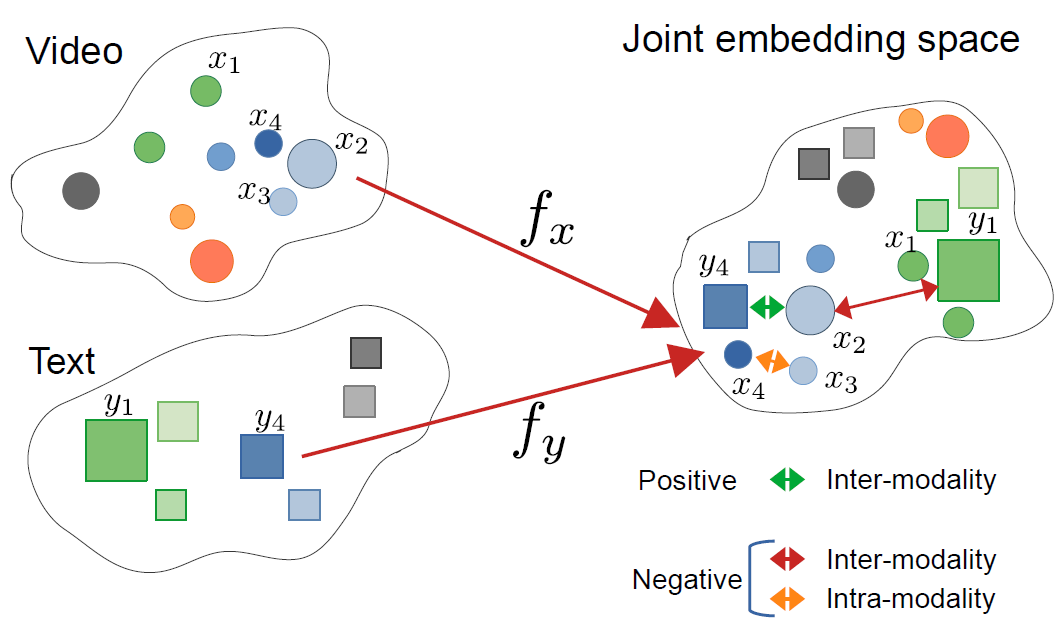

CrossCLR: przekrojowe uczenie kontrastowe dla reprezentacji wideo wieloczuciowych, autorstwa Mohammadreza Zolfaghari i innych

Ten obraz pochodzi z artykułu:

CrossCLR: przekrojowe uczenie kontrastowe dla reprezentacji wideo wieloczuciowych, autorstwa Mohammadreza Zolfaghari i innych

Zrozumienie przestrzennych reprezentacji przekrojowych

Przestrzenne reprezentacje przekrojowe to wektorowe reprezentacje, które kodują informację z różnych modalności – takich jak tekst, obrazy, dźwięk i wideo – w wspólną przestrzeń reprezentacji. W przeciwieństwie do tradycyjnych reprezentacji jednomodalnych, podejścia przekrojowe uczą się jednolitej reprezentacji, w której koncepcje semantycznie podobne łączą się razem, niezależnie od swojej oryginalnej formy.

Co to są przestrzenne reprezentacje przekrojowe?

W swoim sercu, przestrzenne reprezentacje przekrojowe rozwiązują kluczowy problem w AI: jak porównywać i powiązywać informację między różnymi typami danych. Tradycyjny klasyfikator obrazów może działać tylko z obrazami, podczas gdy model tekstowy obsługuje tylko tekst. Przestrzenne reprezentacje przekrojowe łagodzą tę przeszkodę, projektując różne modalności w wspólną przestrzeń wektorową, gdzie:

- Obraz kota i słowo “kot” mają podobne wektory reprezentacji

- Relacje semantyczne są zachowywane między modalnościami

- Miary odległości (podobieństwo kosinusowe, odległość euklidesowa) mierzą podobieństwo przekrojowe

Ta jednolita reprezentacja umożliwia potężne możliwości, takie jak wyszukiwanie obrazów za pomocą zapytań tekstowych, generowanie opisów na podstawie obrazów, a nawet klasyfikacja zero-shot bez treningu specyficznego dla zadania.

Architektura za Cross-Modal Learning

Nowoczesne systemy przekrojowe zazwyczaj wykorzystują architektury dualnych encoderów z celami uczenia kontrastowego:

Dualne encodery: Odrębne sieci neuronowe kodują każdą modalność. Na przykład CLIP używa:

- Transformera wizualnego (ViT) lub ResNet dla obrazów

- Transformera opartego na języku dla języka

Uczenie kontrastowe: Model uczy się maksymalizując podobieństwo między pasującymi pарамi (np. obraz i jego opis) a minimalizując podobieństwo między niepasującymi pарамi. Funkcja straty kontrastowej może być wyrażona jako:

$$ \mathcal{L} = -\log \frac{\exp(\text{sim}(v_i, t_i) / \tau)}{\sum_{j=1}^{N} \exp(\text{sim}(v_i, t_j) / \tau)} $$

gdzie $v_i$ to wektor reprezentacji obrazu, $t_i$ to wektor reprezentacji tekstu, $\text{sim}$ to podobieństwo (zwykle kosinusowe), a $\tau$ to parametr temperatury.

Kluczowe technologie i modele

CLIP: Pionierski zrozumienie wizualno-językowe

CLIP (Kontrastowe uczenie wstępne wizualno-językowe) firmy OpenAI przełamał pola, ucząc się na 400 milionach par obraz-tekst z internetu. Architektura modelu składa się z:

import torch

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

# Załaduj wstępnie wytrenowany model CLIP

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# Przygotuj dane wejściowe

image = Image.open("example.jpg")

texts = ["fotografia kota", "fotografia psa", "fotografia ptaka"]

# Przetwórz i uzyskaj reprezentacje

inputs = processor(text=texts, images=image, return_tensors="pt", padding=True)

# Uzyskaj wyniki podobieństwa przekrojowego

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = logits_per_image.softmax(dim=1)

print(f"Prawdopodobieństwa: {probs}")

Kluczową innowacją CLIP było skalowanie i prostota. Poprzez trening na ogromnych danych internetowych bez ręcznych anotacji, osiągnął niezwykłą zdolność transferu zero-shot. Jak CLIP różni się od tradycyjnych modeli wizualnych? W przeciwieństwie do nadzorowanych klasyfikatorów trenowanych na ustalonych zestawach etykiet, CLIP uczy się od nadzoru językowego, co czyni go elastycznym do dowolnego pojęcia wizualnego opisanego w tekście.

ImageBind: Rozszerzanie do sześciu modalności

ImageBind firmy Meta rozszerza przestrzenne reprezentacje przekrojowe poza wizję i język, w tym:

- Dźwięk (środowiskowe dźwięki, mowa)

- Głębia (informacja głębiowa)

- Termografia

- Dane z czujnika IMU (czujnika ruchu)

To tworzy naprawdę wieloczuciową przestrzeń reprezentacji, w której wszystkie sześć modalności są wyrównane. Kluczowe spostrzeżenie to to, że obrazy pełnią rolę “wiążącej” modalności – łącząc obrazy z innymi modalnościami i wykorzystując istniejące wyrównanie wizualno-językowe, ImageBind tworzy jednolitą przestrzeń bez konieczności wszystkich możliwych par modalności podczas treningu.

Otwarte źródło alternatywy

Ekosystem rozszerzył się z kilkoma implementacjami open source:

OpenCLIP: Implementacja społeczności oferująca większe modele i różnorodne receptury treningowe:

import open_clip

model, _, preprocess = open_clip.create_model_and_transforms(

'ViT-L-14',

pretrained='laion2b_s32b_b82k'

)

tokenizer = open_clip.get_tokenizer('ViT-L-14')

Modele LAION-5B: Wytrenowane na ogromnym otwartym zestawie danych LAION-5B, oferują alternatywy dla modeli własnościowych z porównywalną lub lepszą wydajnością.

Dla programistów zainteresowanych najnowszymi otwartymi modelami wstępnego wstawiania tekstu, Modele Qwen3 Embedding & Reranker na Ollama oferują świetną wydajność multyjęzyczną z łatwym lokalnym wdrożeniem.

Strategie implementacji

Budowanie systemu wyszukiwania przekrojowego

Praktyczna implementacja przestrzennych reprezentacji przekrojowych dla wyszukiwania semantycznego obejmuje kilka komponentów. Jakie są główne zastosowania przestrzennych reprezentacji przekrojowych? Napędzają przypadki użycia od wyszukiwania produktów w e-commerce do moderacji treści i narzędzi kreatywnych.

import numpy as np

from typing import List, Tuple

import faiss

from transformers import CLIPModel, CLIPProcessor

class CrossModalSearchEngine:

def __init__(self, model_name: str = "openai/clip-vit-base-patch32"):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.image_index = None

self.image_metadata = []

def encode_images(self, images: List) -> np.ndarray:

"""Koduj obrazy w reprezentacje"""

inputs = self.processor(images=images, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_image_features(**inputs)

return embeddings.cpu().numpy()

def encode_text(self, texts: List[str]) -> np.ndarray:

"""Koduj zapytania tekstowe w reprezentacje"""

inputs = self.processor(text=texts, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_text_features(**inputs)

return embeddings.cpu().numpy()

def build_index(self, image_embeddings: np.ndarray):

"""Stwórz indeks FAISS dla efektywnego wyszukiwania podobieństwa"""

dimension = image_embeddings.shape[1]

# Normalizuj reprezentacje dla podobieństwa kosinusowego

faiss.normalize_L2(image_embeddings)

# Utwórz indeks (używając HNSW dla dużych wdrożeń)

self.image_index = faiss.IndexHNSWFlat(dimension, 32)

self.image_index.hnsw.efConstruction = 40

self.image_index.add(image_embeddings)

def search(self, query: str, k: int = 10) -> List[Tuple[int, float]]:

"""Wyszukaj obrazy za pomocą zapytania tekstowego"""

query_embedding = self.encode_text([query])

faiss.normalize_L2(query_embedding)

distances, indices = self.image_index.search(query_embedding, k)

return list(zip(indices[0], distances[0]))

# Przykład użycia

engine = CrossModalSearchEngine()

# Budowanie indeksu z kolekcji obrazów

image_embeddings = engine.encode_images(image_collection)

engine.build_index(image_embeddings)

# Wyszukiwanie z tekstu

results = engine.search(" zachód słońca nad górami", k=5)

Fine-tuning do zadań specyficznych dla dziedziny

Choć wstępnie wytrenowane modele dobrze działają w ogólnych celach, aplikacje specyficzne dla dziedziny korzystają z fine-tuning:

from transformers import CLIPModel, CLIPProcessor, AdamW

import torch.nn as nn

class FineTuneCLIP:

def __init__(self, model_name: str, num_epochs: int = 10):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.num_epochs = num_epochs

def contrastive_loss(self, image_embeddings, text_embeddings, temperature=0.07):

"""Oblicz InfoNCE stratę kontrastową"""

# Normalizuj reprezentacje

image_embeddings = nn.functional.normalize(image_embeddings, dim=1)

text_embeddings = nn.functional.normalize(text_embeddings, dim=1)

# Oblicz macierz podobieństwa

logits = torch.matmul(image_embeddings, text_embeddings.T) / temperature

# Etykiety są diagonalne (pasujące pary)

labels = torch.arange(len(logits), device=logits.device)

# Strata symetryczna

loss_i = nn.functional.cross_entropy(logits, labels)

loss_t = nn.functional.cross_entropy(logits.T, labels)

return (loss_i + loss_t) / 2

def train(self, dataloader, learning_rate=5e-6):

"""Fine-tuning na danych specyficznych dla dziedziny"""

optimizer = AdamW(self.model.parameters(), lr=learning_rate)

self.model.train()

for epoch in range(self.num_epochs):

total_loss = 0

for batch in dataloader:

images, texts = batch['images'], batch['texts']

# Przetwórz dane wejściowe

inputs = self.processor(

text=texts,

images=images,

return_tensors="pt",

padding=True

)

# Przepływ w przód

outputs = self.model(**inputs, return_loss=True)

loss = outputs.loss

# Przepływ w tył

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"Epoka {epoch+1}/{self.num_epochs}, Strata: {avg_loss:.4f}")

Rozważania dotyczące wdrażania w produkcji

Optymalizacja wydajności wnioskowania

Jak mogę zoptymalizować przestrzenne reprezentacje przekrojowe dla produkcji? Optymalizacja wydajności jest kluczowa dla rzeczywistego wdrażania:

Kwantyzacja modelu: Zmniejsz rozmiar modelu i zwiększ szybkość wnioskowania:

import torch

from torch.quantization import quantize_dynamic

# Kwantyzacja dynamiczna dla wnioskowania na CPU

quantized_model = quantize_dynamic(

model,

{torch.nn.Linear},

dtype=torch.qint8

)

Konwersja do ONNX: Eksportuj do ONNX dla zoptymalizowanego wnioskowania:

import torch.onnx

dummy_input = processor(text=["przykład"], return_tensors="pt")

torch.onnx.export(

model,

tuple(dummy_input.values()),

"clip_model.onnx",

input_names=['input_ids', 'attention_mask'],

output_names=['output'],

dynamic_axes={

'input_ids': {0: 'batch_size'},

'attention_mask': {0: 'batch_size'}

}

)

Przetwarzanie wsadowe: Maksymalizuj wykorzystanie GPU za pomocą wsadowego przetwarzania:

def batch_encode(items: List, batch_size: int = 32):

"""Przetwarzaj elementy w partii dla wydajności"""

embeddings = []

for i in range(0, len(items), batch_size):

batch = items[i:i+batch_size]

batch_embeddings = encode_batch(batch)

embeddings.append(batch_embeddings)

return np.concatenate(embeddings, axis=0)

Skalowalne przechowywanie wektorów

Dla dużych aplikacji, bazy danych wektorów są kluczowe. Jakie ramy wspierają implementacje przestrzennych reprezentacji przekrojowych? Później niż same modele, infrastruktura ma znaczenie:

FAISS (Facebook AI Similarity Search): Wydajna biblioteka wyszukiwania podobieństwa

- Obsługuje miliardy wektorów

- Wiele typów indeksów (flata, IVF, HNSW)

- Dostępna akceleracja GPU

Milvus: Otwarta baza danych wektorów

from pymilvus import connections, Collection, FieldSchema, CollectionSchema, DataType

# Zdefiniuj schemat

fields = [

FieldSchema(name="id", dtype=DataType.INT64, is_primary=True, auto_id=True),

FieldSchema(name="embedding", dtype=DataType.FLOAT_VECTOR, dim=512),

FieldSchema(name="metadata", dtype=DataType.JSON)

]

schema = CollectionSchema(fields, description="Wektory obrazów")

# Utwórz kolekcję

collection = Collection("obrazy", schema)

# Utwórz indeks

index_params = {

"metric_type": "IP", # Iloczyn skalarny (podobieństwo kosinusowe)

"index_type": "IVF_FLAT",

"params": {"nlist": 1024}

}

collection.create_index("embedding", index_params)

Pinecone/Weaviate: Usługi zarządzanej bazy danych wektorów oferujące łatwe skalowanie i utrzymanie.

Zaawansowane zastosowania i aplikacje

Klasyfikacja zero-shot

Przestrzenne reprezentacje przekrojowe umożliwiają klasyfikację bez treningu specyficznego dla zadania. Ta zdolność rozciąga się poza tradycyjne podejścia wizualne – na przykład, jeśli jesteś zainteresowany bardziej specjalizowanym wykrywaniem obiektów z TensorFlow, to reprezentuje uzupełniające podejście nadzorowane do konkretnych zadań wykrywania.

def zero_shot_classify(image, candidate_labels: List[str], model, processor):

"""Klasyfikuj obraz w dowolne kategorie"""

# Utwórz tekstowe podpowiedzi

text_inputs = [f"zdjęcie {label}" for label in candidate_labels]

# Uzyskaj reprezentacje

inputs = processor(

text=text_inputs,

images=image,

return_tensors="pt",

padding=True

)

outputs = model(**inputs)

# Oblicz prawdopodobieństwa

logits = outputs.logits_per_image

probs = logits.softmax(dim=1)

# Zwroc posortowane przewidywania

sorted_indices = probs.argsort(descending=True)[0]

return [(candidate_labels[idx], probs[0][idx].item()) for idx in sorted_indices]

# Przykład użycia

labels = ["kot", "pies", "ptak", "ryba", "krowa"]

predictions = zero_shot_classify(image, labels, model, processor)

print(f"Najlepsze przewidywanie: {predictions[0]}")

Wieloczuciowy RAG (Retrieval-Augmented Generation)

Połączenie przestrzennych reprezentacji przekrojowych z modelami językowymi tworzy potężne systemy RAG wieloczuciowe. Po wyprowadzeniu odpowiednich dokumentów, ponowne sortowanie z modelami reprezentacji może znacząco poprawić jakość wyników, sortując ponownie wybrane kandydaty na podstawie ważności:

class MultimodalRAG:

def __init__(self, clip_model, llm_model):

self.clip = clip_model

self.llm = llm_model

self.knowledge_base = []

def add_documents(self, images, texts, metadata):

"""Dodaj dokumenty wieloczuciowe do bazy wiedzy"""

image_embeds = self.clip.encode_images(images)

text_embeds = self.clip.encode_text(texts)

# Przechowuj połączone informacje

for i, (img_emb, txt_emb, meta) in enumerate(

zip(image_embeds, text_embeds, metadata)

):

self.knowledge_base.append({

'image_embedding': img_emb,

'text_embedding': txt_emb,

'metadata': meta,

'index': i

})

def retrieve(self, query: str, k: int = 5):

"""Wyprowadź odpowiednie treści wieloczuciowe"""

query_embedding = self.clip.encode_text([query])[0]

# Oblicz podobieństwa

similarities = []

for doc in self.knowledge_base:

# Średnie podobieństwo między modalnościami

img_sim = np.dot(query_embedding, doc['image_embedding'])

txt_sim = np.dot(query_embedding, doc['text_embedding'])

combined_sim = (img_sim + txt_sim) / 2

similarities.append((combined_sim, doc))

# Zwroc top-k

similarities.sort(reverse=True)

return [doc for _, doc in similarities[:k]]

def answer_query(self, query: str):

"""Odpowiedz na zapytanie za pomocą wyprowadzonych treści wieloczuciowych"""

retrieved_docs = self.retrieve(query)

# Utwórz kontekst z wyprowadzonych dokumentów

context = "\n".join([doc['metadata']['text'] for doc in retrieved_docs])

# Wygeneruj odpowiedź z LLM

prompt = f"Kontekst:\n{context}\n\nPytanie: {query}\n\nOdpowiedź:"

answer = self.llm.generate(prompt)

return answer, retrieved_docs

Jeśli implementujesz systemy RAG w produkcji w Go, możesz znaleźć tę wskazówkę na ponowne sortowanie dokumentów tekstowych z Ollama i modelem Qwen3 Embedding w Go szczególnie przydatną do optymalizacji jakości wyprowadzania.

Moderacja treści i bezpieczeństwo

Przestrzenne reprezentacje przekrojowe wyróżniają się w wykrywaniu nieodpowiednich treści na przekrój modalności:

class ContentModerator:

def __init__(self, model, processor):

self.model = model

self.processor = processor

# Zdefiniuj kategorie bezpieczeństwa

self.unsafe_categories = [

"naruszające prawa",

"treści nieodpowiednie",

"obraz nienawiści",

"graficzne przemoc",

"eksplicytne treści"

]

self.safe_categories = [

"bezpieczne do pracy",

"dla rodziny",

"edukacyjne treści"

]

def moderate_image(self, image, threshold: float = 0.3):

"""Sprawdź, czy obraz zawiera niebezpieczne treści"""

# Połącz wszystkie kategorie

all_categories = self.unsafe_categories + self.safe_categories

text_inputs = [f"obraz zawierający {cat}" for cat in all_categories]

# Uzyskaj przewidywania

inputs = self.processor(

text=text_inputs,

images=image,

return_tensors="pt"

)

outputs = self.model(**inputs)

probs = outputs.logits_per_image.softmax(dim=1)[0]

# Sprawdź kategorie niebezpieczne

unsafe_scores = probs[:len(self.unsafe_categories)]

max_unsafe_score = unsafe_scores.max().item()

return {

'is_safe': max_unsafe_score < threshold,

'confidence': 1 - max_unsafe_score,

'flagged_categories': [

self.unsafe_categories[i]

for i, score in enumerate(unsafe_scores)

if score > threshold

]

}

Najlepsze praktyki i typowe pułapki

Przetwarzanie danych

Poprawne przetwarzanie danych jest kluczowe dla optymalnej wydajności:

from torchvision import transforms

# Standardowe przetwarzanie CLIP

clip_transform = transforms.Compose([

transforms.Resize(224, interpolation=transforms.InterpolationMode.BICUBIC),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(

mean=[0.48145466, 0.4578275, 0.40821073],

std=[0.26862954, 0.26130258, 0.27577711]

)

])

Obsługa biasu i sprawiedliwości

Modele przekrojowe mogą dziedziczyć biasy z danych treningowych:

Strategie zmniejszania biasu:

- Ocena na różnych grupach demograficznych

- Użycie technik zmniejszania biasu podczas fine-tuning

- Implementacja sprawiedliwego wyszukiwania

- Regularne audytowanie i monitorowanie w produkcji

Ocena jakości reprezentacji

Monitoruj jakość reprezentacji w produkcji:

def assess_embedding_quality(embeddings: np.ndarray):

"""Oblicz metryki jakości reprezentacji"""

# Oblicz średnią odległość par

distances = np.linalg.norm(

embeddings[:, None] - embeddings[None, :],

axis=2

)

avg_distance = distances.mean()

# Sprawdź grupowanie (niskie odległości wewnątrz grupy)

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=10)

labels = kmeans.fit_predict(embeddings)

# Oblicz wynik silhouette

from sklearn.metrics import silhouette_score

score = silhouette_score(embeddings, labels)

return {

'avg_pairwise_distance': avg_distance,

'silhouette_score': score

}

Przykład wdrażania w Dockerze

Opakuj swoje aplikacje przekrojowe do łatwego wdrażania:

FROM nvidia/cuda:11.8.0-cudnn8-runtime-ubuntu22.04

# Zainstaluj Python i zależności

RUN apt-get update && apt-get install -y python3-pip

WORKDIR /app

# Zainstaluj wymagania

COPY requirements.txt .

RUN pip3 install --no-cache-dir -r requirements.txt

# Skopiuj kod aplikacji

COPY . .

# Wyświetl port API

EXPOSE 8000

# Uruchom serwer API

CMD ["uvicorn", "api:app", "--host", "0.0.0.0", "--port", "8000"]

# api.py - serwer FastAPI dla przestrzennych reprezentacji przekrojowych

from fastapi import FastAPI, File, UploadFile

from pydantic import BaseModel

import torch

from PIL import Image

import io

app = FastAPI()

# Załaduj model przy starcie

@app.on_event("startup")

async def load_model():

global model, processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

if torch.cuda.is_available():

model = model.cuda()

class TextQuery(BaseModel):

text: str

@app.post("/embed/text")

async def embed_text(query: TextQuery):

inputs = processor(text=[query.text], return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_text_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/embed/image")

async def embed_image(file: UploadFile = File(...)):

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(images=image, return_tensors="pt")

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_image_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/similarity")

async def compute_similarity(

text: TextQuery,

file: UploadFile = File(...)

):

# Uzyskaj oba embeddingi

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(text=[text.text], images=image, return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

outputs = model(**inputs)

similarity = outputs.logits_per_image[0][0].item()

return {"similarity": similarity}

Przyszłe kierunki

Pole przestrzennych reprezentacji przekrojowych nadal szybko ewoluuje:

Większa pokrycie modalności: Przyszłe modele prawdopodobnie włączą dodatkowe modalności, takie jak dotyk (odpowiedź haptic), zapach i smak danych dla prawdziwie kompleksowego zrozumienia wieloczuciowego.

Poprawiona wydajność: Badania nad distylacją i wydajnymi architekturami sprawią, że potężne modele przekrojowe będą dostępne na urządzeniach na krawędzi.

Lepsze wyrównanie: Zaawansowane techniki wyrównania modalności, w tym cykliczne straty spójności i trening przeciwników.

Zrozumienie kompozycyjne: Przejście poza prostym rozpoznawaniem obiektów do zrozumienia złożonych relacji i kompozycji na przekrój modalności.

Modelowanie czasowe: Lepsze obsługiwanie wideo i danych szeregów czasowych z jawnym rozumowaniem czasowym w przestrzeniach reprezentacji.

Przydatne linki

- Repozytorium OpenAI CLIP

- OpenCLIP: Otwarta implementacja

- Dokumentacja Hugging Face Transformers

- Meta ImageBind

- Zestaw danych LAION-5B

- Dokumentacja FAISS

- Baza danych wektorów Milvus

- Baza danych wektorów Pinecone

- Artykuł: Learning Transferable Visual Models From Natural Language Supervision

- Artykuł: ImageBind: One Embedding Space To Bind Them All

- Wykrywanie obiektów z TensorFlow

- Ponowne sortowanie z modelami reprezentacji

- Ponowne sortowanie dokumentów tekstowych z Ollama i modelem Qwen3 Embedding w Go

- Modele Qwen3 Embedding & Reranker na Ollama: Najnowsza wydajność

Przestrzenne reprezentacje przekrojowe reprezentują przeskok w sposobie, w jaki systemy AI przetwarzają i zrozumiewają informację. Poprzez rozbijanie barier między różnymi typami danych, te techniki umożliwiają bardziej naturalne i potężne aplikacje AI. Niezależnie od tego, czy budujesz systemy wyszukiwania, narzędzia moderacji treści czy aplikacje kreatywne, opanowanie przestrzennych reprezentacji przekrojowych otwiera świat możliwości dla innowacji w AI wieloczuciowych.