Interfejsy chatu dla lokalnych instancji Ollama

Krótki przegląd najbardziej wyraźnych interfejsów użytkownika dla Ollama w 2025 roku

Lokalnie hostowane Ollama umożliwia uruchomienie dużych modeli językowych na własnym komputerze, ale korzystanie z niego za pośrednictwem wiersza poleceń nie jest przyjazne dla użytkownika. Oto kilka projektów open source, które oferują interfejsy stylu ChatGPT, łączące się z lokalnym Ollama.

Te interfejsy graficzne obsługują konwersacyjny chat, często z funkcjami takimi jak przesyłanie dokumentów w celu generowania zwiększonego przez odzyskanie (RAG), a także działają jako aplikacje sieciowe lub desktopowe. Poniżej znajduje się porównanie kluczowych opcji, po czym omówione zostaną szczegółowo każda z nich. Aby uzyskać ogólny pogląd na to, jak lokalny Ollama współgra z vLLM, Docker Model Runner, LocalAI i dostawcami chmurowymi – w tym kosztach i wadach systemowych – zobacz Hostowanie LLM: Porównanie lokalnego, samodzielnie hostowanego i infrastruktury w chmurze.

Porównanie interfejsów graficznych kompatybilnych z Ollama

| Narzędzie interfejsu | Platforma | Wsparcie dla dokumentów | Integracja z Ollama | Zalety | Ograniczenia |

|---|---|---|---|---|---|

| Page Assist | Rozszerzenie przeglądarki (Chrome, Firefox) | Tak – dodaj pliki do analizy | Łączy się z lokalnym Ollama za pośrednictwem konfiguracji rozszerzenia | Chat w przeglądarce; łatwe zarządzanie modelami i integracja z kontekstem strony webowej | Tylko w przeglądarce; wymaga instalacji i konfiguracji rozszerzenia |

| Open WebUI | Aplikacja sieciowa (samodzielnie hostowana; Docker/PWA) | Tak – wbudowany RAG (przesyłanie dokumentów lub dodawanie do biblioteki) | Wbudowane wsparcie API Ollama lub serwer (konfiguracja adresu URL) | Wiele funkcji (wiele modeli LLM, offline, generowanie obrazów); mobilne (PWA) | Wymaga bardziej złożonej konfiguracji (Docker/K8s); szeroki zakres może być nadmiernie rozbudowany dla prostego użycia |

| LobeChat | Aplikacja sieciowa (samodzielnie hostowana; PWA) | Tak – „Baza wiedzy” z przesyłaniem plików (PDF, obrazy itd.) | Obsługuje Ollama jako jedną z wielu możliwości (wymaga włączenia dostępu API do Ollama) | Sleczny interfejs stylu ChatGPT; rozmowa głosowa, wtyczki, obsługa wielu modeli | Złożony zestaw funkcji; wymaga konfiguracji środowiska (np. cross-origin dla Ollama) |

| LibreChat | Aplikacja sieciowa (samodzielnie hostowana; wielouserska) | Tak – „Chat z plikami” za pomocą RAG (za pomocą embeddingów) | Kompatybilny z Ollama i wieloma innymi dostawcami (zmiana na połączenie) | Znany interfejs stylu ChatGPT; bogate funkcje (agenta, interpreter kodu itd.) | Instalacja i konfiguracja mogą być złożone; duży projekt może być bardziej niż potrzebny do podstawowego użycia |

| AnythingLLM | Aplikacja desktop (Windows, Mac, Linux) lub sieciowa (Docker) | Tak – wbudowany RAG: przeciąganie i upuszczanie dokumentów (PDF, DOCX itd.) z cytatami | Ollama wspierany jako dostawca LLM (ustawienie w konfiguracji lub Docker env) | Wszystko w jednym interfejsie (prywatny ChatGPT z dokumentami); budowniczy agenta bez kodu, obsługa wielu użytkowników | Wysoki zużycie zasobów (baza danych embeddingów itd.); aplikacja desktop brakuje niektórych funkcji wielouserskich |

| Chat-with-Notes | Aplikacja sieciowa (lekkie serwer Flask) | Tak – przesyłanie tekstu/PDF i rozmowa z ich zawartością | Używa Ollama do wszystkich odpowiedzi AI (wymaga lokalnego działania Ollama) | Bardzo prosty ustawienie i interfejs skupiony na Q&A dokumentu; dane pozostają lokalne | Prosty interfejs i funkcje; jednoosobowy, jeden dokument naraz (brak zaawansowanych funkcji) |

Każde z tych narzędzi jest aktywnie utrzymywane i open source. Następnie zagłębiamy się w szczegóły każdej opcji, w tym sposobem działania z Ollama, wyróżniających funkcjami i wadami.

Page Assist (Rozszerzenie przeglądarki)

Page Assist to open-source rozszerzenie przeglądarki, które przynosi lokalny chat LLM do przeglądarki. Obsługuje przeglądarki oparte na Chromium i Firefox, oferując boczną zakładkę lub zakładkę stylu ChatGPT, w której możesz rozmawiać z modelem. Page Assist może łączyć się z lokalnie działającym Ollama jako dostawcą AI, lub innymi lokalnymi backendami, przez swoje ustawienia. Wyróżnia się tym, że pozwala Ci dodać pliki (np. PDFy lub tekst) do analizy przez AI w ramach rozmowy, umożliwiając podstawowe przepływy pracy RAG. Możesz nawet pomóc w analizie zawartości bieżącej strony webowej lub wykonać wyszukiwania w sieci.

Instalacja jest prosta: zainstaluj rozszerzenie z Chrome Web Store lub Firefox Add-ons, upewnij się, że Ollama działa, a następnie wybierz Ollama jako lokalnego dostawcę AI w ustawieniach Page Assist. Interfejs zawiera funkcje takie jak historia rozmowy, wybór modelu i opcjonalny udostępniany URL do wyników rozmowy. Interfejs sieciowy również jest dostępny za pomocą skrótu klawiatury, jeśli preferujesz pełną zakładkę do rozmowy.

Zalety: Page Assist jest lekkie i wygodne – ponieważ znajduje się w przeglądarce, nie ma oddzielnego serwera do uruchomienia. Idealne do przeglądania stron (można ją otworzyć na dowolnej stronie webowej) i obsługuje integrację wyszukiwania w internecie i załączników plików, aby wzbogacić rozmowę. Ponadto oferuje przydatne funkcje, takie jak skróty klawiatury do nowej rozmowy i przekazywania bocznej zakładki.

Ograniczenia: Jako rozszerzenie jest ograniczone do środowiska przeglądarki. Interfejs jest prostszy i trochę mniej funkcjonalny niż pełne aplikacje do rozmowy. Na przykład, zarządzanie wieloma użytkownikami lub zaawansowane wtyczki agenta nie są w zakresie. Ponadto, początkowa konfiguracja może wymagać budowania/ladowania rozszerzenia, jeśli wersja pakowana nie jest dostępna dla Twojej przeglądarki (projekt oferuje instrukcje budowania za pomocą Bun lub npm). W skrócie, Page Assist najlepiej nadaje się do indywidualnego użytku, gdy chcesz szybki dostęp do rozmowy z Ollama podczas przeglądania stron, z umiarkowaną funkcjonalnością RAG.

Open WebUI (Samodzielnie hostowana aplikacja sieciowa)

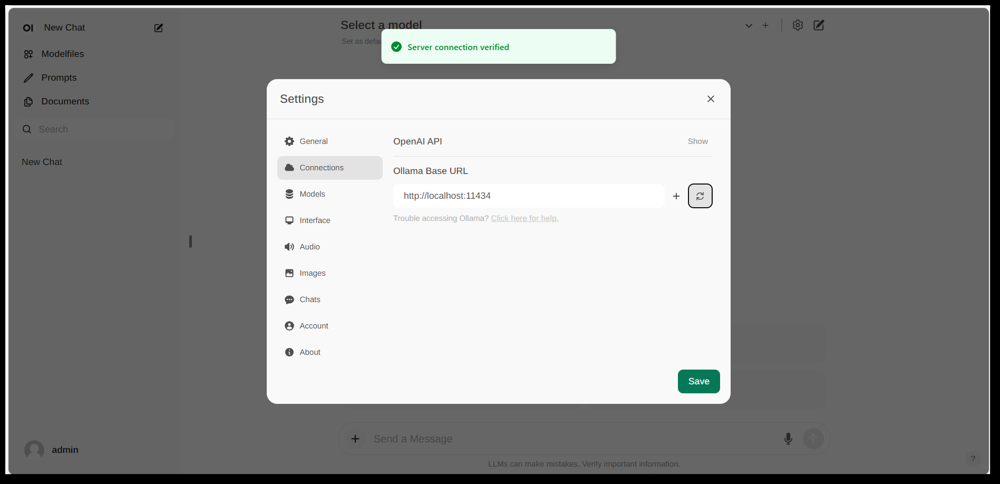

Interfejs ustawień Open WebUI pokazujący skonfigurowane połączenie z Ollama (adres URL podstawowy ustawiony na lokalny API Ollama). Interfejs zawiera sekcję Dokumenty, umożliwiającą przepływy pracy RAG.

Open WebUI to potężna, ogólnego przeznaczenia aplikacja do rozmowy, stworzona pierwotnie do pracy z Ollama, a teraz rozszerzona, aby wspierać różne backendy LLM. Działa jako samodzielnie hostowana aplikacja sieciowa i zazwyczaj wdrażana jest przez Docker lub Kubernetes w celu ułatwienia konfiguracji. Po uruchomieniu dostępu do niej uzyskujesz przez przeglądarkę (z obsługą instalacji jako Progressive Web App na urządzeniach mobilnych).

Open WebUI oferuje pełny interfejs do rozmowy z obsługą wielu użytkowników, zarządzaniem modelem i szerokim zakresem funkcji. Krytycznie, ma wbudowane możliwości RAG – możesz przesyłać lub importować dokumenty do biblioteki dokumentów i następnie zadawać pytania z użyciem odzyskiwania. Interfejs pozwala na ładowanie dokumentów bezpośrednio do sesji rozmowy lub utrzymanie trwałą bibliotekę wiedzy. Nawet wspiera wykonywanie wyszukiwań w sieci i wstrzykiwanie wyników do rozmowy w celu uzyskania aktualnych informacji.

Integracja z Ollama: Open WebUI łączy się z Ollama przez jego API. Możesz albo uruchomić kontener Open WebUI Docker obok serwera Ollama i ustawić zmienną środowiskową, aby wskazać adres URL Ollama, albo użyć specjalnego obrazu Docker, który łączy Ollama z interfejsem sieciowym. W praktyce, po uruchomieniu kontenerów, odwiedzisz Open WebUI w przeglądarce i zobaczysz „Sprawdzenie połączenia z serwerem”, jeśli skonfigurowano poprawnie (jak pokazano na powyższym obrazie). Oznacza to, że interfejs jest gotowy do użycia lokalnych modeli Ollama do rozmowy. Open WebUI wspiera również kompatybilne punkty końcowe API OpenAI, więc może współpracować z LM Studio, OpenRouter itp., oprócz Ollama.

Zalety: To jedno z najbardziej funkcjonalnych i elastycznych interfejsów. Wspiera wiele jednoczesnych modeli i wątków rozmowy, niestandardowe „postacie” lub systemowe wskazówki, generowanie obrazów i wiele innych funkcji. Implementacja RAG jest solidna – otrzymujesz pełny interfejs do zarządzania dokumentami i nawet konfiguracji, który wektorowy magazyn lub usługa wyszukiwania do użycia w odzyskiwaniu. Open WebUI jest również aktywnie rozwijany (z dużą społecznością, jak wskazuje liczba gwiazdek na GitHubie) i zaprojektowany do rozszerzalności i skalowania. Jest dobrym wyborem, jeśli chcesz kompletny, wszystko w jednym interfejsie do rozmowy dla lokalnych modeli, szczególnie w scenariuszu z wieloma użytkownikami lub złożonymi przypadkami użycia.

Ograniczenia: Z wielką mocą przyszedł większy złożoność. Open WebUI może być nadmiernie rozbudowany do prostego użytku osobistego – wdrażanie kontenerów Docker i zarządzanie konfiguracją może być zniechęcające, jeśli nie jesteś zaznajomiony. Zużywa więcej zasobów niż lekkie aplikacje, ponieważ działa serwer sieciowy, opcjonalna baza danych do historii rozmowy itd. Ponadto, funkcje takie jak kontrola dostępu oparta na roli i zarządzanie użytkownikami, choć przydatne, wskazują, że są skierowane do konfiguracji serwera – pojedynczy użytkownik na komputerze w domu może nie potrzebować wszystkiego. W skrócie, konfiguracja jest bardziej złożona, a interfejs może wydawać się skomplikowany, jeśli potrzebujesz tylko podstawowego klonu ChatGPT. Ale dla tych, którzy potrzebują szerokiego zakresu funkcji (lub chcą łatwo przełączać się między Ollama a innymi dostawcami modeli w jednym interfejsie), Open WebUI to wyróżniający się kandydat.

LobeChat (Framework stylu ChatGPT z wtyczkami)

Baner interfejsu LobeChat pokazujący „Ollama Supported” i wiele lokalnych modeli. LobeChat pozwala wdrożyć elegancki web app stylu ChatGPT przy użyciu Ollama lub innych dostawców, z funkcjami takimi jak wejście głosowe i wtyczki.

LobeChat to open-source framework do rozmowy, który podkreśla wygoda użytkownika i elastyczność. Jest to w zasadzie web app stylu ChatGPT, który możesz samodzielnie hostować, z obsługą wielu dostawców AI – od OpenAI i Anthropic po otwarte modele przez Ollama. LobeChat jest zaprojektowany z uwzględnieniem prywatności (uruchamiasz go samodzielnie) i ma nowoczesny interfejs, który obejmuje wygoda takie jak pamięć rozmowy, tryb rozmowy głosowej i nawet generowanie obrazów przez wtyczki.

Jedną z kluczowych cech LobeChat to jego możliwość tworzenia bazy wiedzy. Możesz przesyłać dokumenty (w formatach takich jak PDFy, obrazy, audio, wideo) i tworzyć bazę wiedzy, która może być wykorzystywana podczas rozmowy. To oznacza, że możesz zadawać pytania o zawartość swoich plików – przepływ pracy RAG, który LobeChat wspiera domyślnie. Interfejs umożliwia zarządzanie tymi plikami/bazami wiedzy i umożliwia ich włączanie/wyłączanie w rozmowie, dając bogatsze doświadczenie Q&A poza podstawowym LLM.

Aby użyć LobeChat z Ollama, wdrożysz aplikację LobeChat (np. za pomocą dostarczonego obrazu Docker lub skryptu) i skonfigurujesz Ollama jako backend. LobeChat rozpoznaje Ollama jako pierwszorzędny dostawcę – nawet oferuje skrypt jednoklikowy do wdrożenia przez Pinokio AI w przeglądarce, jeśli używasz tego. W praktyce, możesz musieć dostosować ustawienia Ollama (np. włączenie CORS zgodnie z dokumentacją LobeChat) tak, aby interfejs sieciowy LobeChat mógł uzyskać dostęp do HTTP API Ollama. Po skonfigurowaniu możesz wybrać model Ollama w interfejsie LobeChat i rozmawiać z nim, w tym pytania dotyczące przesłanych dokumentów.

Zalety: Interfejs LobeChat często jest pochwalany za to, że jest czysty i łatwy w użyciu, bardzo zbliżony do wyglądu i odczuć ChatGPT (co może ułatwić adaptację). Dodaje wartość z funkcjami takimi jak wejście/wyjście głosowe do rozmowy mówionych i system wtyczek, aby rozszerzyć funkcjonalność (podobnie jak wtyczki ChatGPT, umożliwiające rzeczy takie jak przeglądanie sieci lub generowanie obrazów). Wsparcie wielu modeli oznacza, że łatwo możesz przełączać się między, powiedzmy, lokalnym modelem Ollama i modelem API OpenAI w tym samym interfejsie. Wspiera również instalację jako PWA, kompatybilne z urządzeniami mobilnymi, więc możesz uzyskać dostęp do lokalnej rozmowy na bieżąco.

Ograniczenia: Konfiguracja LobeChat może być bardziej skomplikowana niż niektóre alternatywy. Jest to pełnoprawna aplikacja (często uruchamiana za pomocą Docker Compose), więc istnieje pewna przeszkoda. W szczególności, konfiguracja integracji z Ollama wymaga włączenia żądań cross-origin po stronie Ollama i upewnienia się, że porty są zgodne – to jednorazowe zadanie, ale techniczne. Ponadto, choć LobeChat jest bardzo potężny, nie wszystkie funkcje mogą być potrzebne dla każdego użytkownika; na przykład, jeśli nie potrzebujesz wsparcia wielu dostawców lub wtyczek, interfejs może wydawać się zbyt złożony w porównaniu do minimalnego narzędzia. Na koniec, niektóre zaawansowane funkcje, takie jak jednoklikowe wdrożenie, zakładać określone środowiska (przeglądarka Pinokio lub Vercel), które możesz lub nie możesz używać. W skrócie, LobeChat jest idealny, jeśli chcesz pełnoprawną alternatywę dla ChatGPT, która działa lokalnie z Ollama, i nie boisz się pewnej konfiguracji początkowej, aby tam dojść.

LibreChat (Klon ChatGPT z wsparciem wielu dostawców)

LibreChat (wcześniej znany jako ChatGPT-Clone lub UI) to projekt open-source, który ma na celu replikację i rozszerzenie interfejsu i funkcjonalności ChatGPT. Można go wdrożyć lokalnie (lub na własnym serwerze) i wspiera wiele backendów AI – w tym modeli open-source przez Ollama. W zasadzie, LibreChat oferuje znane doświadczenie w rozmowie (interfejs dialogowy z historią, komunikaty użytkownika i asystenta), umożliwiając wstawienie różnych dostawców modeli w tle.

LibreChat wspiera interakcję z dokumentami i RAG poprzez dodatek nazywany RAG API i usługi embeddingów. W interfejsie możesz korzystać z funkcji takich jak „Chat z plikami”, które pozwalają przesyłać dokumenty i następnie zadawać pytania o nie. W tle to wykorzystuje embeddingi i bazę wektorową, aby uzyskać odpowiedni kontekst z Twoich plików. To oznacza, że możesz uzyskać podobny efekt do ChatGPT + wiedzy niestandardowej, wszystko lokalnie. Projekt oferuje również oddzielny repozytorium dla usługi RAG, jeśli chcesz samodzielnie hostować tę usługę.

Użycie LibreChat z Ollama zwykle obejmuje uruchomienie serwera LibreChat (np. przez Node/Docker) i upewnienie się, że może osiągnąć usługę Ollama. LibreChat ma „Niestandardowy punkt końcowy”, w którym możesz wpisać URL API kompatybilny z OpenAI. Ponieważ Ollama może wyeksponować lokalny API, który jest kompatybilny z OpenAI, LibreChat może być skierowany do http://localhost:11434 (lub gdziekolwiek Ollama nasłuchuje). W rzeczywistości LibreChat jawne wymienia Ollama wśród swoich wspieranych dostawców AI – wraz z innymi, takimi jak OpenAI, Cohere itp. Po skonfigurowaniu możesz wybrać model (model Ollama) w rozwijanej liście i rozmawiać. LibreChat również pozwala przełączać modele lub dostawców nawet w trakcie rozmowy i wspiera wiele ustawień rozmowy/kontekstów.

Zalety: Główne zalety LibreChat to bogaty zestaw funkcji opartych na doświadczeniu rozmowy. Obejmuje takie rzeczy jak rozdzielanie rozmowy, wyszukiwanie komunikatów, wbudowane obsługa interpretera kodu (bezpieczne wykonywanie kodu w sandbox), oraz integracje narzędzi/agentów. Jest to w zasadzie ChatGPT++, z możliwością integracji lokalnych modeli. Dla kogoś, kto lubi interfejs ChatGPT, LibreChat będzie bardzo znajomy i wymaga niewielkiego poziomu nauki. Projekt jest aktywny i wspierany przez społeczność (jak pokazuje to częste aktualizacje i dyskusje), a także jest bardzo elastyczny: możesz połączyć się z wieloma rodzajami punktów końcowych LLM lub nawet uruchomić go w trybie wielouserskim z uwierzytelnieniem dla zespołu.

Ograniczenia: Z wieloma funkcjami LibreChat może być trudniejszy do uruchomienia. Instalacja może obejmować ustawienie bazy danych do przechowywania rozmów i konfigurację zmiennych środowiskowych dla różnych API. Jeśli włączysz wszystkie komponenty (RAG, agentów, generowanie obrazów itp.), to dość złożony stos. Dla pojedynczego użytkownika, który potrzebuje tylko podstawowej rozmowy z jednym lokalnym modelem, LibreChat może być więcej niż potrzebne. Ponadto, interfejs, choć znajomy, nie jest bardzo specjalizowany dla QA dokumentów – robi to dobrze, ale brakuje dedykowanego interfejsu „biblioteki dokumentów” (przesyłanie plików jest zwykle wykonywane w ramach rozmowy lub przez API). W skrócie, LibreChat świetnie radzi sobie, gdy chcesz pełne środowisko stylu ChatGPT z szerokim zakresem funkcji, działające lokalnie, ale prostsze rozwiązania mogą wystarczyć dla wąskich przypadków użycia.

AnythingLLM (Wszystko w jednym aplikacji desktopowej lub serwerowej)

AnythingLLM to wszystko w jednym aplikacji AI, która podkreśla RAG i łatwość użycia. Pozwala Ci „rozmawiać z dokumentami” przy użyciu zarówno open-source modeli LLM, jak i nawet modeli OpenAI, wszystko przez jednolity interfejs. Wyróżnia się tym, że AnythingLLM jest dostępny zarówno jako krzyżowe aplikacji desktop (dla Windows, Mac, Linux) jak i jako samodzielnie hostowana aplikacja sieciowa (przez Docker). Ta elastyczność oznacza, że możesz uruchomić ją jak normalną aplikację na swoim komputerze, lub wdrożyć ją dla wielu użytkowników na serwerze.

Obsługa dokumentów jest w centrum AnythingLLM. Możesz przeciągnąć i upuścić dokumenty (PDF, TXT, DOCX itd.) do aplikacji, a ona automatycznie indeksuje je do bazy danych wektorowej (ma domyślnie LanceDB). W interfejsie rozmowy, gdy zadajesz pytania, będzie odzyskiwać odpowiednie fragmenty z Twoich dokumentów i dostarczać odpowiedzi z cytatami, więc wiesz, z którego pliku i sekcji pochodzi informacja. W zasadzie, buduje prywatną bazę wiedzy dla Ciebie i pozwala LLM używać jej jako kontekstu. Możesz organizować dokumenty w „przestrzeniach roboczych” (np. jeden przestrzeń robocza na projekt lub temat), izolując konteksty w razie potrzeby.

Użycie Ollama z AnythingLLM jest proste. W konfiguracji wybierasz Ollama jako dostawcę LLM. Jeśli uruchamiasz przez Docker, ustawisz zmienne środowiskowe takie jak LLM_PROVIDER=ollama i dostarczysz OLLAMA_BASE_PATH (URL do Twojej instancji Ollama). Serwer AnythingLLM będzie wysyłał wszystkie zapytania modelu do API Ollama. Ollama jest oficjalnie wspierany, a dokumentacja zauważa, że można go wykorzystać do uruchamiania różnych open modeli (np. Llama 2, Mistral itp.) lokalnie. W rzeczywistości, twórcy podkreślają, że łączenie AnythingLLM z Ollama odblokowuje potężne możliwości offline RAG: Ollama obsługuje inferencję modelu, a AnythingLLM obsługuje embeddingi i logikę interfejsu/agenta.

Zalety: AnythingLLM oferuje kompleksowe rozwiązanie dla prywatnego Q&A i rozmowy. Kluczowe zalety obejmują: łatwe ustawienie RAG (ciężka praca embeddingów i przechowywania wektorów jest automatyczna), wsparcie wielu dokumentów z wyraźnym cytowaniem źródeł, oraz dodatkowe funkcje takie jak AI Agentów (ma budowniczy agenta bez kodu, w którym możesz tworzyć niestandardowe przepływy pracy i użycie narzędzi). Jest również wielouserski z domyślnym (szczególnie w trybie serwera), z kontami użytkowników i uprawnieniami, jeśli są potrzebne. Interfejs jest zaprojektowany, aby być prostym (okno chat + boczna lista dokumentów/przestrzeni roboczych), ale potężny pod spodem. Dla użytkowania osobistego, aplikacja desktop jest dużym plusem – otrzymujesz aplikację o czułym odczuciu bez konieczności otwierania przeglądarki lub uruchamiania poleceń, a domyślnie przechowuje dane lokalnie.

Ograniczenia: Ponieważ integruje wiele komponentów (API LLM, modele embeddingów, baza danych wektorowa itd.), AnythingLLM może być zasobożerne. Gdy wchłaniasz dokumenty, może to zająć czas i pamięć na generowanie embeddingów (nawet wspiera użycie Ollama samego lub lokalnych modeli dla embeddingów z modelami takimi jak nomic-embed). Aplikacja desktop upraszcza użycie, ale jeśli masz dużo dokumentów lub bardzo duże pliki, oczekuj ciężkiego przetwarzania w tle. Inne ograniczenie to to, że zaawansowani użytkownicy mogą znaleźć ją mniej konfigurowalną niż tworzenie własnego stosu – na przykład, obecnie używa LanceDB lub Chroma; jeśli chciałbyś inną bazę wektorową, musiałbyś zagłębić się w konfigurację lub kod. Ponadto, choć wspiera wielu dostawców, interfejs jest naprawdę skierowany na jeden model naraz (zamienisz ustawienie dostawcy globalnego, jeśli chcesz użyć innego modelu). W skrócie, AnythingLLM to wspaniałe rozwiązanie gotowe do użycia dla lokalnej rozmowy z dokumentami, szczególnie z Ollama, ale jest większą aplikacją do uruchomienia w porównaniu do minimalnych interfejsów.

Chat-with-Notes (Minimalny interfejs do rozmowy z dokumentami)

Chat-with-Notes to minimalistyczna aplikacja specjalnie stworzona do rozmowy z lokalnymi plikami tekstowymi przy użyciu modeli zarządzanych przez Ollama. Jest to w zasadzie lekkie serwer Flask, który uruchamiasz na swoim komputerze, oferując prostą stronę sieciową, gdzie możesz przesłać dokument i rozpocząć rozmowę o nim. Celem tego projektu jest prostota: nie ma wiele dodatkowych funkcji, ale robi podstawową pracę odpowiedzi na pytania dotyczące dokumentów za pomocą lokalnego LLM.

Użycie Chat-with-Notes obejmuje najpierw upewnienie się, że instancja Ollama uruchamia model (np. możesz uruchomić Ollama za pomocą ollama run llama2 lub innego modelu). Następnie uruchamiasz aplikację Flask (python app.py) i otwierasz lokalną stronę internetową. Interfejs będzie prosił o przesłanie pliku (obsługiwane formaty obejmują tekst prosty, Markdown, pliki kodu, HTML, JSON i PDFy). Po przesłaniu, zawartość tekstu pliku zostanie wyświetlona, a możesz zadawać pytania lub rozmawiać z AI o tej treści. Rozmowa odbywa się w typowym formacie pętli rozmowy. Jeśli przesłasz nowy plik w trakcie rozmowy, aplikacja zapyta, czy chcesz rozpocząć nową rozmowę lub zachować bieżący kontekst rozmowy i dodać tylko informacje z nowego pliku. W ten sposób możesz rozmawiać o wielu plikach sekwencyjnie, jeśli to konieczne. Są również przyciski do wyczyszczenia rozmowy lub eksportowania rozmowy do pliku tekstowego.

W tle, Chat-with-Notes zapytuje API Ollama w celu generowania odpowiedzi. Ollama obsługuje inferencję modelu, a Chat-with-Notes po prostu dostarcza prompt (który obejmuje odpowiednie części przesłanego tekstu). Nie używa bazy danych wektorowej; zamiast tego po prostu wysyła całą zawartość pliku (lub fragmenty) wraz z Twoim pytaniem do modelu. Ten podejście działa najlepiej na rozsądną wielkość dokumentów, które mieszczą się w oknie kontekstu modelu.

Zalety: Aplikacja jest bardzo łatwa do wdrożenia i użycia. Nie ma złożonej konfiguracji – jeśli masz Python i Ollama skonfigurowane, możesz uruchomić ją w ciągu kilku minut. Interfejs jest czysty i minimalny, skupiając się na treści tekstowej i Q&A. Ponieważ jest tak skupiona, zapewnia, że wszystkie dane pozostają lokalne i tylko w pamięci (bez wywołań zewnętrznych poza Ollama na localhost). To świetny wybór, jeśli chcesz rozmawiać z plikami i nie potrzebujesz ogólnej rozmowy bez dokumentu.

Ograniczenia: Minimalizm Chat-with-Notes oznacza, że brakuje wielu funkcji, które znajdują się w innych interfejsach. Na przykład, nie wspiera użycia wielu modeli lub dostawców (jest tylko dla Ollama), a nie utrzymuje długoterminowej biblioteki dokumentów – przesyłasz pliki w razie potrzeby na sesję, a nie ma trwałe indeksu wektorowego. Skalowanie do bardzo dużych dokumentów może być trudne bez ręcznych dostosowań, ponieważ może spróbować dołączyć dużo tekstu w prompt. Ponadto, interfejs, choć funkcjonalny, nie jest tak wyrafinowany (brak trybu ciemnego, brak bogatej formatowania odpowiedzi itp.). W skrócie, to narzędzie idealne do szybkich, jednorazowych analiz plików z modelem Ollama. Jeśli Twoje potrzeby rosną (np. wiele dokumentów, lub pragnienie bardziej eleganckiego interfejsu), możesz wyrosnąć ponad Chat-with-Notes. Ale jako punkt wyjścia lub osobiste „zapytaj mój PDF” rozwiązanie na Ollama, jest bardzo skuteczne.

Podsumowanie

Każdy z tych open-source interfejsów może poprawić Twoje doświadczenie z lokalnymi modelami Ollama, oferując przyjazny interfejs do rozmowy i dodatkowe funkcje, takie jak odpowiedzi na pytania dotyczące dokumentów. Najlepszy wybór zależy od Twoich wymagań i komfortu technicznego:

- Dla szybkiego ustawienia i użycia w przeglądarce: Page Assist to świetna opcja, łącząca się bezpośrednio z Twoim przeglądaniem internetowym z minimalnym zamieszaniem.

- Dla pełnego środowiska aplikacji sieciowej: Open WebUI lub LibreChat oferują szeroką gamę funkcji i elastyczność wielu modeli, odpowiednie dla zaawansowanych użytkowników lub konfiguracji wielouserskich.

- Dla eleganckiej alternatywy dla ChatGPT z potencjałem wtyczek: LobeChat oferuje dobrą równowagę między wygodością a funkcjami w pakiecie samodzielnie hostowanym.

- Dla interakcji skupionych na dokumentach: AnythingLLM dostarcza kompleksowe rozwiązanie (szczególnie jeśli lubisz aplikację desktopową), podczas gdy Chat-with-Notes oferuje minimalistyczne podejście do Q&A jednego dokumentu.

Wszystkie te narzędzia są aktywnie utrzymywane, więc możesz również spodziewać się poprawek i wsparcia społeczności. Wybierając jedno z tych interfejsów, możesz rozmawiać z lokalnie hostowanymi modelami Ollama w wygodny sposób – czy to analizowanie dokumentów, kodowanie z pomocą, czy po prostu dostęp do rozmowy AI bez zależności od chmury. Każde rozwiązanie powyżej jest open-source, więc możesz dalej dostosować je do swoich potrzeb lub nawet przyczynić się do ich rozwoju. Aby zobaczyć, jak lokalny Ollama plus te interfejsy graficzne pasuje do innych lokalnych i chmurowych opcji, sprawdź nasz Hostowanie LLM: Porównanie lokalnego, samodzielnie hostowanego i infrastruktury w chmurze.

Miłej rozmowy z lokalnym LLM!