ローカルOllamaインスタンス用のチャットUI

2025年のOllamaで最も注目されているUIの概要

ローカルにホストされた Ollama は、あなたのマシン上で大規模言語モデルを実行できるが、コマンドライン経由での使用はユーザーにとって使いにくい。

以下に、ローカルの Ollama に接続するための、いくつかのオープンソースプロジェクトが提供する ChatGPTスタイルのインターフェース がある。

これらのUIは、会話型チャットをサポートしており、多くの場合、ドキュメントアップロードによるリトリーバル・オーガナイズド・ジェネレーション(RAG) のような機能を備えており、ウェブまたはデスクトップアプリケーションとして動作します。以下に、主なオプションの比較を示し、その後に各オプションの詳細な説明を行います。ローカルの Ollama が vLLM、Docker Model Runner、LocalAI、クラウドプロバイダーとどのように統合されるか、コストやインフラストラクチャのトレードオフを含む、より広範な概観については、LLM ホスティング: ローカル、セルフホスト、クラウドインフラストラクチャ比較 を参照してください。

Ollama対応UIの比較

| UIツール | プラットフォーム | ドキュメントサポート | Ollama統合 | 長所 | 制限 |

|---|---|---|---|---|---|

| Page Assist | ブラウザ拡張機能(Chrome、Firefox) | はい – ファイルをアップロードして分析 | 拡張機能の設定を通じてローカルの Ollama に接続 | ブラウザ内でのチャット;モデル管理とウェブページコンテキストの統合が容易。 | ブラウザ専用;拡張機能のインストール/設定が必要。 |

| Open WebUI | ウェブアプリ(セルフホスト;Docker/PWA) | はい – 内蔵RAG(ドキュメントをアップロードまたはライブラリに追加) | Ollama APIの直接サポートまたはバンドルされたサーバー(ベースURLを設定) | 機能が豊富(マルチLLM、オフライン、画像生成);モバイル対応(PWA)。 | 設定が重い(Docker/K8s);広範なスコープが単純な使用には過剰。 |

| LobeChat | ウェブアプリ(セルフホスト;PWA対応) | はい – “Knowledge Base” にファイルアップロード(PDF、画像など) | Ollamaを複数のAIバックエンドの一つとしてサポート(OllamaのAPIアクセスを有効にする必要あり) | スリムなChatGPTスタイルUI;音声チャット、プラグイン、マルチモデルサポート。 | 複雑な機能セット;環境設定が必要(例:Ollamaのクロスドメイン)。 |

| LibreChat | ウェブアプリ(セルフホスト;マルチユーザー対応) | はい – “Chat with Files”を使用してRAG(埋め込み経由) | Ollamaおよび多くの他のプロバイダーと互換性があり(チャットごとに切り替え可能) | なじみのあるChatGPTスタイルインターフェース;豊富な機能(エージェント、コードインタープリターなど)。 | インストール/設定が複雑;大規模なプロジェクトが基本使用には必要ない。 |

| AnythingLLM | デスクトップアプリ(Windows、Mac、Linux)またはウェブ(Docker) | はい – 内蔵RAG: ドキュメント(PDF、DOCXなど)をドラッグ&ドロップして引用付きで表示 | OllamaをLLMプロバイダーとしてサポート(設定またはDocker環境で設定) | すべてを一括してUI(あなたのドキュメント付きのプライベートChatGPT);ノーコードエージェントビルダー、マルチユーザー対応。 | 資源使用量が高め(埋め込みDBなど);デスクトップアプリは一部のマルチユーザー機能を欠く。 |

| Chat-with-Notes | ウェブアプリ(軽量なFlaskサーバー) | はい – テキスト/PDFファイルをアップロードしてその内容とチャット | Ollamaを使用してすべてのAI回答(ローカルでOllamaを実行する必要あり) | とてもシンプルな設定とインターフェースがドキュメントQ&Aに焦点を当てており、データはローカルに残る。 | 基本的なUIと機能;シングルユーザー、1ドキュメントのみ(高度な機能はなし)。 |

これらのツールはすべて 積極的にメンテナンス されており、オープンソースです。次に、各オプションの詳細について説明します。Ollamaとの統合方法、特徴、トレードオフを含みます。

Page Assist(ブラウザ拡張機能)

Page Assist は、ローカルのLLMチャットをブラウザに持ち込むオープンソースのブラウザ拡張機能です。ChromiumベースのブラウザおよびFirefox をサポートしており、モデルと会話できるChatGPTスタイルのサイドバーまたはタブを提供します。Page Assist は、ローカルで実行されている Ollama をAIプロバイダーとして、またはその他のローカルバックエンドを通じて、設定で接続できます。特に、ファイル(例:PDFやテキスト)を追加 してAIがチャット内で分析できるようにする基本的なRAGワークフローをサポートしています。ウェブページの内容を補助したり、情報を検索して取得したりすることもできます。

設定は簡単です:Chrome Web StoreまたはFirefox Add-onsから拡張機能をインストールし、Ollamaが実行されていることを確認し、Page Assistの設定でOllamaをローカルAIプロバイダーとして選択 します。インターフェースには、チャット履歴、モデル選択、チャット結果の共有可能なURLなどの機能が含まれています。フルタブチャット体験を希望する場合は、キーボードショートカットでウェブUI も利用可能です。

長所: Page Assist は軽量で便利です。ブラウザに存在するため、別途サーバーを実行する必要がありません。ブラウジングコンテキスト(任意のウェブページで開くことができ)に最適で、インターネット検索の統合とファイル添付 をサポートして会話を豊かにします。また、新しいチャットを作成するためのキーボードショートカットやサイドバーの切り替えなどの便利な機能も提供しています。

制限: 拡張機能であるため、ブラウザ環境に限定されます。UIはシンプルで、フルスタンドアロンチャットアプリほど機能が豊かではありません。例えば、マルチユーザー管理や高度なエージェントプラグインは対象外です。また、事前にパッケージ化されたバージョンがブラウザにない場合、拡張機能を構築/ロードする必要があるため、初期設定がやや複雑です(プロジェクトはBunまたはnpmを使用した構築手順を提供しています)。全体的に、Page Assistは、ウェブブラウジング中にOllamaによるチャットに迅速にアクセスしたい個人ユーザー向けで、中程度のRAG機能を備えています。

Open WebUI(セルフホストウェブアプリケーション)

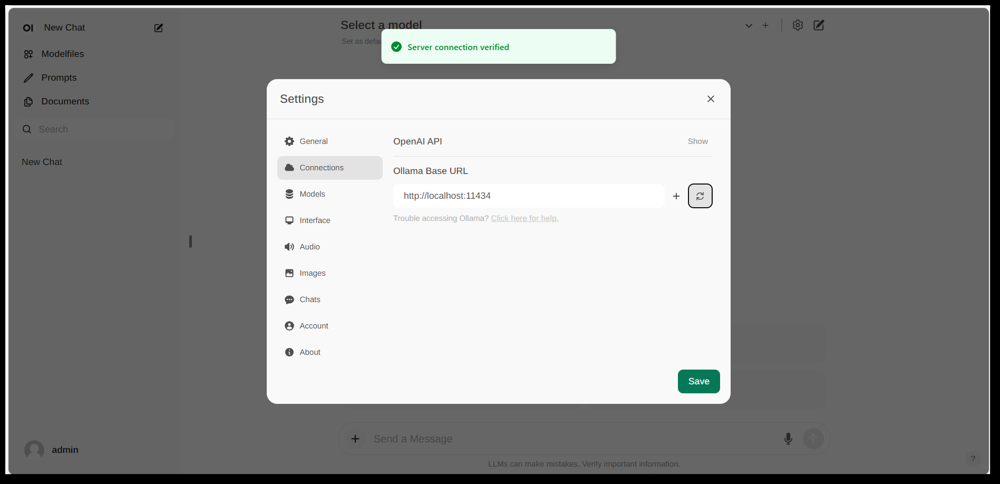

Open WebUIの設定インターフェース、Ollama接続が設定されている(ローカルOllama APIのベースURLが設定済み)。UIにはドキュメントセクションがあり、RAGワークフローを可能にします。

Open WebUI は、Ollama と連携して動作する、汎用的なチャットフロントエンドとして最初に作成された強力なツールで、現在ではさまざまなLLMバックエンドをサポートしています。これはセルフホストウェブアプリケーションとして動作し、DockerまたはKubernetesで簡単にセットアップするために通常はデプロイされます。一度実行されると、ブラウザ経由でアクセスできます(モバイルデバイスではプログレッシブウェブアプリとしてインストール可能です)。

Open WebUIは、マルチユーザー対応、モデル管理、豊富な機能 を備えた完全なチャットインターフェースを提供します。重要なのは、内蔵のRAG機能 です。ドキュメントをアップロードまたはライブラリにインポートし、リトリーバル拡張付きで質問 できます。インターフェースは、チャットセッション内にドキュメントを直接ロードしたり、知識の永続的なライブラリを維持したりできます。また、ウェブ検索 を実行し、結果を会話に注入して最新情報を提供することも可能です。

Ollama統合: Open WebUIはOllamaのAPIを通じて接続します。Open WebUIのDockerコンテナをOllamaサーバーと並行して実行し、OllamaのURLを指す環境変数を設定するか、Ollamaをバンドル した特別なDockerイメージを使用することができます。実際には、コンテナを起動した後、ブラウザでOpen WebUIにアクセスし、「サーバー接続が確認済み」 と表示される場合(上の画像のように設定されている場合)が確認できます。これはUIがローカルのOllamaモデルを使用してチャットが可能であることを意味します。Open WebUIはまた、OpenAI APIと互換性のあるエンドポイント もサポートしており、LM Studio、OpenRouterなど、Ollama以外のプロバイダーともインターフェース可能です。

長所: このソリューションは、最も機能が豊かで柔軟性が高いUI の一つです。複数のモデルと会話スレッド、カスタム「キャラクター」またはシステムプロンプト、画像生成、など多くの機能をサポートしています。RAG実装は強力で、ドキュメント管理のための完全なUIが提供され、どのベクトルストアや検索サービスを使用するかを設定することもできます。Open WebUIは積極的に開発されており(GitHubのスター数が示すように、広範なコミュニティが存在)、拡張性とスケーリングに設計されています。複数のユーザーまたは複雑なユースケースがある場合に、ローカルモデル用の統合されたチャットUI として非常に適しています。

制限: 高い機能性は、複雑さを伴います。Open WebUIはシンプルな個人的な使用には過剰 かもしれません。Dockerコンテナをデプロイし、設定を管理する必要があることが、不慣れなユーザーには恐ろしく感じるかもしれません。軽量アプリよりもリソースを多く消費します。ウェブサーバー、チャット履歴用のオプションデータベースなどを実行しているためです。また、役割ベースのアクセス制御やユーザー管理などの機能は、サーバー設定向けに設計されていることを示しており、家庭のPCで単一ユーザーが使用する場合、すべてが不要かもしれません。要するに、設定は重く、インターフェースは基本的なChatGPTクローンを必要とするユーザーにとっては複雑に感じられるかもしれませんが、Ollamaと他のモデルプロバイダーの切り替えが容易なUIを必要とするユーザーにとっては、Open WebUIは最優秀な候補です。

LobeChat(プラグイン付きChatGPTスタイルフレームワーク)

LobeChatインターフェースのバナーで、「Ollama Supported」と複数のローカルモデルが表示されています。LobeChatは、Ollamaや他のプロバイダーを使用して、音声入力やプラグイン付きのスリックなChatGPTスタイルウェブアプリをデプロイできます。

LobeChat は、使いやすさと柔軟性を重視したオープンソースのチャットフレームワークです。これは、ChatGPTスタイルのウェブアプリケーション で、OpenAIやAnthropicからOllama経由のオープンモデルまで、複数のAIプロバイダーをサポート しています。LobeChatはプライバシーを考慮し(自分自身で実行)、現代的なインターフェースを提供し、会話メモリ、音声チャットモード、テキストから画像生成をプラグイン経由で実現するなど、便利な機能が含まれています。

LobeChatの主な特徴の一つは、Knowledge Base の機能です。PDF、画像、音声、動画などの形式のドキュメントをアップロード し、チャット中に参照できる知識ベースを作成できます。これは、LobeChatがRAGワークフローをデフォルトでサポートする意味です。UIはこれらのファイル/知識ベースを管理し、チャット中で使用するかどうかを切り替えることができます。これにより、LLMの基本機能を超えた豊かなQ&A体験が可能になります。

LobeChatをOllamaと使用するには、LobeChatアプリ(例えば、提供されたDockerイメージやスクリプトを使用して)をデプロイし、Ollamaをバックエンドとして設定します。LobeChatはOllamaを第一級のプロバイダーとして認識し、Pinokio AIブラウザを使用する場合、ワンクリックでデプロイするスクリプトを提供しています。実際には、LobeChatのウェブフロントエンドがOllamaのHTTP APIにアクセスできるようにするため、Ollamaの設定(例:LobeChatのドキュメントに従ってCORSを有効にする)を調整する必要があります。設定が完了すると、LobeChat UIでOllamaがホストしているモデルを選択し、アップロードしたドキュメントをクエリできます。

長所: LobeChatのUIは、きれいで使いやすい とよく評価されており、ChatGPTの見た目と使いやすさに近い(採用を容易にします)。音声入力/出力 で会話をしたり、プラグインシステム で機能を拡張したりするなど、価値ある機能を提供します(ChatGPTのプラグインに類似し、ウェブブラウジングや画像生成が可能)。マルチモデルサポートにより、OllamaのローカルモデルとOpenAI APIモデルを同じインターフェースで簡単に切り替えることができます。また、モバイルフレンドリーなPWAとしてインストール可能で、外出先でもローカルチャットにアクセスできます。

制限: LobeChatのセットアップは他の代替案に比べて複雑です。フルスタックアプリケーション(通常はDocker Composeで実行)であり、ある程度のオーバーヘッドがあります。特に、Ollamaとの統合には、Ollama側でクロスドメインリクエストを有効にする設定 が必要で、ポートの一致も必要です(一回のタスクですが、技術的です)。さらに、LobeChatは非常に強力ですが、すべてのユーザーにとって必要な機能ではないかもしれません。例えば、マルチプロバイダサポートやプラグインが必要でない場合、インターフェースは最小限のツールと比べて複雑に感じられるかもしれません。また、特定の環境(PinokioブラウザやVercel)を仮定するワンクリックデプロイ機能も存在しますが、使用するかどうかはユーザー次第です。全体的に、LobeChatは、Ollamaとローカルで動作する、フル機能のChatGPT代替 が望ましい場合に最適です。初期設定に少しの手間が必要ですが、それを受け入れる価値があります。

LibreChat(マルチプロバイダサポート付きChatGPTクローン)

LibreChat(以前はChatGPT-CloneやUIとして知られていた)は、ChatGPTのインターフェースと機能を複製・拡張することを目的としたオープンソースプロジェクトです。ローカル(または自分のサーバー)にデプロイ可能で、Ollama経由のオープンソースモデルを含むさまざまなAIバックエンドをサポート しています。本質的に、LibreChatは、なじみのあるチャット体験(履歴付きのダイアログインターフェース、ユーザーとアシスタントのメッセージ)を提供しつつ、バックエンドにさまざまなモデルプロバイダーをプラグインできるようにしています。

LibreChatは、RAG APIと埋め込みサービスを介して ドキュメントのやり取りとRAG をサポートしています。インターフェースでは、「Chat with Files」という機能を使用して、ドキュメントをアップロードし、質問をすることもできます。裏では、これは埋め込みとベクトルストアを使用して、ファイルから関連するコンテキストを取得しています。つまり、ローカルでChatGPT + カスタム知識の効果と同様の効果を実現できます。プロジェクトは、RAGサービスを自社ホストしたい場合に、別途リポジトリを提供しています。

LibreChatをOllamaと使用するには、通常、LibreChatサーバー(例:Node/Docker経由)を実行し、Ollamaサービスにアクセスできるようにする必要があります。LibreChatには、「カスタムエンドポイント」 の設定があり、OpenAI互換のAPI URLを入力できます。Ollamaはローカルで実行され、OpenAI互換のAPIを公開できるため、LibreChatはhttp://localhost:11434(Ollamaがリスニングしている場所)に接続できます。実際には、LibreChatはOllamaを含む、OpenAI、Cohereなどの他のサポートAIプロバイダーを明示的にリストしています。設定が完了すると、ドロップダウンからモデル(Ollamaのモデル)を選択し、チャットできます。LibreChatは、会話中でもモデルやプロバイダーを切り替えることができ、複数のチャットプリセット/コンテキストもサポートしています。

長所: LibreChatの主な利点は、チャット体験の周りに構築された豊富な機能セット です。会話分岐、メッセージ検索、組み込みのコードインタープリター(安全なサンドボックスでのコード実行)、ツール/エージェント統合などが含まれます。これは本質的にChatGPT++であり、ローカルモデルを統合する能力があります。ChatGPTのUIが好きなユーザーにとって、LibreChatは非常になじみやすく、学習曲線はわずかです。プロジェクトは活発に開発されており、コミュニティが中心(頻繁な更新や議論が示す)、非常に柔軟性があります:さまざまなLLMエンドポイントに接続したり、チーム設定で認証付きでマルチユーザーで実行したりできます。

制限: 多くの機能を備えているため、LibreChatは実行に時間がかかる かもしれません。インストールでは、チャットを保存するためのデータベースの設定や、さまざまなAPIの環境変数の設定が必要です。すべてのコンポーネント(RAG、エージェント、画像生成など)を有効にすると、かなり複雑なスタックになります。単一ユーザーが1つのローカルモデルで基本的なチャットが必要な場合、LibreChatは過剰かもしれません。また、UIはなじみがあるが、ドキュメントQAに特化していないため、ドキュメントライブラリのインターフェースがなく(アップロードは通常チャット内またはAPI経由で行われる)、やや不十分です。要するに、LibreChatは、ローカルで動作する、ChatGPTスタイルの環境と幅広い機能 を望む場合に最適ですが、狭い目的のユースケースでは、シンプルなソリューションが十分かもしれません。

AnythingLLM(すべてを1つにまとめたデスクトップまたはサーバーアプリ)

AnythingLLM は、RAGと使いやすさを重視したすべてを1つにまとめたAIアプリケーション です。オープンソースLLMまたはOpenAIのモデルを使用して「ドキュメントとチャット」できるようにし、すべてを1つの統合インターフェースで提供します。特に、AnythingLLMは、クロスプラットフォームデスクトップアプリ(Windows、Mac、Linux)とセルフホストウェブサーバー(Docker経由)の両方で利用可能です。この柔軟性により、PC上で通常のアプリケーションのように動作させたり、サーバー上で複数ユーザーにデプロイしたりできます。

ドキュメント処理はAnythingLLMの中心です。PDF、TXT、DOCXなどのファイルをドラッグ&ドロップ してアプリにアップロードし、デフォルトで LanceDB を使用してベクトルデータベースに自動的にインデックス化します。チャットインターフェースで質問をした場合、関連するドキュメントのチャンクを取得し、引用付きの回答 を提供します。つまり、あなたのためにプライベートな知識ベースを作成し、LLMがそれをコンテキストとして使用できるようにします。ドキュメントを 「ワークスペース」 に整理することもでき(プロジェクトごとやトピックごとに1つずつ)、必要に応じてコンテキストを分離できます。

AnythingLLMでOllamaを使用するのは簡単です。設定で OllamaをLLMプロバイダー として選択します。Docker経由で実行する場合は、LLM_PROVIDER=ollamaやOLLAMA_BASE_PATH(OllamaインスタンスのURL)などの環境変数を設定します。AnythingLLMサーバーは、すべてのモデルクエリをOllamaのAPIに送信します。Ollamaは公式にサポートされており、ドキュメントでは、さまざまなオープンモデル(Llama 2、Mistralなど)をローカルで実行できるようにすることもできます。実際、開発者はAnythingLLMとOllamaを組み合わせることで、強力なオフラインRAG機能を提供していると強調しています:Ollamaはモデル推論を処理し、AnythingLL线は埋め込みとUI/エージェントロジックを処理します。

長所: AnythingLLMは、プライベートなQ&Aとチャットのための包括的なソリューション を提供します。主な長所は以下の通りです:RAGの簡単なセットアップ(埋め込みとベクトルの保存の重い処理は自動化)、マルチドキュメントサポートと明確な出典情報、AIエージェント(ノーコードエージェントビルダーでカスタムワークフローとツールの使用を作成可能)など。また、デフォルトでマルチユーザー対応(特にサーバーモード)で、必要に応じてユーザーアカウントと権限管理も可能です。インターフェースはシンプル(チャットボックス + ドキュメント/ワークスペースのサイドバー)ですが、裏では強力です。個人的な使用には、デスクトップアプリが大きな利点で、ブラウザを開く必要がなく、コマンドを実行する必要がないネイティブなアプリが提供され、デフォルトではローカルにデータを保存します。

制限: 複数のコンポーネント(LLM API、埋め込みモデル、ベクトルDBなど)を統合しているため、AnythingLLMはリソースを多く消費 します。ドキュメントをインポートすると、埋め込みを生成するのに時間がかかり、メモリを多く使用します(Ollama自身やローカルモデル(nomic-embedなど)を使用して埋め込みを生成することもサポートしています)。デスクトップアプリは使用を簡単にする一方で、多くのドキュメントや非常に大きなファイルがある場合、バックグラウンドで重い処理が行われる可能性があります。もう一つの制限は、高度なユーザーが自らのスタックを組み立てるよりも構成が難しい可能性があることです。例えば、現在はLanceDBまたはChromaを使用していますが、別のベクトルストアを使用したい場合は、構成やコードに深入りする必要があります。また、マルチプロバイダはサポートしていますが、インターフェースは基本的に1つのモデルだけに焦点を当てています(別のモデルを使用したい場合は、グローバルプロバイダ設定を変更する必要があります)。要するに、AnythingLLMは、Ollamaと組み合わせてローカルドキュメントチャットのためのすぐ使えるソリューション として非常に優れていますが、最小限のUIに比べて実行するアプリケーションは大きくなります。

Chat-with-Notes(最小限のドキュメントチャットUI)

Chat-with-Notes は、Ollamaで管理されたモデルを使用してローカルテキストファイルとチャットするためのミニマリストアプリケーションです。これは、PCで実行する軽量なFlaskウェブサーバーであり、ドキュメントをアップロードしてチャットを開始できるシンプルなウェブページを提供します。このプロジェクトの目標は シンプルさ です:多くの装飾や機能はなく、ローカルLLMを使用したドキュメント質問回答のコア機能を実行します。

Chat-with-Notesを使用するには、まず Ollamaインスタンスがモデルを実行していることを確認 する必要があります(例えば、ollama run llama2や他のモデルでOllamaを起動)。その後、Flaskアプリ(python app.py)を起動し、ローカルウェブサイトを開きます。UIでは、ファイルをアップロード するよう促されます(サポートされている形式には、プレーンテキスト、Markdown、コードファイル、HTML、JSON、PDFなどが含まれます)。アップロード後、ファイルのテキストコンテンツが表示され、その内容について質問したりチャットしたりできます。会話は通常のチャットバブル形式で行われます。会話中に新しいファイルをアップロードした場合、アプリは、新しいチャットを開始するか、現在のチャットコンテキストを維持し、新しいファイルの情報を追加するかを尋ねます。これにより、必要に応じて複数のファイルを順次処理できます。また、チャットをクリアするボタンや、チャットをテキストファイルにエクスポートするボタンもあります。

裏では、Chat-with-Notesは Ollama API にクエリを送信して応答を生成します。Ollamaはモデル推論を処理し、Chat-with-Notesはプロンプト(アップロードされたテキストの関連部分を含む)を提供します。ベクトルデータベースを使用せず、単にファイルの全文(またはその一部)と質問をモデルに送信します。このアプローチは、モデルのコンテキストウィンドウに収まるほどにサイズが適切なドキュメントに最適です。

長所: アプリは非常に 簡単にデプロイ・使用 できます。複雑な設定はなく、PythonとOllamaがセットアップされている場合、数分以内に動作させることができます。インターフェースはきれいで最小限で、テキストコンテンツとQ&Aに焦点を当てています。非常に集中しているため、すべてのデータがローカルに残り、メモリ内でのみ存在 します(Ollamaにlocalhostでのみ外部コールが発生)。ファイルとチャットする必要がある場合、一般の会話は不要な場合に非常に適しています。

制限: Chat-with-Notesのミニマリズムは、他のUIに見られる多くの機能を欠いている ことを意味します。例えば、複数のモデルやプロバイダーの使用はサポートされていません(Ollama専用で設計されています)、長期的なドキュメントライブラリの維持もありません(セッションごとに必要に応じてファイルをアップロードし、永続的なベクトルインデックスはありません)。非常に大きなドキュメントのスケーリングは、手動の調整なしでは難しいかもしれません、モデルのコンテキストウィンドウに多くのテキストを含めようとします。また、UIは機能的ですが、ポリッシュがされていません(ダークモードなし、応答の豊富なテキストフォーマットなしなど)。要するに、このツールは、Ollamaモデルを使用してファイルを分析するためのクイックな一時的な分析 に最適です。ニーズが成長する場合(例えば、多くのドキュメントや、より洗練されたUIを望む場合)、Chat-with-Notesを越える可能性があります。しかし、Ollama上での「私のPDFに質問する」ソリューションとしての起点として、非常に効果的です。

結論

これらのオープンソースUIは、ローカルのOllamaモデルとユーザーが使いやすいチャットインターフェースを提供し、ドキュメントの質問回答などの追加機能を強化します。最適な選択は、あなたの要件と技術的な快適性に依存します:

- 迅速なセットアップとブラウザベースの使用: Page Assist は、最小限の手間でウェブブラウジングに直接統合されるため、非常に良い選択肢です。

- 機能豊富なウェブアプリ環境: Open WebUI または LibreChat は、多機能性とマルチモデルの柔軟性を提供し、プロユーザーまたはマルチユーザーの設定に適しています。

- 洗練されたChatGPT代替で、プラグインの可能性: LobeChat は、セルフホストパッケージで使いやすさと機能のバランスが良いです。

- ドキュメントに焦点を当てた相互作用: AnythingLLM は、特にデスクトップアプリを好むユーザー向けにすべてを1つにまとめたソリューションを提供しますが、Chat-with-Notes は、シングルドキュメントのQ&Aに最適なミニマリズムアプローチを提供します。

すべてのツールが積極的にメンテナンスされているため、改善とコミュニティのサポートも期待できます。これらのUIのいずれかを選択することで、ローカルのOllamaホストモデルと便利にチャットできるようになります – たとえば、ドキュメントの分析、コードのサポート、またはクラウド依存なしで会話型AIを楽しむことができます。上記のすべてのソリューションは オープンソース であるため、さらに必要に応じてカスタマイズしたり、開発に貢献したりすることも可能です。

ローカルのOllamaとこれらのUIが他のローカルおよびクラウドオプションとどのように統合されるかについては、LLM ホスティング: ローカル、セルフホスト、クラウドインフラストラクチャ比較 ガイドを参照してください。

ローカルLLMとチャットするのを楽しんでください!