Ollama上でのQwen3埋め込みおよび再ランクモデル:最先端の性能

Ollama に新しいすごい LLM が利用可能になりました。

Qwen3 Embedding および Reranker モデル は、Qwenファミリの最新リリースで、高度なテキスト埋め込み、検索、再順位付けタスクに特化して設計されています。

目で楽しむ喜び

Qwen3 Embedding および Reranker モデル は、多言語自然言語処理(NLP)における重要な進歩をもたらし、テキスト埋め込みおよび再順位付けタスクにおいて最先端の性能を提供しています。これらのモデルは、アリババが開発した Qwen シリーズの一部であり、セマンティック検索からコード検索に至るまで、幅広いアプリケーションをサポートするように設計されています。Ollama は、大規模言語モデル(LLM)のホスティングおよびデプロイに人気のあるオープンソースプラットフォームですが、公式ドキュメントでは Qwen3 モデルと Ollama の統合が明示的に詳細に記載されていません。ただし、これらのモデルは Hugging Face、GitHub、ModelScope を介してアクセス可能であり、Ollama や類似のツールを通じてローカルにデプロイすることが可能です。

これらのモデルを使用した例

Go 言語を使用して Ollama とこれらのモデルを組み合わせたサンプルコードをご覧ください:

- Ollama と Qwen3 Embedding モデルを使用したテキストドキュメントの再順位付け - Go 言語

- Ollama と Qwen3 Reranker モデルを使用したテキストドキュメントの再順位付け - Go 言語

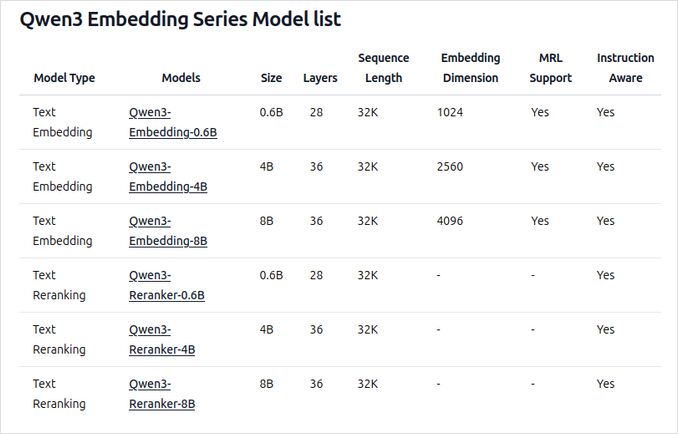

Ollama 上の新しい Qwen3 Embedding および Reranker モデルの概要

これらのモデルは、さまざまなサイズで Ollama 上でデプロイ可能であり、広範な言語およびコード関連のアプリケーションにわたって最先端の性能と柔軟性を提供しています。

主な特徴と機能

-

モデルサイズと柔軟性

- 埋め込みおよび再順位付けタスクの両方に、0.6B、4B、8B パラメータの複数サイズが利用可能です。

- 8B 埋め込みモデルは、2025年6月5日時点での MTEB 多言語リーダーボードで 70.58 点を記録し、現在 No.1 にランクインしています。

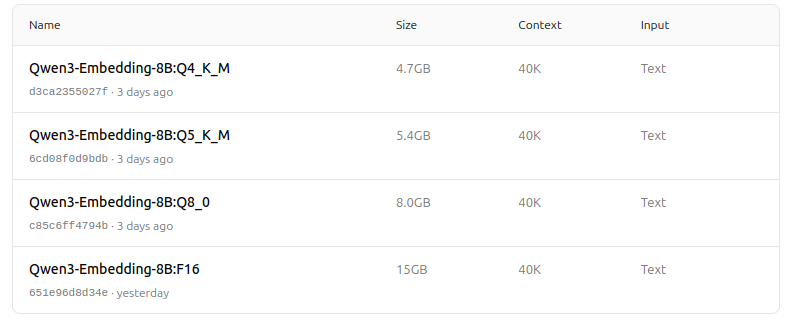

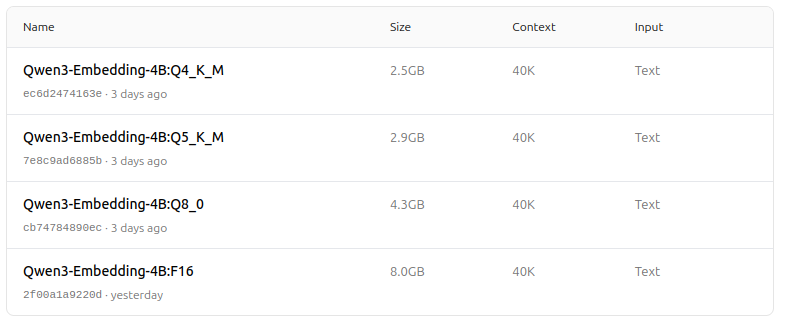

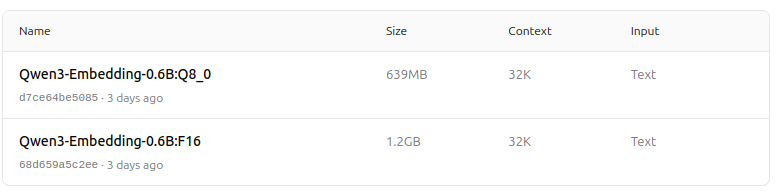

- パフォーマンス、メモリ使用量、速度のバランスを取るため、Q4、Q5、Q8 などの複数の量子化オプションがサポートされています。Q5_K_M は、ほとんどのユーザーにとってモデルパフォーマンスを維持しつつリソース効率が良いため、推奨されます。

-

アーキテクチャとトレーニング

- Qwen3 ファウンデーションに基づいて構築され、埋め込み用の双子エンコーダー(dual-encoder)と再順位付け用のクロスエンコーダー(cross-encoder)のアーキテクチャを活用しています。

- 埋め込みモデル:単一のテキストセグメントを処理し、最終隠れ状態からセマンティック表現を抽出します。

- 再順位付けモデル:テキストペア(例:クエリとドキュメント)を受け取り、クロスエンコーダーのアプローチを使用して関連性スコアを出力します。

- 埋め込みモデルは、対照的前トレーニング、高品質データを使用した監督トレーニング、最適な汎用性と適応性を確保するためのモデルマージの3段階トレーニングパラダイムを使用しています。

- 再順位付けモデルは、効率性と効果性のために高品質なラベル付きデータで直接トレーニングされています。

-

多言語およびマルチタスクサポート

- 100以上の言語をサポートしており、プログラミング言語を含むため、強固な多言語、クロスリンガル、コード検索能力を提供します。

- 埋め込みモデルは、ベクトル定義やユーザー定義の指示を柔軟に使用して、特定のタスクや言語に合わせたパフォーマンスを調整可能です。

-

パフォーマンスとユースケース

- テキスト検索、コード検索、分類、クラスタリング、バイテキストマイニングにおいて最先端の結果を提供します。

- 再順位付けモデルは、さまざまなテキスト検索シナリオで優れたパフォーマンスを発揮し、埋め込みモデルとシームレスに組み合わせてエンドツーエンドの検索パイプラインを構築できます。

Ollama 上での使用方法

これらのモデルは、以下のコマンドで Ollama 上で実行できます:

ollama run dengcao/Qwen3-Embedding-8B:Q5_K_M

ollama run dengcao/Qwen3-Reranker-0.6B:F16

ハードウェアおよびパフォーマンスの要件に最も適した量子化バージョンを選択してください。

概要表

| モデルタイプ | 利用可能なサイズ | 主な強み | 多言語サポート | 量子化オプション |

|---|---|---|---|---|

| 埋め込み | 0.6B, 4B, 8B | MTEB スコアがトップ、柔軟性、効率、SOTA | はい(100以上の言語) | Q4, Q5, Q6, Q8 など |

| 再順位付け | 0.6B, 4B, 8B | テキストペアの関連性に優れ、効率的、柔軟 | はい | F16, Q4, Q5 など |

すごいニュース!

Ollama 上の Qwen3 Embedding および Reranker モデルは、多言語、マルチタスクのテキストおよびコード検索能力において大きな飛躍をもたらしています。柔軟なデプロイオプション、強力なベンチマークパフォーマンス、広範な言語およびタスクへのサポートにより、研究および生産環境の両方に最適です。

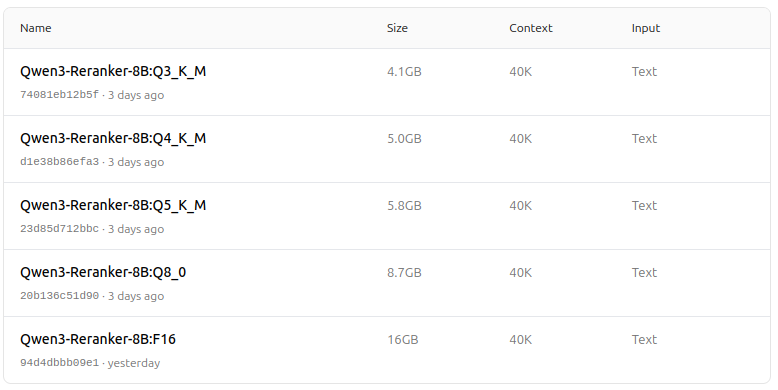

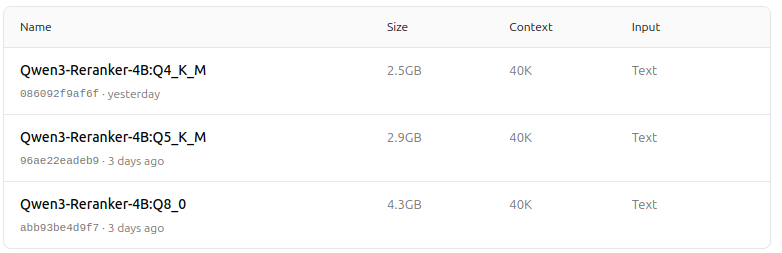

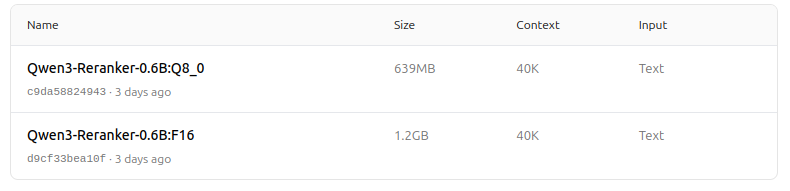

モデルズー - 目で楽しむ喜び

Qwen3 Embedding

https://ollama.com/dengcao/Qwen3-Embedding-8B

https://ollama.com/dengcao/Qwen3-Embedding-4B/tags

https://ollama.com/dengcao/Qwen3-Embedding-0.6B/tags

Qwen3 Reranker

https://ollama.com/dengcao/Qwen3-Reranker-8B

dengcao/Qwen3-Reranker-8B:Q3_K_M

dengcao/Qwen3-Reranker-8B:Q5_K_M

https://ollama.com/dengcao/Qwen3-Reranker-4B/tags

dengcao/Qwen3-Reranker-4B:Q5_K_M

https://ollama.com/dengcao/Qwen3-Reranker-0.6B/tags

素晴らしい!

有用なリンク

- Ollama と Qwen3 Embedding モデルを使用したテキストドキュメントの再順位付け - Go 言語

- Ollama と Qwen3 Reranker モデルを使用したテキストドキュメントの再順位付け - Go 言語

- Ollama チートシート

- Ollama モデルを別のドライブまたはフォルダに移動

- Perplexica のセルフホスティング - Ollama で

- テスト:Ollama がインテル CPU のパフォーマンスと効率的なコアを使用する方法

- LLM の速度パフォーマンス比較

- LLM の要約能力比較

- クラウド LLM プロバイダ

- Ollama が並列リクエストを処理する方法

- Hugo ページ翻訳品質比較 - Ollama 上の LLMs