Ollamaモデルを別の場所に移動する

OllamaのLLMモデルファイルは多くのストレージスペースを占有します。

ollamaをインストールした後、モデルを新しい場所に即座に再構成するのがより良いです。

これにより、新しいモデルをプルした後、古い場所にダウンロードされません。

Ollamaについて

Ollamaは、LLM AIモデルのテキストベースのフロントエンドであり、それらをホストするAPIでもあります。

Ollamaのインストール

https://ollama.com/downloadにアクセスしてください。

LinuxでOllamaをインストールするには、以下のコマンドを実行してください:

curl -fsSL https://ollama.com/install.sh | sh

Windows用のOllamaについてはこちら: https://ollama.com/download/windows

Mac用のOllamaはこちら: https://ollama.com/download/macOllamaSetup.exe

Ollamaモデルのダウンロード、一覧表示、削除

Ollamaモデルをダウンロードするには、Ollamaライブラリ(https://ollama.com/library)にアクセスし、必要なモデルを探してください。

ここではモデルのタグやサイズも確認できます。

その後、以下のコマンドを実行してください:

ollama pull gemma2:latest

# もしくは、16GB VRAMにちょうどよく収まる少し賢いモデルを取得する場合:

ollama pull gemma2:27b-instruct-q3_K_S

# または:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

ローカルリポジトリに保存されているOllamaモデルを確認するには、以下のコマンドを実行してください:

ollama list

不要なモデルを削除するには、以下のコマンドを実行してください:

ollama rm qwen2:7b-instruct-q8_0 # 例

Ollamaモデルの保存場所

デフォルトではモデルファイルは以下に保存されます:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

WindowsでOllamaモデルの保存場所を設定する

Windowsで環境変数を作成するには、以下の手順に従ってください:

- Windows設定を開きます。

- 「システム」を選択します。

- 「概要」を選択します。

- 「高度なシステム設定」を選択します。

- 「高度な」タブに移動します。

- 「環境変数…」を選択します。

- 「新規…」をクリックします。

- 保存先の場所を示すOLLAMA_MODELSという名前の変数を作成します。

LinuxでOllamaモデルを移動する

ollamaのsystemdサービスパラメータを編集します。

sudo systemctl edit ollama.service

または

sudo xed /etc/systemd/system/ollama.service

これにより、エディタが開きます。

各環境変数に対して、[Service]セクションにEnvironment行を追加します。

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

保存して終了します。

UserとGroupのパラメータも存在しており、このフォルダにアクセスできる必要があります。

systemdを再読み込みし、Ollamaを再起動します:

sudo systemctl daemon-reload

sudo systemctl restart ollama

何か問題が起きた場合は、以下のコマンドで確認してください:

systemctl status ollama.service

sudo journalctl -u ollama.service

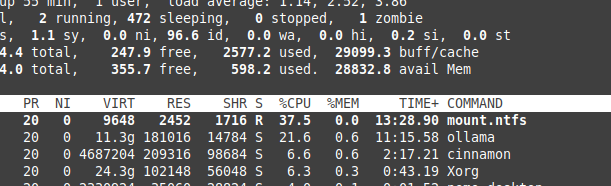

NTFSのオーバーヘッドによるファイルの保存

Linuxで動作させている場合、モデルをNTFSフォーマットのパーティションに保存している場合、モデルの読み込みが20%以上遅くなる可能性があります。

WindowsでOllamaを特定のフォルダにインストール

モデルと一緒にインストールするには、以下のコマンドを実行してください:

.\OllamaSetup.exe /DIR=D:\OllamaDir

内部ネットワークにOllama APIを公開する

ここでの「内部」はローカルネットワークを指します。

サービス設定に以下を追加してください:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"